KI-generierte Charakterdialoge in Spielen

KI verändert, wie Spielfiguren mit Spielern interagieren. Dieser Artikel erklärt, wie KI dynamische NPC-Dialoge ermöglicht, stellt Top-Tools wie Inworld AI, GPT-4 und Convai vor und zeigt reale Spielbeispiele mit generativen Gesprächen.

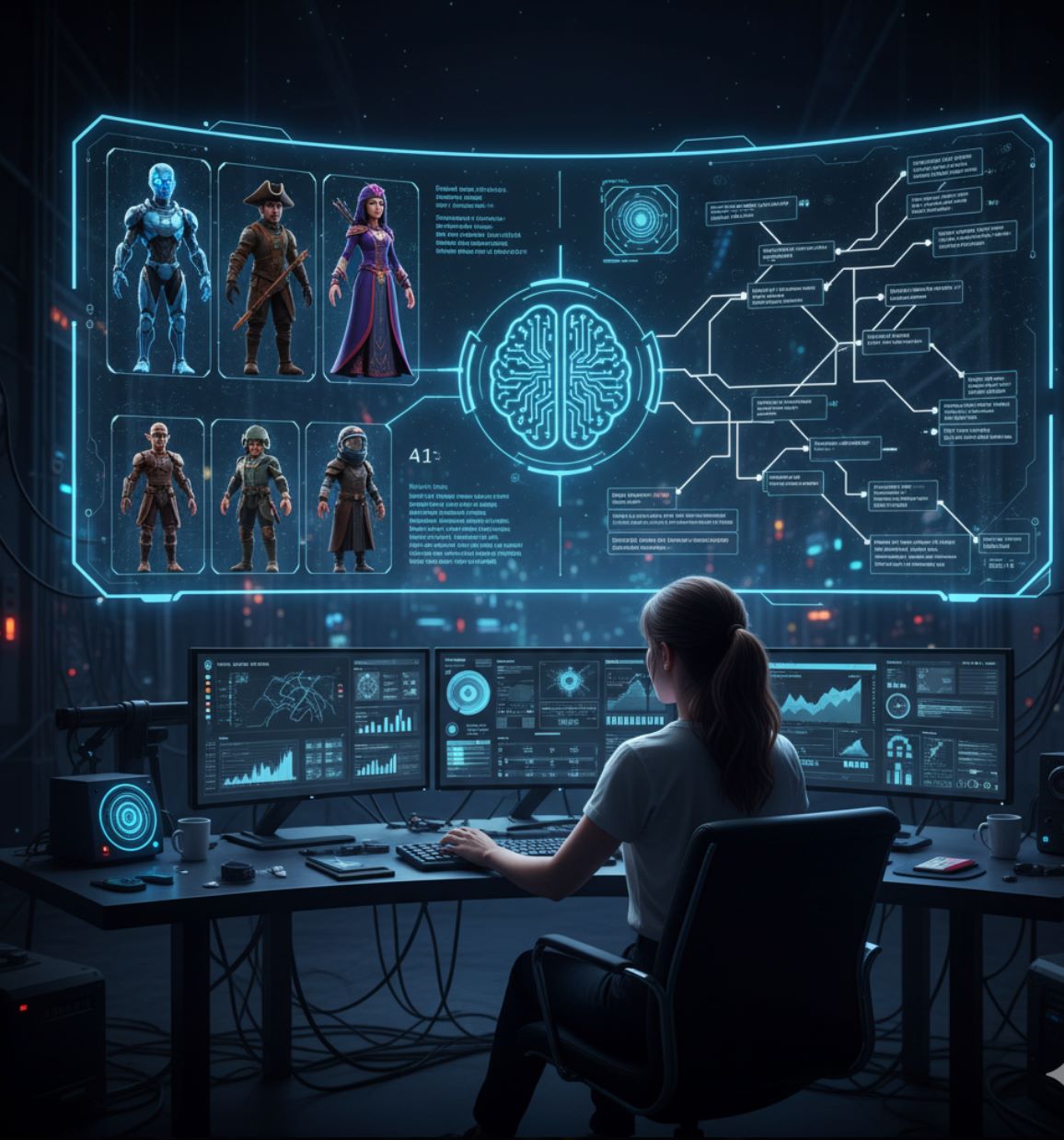

Videospiele haben traditionell auf vorgeschriebene Dialogbäume gesetzt, bei denen NPCs (Nicht-Spieler-Charaktere) feste Zeilen als Reaktion auf Spieleraktionen liefern. Heute nutzt KI-gesteuerter Dialog maschinelle Lernmodelle – insbesondere große Sprachmodelle (LLMs) – um Charakterantworten dynamisch zu generieren. Wie die Associated Press berichtet, experimentieren Studios nun mit generativer KI, um NPC-Dialoge zu gestalten und Welten „reaktionsfähiger“ auf die Kreativität der Spieler zu machen.

In der Praxis bedeutet das, dass NPCs sich an vergangene Interaktionen erinnern, mit neuen Zeilen antworten und freie Gespräche führen können, anstatt vorgefertigte Antworten zu wiederholen. Spieleentwickler und Forscher stellen fest, dass die starke Kontextverständnisfähigkeit von LLMs „natürlich klingende Antworten“ erzeugt, die traditionelle Dialogskripte ersetzen können.

Warum KI-Dialog wichtig ist

Immersion & Wiederspielbarkeit

NPCs erhalten lebensechte Persönlichkeiten mit Tiefe und Dynamik, was reichhaltigere Gespräche und stärkere Spielerbindung schafft.

Kontextbewusstsein

Charaktere erinnern sich an frühere Begegnungen und passen sich den Entscheidungen der Spieler an, wodurch Welten reaktiver und lebendiger wirken.

Emergentes Gameplay

Spieler können frei interagieren und emergente Geschichten vorantreiben, anstatt vorgegebene Questpfade zu folgen.

KI als kreatives Werkzeug, nicht als Ersatz

KI-gestützter Dialog soll Entwickler unterstützen, nicht menschliche Kreativität ersetzen. Ubisoft betont, dass Autoren und Künstler weiterhin die Kernidentität jedes Charakters definieren.

Entwickler „formen [den NPC-]Charakter, die Hintergrundgeschichte und den Gesprächsstil“ und nutzen KI „nur, wenn sie für sie einen Mehrwert hat“ – KI „darf die menschliche Kreativität nicht ersetzen“.

— Ubisoft, NEO NPC Projekt

Im Prototyp-Projekt „NEO NPC“ von Ubisoft erstellen Designer zuerst die Hintergrundgeschichte und Stimme eines NPC und leiten dann die KI an, diesem Charakter zu folgen. Generative Werkzeuge fungieren als „Co-Piloten“ für die Erzählung und helfen Autoren, Ideen schnell und effizient zu erkunden.

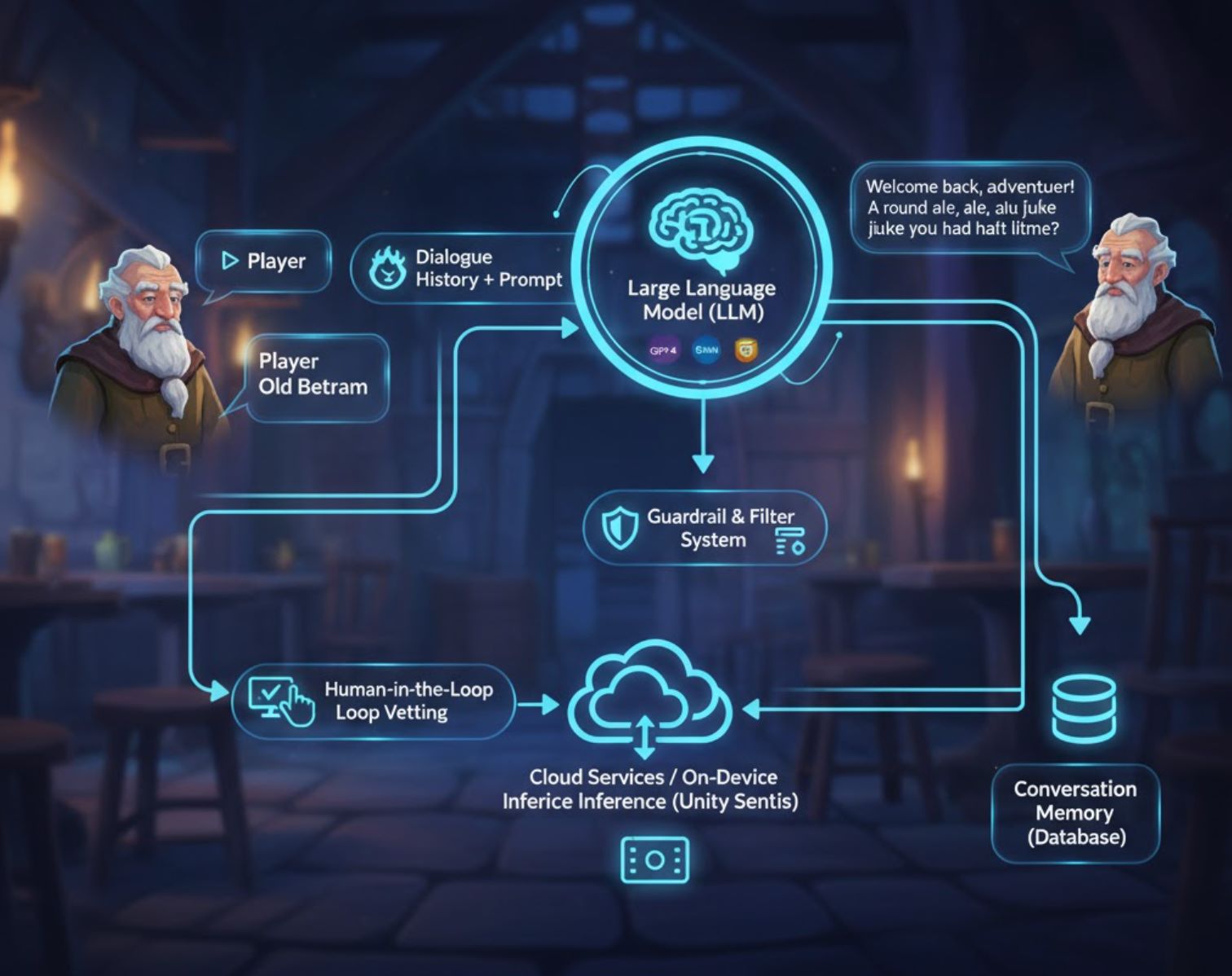

Wie KI-Dialogsysteme funktionieren

Die meisten KI-Dialogsysteme verwenden große Sprachmodelle (LLMs) wie GPT-4, Google Gemini oder Claude – neuronale Netze, die auf riesigen Textdaten trainiert wurden, um kohärente Antworten zu generieren.

Charakterdefinition

Entwickler geben eine Eingabeaufforderung, die die Persönlichkeit und den Kontext des NPC beschreibt (z. B. „Du bist ein alter Wirt namens Old Bertram, der freundlich spricht und sich an die vorherigen Bestellungen des Spielers erinnert“)

Echtzeit-Generierung

Wenn ein Spieler mit einem KI-NPC spricht, sendet das Spiel die Eingabeaufforderung und den Dialogverlauf über eine API an das Sprachmodell

Antwortausgabe

Die KI liefert eine Dialogzeile zurück, die das Spiel in Echtzeit oder nahezu Echtzeit anzeigt oder vertont

Gedächtnisbewahrung

Gesprächsprotokolle werden gespeichert, damit die KI weiß, was zuvor gesagt wurde, und die Kohärenz über Sitzungen hinweg erhält

Schutzmaßnahmen & Qualitätskontrolle

Teams integrieren mehrere Schutzmaßnahmen, um Charakterkonsistenz zu gewährleisten und unangemessene Antworten zu verhindern:

- Absicherungssysteme und Toxizitätsfilter halten NPCs in ihrem Charakter

- Menschliche Kontrolle: Wenn ein NPC „wie der vorgesehene Charakter antwortete“, behalten Entwickler die Antwort; andernfalls passen sie die Eingabeaufforderungen an

- Hochwertige Eingaben sichern hochwertigen Dialog („garbage in, garbage out“)

- Cloud-Dienste oder lokale Ausführung (z. B. Unity Sentis) optimieren Leistung und reduzieren Latenz

Vorteile und Herausforderungen

Vorteile für Entwickler & Spieler

- Zeitersparnis: Gespräche schnell entwerfen, statt jede Zeile manuell zu schreiben

- Kreatives Brainstorming: KI als Ausgangspunkt nutzen, um neue Dialogrichtungen zu erkunden

- Skalierbarkeit: Lange Chats und personalisierte Handlungsstränge generieren

- Spielerbindung: NPCs, die sich an frühere Begegnungen erinnern, wirken lebendiger und anpassungsfähiger

- Emergentes Erzählen: Spieler können freie Interaktionen in Sandbox- oder Mehrspieler-Spielen steuern

Zu beachtende Fallstricke

- Bedeutungsloser Chat: Unbegrenzter, zufälliger Dialog ist „nur endloses Rauschen“ und zerstört die Immersion

- Halluzinationen: KI kann themenfremde Zeilen generieren, wenn sie nicht sorgfältig mit Kontext begrenzt wird

- Rechenkosten: LLM-API-Aufrufe summieren sich bei großem Umfang; Nutzungskosten können Budgets belasten

- Ethische Bedenken: Synchronsprecher und Autoren sorgen sich um Arbeitsplatzverlust

- Transparenz: Manche erwägen, KI-generierte Zeilen den Spielern offenzulegen

Werkzeuge & Plattformen für KI-Dialoge in Spielen

Spieleschöpfer haben zahlreiche Möglichkeiten für KI-Dialoge. Hier sind einige bemerkenswerte Werkzeuge und Technologien:

Inworld AI

Anwendungsinformationen

| Entwickler | Inworld AI, Inc. |

| Unterstützte Plattformen |

|

| Sprachunterstützung | Primär Englisch; mehrsprachige Sprachgenerierung und Lokalisierungsfunktionen in Entwicklung. |

| Preismodell | Freemium: kostenlose Credits mit nutzungsabhängiger Bezahlung für LLM-Dialoge und Text-zu-Sprache. |

Überblick

Inworld AI ist eine generative KI-Plattform, die darauf ausgelegt ist, hochrealistische, emotional intelligente Nicht-Spieler-Charaktere (NPCs) für Spiele zu erschaffen. Durch die Kombination von Gedächtnis, Zielen, Persönlichkeit und Sprachsynthese ermöglicht sie dynamische, kontextbewusste Gespräche, die sich basierend auf dem Verhalten der Spieler und dem Zustand der Spielwelt entwickeln. Spieleentwickler können KI-gesteuerte Charaktere mit visuellen Werkzeugen erstellen und diese dann in Spiele-Engines wie Unreal oder über eine API integrieren.

Hauptfunktionen

Charaktere mit Gedächtnis, Zielen und emotionaler Dynamik, die natürlich auf Spielerinteraktionen reagieren.

No-Code, graphbasierte Studio-Oberfläche zur Definition von Persönlichkeit, Wissen, Beziehungen und Dialogstil.

Text-zu-Sprache mit geringer Latenz und integrierten Sprach-Archetypen, optimiert für Spiele und emotionale Nuancen.

NPCs erinnern sich an vergangene Interaktionen und entwickeln Beziehungen zu Spielern über die Zeit.

Filterung des Charakterwissens und Moderation der Antworten zur Sicherstellung eines realistischen und sicheren NPC-Verhaltens.

SDKs und Plugins für Unreal Engine, Unity (früher Zugang) und Node.js-Agenten-Vorlagen.

Download oder Zugriff

Erste Schritte

Registrieren Sie sich für ein Inworld Studio-Konto auf der Inworld-Website, um Zugriff auf den Charakter-Builder zu erhalten.

Nutzen Sie Studio, um Persona, Gedächtnis, emotionale Graphen und Wissensbasis für Ihren NPC zu definieren.

Laden Sie das Unreal Runtime SDK oder das Unity-Plugin herunter und importieren Sie die Charaktervorlagen-Komponenten in Ihr Projekt.

Richten Sie die Spieler-Eingabe (Sprache oder Text) ein, verbinden Sie sie mit dem Dialoggraphen und ordnen Sie die Ausgabe Text-zu-Sprache und Lippen-Synchronisation zu.

Definieren Sie, was Ihr NPC weiß und wie sich dieses Wissen im Laufe der Zeit als Reaktion auf Spieleraktionen entwickelt.

Prototypen Sie Interaktionen im Studio, überprüfen Sie generierte Dialoge, justieren Sie Charakterziele und emotionale Gewichtungen und setzen Sie dann neu ein.

Nutzen Sie die API oder das integrierte SDK, um Ihre KI-gesteuerten NPCs in Ihrem Spiel oder interaktiven Erlebnis zu starten.

Wichtige Hinweise

Konfiguration & Optimierung

- Gedächtnisabstimmung und Sicherheitsfilter erfordern sorgfältige Konfiguration, um unrealistische oder unsichere NPC-Antworten zu vermeiden

- Sprachlokalisierung wird erweitert, aber nicht alle Sprachen sind derzeit verfügbar

- Testen Sie das Charakterverhalten gründlich vor dem Produktionseinsatz, um qualitativ hochwertige Interaktionen sicherzustellen

Häufig gestellte Fragen

Ja, Inworld Studio bietet eine No-Code, graphbasierte Oberfläche, um Charakterpersönlichkeit, Dialog und Verhalten ohne Programmierkenntnisse zu gestalten.

Ja, Inworld beinhaltet eine ausdrucksstarke Text-zu-Sprache-API mit für Spiele optimierten Stimmen und integrierten Charakter-Archetypen. TTS ist in die Inworld Engine integriert.

Inworld verwendet nutzungsbasierte Preisgestaltung: Sie zahlen pro Million Zeichen für Text-zu-Sprache und für die Rechenkosten der LLM-Dialoggenerierung. Kostenlose Credits sind zum Einstieg verfügbar.

Ja, Inworld unterstützt Langzeitgedächtnis, sodass NPCs vergangene Interaktionen abrufen und sich über mehrere Sitzungen hinweg entwickelnde Beziehungen zu Spielern pflegen können.

Ja, das Inworld AI NPC Engine Plugin ist im Epic Games Marketplace für die Unreal Engine Integration verfügbar.

HammerAI

Anwendungsinformationen

| Entwickler | HammerAI (Einzelentwickler / kleines Team) |

| Unterstützte Plattformen |

|

| Sprachunterstützung | Vorwiegend Englisch; Charaktererstellung unterstützt verschiedene Stile ohne geografische Einschränkungen |

| Preismodell | Kostenlose Stufe mit unbegrenzten Gesprächen und Charakteren; kostenpflichtige Pläne (Starter, Advanced, Ultimate) bieten erweiterten Kontextumfang und erweiterte Funktionen |

Überblick

HammerAI ist eine leistungsstarke KI-Plattform, die für die Erstellung realistischer, ausdrucksstarker Charakterdialoge entwickelt wurde. Sie ermöglicht es Autoren, Spieleentwicklern und Rollenspielern, mit KI-gesteuerten Personas über intuitive Chats zu interagieren und so reichhaltige Hintergrundgeschichten, Charakterbiografien und immersive Gespräche zu erstellen. Die Plattform unterstützt sowohl lokale Sprachmodelle als auch cloud-gehostete Optionen und bietet damit Flexibilität zwischen Datenschutz und Skalierbarkeit.

Hauptfunktionen

Die kostenlose Stufe unterstützt unbegrenzte Chats und Charaktererstellung ohne Einschränkungen.

Führen Sie leistungsstarke LLMs lokal über den Desktop für Datenschutz aus oder nutzen Sie cloud-gehostete Modelle für Komfort.

Erstellen Sie detaillierte Hintergrundgeschichten, Biografien und Charaktereinstellungen, um Dialoge zu bereichern und Konsistenz zu gewährleisten.

Spezialisierter Modus zum Schreiben von Dialogen für Spiel-Cutscenes und interaktive Erzählsequenzen.

Die Desktop-App unterstützt die Bildgenerierung während der Chats mit integrierten Modellen wie Flux.

Laden Sie bis zu 10 Charaktere in einen Gruppenchat ein für komplexe Mehrcharakter-Interaktionen.

Ausführliche Einführung

HammerAI bietet eine einzigartige Umgebung zur Erstellung und Interaktion mit KI-Charakteren. Über die Desktop-Anwendung können Nutzer Sprachmodelle lokal auf ihrer eigenen Hardware mit ollama oder llama.cpp ausführen, was Datenschutz und Offline-Funktionalität gewährleistet. Für diejenigen, die cloudbasierte Lösungen bevorzugen, bietet HammerAI sichere Remote-Hosting-Optionen für unbegrenzte KI-Chats ohne Kontoerfordernis.

Das Charaktersystem unterstützt Lorebooks, persönliche Hintergrundgeschichten und Anpassungen des Dialogstils, was es ideal für die narrative Entwicklung in Spielen, Drehbüchern und interaktiver Fiktion macht. Die Plattform beinhaltet spezialisierte Werkzeuge für die Cutscene-Dialogerstellung, die eine schnelle Erstellung von filmischen und spielbezogenen Erzählsequenzen mit korrekter Formatierung für gesprochene Dialoge, Gedanken und Erzählungen ermöglichen.

Download oder Zugriff

Erste Schritte Anleitung

Laden Sie HammerAI von der itch.io-Seite für Windows, macOS oder Linux herunter.

Verwenden Sie den Reiter „Modelle“ in der Desktop-App, um Sprachmodelle wie Mistral-Nemo oder Smart Lemon Cookie herunterzuladen.

Wählen Sie aus vorhandenen KI-Charakterkarten oder erstellen Sie Ihren eigenen individuellen Charakter im Autorenmodus.

Geben Sie Dialoge oder Aktionen mit normalem Text für gesprochene Rede oder kursiv für Erzählungen und Gedanken ein.

Klicken Sie auf „Regenerieren“, wenn Sie mit der Antwort der KI nicht zufrieden sind, oder bearbeiten Sie Ihre Eingabe, um bessere Antworten zu erhalten.

Erstellen und speichern Sie Hintergrundgeschichten und Weltenwissen, um durchgängig konsistenten Kontext in Gesprächen zu gewährleisten.

Wechseln Sie in den Cutscene-Dialogmodus, um filmische oder interaktive narrative Austausche für Spiele und Geschichten zu schreiben.

Einschränkungen & Wichtige Hinweise

- Offline-Nutzung erfordert das vorherige Herunterladen von Charakter- und Modelldateien

- Cloud-Modelle sind im kostenlosen Plan auf 4.096 Token Kontext begrenzt; höhere Pläne bieten erweiterten Kontext

- Chats und Charaktere werden lokal gespeichert; geräteübergreifende Synchronisation ist aufgrund fehlenden Login-Systems nicht verfügbar

- Cloud-gehostete Modelle verwenden Inhaltsfilter; lokale Modelle sind weniger eingeschränkt

- Leistung lokaler Modelle hängt von verfügbarem RAM und GPU-Ressourcen ab

Häufig gestellte Fragen

Ja — HammerAI bietet eine kostenlose Stufe mit unbegrenzten Gesprächen und Charaktererstellung. Kostenpflichtige Pläne (Starter, Advanced, Ultimate) bieten erweiterten Kontextumfang und zusätzliche Funktionen für fortgeschrittene Nutzer.

Ja, über die Desktop-App, die lokale Sprachmodelle ausführt. Sie müssen Charakter- und Modelldateien im Voraus herunterladen, um die Offline-Funktionalität zu aktivieren.

Ja — die Desktop-App unterstützt die Bildgenerierung während des Chats mit integrierten Modellen wie Flux, sodass Sie visuelle Inhalte parallel zu Ihren Gesprächen erstellen können.

Verwenden Sie die Lorebook-Funktion, um Charakterhintergründe, Persönlichkeitsmerkmale und Weltwissen zu erstellen und zu verwalten. Dies gewährleistet konsistenten Kontext während Ihrer Gespräche.

Sie können die Antwort regenerieren, Ihre Eingaben bearbeiten, um bessere Anweisungen zu geben, oder Ihre Rollenspiel-Prompts anpassen, um die KI zu einer qualitativ besseren Ausgabe zu führen.

Large Language Models (LLMs)

Anwendungsinformationen

| Entwickler | Mehrere Anbieter: OpenAI (GPT-Serie), Meta (LLaMA), Anthropic (Claude) und andere |

| Unterstützte Plattformen |

|

| Sprachunterstützung | Primär Englisch; mehrsprachige Unterstützung variiert je nach Modell (Spanisch, Französisch, Chinesisch und weitere verfügbar) |

| Preismodell | Freemium oder kostenpflichtig; kostenlose Stufen für einige APIs verfügbar, während größere Modelle oder hohe Nutzung Abonnements oder Pay-as-you-go-Pläne erfordern |

Überblick

Große Sprachmodelle (LLMs) sind fortschrittliche KI-Systeme, die kohärenten, kontextbewussten Text für dynamische Spielerlebnisse erzeugen. In der Spieleentwicklung treiben LLMs intelligente NPCs mit Echtzeit-Dialogen, adaptivem Storytelling und interaktivem Rollenspiel an. Im Gegensatz zu statischen Skripten reagieren LLM-gesteuerte Charaktere auf Spieler-Eingaben, behalten Gesprächsspeicher und schaffen einzigartige narrative Erlebnisse, die sich mit den Entscheidungen der Spieler entwickeln.

Wie LLMs in Spielen funktionieren

LLMs analysieren große Mengen an Textdaten, um natürliche Sprach-Ausgaben vorherzusagen und zu generieren, die auf Spielkontexte zugeschnitten sind. Entwickler nutzen Prompt-Engineering und Feinabstimmung, um NPC-Antworten zu gestalten und gleichzeitig die Story-Kohärenz zu bewahren. Fortgeschrittene Techniken wie retrieval-augmented generation (RAG) ermöglichen es Charakteren, sich an frühere Interaktionen und Lore zu erinnern, wodurch glaubwürdige, immersive NPCs für Rollenspiele, Abenteuer- und erzählerisch getriebene Spiele entstehen.

Erzeugt kontextabhängige NPC-Gespräche in Echtzeit, die natürlich auf Spieler-Eingaben reagieren.

Generiert Quests, Ereignisse und Handlungsstränge, die sich an Spielzustand und Spielerentscheidungen anpassen.

Erhält Charakterkonsistenz durch definierte Hintergrundgeschichten, Ziele und Persönlichkeitsmerkmale.

Erinnert sich an frühere Interaktionen und Spielwelt-Fakten für kohärente Mehrfach-Dialoge und persistentes Charakterwissen.

Herunterladen oder Zugriff

Erste Schritte

Wählen Sie ein Modell (OpenAI GPT, Meta LLaMA, Anthropic Claude), das den Anforderungen und Leistungsbedürfnissen Ihres Spiels entspricht.

Nutzen Sie Cloud-APIs für Komfort oder richten Sie lokale Instanzen auf kompatibler Hardware für mehr Kontrolle und Datenschutz ein.

Erstellen Sie detaillierte NPC-Hintergrundgeschichten, Persönlichkeitsmerkmale und Wissensdatenbanken, um LLM-Antworten zu steuern.

Erstellen Sie Prompts, die LLM-Antworten entsprechend Spielkontext, Spieler-Eingaben und narrativen Zielen lenken.

Verbinden Sie LLM-Ausgaben mit den Dialogsystemen Ihres Spiels mittels SDKs, APIs oder maßgeschneiderten Middleware-Lösungen.

Bewerten Sie die Qualität der NPC-Dialoge, verfeinern Sie Prompts und passen Sie die Speicherverwaltung an, um Konsistenz und Immersion sicherzustellen.

Wichtige Überlegungen

- Halluzinationen: LLMs können inkohärente oder faktisch falsche Dialoge erzeugen, wenn Prompts mehrdeutig sind; verwenden Sie klare, spezifische Anweisungen

- Hardware & Latenz: Echtzeit-Integration erfordert leistungsstarke Hardware oder Cloud-Infrastruktur für reaktionsschnelles Gameplay

- Ethische & Bias-Risiken: LLM-Ausgaben können unbeabsichtigte Vorurteile enthalten; implementieren Sie Moderation und sorgfältiges Prompt-Design

- Abonnementkosten: Modelle mit hohem Volumen oder Feinabstimmung erfordern in der Regel kostenpflichtigen API-Zugang

Häufig gestellte Fragen

Ja. Mit geeigneter Persona-Gestaltung, Speicherintegration und Prompt-Engineering können LLMs Charakterkonsistenz über mehrere Interaktionen und Gespräche hinweg aufrechterhalten.

Ja, obwohl die Leistung von Hardware oder Cloud-Latenz abhängt. Kleinere lokale Modelle sind für Echtzeit-Reaktionsfähigkeit oft bevorzugt, während Cloud-APIs sich gut für rundenbasierte oder asynchrone Spiele eignen.

Viele Modelle unterstützen mehrsprachige Dialoge, aber die Qualität variiert je nach Sprache und spezifischem Modell. Testen Sie gründlich für Ihre Zielsprachen.

Implementieren Sie Moderationsfilter, beschränken Sie Prompts mit klaren Richtlinien und nutzen Sie Sicherheitsebenen, die von der Modellplattform bereitgestellt werden. Regelmäßige Tests und Community-Feedback helfen, Probleme zu erkennen und zu beheben.

Einige kostenlose Stufen existieren für Basisnutzung, aber größere Kontextmodelle oder Szenarien mit hohem Volumen erfordern in der Regel Abonnements oder Pay-as-you-go-Pläne. Bewerten Sie die Kosten basierend auf dem Umfang Ihres Spiels und der Spielerbasis.

Convai

Anwendungsinformationen

| Entwickler | Convai Technologies Inc. |

| Unterstützte Plattformen |

|

| Sprachunterstützung | Über 65 Sprachen weltweit unterstützt über Web- und Engine-Integrationen. |

| Preismodell | Kostenloser Zugang zum Convai Playground; Enterprise- und großskalige Einsätze erfordern kostenpflichtige Pläne oder Lizenzanfragen. |

Was ist Convai?

Convai ist eine konversationale KI-Plattform, die Entwickler befähigt, hochinteraktive, verkörperte KI-Charaktere (NPCs) für Spiele, XR-Welten und virtuelle Erlebnisse zu erstellen. Diese intelligenten Agenten nehmen ihre Umgebung wahr, hören zu und sprechen natürlich und reagieren in Echtzeit. Mit nahtlosen Integrationen in Unity, Unreal Engine und Web-Umgebungen erweckt Convai lebensechte virtuelle Menschen zum Leben und fügt interaktiven Welten immersive narrative Tiefe und realistische Dialoge hinzu.

Hauptfunktionen

NPCs reagieren intelligent auf Stimme, Text und Umgebungsreize für dynamische Interaktionen.

Sprachbasierter Chat mit KI-Charakteren in Echtzeit und niedriger Latenz für natürliche, immersive Dialoge.

Laden Sie Dokumente und Hintergrundwissen hoch, um das Wissen der Charaktere zu formen und konsistente, kontextbewusste Gespräche zu gewährleisten.

Graphbasierte Werkzeuge zur Definition von Auslösern, Zielen und Dialogflüssen bei gleichzeitig flexiblen, offenen Interaktionen.

Native Unity SDK und Unreal Engine Plugin für nahtlose Einbindung von KI-NPCs in Ihre Projekte.

Ermöglichen Sie KI-Charakteren, autonom miteinander in gemeinsamen Szenen zu kommunizieren für dynamisches Storytelling.

Download oder Zugriff

Erste Schritte Anleitung

Erstellen Sie Ihr Convai-Konto über die Website, um Zugriff auf den Playground zu erhalten und mit dem Erstellen von KI-Charakteren zu beginnen.

Definieren Sie im Playground die Persönlichkeit, Hintergrundgeschichte, Wissensbasis und Stimmeinstellungen Ihres Charakters, um ihn zum Leben zu erwecken.

Nutzen Sie Convais Narrative Design-Graph, um Auslöser, Entscheidungspunkte und Ziele festzulegen, die das Verhalten des Charakters steuern.

Unity: Laden Sie das Convai Unity SDK aus dem Asset Store herunter, importieren Sie es und konfigurieren Sie Ihren API-Schlüssel.

Unreal Engine: Installieren Sie das Convai Unreal Engine Plugin (Beta), um Sprache, Wahrnehmung und Echtzeit-Gespräche zu ermöglichen.

Aktivieren Sie Convais NPC2NPC-System, um KI-Charakteren autonome Gespräche untereinander zu ermöglichen.

Testen Sie Ihre Szenen gründlich, verfeinern Sie maschinelle Lernparameter, Dialogauslöser und Charakterverhalten basierend auf Feedback.

Wichtige Einschränkungen & Hinweise

- Charakter-Avatare, die mit Convais Web-Tools erstellt wurden, benötigen möglicherweise externe Modelle für den Export in Spiele-Engines.

- Die Steuerung des narrativen Flusses über mehrere KI-Agenten erfordert sorgfältige Planung und Design.

- Echtzeit-Sprachgespräche können je nach Backend-Leistung und Netzwerkbedingungen Latenzen aufweisen.

- Komplexe oder großskalige Einsätze erfordern in der Regel Enterprise-Lizenzen; der kostenlose Zugang ist hauptsächlich über den Playground möglich.

Häufig gestellte Fragen

Ja – Convai unterstützt NPC-zu-NPC-Gespräche über die NPC2NPC-Funktion sowohl in Unity als auch in Unreal Engine, was autonome Charakterinteraktionen ermöglicht.

Die grundlegende Charaktererstellung ist ohne Programmierung über den Playground möglich, aber die Integration in Spiele-Engines (Unity, Unreal) erfordert Entwicklungskenntnisse und technisches Know-how.

Ja – Sie können für jeden Charakter eine Wissensbasis und ein Gedächtnissystem definieren, um konsistente, kontextbewusste Dialoge während der Interaktionen sicherzustellen.

Ja – Echtzeit-Sprachgespräche werden vollständig unterstützt, einschließlich Spracherkennung (Speech-to-Text) und Sprachausgabe (Text-to-Speech) für natürliche Interaktionen.

Ja – Convai bietet Enterprise-Optionen einschließlich On-Premises-Bereitstellung und Sicherheitszertifizierungen wie ISO 27001 für kommerzielle und großskalige Projekte.

Nvidia ACE

Anwendungsinformationen

| Entwickler | NVIDIA Corporation |

| Unterstützte Plattformen |

|

| Sprachunterstützung | Mehrere Sprachen für Text und Sprache; weltweit für Entwickler verfügbar |

| Preismodell | Zugang für Unternehmen/Entwickler über NVIDIA-Programm; kommerzielle Lizenzierung erforderlich |

Was ist NVIDIA ACE?

NVIDIA ACE (Avatar Cloud Engine) ist eine generative KI-Plattform, die Entwickler befähigt, intelligente, lebensechte NPCs für Spiele und virtuelle Welten zu erstellen. Sie kombiniert fortschrittliche Sprachmodelle, Spracherkennung, Sprachsynthese und Echtzeit-Gesichtsanimation, um natürliche, interaktive Dialoge und autonomes Charakterverhalten zu ermöglichen. Durch die Integration von ACE können Entwickler NPCs erschaffen, die kontextbezogen reagieren, natürlich kommunizieren und persönlichkeitsgesteuerte Verhaltensweisen zeigen, was die Immersion in Spielerlebnissen deutlich erhöht.

Funktionsweise

NVIDIA ACE nutzt eine Reihe spezialisierter KI-Komponenten, die zusammenarbeiten:

- NeMo — Fortgeschrittenes Sprachverständnis und Dialogmodellierung

- Riva — Echtzeit-Spracherkennung und Sprachsynthese

- Audio2Face — Echtzeit-Gesichtsanimation, Lippen-Synchronisation und emotionale Ausdrücke

Von ACE angetriebene NPCs nehmen Audio- und visuelle Signale wahr, planen autonom Aktionen und interagieren mit Spielern durch realistische Dialoge und Mimik. Entwickler können NPC-Persönlichkeiten, Erinnerungen und Gesprächskontexte feinjustieren, um konsistente, immersive Interaktionen zu schaffen. Die Plattform unterstützt die Integration in gängige Spiel-Engines und Cloud-Bereitstellung, was skalierbare KI-Charakterimplementierungen für komplexe Spielszenarien ermöglicht.

Hauptmerkmale

Feinabstimmung von NPC-Dialogen mit Charakterhintergründen, Persönlichkeiten und Gesprächskontext.

Spracherkennung und Sprachsynthese powered by NVIDIA Riva für natürliche Sprachinteraktionen.

Echtzeit-Gesichtsausdrücke und Lippen-Synchronisation mit Audio2Face in NVIDIA Omniverse.

NPCs nehmen Audio- und visuelle Eingaben wahr, handeln autonom und treffen intelligente Entscheidungen.

Cloud- oder lokale Bereitstellung über flexibles SDK für skalierbare, effiziente Integration.

Erste Schritte

Installations- & Einrichtungsanleitung

Melden Sie sich für das NVIDIA-Entwicklerprogramm an, um ACE SDK, API-Zugangsdaten und Dokumentation zu erhalten.

Stellen Sie sicher, dass Sie eine NVIDIA GPU (RTX-Serie empfohlen) oder eine Cloud-Instanz für Echtzeit-KI-Inferenz und -Verarbeitung bereitgestellt haben.

Richten Sie die drei Kernkomponenten ein und konfigurieren Sie sie:

- NeMo — Bereitstellung für Dialogmodellierung und Sprachverständnis

- Riva — Konfiguration für Spracherkennung und Sprachsynthese

- Audio2Face — Aktivierung für Echtzeit-Gesichtsanimation und -Ausdrücke

Konfigurieren Sie Persönlichkeitseigenschaften, Gedächtnissysteme, Verhaltensparameter und Gesprächsschutzmechanismen für jeden NPC.

Verbinden Sie ACE-Komponenten mit Unity, Unreal Engine oder Ihrer eigenen Spiel-Engine, um NPC-Interaktionen in Ihrer Spielwelt zu ermöglichen.

Bewerten Sie Dialogqualität, Animationsflüssigkeit und Antwortlatenz. Feinjustieren Sie KI-Parameter und Hardware-Zuweisung für ein optimales Spielerlebnis.

Wichtige Hinweise

Häufig gestellte Fragen

Ja. NVIDIA Riva bietet Echtzeit-Spracherkennung und Sprachsynthese, sodass NPCs natürliche, sprachbasierte Gespräche mit Spielern führen können.

Ja. Audio2Face ermöglicht Echtzeit-Gesichtsanimation, Lippen-Synchronisation und emotionale Ausdrücke, wodurch NPCs visuell ausdrucksstark und emotional ansprechend sind.

Ja. Mit RTX-GPUs oder optimierter Cloud-Bereitstellung unterstützt ACE latenzarme Interaktionen, die für Echtzeit-Spieleszenarien geeignet sind.

Ja. Die Engine-Integration und Einrichtung mehrerer Komponenten erfordern fundierte Programmierkenntnisse und Erfahrung mit Spieleentwicklungs-Frameworks.

Nein. Der Zugang erfolgt über das NVIDIA-Entwicklerprogramm. Für kommerzielle Nutzung ist eine Unternehmenslizenz oder ein Abonnement erforderlich.

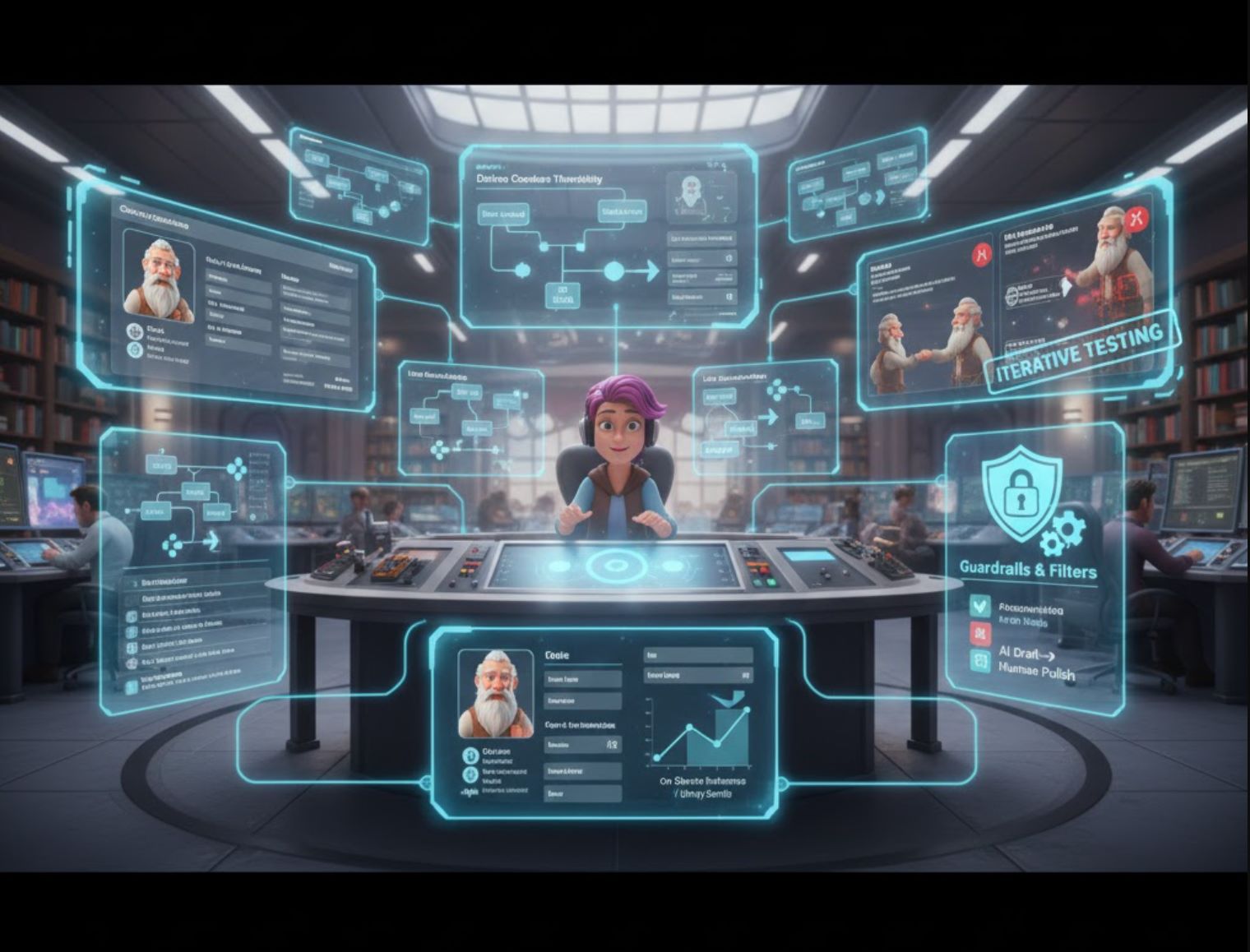

Best Practices für Entwickler

Charaktere gründlich definieren

Schreiben Sie eine klare Hintergrundgeschichte und einen Stil für jeden NPC. Verwenden Sie dies als „System-Prompt“ für die KI, damit sie weiß, wie sie sprechen soll. Ubisofts Experiment ließ Autoren detaillierte Charakternotizen erstellen, bevor die KI einbezogen wurde.

Kontext erhalten

Beziehen Sie relevanten Spielkontext in jede Eingabeaufforderung ein. Übermitteln Sie den jüngsten Chat des Spielers und wichtige Spielereignisse (abgeschlossene Quests, Beziehungen), damit die KI-Antwort thematisch bleibt. Viele Systeme speichern Gesprächsverläufe, um Gedächtnis zu simulieren.

Schutzmaßnahmen verwenden

Fügen Sie Filter und Einschränkungen hinzu. Legen Sie Wortlisten fest, die die KI vermeiden soll, oder programmieren Sie Auslöser für spezielle Dialogbäume. Ubisoft nutzte Schutzmaßnahmen, damit der NPC nie vom Charakter abweicht.

Iterativ testen

Testen Sie Chats und verfeinern Sie Eingabeaufforderungen. Wenn eine NPC-Antwort untypisch wirkt, passen Sie die Eingabe oder Beispiel-Dialoge an. Wenn die Antwort nicht wirklich zum Charakter passt, analysieren Sie das Modell genauer.

Kosten und Leistung managen

Setzen Sie KI strategisch ein. Nicht jede beiläufige Zeile benötigt KI. Erwägen Sie, häufige Antworten vorab zu generieren oder KI mit traditionellen Dialogbäumen zu kombinieren. Ubisofts Sentis-Engine kann optimierte Modelle lokal ausführen, um Serveraufrufe zu reduzieren.

KI mit manuellem Schreiben verbinden

Denken Sie daran, dass menschliche Autoren KI-Ausgaben kuratieren sollten. Nutzen Sie KI als Inspiration, nicht als finale Stimme. Der narrative Bogen muss von Menschen kommen. Viele Teams verwenden KI, um Dialoge zu entwerfen oder zu erweitern, und prüfen und polieren die Ergebnisse anschließend.

Die Zukunft des Spieledialogs

KI läutet eine neue Ära der Videospieldialoge ein. Von Indie-Mods bis zu AAA-Forschungsabteilungen setzen Entwickler generative Modelle ein, damit NPCs wie nie zuvor sprechen, reagieren und sich erinnern. Offizielle Initiativen wie Microsofts Project Explora und Ubisofts NEO NPC zeigen, dass die Branche diese Technologie annimmt – stets mit Blick auf Ethik und Autorenaufsicht.

Die heutigen Werkzeuge (GPT-4, Inworld AI, Convai, Unity-Assets und andere) geben Kreativen die Möglichkeit, reichhaltige Dialoge schnell zu prototypisieren. In Zukunft könnten vollständig prozedurale Erzählungen und personalisierte Geschichten „on the fly“ generiert werden. Für den Moment bedeutet KI-Dialog mehr kreative Flexibilität und Immersion, solange wir sie verantwortungsvoll neben menschlicher Kunstfertigkeit einsetzen.

No comments yet. Be the first to comment!