Risultati dell'Intelligenza Artificiale

L'Intelligenza Artificiale (IA) ha compiuto progressi straordinari negli ultimi anni, trasformando settori che vanno dalla sanità e finanza all'arte e all'intrattenimento. Dai modelli linguistici generativi che creano testi simili a quelli umani ai sistemi IA che padroneggiano giochi complessi e ricerche scientifiche, questi risultati mostrano l'evoluzione rapida dell'intelligenza delle macchine. In questo articolo esploriamo le più impressionanti scoperte recenti dell'IA, evidenziandone l'impatto, le potenziali applicazioni e il futuro dell'innovazione IA.

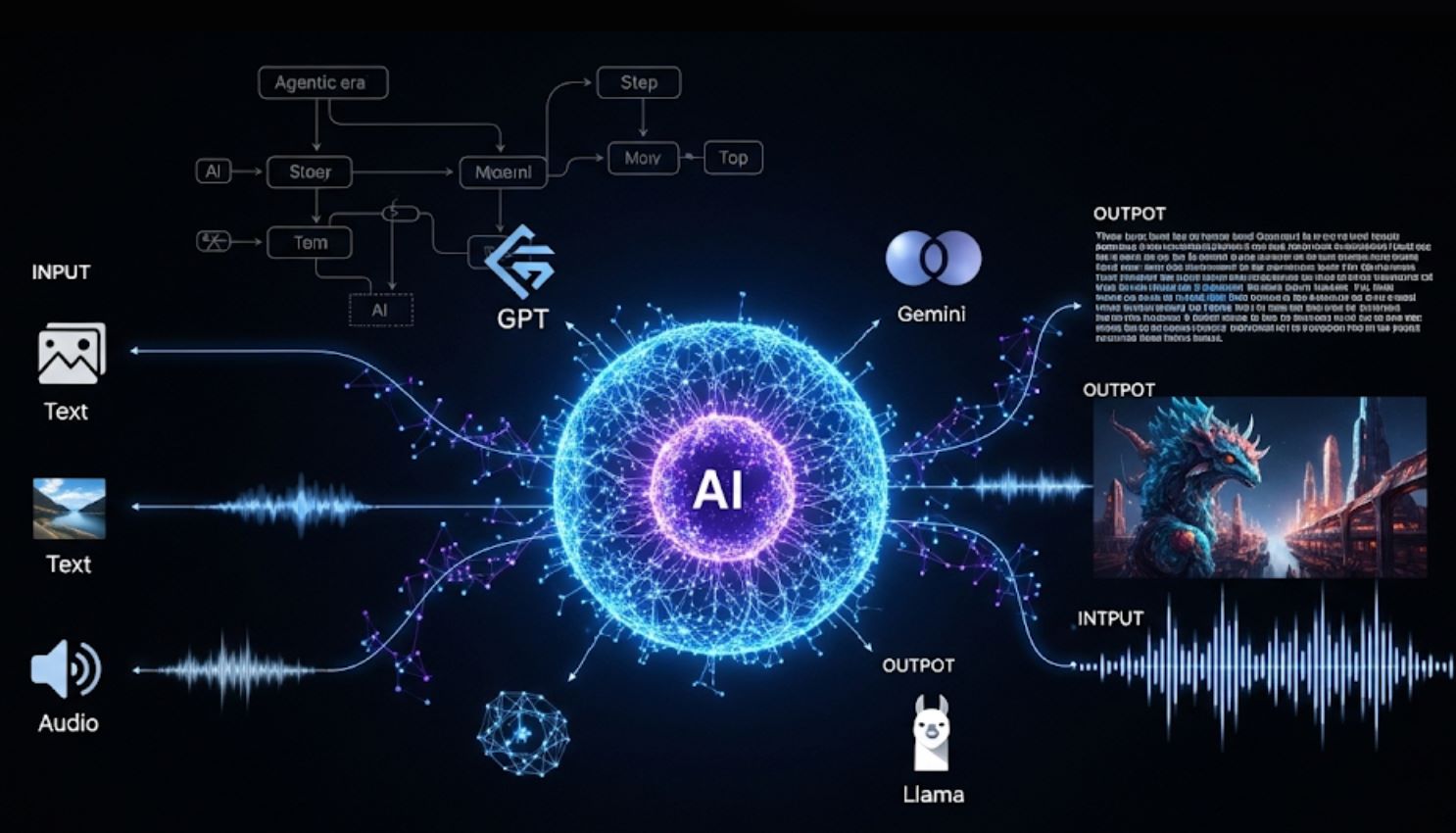

Per molti anni (2023–2025), l'intelligenza artificiale ha fatto balzi in avanti su molti fronti. I grandi modelli linguistici (LLM) e chatbot, i sistemi multimodali, gli strumenti scientifici IA e la robotica hanno tutti visto importanti progressi.

I giganti tecnologici hanno rilasciato nuovi assistenti IA, le comunità open source hanno distribuito modelli potenti e persino i regolatori si sono mossi per affrontare l'impatto dell'IA.

Di seguito esaminiamo i risultati più sorprendenti, dalle estensioni di GPT-4 e Google Gemini al Premio Nobel di AlphaFold e alle scoperte guidate dall'IA nella scienza e nell'arte.

Modelli Linguistici Generativi e Chatbot

I moderni LLM sono diventati molto più capaci e multimodali. GPT-4 Turbo di OpenAI (annunciato nel novembre 2023) può ora elaborare 128.000 token in un singolo prompt (circa 300 pagine di testo) ed è molto più economico da eseguire rispetto a GPT-4.

GPT-4o rappresenta un cambiamento fondamentale verso un'IA veramente multimodale che può gestire senza soluzione di continuità testo, immagini e audio in conversazioni in tempo reale.

— Team di Ricerca OpenAI, maggio 2024

Nel maggio 2024 OpenAI ha introdotto GPT-4o (Omni), un modello aggiornato che gestisce testo, immagini e audio in tempo reale – dando a GPT-4 una "visione e udito" conversazionale. ChatGPT ora integra funzionalità di immagini e voce: gli utenti possono caricare foto o parlare con il bot, che risponderà basandosi su quell'input visivo o audio.

GPT-4 Turbo & GPT-4o

GPT-4 Turbo (novembre 2023): Costi ridotti e lunghezza del contesto estesa a 128K token.

GPT-4o (maggio 2024): Ha reso l'IA veramente multimodale, generando testo, voce e immagini in modo intercambiabile con velocità quasi umana.

Evoluzione di ChatGPT

Alla fine del 2023, ChatGPT "ora può vedere, sentire e parlare" – immagini e audio possono essere caricati o pronunciati come prompt.

Integrazione di DALL·E 3 (ottobre 2023) per la generazione conversazionale di immagini.

Serie Gemini di Google

Nel dicembre 2024 Google DeepMind ha lanciato i primi modelli Gemini 2.0 ("Flash" e prototipi) progettati per l'"era agentica" – IA che può eseguire autonomamente compiti multi-step.

- Test con oltre 1 miliardo di utenti

- Capacità di ragionamento migliorate

- Abilità multimodali avanzate

Modelli Open Source & Enterprise

Meta ha rilasciato LLaMA 3 nell'aprile 2024 (LLM open-weight fino a 400 miliardi di parametri) con prestazioni superiori.

- Avanzamento di Claude 3 di Anthropic

- Integrazione di Microsoft Copilot

- API Assistenti di OpenAI

Alimentano anche nuove app "assistenti" tramite API (come "AI Overviews" di Google, API Assistenti di OpenAI, ecc.), rendendo l'IA più accessibile a sviluppatori e utenti finali.

Progressi Multimodali e Creativi dell'IA

La creatività e la comprensione visiva dell'IA sono esplose. I modelli testo-immagine e testo-video hanno raggiunto nuovi livelli:

DALL·E 3 di OpenAI (ottobre 2023) genera immagini fotorealistiche da prompt ed è integrato con ChatGPT per la scrittura guidata di prompt.

Google ha introdotto Imagen 3 (ottobre 2024) e Veo 2 (dicembre 2024) – motori all'avanguardia per testo-immagine e testo-video – che migliorano drasticamente qualità, dettaglio e coerenza nell'arte e nella generazione video IA.

Anche l'IA musicale è migliorata con gli strumenti MusicFX di Google e ricerche correlate (es. esperimenti MusicLM).

Capacità Avanzate di Generazione

- DALL·E 3 e Imagen 3: Seguono prompt sottili (incluso testo incorporato nelle immagini) con alta fedeltà

- Veo 2 di Google: Genera brevi clip video da singole descrizioni testuali, segnando un progresso significativo nella sintesi video

- Stable Diffusion e Midjourney: Hanno rilasciato nuove versioni (v3, v6) con realismo migliorato durante il 2024

Integrazione Apple Intelligence

Apple ha lanciato Apple Intelligence (in iOS 18 e macOS 15, fine 2024) – IA generativa integrata su iPhone/iPad/Mac.

Scrittura e Comunicazione

- Riscrivere, correggere, riassumere in Mail/Pages

- Capacità avanzate di Siri

- Elaborazione del linguaggio naturale

Strumenti Visivi e Creativi

- Image Playground: Creare illustrazioni tramite testo

- Genmoji: Emoji personalizzate generate dall'IA

- Clean Up: Rimuovere oggetti indesiderati dalle foto

Risultato Storico nel Mercato dell'Arte

Un esempio notevole: nel novembre 2024 Sotheby's ha venduto il primo dipinto realizzato da un robot umanoide.

Vendita Record di Arte IA

Un ritratto di Alan Turing disegnato dal robot IA Ai-Da è stato venduto per 1,08 milioni di dollari USA.

Questa vendita record ("A.I. God: Ritratto di Alan Turing") sottolinea il ruolo crescente dell'IA nella creatività e il suo impatto culturale.

Arte IA Iniziale

- Output focalizzati sulla novità

- Immagini surreali, astratte

- Applicazioni pratiche limitate

- Solo testo-immagine di base

Creatività IA Moderna

- Generazione utile di immagini (loghi, diagrammi, mappe)

- Realismo simile a quello umano

- Flussi di lavoro creativi integrati

- Capacità multimodali

In generale, i modelli generativi stanno democratizzando la creatività: chiunque può ora generare arte, musica o video con poche parole. L'attenzione del settore si è spostata dalla mera novità (immagini surreali) alla generazione utile di immagini (loghi, diagrammi, mappe) e al realismo simile a quello umano.

(Nel marzo 2025 OpenAI ha persino rilasciato "4o Image Generation", integrando il suo miglior modello di immagini in GPT-4o per output precisi e fotorealistici guidati dalla conversazione.)

Questi strumenti vengono rapidamente integrati in app, browser e flussi di lavoro creativi.

IA in Scienza, Medicina e Matematica

I risultati dell'IA hanno alimentato scoperte scientifiche e progressi nella ricerca:

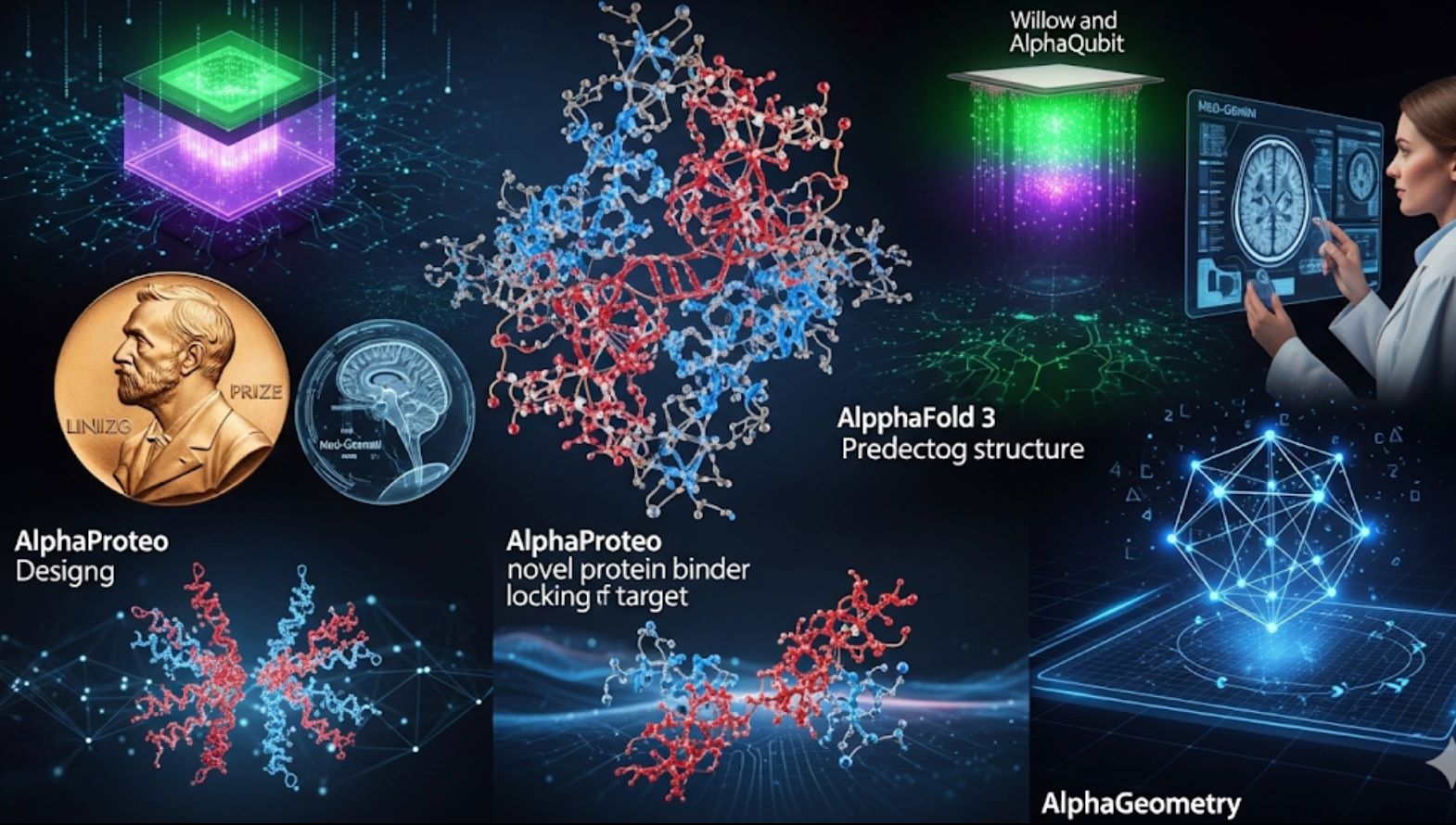

AlphaFold 3 – Predizione Rivoluzionaria di Biomolecole

Nel novembre 2024 Google DeepMind (con Isomorphic Labs) ha svelato AlphaFold 3, un nuovo modello che predice le strutture 3D di tutte le biomolecole (proteine, DNA, RNA, ligandi, ecc.) simultaneamente, con precisione senza precedenti.

I suoi creatori hanno subito rilasciato un AlphaFold Server gratuito affinché i ricercatori di tutto il mondo possano prevedere strutture molecolari. Questo amplia le predizioni solo proteiche di AlphaFold 2 e si prevede trasformi la scoperta di farmaci e la ricerca genomica.

AlphaProteo – Design di Farmaci

Sempre nel 2024, DeepMind ha annunciato AlphaProteo, un'IA che progetta nuovi leganti proteici – molecole che si legano a proteine target con alta affinità.

- Accelera la creazione di anticorpi

- Sviluppa biosensori

- Genera lead per farmaci

- Crea strutture proteiche per target specifici

Matematica – AlphaGeometry

AlphaGeometry e AlphaProof di DeepMind hanno dimostrato un altro progresso.

- 19 secondi per risolvere un problema dell'Olimpiade Internazionale di Matematica

- Prestazioni a livello di medaglia d'argento

- Capacità avanzate di matematica liceale

Progressi nel Calcolo Quantistico – AlphaQubit & Willow

L'IA ha migliorato anche hardware all'avanguardia. Nel 2024 Google ha annunciato AlphaQubit, un decodificatore basato su IA che identifica errori nei computer quantistici (es. chip Sycamore di Google) molto meglio dei metodi precedenti.

Poi, nel dicembre 2024, Google ha svelato Willow, un nuovo chip quantistico che, usando correzione avanzata degli errori, ha risolto un compito benchmark in meno di 5 minuti che richiederebbe all'attuale miglior supercomputer circa 10^24 anni.

Med-Gemini rappresenta un salto significativo nelle capacità mediche dell'IA, raggiungendo il 91,1% di accuratezza nei benchmark degli esami medici USA – una performance che supera di gran lunga i modelli precedenti.

— Team di Ricerca Google Health AI, 2024

In medicina e salute, i modelli IA hanno fatto progressi. Ad esempio, il nuovo Med-Gemini di Google (ottimizzato su dati medici) ha ottenuto il 91,1% in un benchmark di esami medici USA (stile USMLE), superando di molto i modelli precedenti.

Sono stati rilasciati strumenti IA per radiologia e patologia (es. Derm e Path Foundations) per migliorare l'analisi delle immagini. Complessivamente, l'IA è ora un partner indispensabile nella ricerca – dalla mappatura del cervello umano a nanoscale (con imaging EM assistito da IA) all'accelerazione dello screening della tubercolosi in Africa, come riportato dai ricercatori Google.

IA in Robotica e Automazione

I robot alimentati dall'IA stanno imparando compiti complessi nel mondo reale.

I robot umanoidi Optimus di Tesla sono stati mostrati pubblicamente nell'ottobre 2024 (evento "We, Robot"). Diverse decine di unità Optimus hanno camminato, si sono messe in piedi e persino hanno ballato sul palco – anche se rapporti successivi hanno evidenziato che le demo iniziali erano in parte controllate a distanza da umani.

Tuttavia, l'evento ha evidenziato i rapidi progressi verso robot a scopo generale.

Robot ALOHA di DeepMind

Il laboratorio IA di Google ha fatto progressi impressionanti nei robot domestici. Nel 2024 il robot ALOHA (Assistente Domestico Autonomo a Gambe) ha imparato a allacciare le scarpe, appendere una camicia, riparare un altro robot, inserire ingranaggi e persino pulire una cucina usando solo pianificazione IA e visione.

Il progetto open-source "ALOHA Unleashed" ha mostrato robot che coordinano due braccia per compiti, un primato nella manipolazione a scopo generale.

Transformer Robotici

DeepMind ha introdotto RT-2 (Robotic Transformer 2), un modello visione-linguaggio-azione che può imparare sia da immagini internet che da dati reali di robot.

RT-2 permette ai robot di interpretare istruzioni come farebbe un umano sfruttando la conoscenza web. È stato dimostrato aiutare un robot a ordinare oggetti seguendo comandi testuali.

Applicazioni Industriali

Altre aziende hanno fatto progressi: Boston Dynamics ha continuato a perfezionare i robot Atlas e Spot (anche se senza grandi novità di rilievo), e i veicoli autonomi guidati dall'IA sono migliorati (la beta Full Self-Driving di Tesla ha avuto un rollout più ampio, anche se l'autonomia completa resta irrisolta).

Nel settore manifatturiero, aziende IA-centriche come Figure AI hanno raccolto fondi per costruire robot domestici per le faccende.

Fase di Dimostrazione

- Dimostrazioni controllate impressionanti

- Apprendimento di compiti specifici

- Implementazione reale limitata

- Supervisione umana richiesta

Autonomia Completa

- Collaborazione sicura con umani

- Capacità a scopo generale

- Funzionamento affidabile nel mondo reale

- Implementazione su larga scala

Questi sforzi mostrano robot che eseguono compiti progressivamente più difficili senza programmazione esplicita. Tuttavia, veri umanoidi completamente autonomi sono ancora all'orizzonte.

Le dimostrazioni (Optimus, ALOHA, RT-2) sono pietre miliari, ma i ricercatori avvertono che c'è ancora molto lavoro prima che i robot possano lavorare in sicurezza e affidabilità al fianco degli umani su larga scala.

IA in Prodotti, Industria e Società

L'impatto dell'IA si estende ai prodotti di uso quotidiano e persino alle politiche:

Integrazione IA nella Tecnologia Quotidiana

I principali prodotti tecnologici hanno incorporato agenti IA. Copilot di Microsoft (integrato in Windows, Office, Bing) e Bard/Bard AI di Google nella Ricerca (con Gemini dietro) hanno portato la potenza degli LLM agli utenti.

I dispositivi Apple hanno ricevuto Apple Intelligence (come sopra) e produttori hardware come Nvidia hanno venduto un numero record di GPU IA, alimentando sia il cloud che l'IA consumer.

EU AI Act - Prima Legge Completa sull'IA

Riflettendo la portata dell'IA, anche i regolatori sono intervenuti. Il 1° agosto 2024 è entrato in vigore il EU AI Act, la prima legge completa sull'IA.

Quadro Basato sul Rischio

- IA a basso rischio: Regole minime (filtri antispam, videogiochi)

- Regole di trasparenza: I sistemi IA devono dichiarare di essere IA

- IA ad alto rischio: Supervisione rigorosa (strumenti medici, assunzioni)

- IA inaccettabile: Vietata (punteggi sociali governativi)

Impatto Globale

Questo insieme di regole (insieme alle linee guida imminenti sui modelli a scopo generale) rappresenta un grande risultato nella governance dell'IA ed è destinato a influenzare gli standard a livello mondiale.

Investimenti e Valutazioni Storiche

Il settore IA ha visto finanziamenti e valutazioni storiche:

| Azienda | Risultato | Valore/Impatto | Significato |

|---|---|---|---|

| OpenAI | Valutazione | 157 miliardi di $ | Record |

| NVIDIA | Capitalizzazione di mercato | Oltre 3,5 trilioni di $ | Leader Hardware IA |

| Molte Startup | Round di finanziamento | Multi-miliardari $ | Fase di crescita |

Questi numeri sottolineano come l'IA sia diventata centrale nell'economia tecnologica.

Guardando Avanti: L'Impatto Trasformativo dell'IA

In breve, l'IA non è più confinata ai laboratori o a demo di novità – è integrata in telefoni, auto, luoghi di lavoro e politiche pubbliche.

Rivoluzione della Conoscenza

Le vaste capacità di conoscenza di GPT-4 dimostrano il potenziale dell'IA come assistente universale della conoscenza.

Scoperte Scientifiche

Le rivoluzioni scientifiche di AlphaFold mostrano il potere dell'IA di accelerare la scoperta e la ricerca umana.

Integrazione Quotidiana

L'IA si sta integrando senza soluzione di continuità nei nostri strumenti e flussi di lavoro quotidiani.

I progressi sopra descritti – dalla vasta conoscenza di GPT-4 alle rivoluzioni scientifiche di AlphaFold – dimostrano la rapida maturazione dell'IA.

Avvicinandoci al 2025, questi risultati preannunciano applicazioni IA ancora più potenti e pratiche nella nostra vita quotidiana.

No comments yet. Be the first to comment!