Logros de la IA

La Inteligencia Artificial (IA) ha logrado avances notables en los últimos años, transformando industrias desde la salud y las finanzas hasta el arte y el entretenimiento. Desde modelos generativos de lenguaje que crean textos similares a los humanos hasta sistemas de IA que dominan juegos complejos e investigaciones científicas, estos logros muestran la rápida evolución de la inteligencia artificial. En este artículo, exploramos los avances más impresionantes recientes en IA, destacando su impacto, aplicaciones potenciales y el futuro de la innovación en IA.

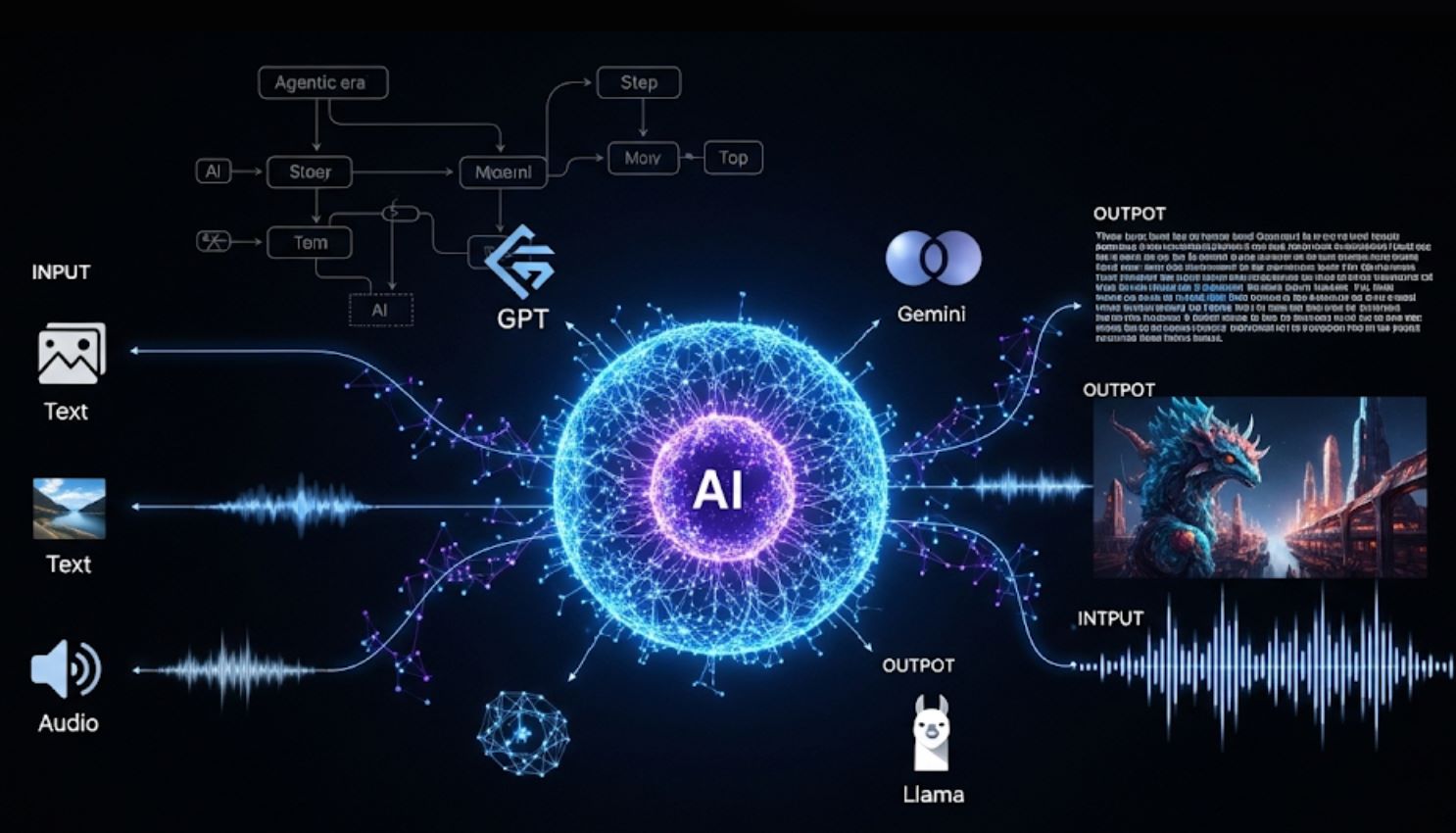

Durante muchos años (2023–2025), la inteligencia artificial ha dado un gran salto en muchos frentes. Los grandes modelos de lenguaje (LLMs) y chatbots, sistemas multimodales, herramientas científicas de IA y robótica han experimentado avances.

Los gigantes tecnológicos lanzaron nuevos asistentes de IA, las comunidades de código abierto desplegaron modelos potentes e incluso los reguladores comenzaron a abordar el impacto de la IA.

A continuación, repasamos los logros más destacados, desde extensiones de GPT-4 y Gemini de Google hasta el Premio Nobel de AlphaFold y descubrimientos impulsados por IA en ciencia y arte.

Modelos generativos de lenguaje y chatbots

Los LLM modernos se volvieron mucho más capaces y multimodales. GPT-4 Turbo de OpenAI (anunciado en noviembre de 2023) ahora puede procesar 128,000 tokens en un solo prompt (aproximadamente 300 páginas de texto) y es mucho más barato de operar que GPT-4.

GPT-4o representa un cambio fundamental hacia una IA verdaderamente multimodal que puede manejar texto, imágenes y audio sin interrupciones en conversaciones en tiempo real.

— Equipo de investigación de OpenAI, mayo de 2024

En mayo de 2024, OpenAI presentó GPT-4o (Omni), un modelo mejorado que maneja texto, imágenes y audio en tiempo real, otorgando a GPT-4 capacidades conversacionales de "visión y audición". ChatGPT ahora incluye funciones integradas de imagen y voz: los usuarios pueden subir fotos o hablar con el bot, y este responderá basándose en esa entrada visual o auditiva.

GPT-4 Turbo y GPT-4o

GPT-4 Turbo (noviembre 2023): Reducción de costos y extensión de la longitud del contexto a 128K tokens.

GPT-4o (mayo 2024): Hizo que la IA fuera verdaderamente multimodal, generando texto, voz e imágenes intercambiables con velocidad casi humana.

Evolución de ChatGPT

A finales de 2023, ChatGPT "ahora puede ver, oír y hablar": se pueden subir imágenes y audios o usarlos como prompts hablados.

Integración de DALL·E 3 (octubre 2023) para generación conversacional de imágenes.

Serie Gemini de Google

En diciembre de 2024, Google DeepMind lanzó los primeros modelos Gemini 2.0 ("Flash" y prototipos) diseñados para la "era agéntica": IA que puede realizar tareas autónomas de múltiples pasos.

- Pruebas con más de 1,000 millones de usuarios

- Capacidades mejoradas de razonamiento

- Habilidades multimodales avanzadas

Modelos de código abierto y empresariales

Meta lanzó LLaMA 3 en abril de 2024 (LLMs de pesos abiertos hasta 400 mil millones de parámetros) con un rendimiento superior.

- Avance de Claude 3 de Anthropic

- Integración de Microsoft Copilot

- API de asistentes de OpenAI

También impulsan nuevas aplicaciones de "asistente" vía APIs (como "AI Overviews" de Google, API de asistentes de OpenAI, etc.), facilitando el acceso a la IA para desarrolladores y usuarios.

Avances multimodales y creativos en IA

La creatividad y comprensión visual de la IA han explotado. Los modelos de texto a imagen y texto a video alcanzaron nuevos niveles:

DALL·E 3 de OpenAI (octubre 2023) genera imágenes fotorrealistas a partir de prompts y está integrado con ChatGPT para guiar la escritura de prompts.

Google presentó Imagen 3 (octubre 2024) y Veo 2 (diciembre 2024), motores de última generación para texto a imagen y texto a video, que mejoran drásticamente la calidad, detalle y consistencia en arte y video generados por IA.

Incluso la IA musical mejoró con las herramientas MusicFX de Google y la investigación relacionada (por ejemplo, experimentos MusicLM).

Capacidades avanzadas de generación

- DALL·E 3 e Imagen 3: Pueden seguir prompts sutiles (incluyendo texto incrustado en imágenes) con alta fidelidad

- Veo 2 de Google: Genera clips de video cortos a partir de descripciones textuales, marcando un progreso significativo en síntesis de video

- Stable Diffusion y Midjourney: Lanzaron versiones nuevas (v3, v6) con realismo mejorado durante 2024

Integración de inteligencia Apple

Apple lanzó Apple Intelligence (en iOS 18 y macOS 15, finales de 2024), IA generativa integrada en iPhone/iPad/Mac.

Escritura y comunicación

- Reescribir, corregir, resumir en Mail/Pages

- Capacidades mejoradas de Siri

- Procesamiento de lenguaje natural

Herramientas visuales y creativas

- Image Playground: Crear ilustraciones mediante texto

- Genmoji: Emojis personalizados generados por IA

- Clean Up: Eliminar objetos no deseados de fotos

Logro histórico en el mercado del arte

Un ejemplo destacado: en noviembre de 2024 Sotheby's vendió la primera pintura realizada por un robot humanoide.

Venta récord de arte generado por IA

Un retrato de Alan Turing dibujado por el robot impulsado por IA Ai-Da alcanzó los 1.08 millones de dólares estadounidenses.

Esta venta récord ("A.I. God: Portrait of Alan Turing") subraya el creciente papel de la IA en la creatividad y su impacto cultural.

Arte temprano de IA

- Salidas enfocadas en la novedad

- Imágenes surrealistas y abstractas

- Aplicaciones prácticas limitadas

- Sólo texto a imagen básico

Creatividad moderna de IA

- Generación útil de imágenes (logotipos, diagramas, mapas)

- Realismo similar al humano

- Flujos de trabajo creativos integrados

- Capacidades multimodales

En general, los modelos generativos están democratizando la creatividad: cualquiera puede ahora generar arte, música o video con pocas palabras. El enfoque de la industria ha cambiado de la mera novedad (imágenes surrealistas) a la generación útil de imágenes (logotipos, diagramas, mapas) y realismo humano.

(En marzo de 2025 OpenAI incluso lanzó "4o Image Generation", integrando su mejor modelo de imagen en GPT-4o para salidas precisas y fotorrealistas guiadas por conversación.)

Estas herramientas se están integrando rápidamente en aplicaciones, navegadores y flujos creativos.

IA en ciencia, medicina y matemáticas

Los logros de la IA han impulsado el descubrimiento científico y avances en investigación:

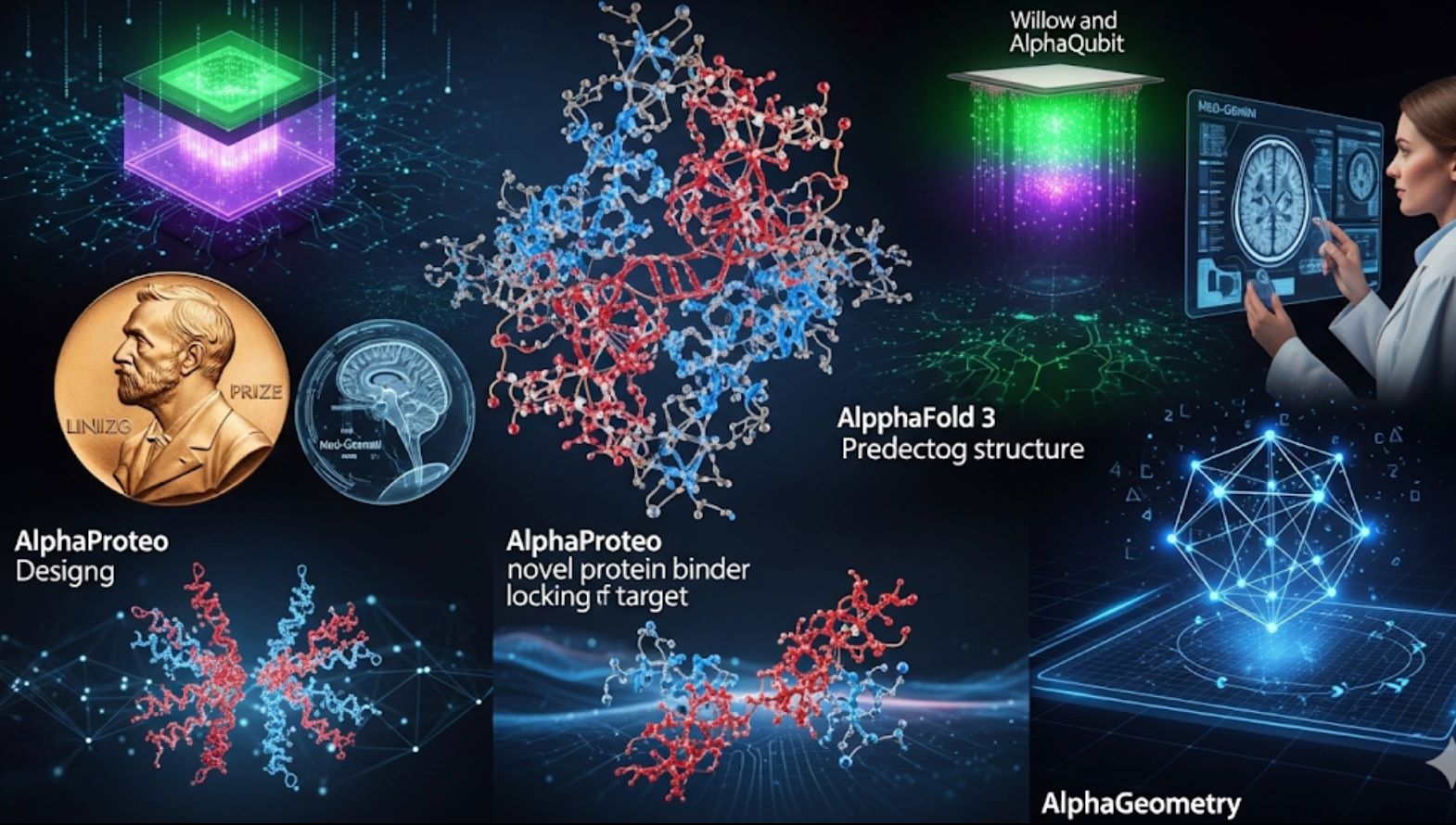

AlphaFold 3 – Predicción biomolecular revolucionaria

En noviembre de 2024 Google DeepMind (con Isomorphic Labs) presentó AlphaFold 3, un nuevo modelo que predice las estructuras 3D de todas las biomoléculas (proteínas, ADN, ARN, ligandos, etc.) simultáneamente, con una precisión sin precedentes.

Sus creadores lanzaron inmediatamente un Servidor AlphaFold gratuito para que investigadores de todo el mundo puedan predecir estructuras moleculares. Esto amplía las predicciones solo de proteínas de AlphaFold 2 y se espera que transforme el descubrimiento de fármacos y la investigación genómica.

AlphaProteo – Diseño de fármacos

También en 2024, DeepMind anunció AlphaProteo, una IA que diseña nuevos ligandos proteicos, moléculas que se unen a proteínas objetivo con alta afinidad.

- Acelera la creación de anticuerpos

- Desarrolla biosensores

- Genera candidatos a fármacos

- Crea estructuras proteicas para objetivos específicos

Matemáticas – AlphaGeometry

AlphaGeometry y AlphaProof de DeepMind demostraron otro avance.

- 19 segundos para resolver un problema de la Olimpiada Matemática Internacional

- Rendimiento a nivel de medallista de plata

- Capacidad avanzada de matemáticas de secundaria

Avances en computación cuántica – AlphaQubit y Willow

La IA también mejoró hardware de vanguardia. En 2024 Google anunció AlphaQubit, un decodificador basado en IA que identifica errores en computadoras cuánticas (por ejemplo, chips Sycamore de Google) mucho mejor que métodos anteriores.

Luego, en diciembre de 2024 Google presentó Willow, un nuevo chip cuántico que, usando corrección avanzada de errores, resolvió una tarea de referencia en menos de 5 minutos que tomaría al mejor superordenador actual ~10^24 años.

Med-Gemini representa un salto significativo en las capacidades médicas de IA, logrando un 91.1% de precisión en pruebas médicas de referencia en EE.UU., superando ampliamente modelos anteriores.

— Equipo de investigación de Google Health AI, 2024

En medicina y salud, los modelos de IA también avanzaron. Por ejemplo, el nuevo Med-Gemini de Google (ajustado con datos médicos) obtuvo un 91.1% en un examen médico de referencia estadounidense (estilo USMLE), superando ampliamente modelos previos.

Se lanzaron herramientas habilitadas por IA para radiología y patología (por ejemplo, Derm y Path Foundations) para mejorar el análisis de imágenes. En general, la IA es ahora un socio indispensable en investigación, desde mapear el cerebro humano a escala nanométrica (con imágenes asistidas por IA) hasta acelerar el cribado de tuberculosis en África, según investigadores de Google.

IA en robótica y automatización

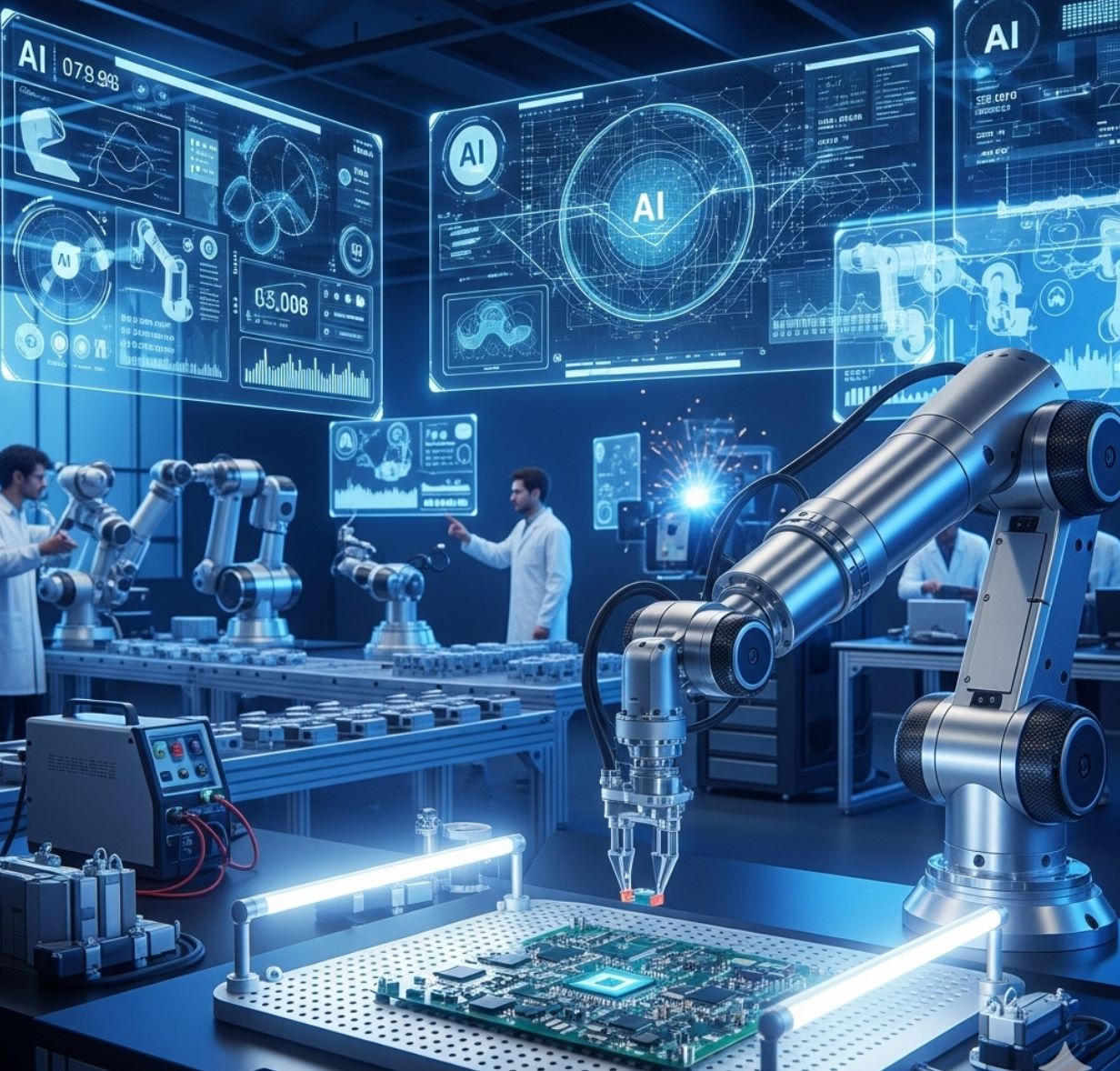

Los robots impulsados por IA están aprendiendo tareas complejas del mundo real.

Los robots humanoides Optimus de Tesla se mostraron públicamente en octubre de 2024 (evento "We, Robot"). Varias docenas de unidades Optimus caminaron, se pararon e incluso bailaron en el escenario, aunque informes posteriores indicaron que las demos iniciales fueron parcialmente controladas a distancia por humanos.

Aun así, el evento destacó el rápido progreso hacia robots de propósito general.

Robots ALOHA de DeepMind

El laboratorio de IA de Google logró avances impresionantes en robots domésticos. En 2024, el robot ALOHA (Asistente Autónomo de Hogar con Extremidades) aprendió a atar cordones, colgar una camisa, reparar otro robot, insertar engranajes e incluso limpiar una cocina usando solo planificación y visión de IA.

Los proyectos de código abierto "ALOHA Unleashed" mostraron robots coordinando dos brazos para tareas, un hito en manipulación de propósito general.

Transformadores robóticos

DeepMind presentó RT-2 (Robotic Transformer 2), un modelo de visión-lenguaje-acción que puede aprender tanto de imágenes de internet como de datos reales de robots.

RT-2 permite que los robots interpreten instrucciones como un humano aprovechando el conocimiento web. Se demostró ayudando a un robot a clasificar objetos siguiendo comandos de texto.

Aplicaciones industriales

Otras compañías también avanzaron: Boston Dynamics continuó refinando los robots Atlas y Spot (aunque sin un avance destacado único), y los vehículos autónomos impulsados por IA mejoraron (la beta de conducción autónoma completa de Tesla se desplegó más ampliamente, aunque la autonomía total sigue sin resolverse).

En manufactura, empresas centradas en IA como Figure AI recaudaron fondos para construir robots domésticos para tareas del hogar.

Fase de demostración

- Demostraciones controladas impresionantes

- Aprendizaje de tareas específicas

- Despliegue limitado en el mundo real

- Supervisión humana requerida

Autonomía total

- Colaboración segura con humanos

- Capacidades de propósito general

- Operación confiable en el mundo real

- Despliegue a gran escala

Estos esfuerzos muestran robots realizando tareas progresivamente más difíciles sin programación explícita. Sin embargo, los humanoides totalmente autónomos aún están en el horizonte.

Las demostraciones (Optimus, ALOHA, RT-2) son hitos, pero los investigadores advierten que queda trabajo antes de que los robots puedan trabajar de forma segura y confiable junto a humanos a gran escala.

IA en productos, industria y sociedad

El impacto de la IA se extiende a productos cotidianos e incluso a políticas públicas:

Integración de IA en tecnología cotidiana

Los principales productos tecnológicos incorporaron agentes de IA. Copilot de Microsoft (integrado en Windows, Office, Bing) y Bard/Bard AI de Google en Search (con Gemini detrás) llevaron el poder de los LLM a los usuarios.

Los dispositivos de Apple recibieron Apple Intelligence (como se mencionó) y fabricantes de hardware como Nvidia vendieron números récord de GPUs para IA, impulsando tanto la nube como la IA para consumidores.

Ley de IA de la UE - Primera ley integral de IA

Reflejando el alcance de la IA, los reguladores también actuaron. El 1 de agosto de 2024 entró en vigor la Ley de IA de la UE, la primera ley integral sobre IA.

Marco basado en riesgos

- IA de bajo riesgo: Reglas mínimas (filtros de spam, videojuegos)

- Reglas de transparencia: Los sistemas de IA deben revelar que son IA

- IA de alto riesgo: Supervisión estricta (herramientas médicas, selección de personal)

- IA inaceptable: Prohibida (puntuación social gubernamental)

Impacto global

Este conjunto de reglas (junto con las próximas directrices sobre modelos de propósito general) es un logro importante en la gobernanza de la IA y probablemente influirá en estándares a nivel mundial.

Inversiones y valoraciones históricas

El sector de la IA vio financiamiento y valoraciones históricas:

| Empresa | Logro | Valor/Impacto | Significado |

|---|---|---|---|

| OpenAI | Valoración | $157 mil millones | Récord |

| NVIDIA | Capitalización de mercado | $3.5+ billones | Líder en hardware de IA |

| Varias startups | Rondas de financiamiento | Multimillonarias | Fase de crecimiento |

Estas cifras subrayan cómo la IA se ha convertido en el centro de la economía tecnológica.

Mirando hacia adelante: impacto transformador de la IA

En resumen, la IA ya no está confinada a laboratorios o demostraciones novedosas: está integrada en teléfonos, autos, lugares de trabajo y políticas públicas.

Revolución del conocimiento

Las vastas capacidades de conocimiento de GPT-4 demuestran el potencial de la IA como asistente universal de conocimiento.

Avances científicos

Las revoluciones científicas de AlphaFold muestran el poder de la IA para acelerar el descubrimiento y la investigación humana.

Integración diaria

La IA se está integrando de forma fluida en nuestras herramientas y flujos de trabajo diarios.

Los avances anteriores —desde el vasto conocimiento de GPT-4 hasta las revoluciones científicas de AlphaFold— demuestran la rápida madurez de la IA.

Al avanzar hacia 2025, estos logros presagian aplicaciones de IA aún más potentes y prácticas en nuestra vida diaria.

No comments yet. Be the first to comment!