Réalisations en Intelligence Artificielle

L'intelligence artificielle (IA) a réalisé des progrès remarquables ces dernières années, transformant des secteurs allant de la santé et la finance à l'art et au divertissement. Des modèles de langage génératifs qui créent des textes proches de ceux des humains aux systèmes d'IA maîtrisant des jeux complexes et la recherche scientifique, ces réalisations illustrent l'évolution rapide de l'intelligence machine. Dans cet article, nous explorons les avancées récentes les plus impressionnantes en IA, en soulignant leur impact, leurs applications potentielles et l'avenir de l'innovation en IA.

Depuis plusieurs années (2023–2025), l'intelligence artificielle a fait des bonds en avant sur de nombreux fronts. Les grands modèles de langage (LLM) et chatbots, les systèmes multimodaux, les outils scientifiques d'IA et la robotique ont tous connu des percées.

Les géants de la tech ont lancé de nouveaux assistants IA, les communautés open source ont déployé des modèles puissants, et même les régulateurs ont commencé à aborder l'impact de l'IA.

Nous passons en revue ci-dessous les réalisations les plus marquantes, des extensions de GPT-4 et Gemini de Google au prix Nobel d'AlphaFold et aux découvertes scientifiques et artistiques pilotées par l'IA.

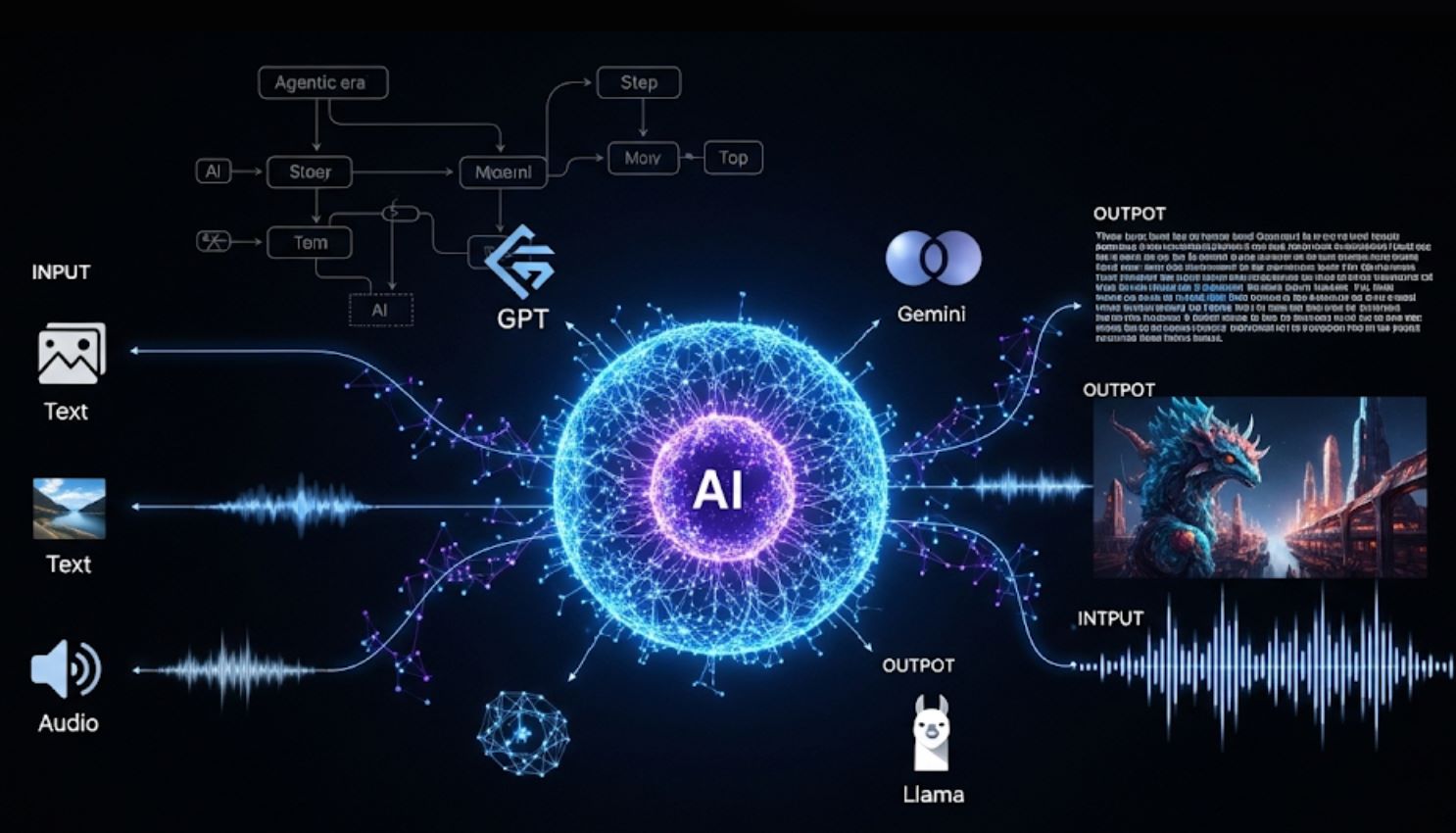

Modèles de Langage Génératifs et Chatbots

Les LLM modernes sont devenus bien plus performants et multimodaux. Le GPT-4 Turbo d'OpenAI (annoncé en nov. 2023) peut désormais traiter 128 000 tokens en une seule requête (environ 300 pages de texte) et coûte beaucoup moins cher à exploiter que GPT-4.

GPT-4o représente un changement fondamental vers une IA véritablement multimodale capable de gérer de manière fluide texte, images et audio en conversations en temps réel.

— Équipe de recherche OpenAI, mai 2024

En mai 2024, OpenAI a introduit GPT-4o (Omni), un modèle amélioré qui traite texte, images et audio en temps réel – offrant ainsi à GPT-4 une "vision et une audition" conversationnelles. ChatGPT intègre désormais des fonctionnalités d'image et de voix : les utilisateurs peuvent télécharger des photos ou parler au bot, qui répondra en fonction de ces entrées visuelles ou audio.

GPT-4 Turbo & GPT-4o

GPT-4 Turbo (nov. 2023) : Coûts réduits et contexte étendu à 128K tokens.

GPT-4o (mai 2024) : IA véritablement multimodale, générant texte, parole et images avec une vitesse proche de celle des humains.

Évolution de ChatGPT

Fin 2023, ChatGPT "voit, entend et parle" – images et audio peuvent être téléchargés ou prononcés comme requêtes.

Intégration de DALL·E 3 (oct. 2023) pour la génération d'images conversationnelle.

Série Gemini de Google

En déc. 2024, Google DeepMind a lancé les premiers modèles Gemini 2.0 ("Flash" et prototypes) conçus pour "l'ère agentique" – une IA capable d'exécuter de manière autonome des tâches en plusieurs étapes.

- Testée par plus d'un milliard d'utilisateurs

- Capacités de raisonnement améliorées

- Compétences multimodales avancées

Modèles Open Source & Entreprise

Meta a publié LLaMA 3 en avril 2024 (LLM open-weight jusqu'à 400 milliards de paramètres) revendiquant des performances supérieures.

- Progrès de Claude 3 d'Anthropic

- Intégration de Microsoft Copilot

- API Assistants d'OpenAI

Elles alimentent aussi de nouvelles applications "assistantes" via des API (Google "AI Overviews", API Assistants d'OpenAI, etc.), rendant l'IA plus accessible aux développeurs et utilisateurs finaux.

Progrès Multimodaux & Créatifs en IA

La créativité et la compréhension visuelle de l'IA ont explosé. Les modèles texte-vers-image et texte-vers-vidéo ont atteint de nouveaux sommets :

Le DALL·E 3 d'OpenAI (oct. 2023) génère des images photoréalistes à partir de requêtes et est même intégré à ChatGPT pour guider la rédaction des prompts.

Google a introduit Imagen 3 (oct. 2024) et Veo 2 (déc. 2024) – moteurs de pointe texte-vers-image et texte-vers-vidéo – qui améliorent considérablement la qualité, le détail et la cohérence dans l'art et la vidéo générés par IA.

Même l'IA musicale a progressé avec les outils MusicFX de Google et les recherches associées (par ex. expériences MusicLM).

Capacités Avancées de Génération

- DALL·E 3 et Imagen 3 : Suivent fidèlement des prompts subtils (y compris texte intégré dans les images)

- Veo 2 de Google : Génère des clips vidéo courts à partir de descriptions textuelles uniques, marquant un progrès significatif en synthèse vidéo

- Stable Diffusion et Midjourney : Versions récentes (v3, v6) avec réalisme amélioré tout au long de 2024

Intégration Apple Intelligence

Apple a lancé Apple Intelligence (dans iOS 18 et macOS 15, fin 2024) – IA générative intégrée sur iPhone/iPad/Mac.

Écriture & Communication

- Réécriture, correction, résumé dans Mail/Pages

- Capacités Siri améliorées

- Traitement du langage naturel

Outils Visuels & Créatifs

- Image Playground : Création d'illustrations via texte

- Genmoji : Emojis personnalisés générés par IA

- Clean Up : Suppression d'objets indésirables sur photos

Réalisation Historique sur le Marché de l'Art

Un exemple marquant : en nov. 2024, Sotheby's a vendu la première peinture réalisée par un robot humanoïde.

Vente d'Art IA Record

Un portrait d'Alan Turing dessiné par le robot IA Ai-Da s'est vendu pour 1,08 million de dollars US.

Cette vente record ("A.I. God : Portrait d'Alan Turing") souligne le rôle croissant de l'IA dans la créativité et son impact culturel.

Premiers Arts IA

- Productions axées sur la nouveauté

- Images surréalistes, abstraites

- Applications pratiques limitées

- Texte-vers-image basique uniquement

Créativité IA Moderne

- Génération d'images utiles (logos, diagrammes, cartes)

- Réalisme proche de l'humain

- Flux de travail créatifs intégrés

- Capacités multimodales

Globalement, les modèles génératifs démocratisent la créativité : chacun peut désormais générer art, musique ou vidéo avec quelques mots. L'industrie est passée de la simple nouveauté (images surréalistes) à la génération d'images utiles (logos, diagrammes, cartes) et au réalisme humain.

(En mars 2025, OpenAI a même publié "4o Image Generation", intégrant son meilleur modèle d'image dans GPT-4o pour des rendus précis et photoréalistes guidés par la conversation.)

Ces outils s'intègrent rapidement dans les applications, navigateurs et flux créatifs.

IA en Science, Médecine et Mathématiques

Les réalisations en IA ont stimulé la découverte scientifique et les avancées en recherche :

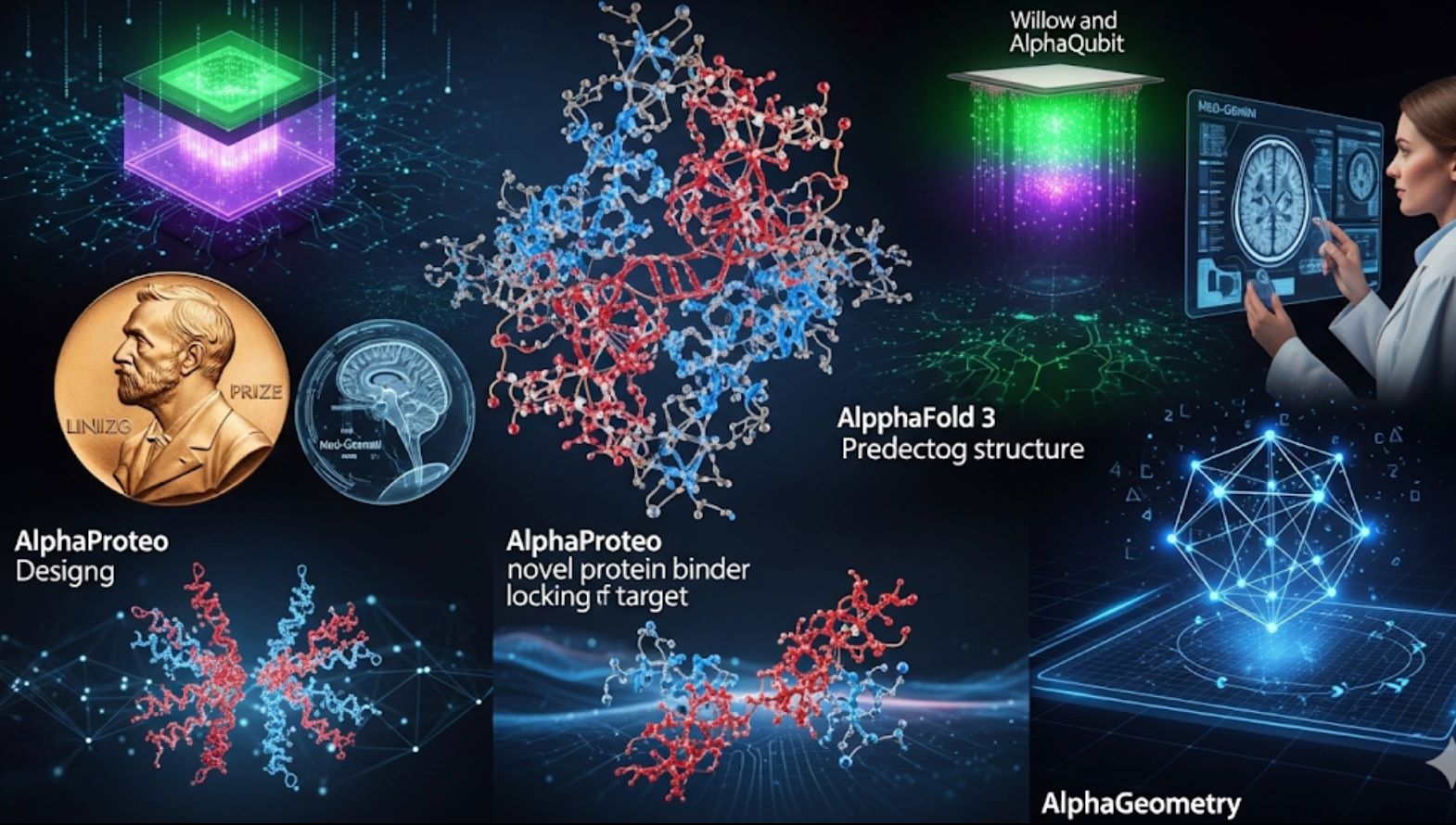

AlphaFold 3 – Prédiction Biomoléculaire Révolutionnaire

En nov. 2024, Google DeepMind (avec Isomorphic Labs) a dévoilé AlphaFold 3, un nouveau modèle qui prédit les structures 3D de toutes les biomolécules (protéines, ADN, ARN, ligands, etc.) simultanément, avec une précision sans précédent.

Ses créateurs ont immédiatement mis en ligne un serveur AlphaFold gratuit pour que les chercheurs du monde entier puissent prédire des structures moléculaires. Cela étend les prédictions uniquement protéiques d'AlphaFold 2 et devrait transformer la découverte de médicaments et la recherche en génomique.

AlphaProteo – Conception de Médicaments

Également en 2024, DeepMind a annoncé AlphaProteo, une IA qui conçoit de nouveaux ligands protéiques – des molécules qui se lient fortement aux protéines cibles.

- Accélère la création d'anticorps

- Développe des biosenseurs

- Génère des pistes médicamenteuses

- Crée des structures protéiques pour des cibles spécifiées

Mathématiques – AlphaGeometry

AlphaGeometry et AlphaProof de DeepMind ont démontré une autre percée.

- 19 secondes pour résoudre un problème de l'Olympiade Internationale de Mathématiques

- Performance au niveau médaillé d'argent

- Capacités avancées en mathématiques de lycée

Percées en Informatique Quantique – AlphaQubit & Willow

L'IA a aussi amélioré le matériel de pointe. En 2024, Google a annoncé AlphaQubit, un décodeur IA qui identifie les erreurs dans les ordinateurs quantiques (par ex. puces Sycamore de Google) bien mieux que les méthodes précédentes.

Puis en déc. 2024, Google a dévoilé Willow, une nouvelle puce quantique qui, grâce à une correction d'erreur avancée, a résolu une tâche de référence en moins de 5 minutes, ce qui prendrait environ 10^24 ans au meilleur superordinateur actuel.

Med-Gemini représente un saut significatif dans les capacités médicales de l'IA, atteignant 91,1 % de précision sur les benchmarks d'examens médicaux américains – une performance surpassant largement les modèles précédents.

— Équipe de recherche Google Health AI, 2024

En médecine et santé, les modèles IA ont aussi progressé. Par exemple, le nouveau Med-Gemini de Google (affiné sur des données médicales) a obtenu 91,1 % sur un benchmark d'examen médical américain (style USMLE), dépassant largement les modèles antérieurs.

Des outils IA pour la radiologie et la pathologie (par ex. Derm et Path Foundations) ont été publiés pour améliorer l'analyse d'images. Globalement, l'IA est désormais un partenaire de recherche indispensable – de la cartographie du cerveau humain à l'échelle nanométrique (avec imagerie EM assistée par IA) à l'accélération du dépistage de la tuberculose en Afrique, comme rapporté par les chercheurs de Google.

IA en Robotique et Automatisation

Les robots pilotés par IA apprennent des tâches complexes du monde réel.

Les robots humanoïdes Optimus de Tesla ont été présentés publiquement en octobre 2024 (événement "We, Robot"). Plusieurs dizaines d'unités Optimus ont marché, tenu debout et même dansé sur scène – bien que des rapports ultérieurs aient noté que les démonstrations initiales étaient en partie télécommandées par des humains.

Cependant, l'événement a mis en lumière les progrès rapides vers des robots à usage général.

Robots ALOHA de DeepMind

Le laboratoire IA de Google a réalisé des avancées impressionnantes en robots domestiques. En 2024, le robot ALOHA (Assistant Ménager Autonome à Pattes) a appris à faire ses lacets, suspendre une chemise, réparer un autre robot, insérer des engrenages et même nettoyer une cuisine en utilisant uniquement la planification IA et la vision.

Les projets open source "ALOHA Unleashed" ont montré des robots coordonnant deux bras pour des tâches, une première en manipulation à usage général.

Transformers Robotiques

DeepMind a présenté RT-2 (Robotic Transformer 2), un modèle vision-langage-action capable d'apprendre à la fois à partir d'images internet et de données réelles de robots.

RT-2 permet aux robots d'interpréter des instructions comme un humain en exploitant les connaissances web. Il a été démontré aidant un robot à trier des objets en suivant des commandes textuelles.

Applications Industrielles

D'autres entreprises ont aussi progressé : Boston Dynamics a continué à affiner les robots Atlas et Spot (sans percée majeure annoncée), et les véhicules autonomes pilotés par IA se sont améliorés (le Full Self-Driving Beta de Tesla a été déployé plus largement, bien que l'autonomie complète reste non résolue).

Dans l'industrie, des sociétés centrées sur l'IA comme Figure AI ont levé des fonds pour construire des robots ménagers pour les tâches domestiques.

Phase de Démonstration

- Démonstrations contrôlées impressionnantes

- Apprentissage de tâches spécifiques

- Déploiement réel limité

- Supervision humaine requise

Autonomie Complète

- Collaboration humaine sécurisée

- Capacités à usage général

- Fonctionnement fiable en conditions réelles

- Déploiement à grande échelle

Ces efforts montrent des robots accomplissant des tâches de plus en plus difficiles sans programmation explicite. Cependant, les humanoïdes pleinement autonomes restent encore à venir.

Les démonstrations (Optimus, ALOHA, RT-2) sont des jalons, mais les chercheurs avertissent qu'il reste du travail avant que les robots puissent travailler en toute sécurité et fiabilité aux côtés des humains à grande échelle.

IA dans les Produits, l'Industrie et la Société

L'impact de l'IA s'étend aux produits quotidiens et même aux politiques :

Intégration de l'IA dans la Technologie Quotidienne

Les produits technologiques majeurs ont intégré des agents IA. Le Copilot de Microsoft (intégré à Windows, Office, Bing) et Bard/Bard AI de Google dans la recherche (avec Gemini derrière) ont apporté la puissance des LLM aux utilisateurs.

Les appareils Apple ont reçu Apple Intelligence (comme mentionné plus haut) et les fabricants de matériel comme Nvidia ont vendu un nombre record de GPU IA, alimentant à la fois le cloud et l'IA grand public.

Loi Européenne sur l'IA - Première Réglementation Globale

En réponse à l'ampleur de l'IA, les régulateurs ont aussi agi. Le 1er août 2024, le Règlement Européen sur l'IA est entré en vigueur, la première loi globale sur l'IA.

Cadre Basé sur les Risques

- IA à faible risque : Règles minimales (filtres anti-spam, jeux vidéo)

- Règles de transparence : Les systèmes IA doivent divulguer qu'ils sont des IA

- IA à haut risque : Surveillance stricte (outils médicaux, recrutement)

- IA inacceptable : Interdite (notation sociale gouvernementale)

Impact Global

Ce cadre (avec des directives à venir sur les modèles à usage général) est une avancée majeure en gouvernance de l'IA et devrait influencer les normes dans le monde entier.

Investissements et Valorisation Historiques

Le secteur de l'IA a connu des financements et valorisations historiques :

| Entreprise | Réalisation | Valeur/Impact | Signification |

|---|---|---|---|

| OpenAI | Valorisation | 157 milliards $ | Record |

| NVIDIA | Capitalisation boursière | 3,5+ billions $ | Leader matériel IA |

| Multiples Startups | Levées de fonds | Plusieurs milliards $ | Phase de croissance |

Ces chiffres soulignent à quel point l'IA est devenue centrale dans l'économie technologique.

Perspectives : Impact Transformateur de l'IA

En résumé, l'IA n'est plus confinée aux laboratoires ou aux démonstrations de nouveauté – elle est intégrée dans les téléphones, voitures, lieux de travail et politiques publiques.

Révolution des Connaissances

Les vastes capacités de connaissance de GPT-4 démontrent le potentiel de l'IA comme assistant universel de savoir.

Percées Scientifiques

Les révolutions scientifiques d'AlphaFold montrent la puissance de l'IA pour accélérer la découverte et la recherche humaines.

Intégration Quotidienne

L'IA s'intègre de manière fluide dans nos outils et flux de travail quotidiens.

Les avancées ci-dessus – des vastes connaissances de GPT-4 aux révolutions scientifiques d'AlphaFold – démontrent la maturation rapide de l'IA.

En 2025, ces réalisations annoncent des applications IA encore plus puissantes et pratiques dans notre vie quotidienne.

No comments yet. Be the first to comment!