Cos'è Edge AI?

Edge AI (Intelligenza Artificiale Edge) è la combinazione di intelligenza artificiale (AI) e edge computing. Invece di inviare i dati al cloud per l'elaborazione, Edge AI consente a dispositivi intelligenti come smartphone, telecamere, robot o macchine IoT di analizzare e prendere decisioni direttamente sul dispositivo. Questo approccio aiuta a ridurre la latenza, risparmiare banda, migliorare la sicurezza e fornire reattività in tempo reale.

Edge AI (a volte chiamata "AI al bordo") significa eseguire modelli di intelligenza artificiale e apprendimento automatico su dispositivi locali (sensori, telecamere, smartphone, gateway industriali, ecc.) invece che in data center remoti. In altre parole, il "bordo" della rete – dove i dati vengono generati – gestisce l'elaborazione. Questo permette ai dispositivi di analizzare i dati immediatamente mentre vengono raccolti, invece di inviare costantemente dati grezzi al cloud.

Edge AI consente l'elaborazione in tempo reale direttamente sul dispositivo senza dipendere da un server centrale. Per esempio, una telecamera con Edge AI può rilevare e classificare oggetti al volo, fornendo un feedback istantaneo. Elaborando i dati localmente, Edge AI può funzionare anche con connessioni internet intermittenti o assenti.

— IBM Research

In sintesi, Edge AI porta semplicemente il calcolo più vicino alla fonte dei dati – distribuendo l'intelligenza su dispositivi o nodi vicini, accelerando le risposte e riducendo la necessità di trasmettere tutto al cloud.

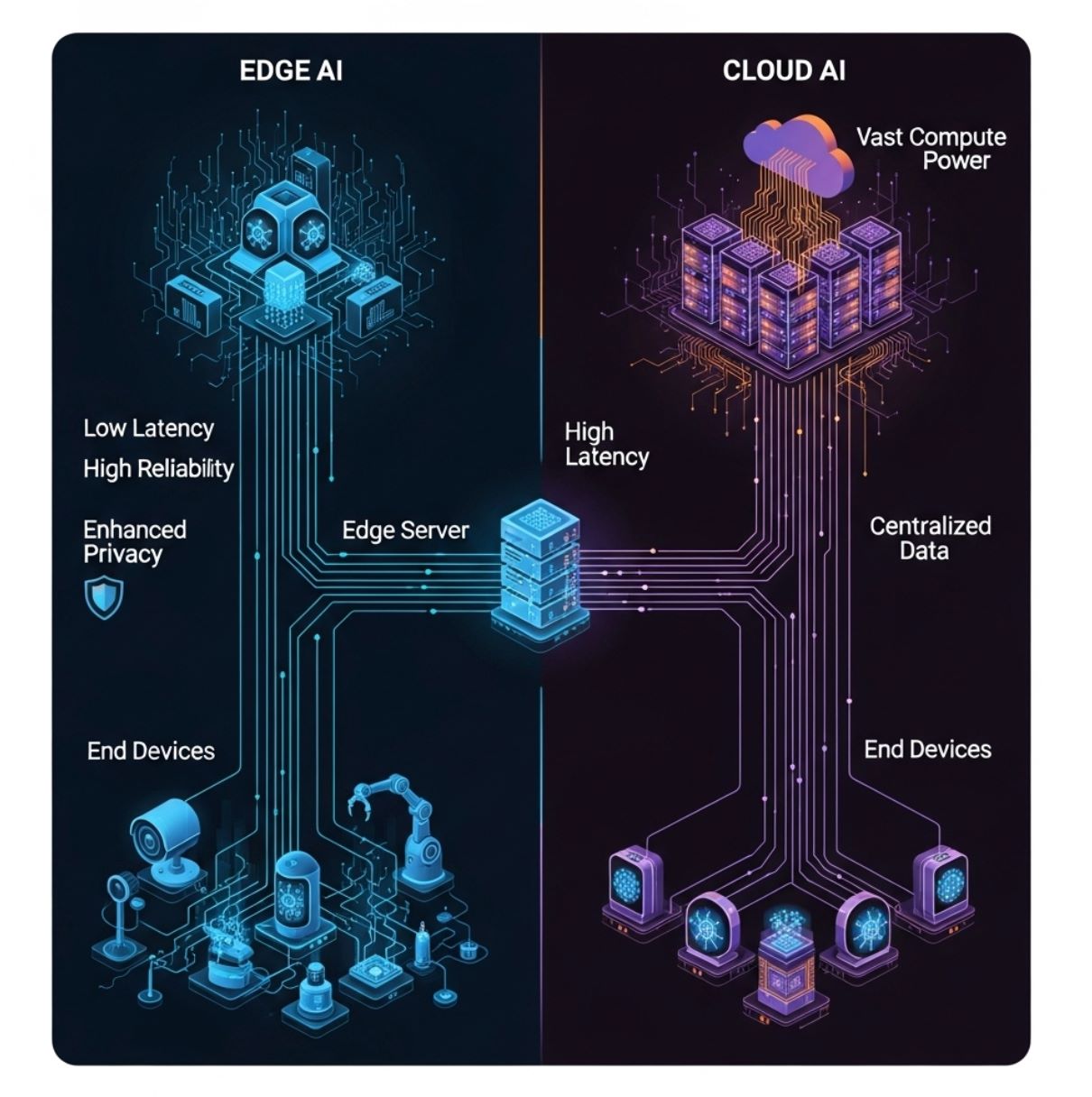

Edge AI vs Cloud AI: Differenze Chiave

A differenza dell'AI tradizionale basata sul cloud (che invia tutti i dati a server centralizzati), Edge AI distribuisce il calcolo tra hardware locale. Il diagramma sottostante illustra un modello semplice di edge computing: i dispositivi finali (livello inferiore) inviano dati a un server o gateway edge (livello intermedio) invece che solo al cloud distante (livello superiore).

In questa configurazione, l'inferenza AI può avvenire sul dispositivo o sul nodo edge locale, riducendo notevolmente i ritardi di comunicazione.

Approccio Tradizionale

- Dati inviati a server remoti

- Maggiore latenza dovuta a ritardi di rete

- Richiede connettività continua

- Risorse di calcolo illimitate

- Preoccupazioni sulla privacy durante la trasmissione dati

Approccio Moderno

- Elaborazione locale sui dispositivi

- Tempi di risposta in millisecondi

- Funziona offline quando necessario

- Risorse limitate ma efficienti

- Protezione della privacy migliorata

Latenza

Edge AI minimizza i ritardi. Poiché l'elaborazione è locale, le decisioni possono avvenire in millisecondi.

- Critico per attività sensibili al tempo

- Prevenzione di incidenti stradali

- Controllo robot in tempo reale

Banda

Edge AI riduce il carico di rete analizzando o filtrando i dati in loco.

- Molto meno informazioni inviate a monte

- Più efficiente e conveniente

- Riduce la congestione di rete

Privacy/Sicurezza

I dati sensibili possono essere elaborati e archiviati sul dispositivo, senza mai essere trasmessi al cloud.

- Voce, immagini, dati sanitari restano locali

- Riduce l'esposizione a violazioni di terze parti

- Riconoscimento facciale senza caricamenti di foto

Risorse di Calcolo

I dispositivi edge hanno potenza di calcolo limitata ma usano modelli ottimizzati.

- Modelli compatti e quantizzati

- Il training avviene ancora nel cloud

- Dimensioni limitate ma efficienti

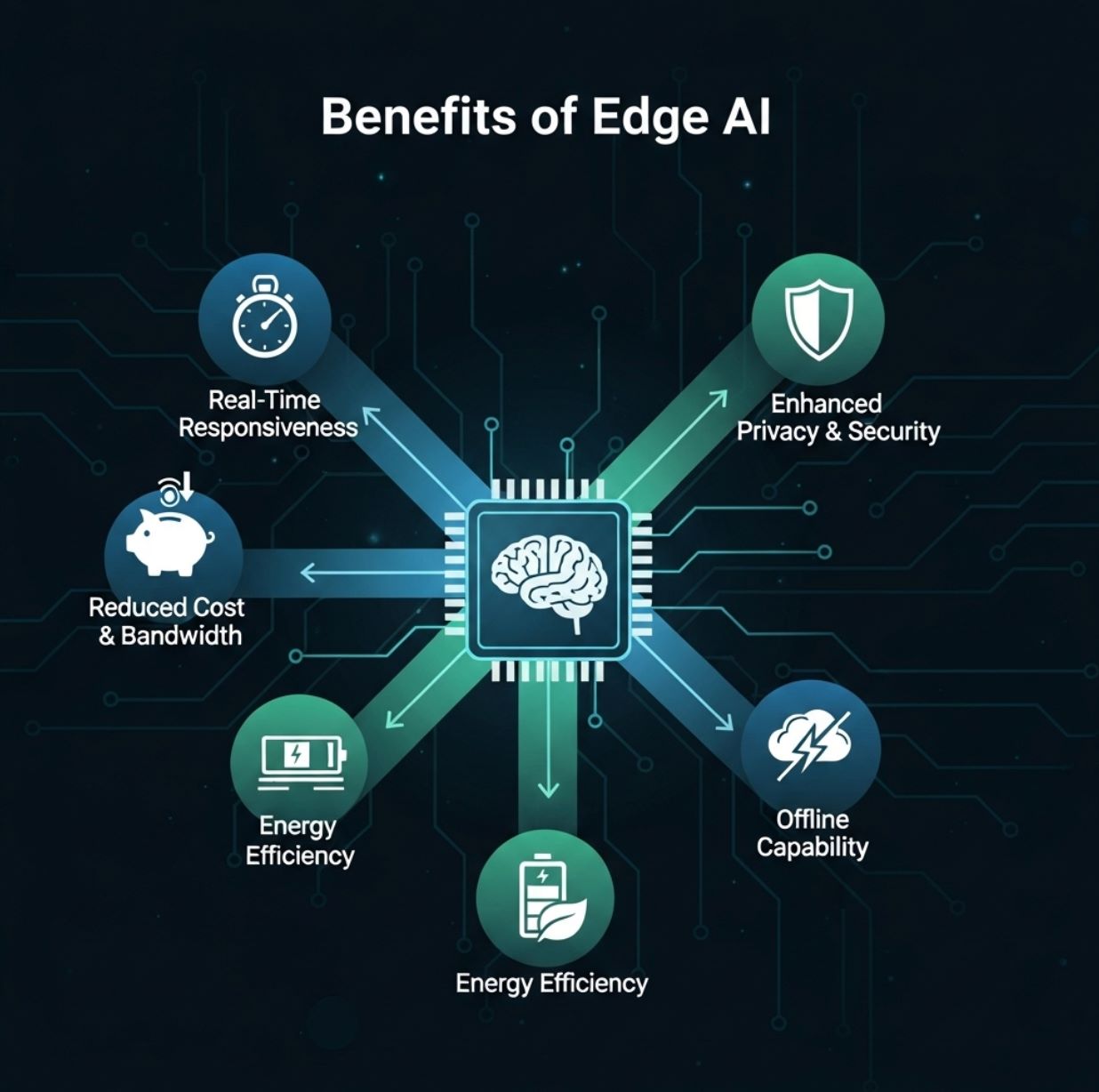

Vantaggi di Edge AI

Edge AI offre diversi vantaggi pratici per utenti e organizzazioni:

Reattività in Tempo Reale

- Rilevamento oggetti in diretta

- Sistemi di risposta vocale

- Avvisi di anomalie

- Applicazioni di realtà aumentata

Riduzione di Banda e Costi

- Telecamere di sicurezza caricano solo clip di minacce

- Streaming continuo ridotto

- Spese di hosting cloud inferiori

Privacy Migliorata

- Critico per sanità e finanza

- I dati restano all'interno del paese/struttura

- Conformità alle normative sulla privacy

Efficienza Energetica e di Costi

- Consumo energetico ridotto

- Costi server inferiori

- Ottimizzato per dispositivi mobili

Edge AI porta capacità di calcolo ad alte prestazioni al bordo, consentendo analisi in tempo reale e maggiore efficienza.

— Rapporto congiunto Red Hat & IBM

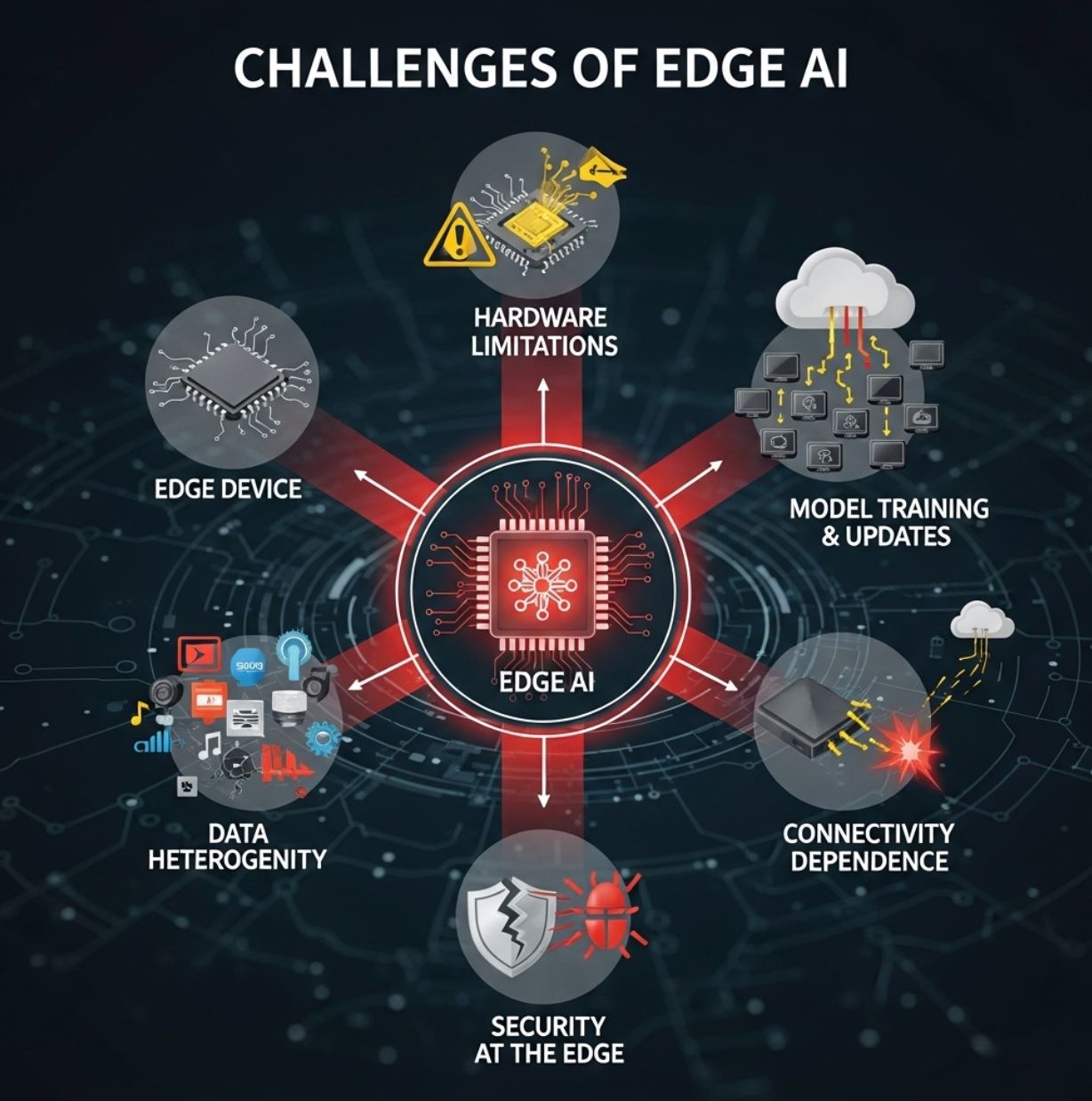

Sfide di Edge AI

Nonostante i vantaggi, Edge AI affronta anche ostacoli significativi:

Limitazioni Hardware

I dispositivi edge sono tipicamente piccoli e con risorse limitate. Possono avere solo CPU modeste o NPU a basso consumo specializzate, e memoria limitata.

- Obbliga all'uso di compressione e potatura dei modelli

- Tecniche TinyML necessarie per microcontrollori

- I modelli complessi non possono girare a piena scala

- Si può sacrificare un po' di accuratezza

Addestramento e Aggiornamenti dei Modelli

L'addestramento di modelli AI sofisticati avviene solitamente ancora nel cloud, dove sono disponibili grandi quantità di dati e potenza di calcolo.

- I modelli devono essere ottimizzati e distribuiti su ogni dispositivo

- Mantenere aggiornati migliaia di dispositivi è complesso

- La sincronizzazione del firmware aggiunge overhead

- Controllo delle versioni in sistemi distribuiti

Gravità e Eterogeneità dei Dati

Gli ambienti edge sono diversi. Diverse località possono raccogliere tipi di dati differenti, e le politiche possono variare per regione.

- I dati tendono a restare locali

- Difficile ottenere una visione globale

- I dispositivi hanno forme e dimensioni varie

- Sfide di integrazione e standardizzazione

Sicurezza al Bordo

Pur migliorando la privacy, Edge AI introduce nuove preoccupazioni di sicurezza. Ogni dispositivo o nodo è un potenziale bersaglio per hacker.

- I modelli devono essere a prova di manomissione

- Requisiti di sicurezza del firmware

- Superficie di attacco distribuita

- Necessità di robuste misure di protezione

Dipendenze di Connettività

Nonostante l'inferenza possa essere locale, i sistemi edge spesso dipendono ancora dalla connettività cloud per compiti pesanti.

- Il riaddestramento dei modelli richiede accesso al cloud

- L'analisi dati su larga scala necessita di connettività

- Aggregazione di risultati distribuiti

- Connettività limitata può creare colli di bottiglia

Casi d'Uso di Edge AI

Edge AI viene applicata in molti settori con impatti concreti:

Veicoli Autonomi

Le auto a guida autonoma usano Edge AI a bordo per elaborare istantaneamente dati da telecamere e radar per navigazione ed evitamento ostacoli.

- Non possono permettersi ritardi nell'invio video al server

- Rilevamento oggetti avviene localmente

- Riconoscimento pedoni in tempo reale

- Monitoraggio corsie senza connettività

Manifatturiero e Industria 4.0

Le fabbriche utilizzano telecamere intelligenti e sensori sulle linee di produzione per rilevare difetti o anomalie in tempo reale.

Controllo Qualità

Le telecamere Edge AI individuano prodotti difettosi sui nastri trasportatori e attivano azioni immediate.

Manutenzione Predittiva

Le macchine industriali usano AI on-site per prevedere guasti prima che si verifichino rotture.

Sanità e Pronto Intervento

Dispositivi medici portatili e ambulanze ora usano Edge AI per analizzare i dati dei pazienti sul posto.

- Ecografie a bordo ambulanza con analisi AI

- Monitor di segni vitali rilevano anomalie

- Avvisi ai paramedici su lesioni interne

- Monitoraggio pazienti ICU con allarmi immediati

Smart Cities

I sistemi urbani usano Edge AI per gestione traffico, sorveglianza e monitoraggio ambientale.

Gestione Traffico

Sorveglianza

Monitoraggio Ambientale

Retail e IoT per Consumatori

Edge AI migliora l'esperienza cliente e la comodità in applicazioni retail e consumer.

Analisi in Negozio

Telecamere intelligenti e sensori sugli scaffali monitorano comportamento clienti e livelli di inventario istantaneamente.

Dispositivi Mobili

Gli smartphone eseguono riconoscimento vocale e facciale sul dispositivo senza accesso al cloud per sblocco e identificazione gestuale.

Monitoraggio Fitness

Wearable analizzano dati sanitari (battito cardiaco, passi) localmente per fornire feedback in tempo reale.

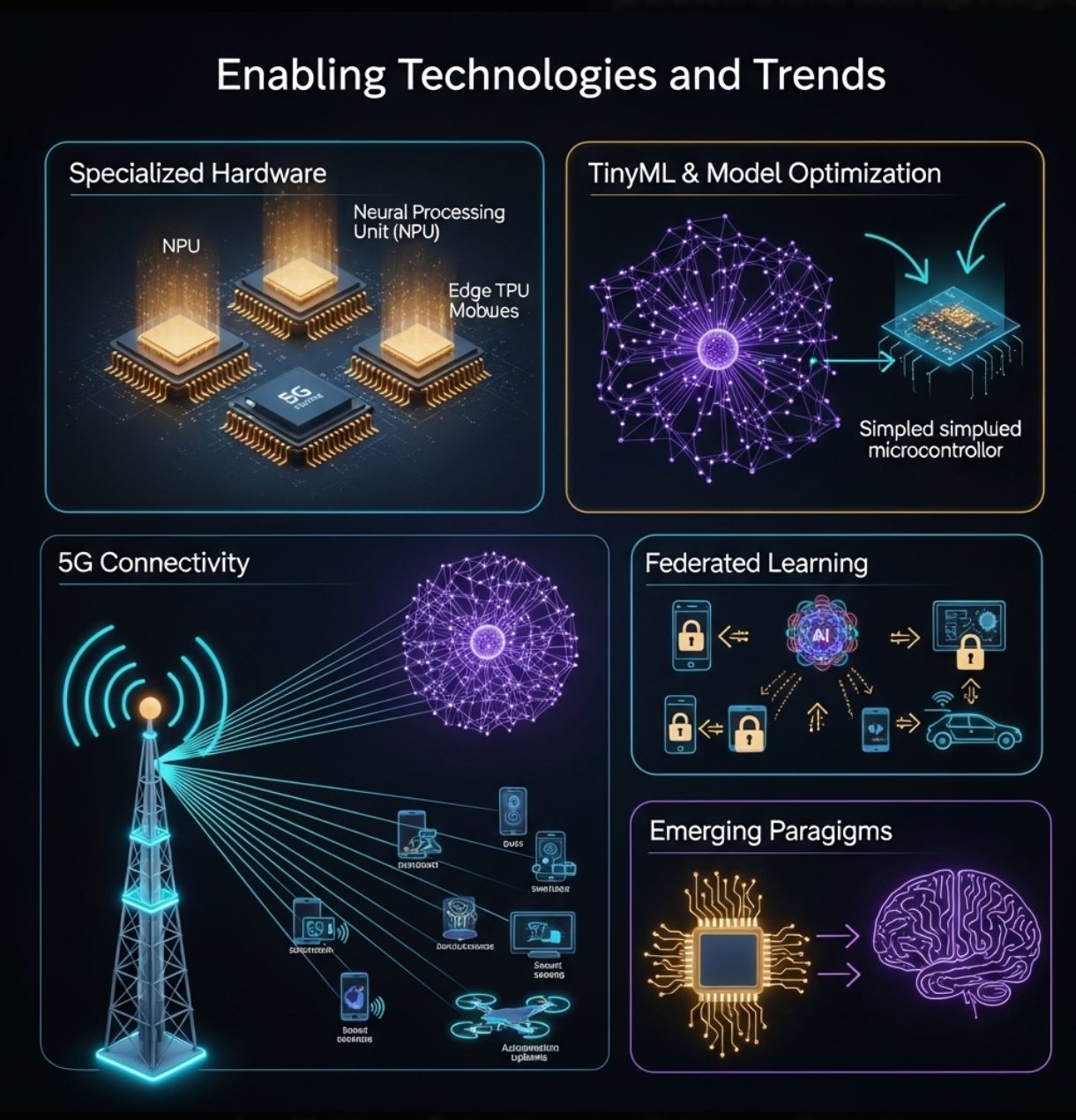

Tecnologie Abilitanti e Tendenze

La crescita di Edge AI è alimentata dai progressi sia hardware che software:

Hardware Specializzato

I produttori stanno costruendo chip progettati specificamente per l'inferenza edge.

- Acceleratori neurali a basso consumo (NPU)

- Google Coral Edge TPU

- NVIDIA Jetson Nano

- Arduino e Raspberry Pi con add-on AI

TinyML e Ottimizzazione Modelli

Strumenti e tecniche rendono possibile ridurre le reti neurali per dispositivi minuscoli.

- Ottimizzazione TensorFlow Lite

- Potatura e quantizzazione modelli

- Distillazione della conoscenza

- TinyML per microcontrollori

5G e Connettività

La wireless di nuova generazione offre alta banda e bassa latenza che completano Edge AI.

- Reti locali veloci per coordinamento dispositivi

- Scarico di compiti pesanti quando necessario

- Fabbriche intelligenti e comunicazione V2X

- Cluster di dispositivi edge potenziati

Federated Learning

Metodi che preservano la privacy permettono a più dispositivi edge di addestrare modelli insieme senza condividere dati grezzi.

- Miglioramento locale del modello

- Condivisione solo degli aggiornamenti del modello

- Utilizzo distribuito dei dati

- Protezione della privacy migliorata

Queste tecnologie continuano a spingere i confini di ciò che Edge AI può fare. Insieme, aiutano a realizzare l'"era dell'inferenza AI" – spostando l'intelligenza più vicino a utenti e sensori.

Conclusione

Edge AI sta trasformando il modo in cui usiamo l'intelligenza artificiale spostando il calcolo alla fonte dei dati. Complementa l'AI cloud, offrendo analisi più rapide, efficienti e private su dispositivi locali.

Questo approccio affronta le sfide di tempo reale e banda insite nelle architetture cloud-centriche. In pratica, Edge AI alimenta una vasta gamma di tecnologie moderne – da sensori intelligenti e fabbriche a droni e auto a guida autonoma – abilitando intelligenza immediata.

Con la proliferazione dei dispositivi IoT e il miglioramento delle reti, Edge AI è destinata a crescere ulteriormente. I progressi hardware (microchip potenti, TinyML) e tecniche (federated learning, ottimizzazione modelli) rendono più facile portare l'AI ovunque.

No comments yet. Be the first to comment!