Qu'est-ce que l'Edge AI ?

L'Edge AI (Intelligence Artificielle en périphérie) est la combinaison de l'intelligence artificielle (IA) et de l'informatique en périphérie. Au lieu d'envoyer les données vers le cloud pour traitement, l'Edge AI permet aux appareils intelligents tels que les smartphones, caméras, robots ou machines IoT d'analyser et de prendre des décisions directement sur l'appareil. Cette approche aide à réduire la latence, économiser la bande passante, renforcer la sécurité et offrir une réactivité en temps réel.

Edge AI (parfois appelée « IA en périphérie ») signifie exécuter des modèles d'intelligence artificielle et d'apprentissage automatique sur des appareils locaux (capteurs, caméras, smartphones, passerelles industrielles, etc.) plutôt que dans des centres de données distants. En d'autres termes, le « bord » du réseau – là où les données sont générées – gère le calcul. Cela permet aux appareils d'analyser les données immédiatement dès leur collecte, au lieu d'envoyer constamment des données brutes vers le cloud.

L'Edge AI permet un traitement en temps réel directement sur l'appareil sans dépendre d'un serveur central. Par exemple, une caméra avec Edge AI peut détecter et classifier des objets instantanément, fournissant un retour immédiat. En traitant les données localement, l'Edge AI peut fonctionner même avec une connexion internet intermittente ou absente.

— IBM Research

En résumé, l'Edge AI rapproche simplement le calcul de la source des données – en déployant l'intelligence sur les appareils ou les nœuds proches, ce qui accélère les réponses et réduit la nécessité de tout transmettre au cloud.

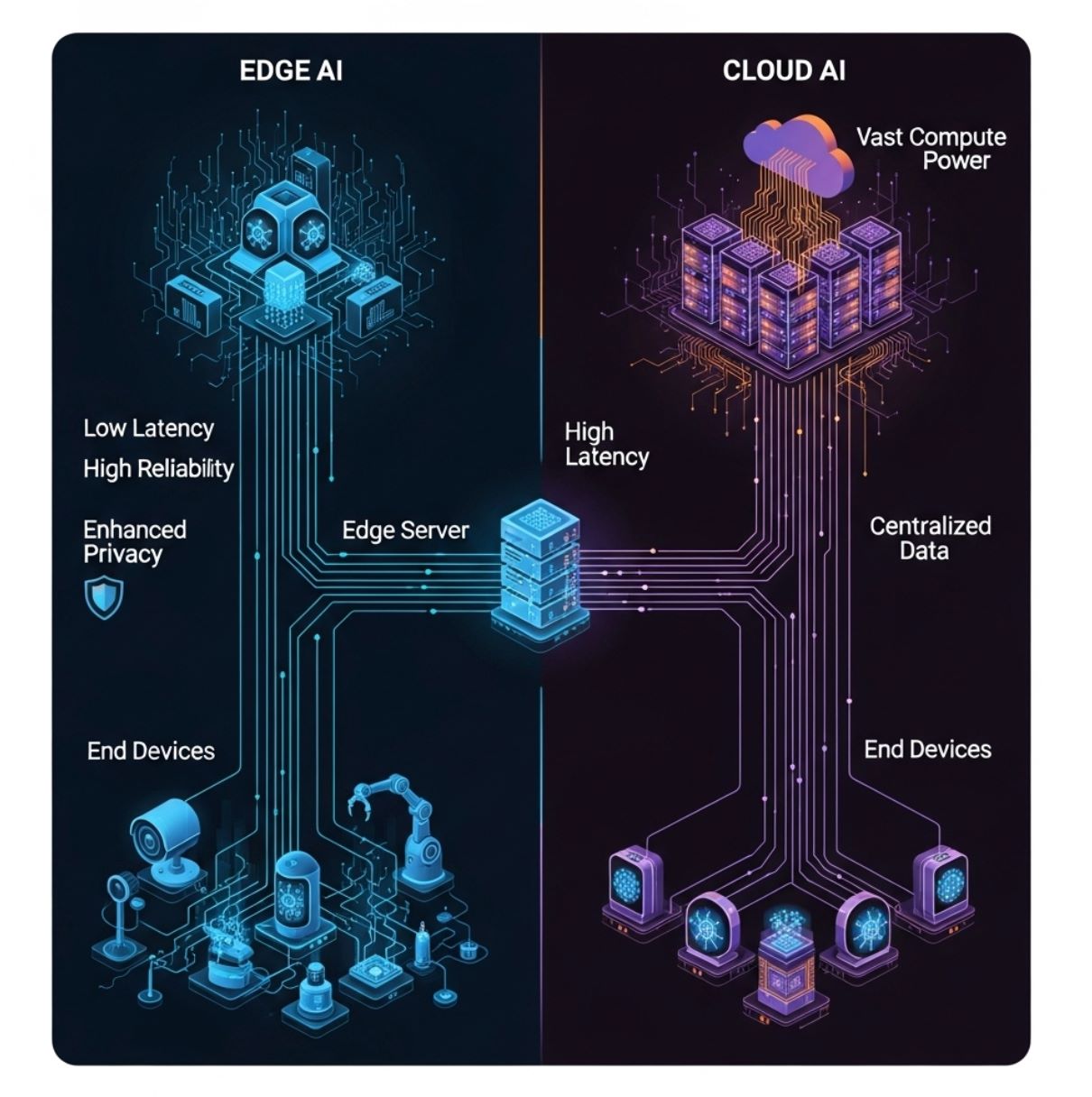

Edge AI vs Cloud AI : différences clés

Contrairement à l'IA traditionnelle basée sur le cloud (qui envoie toutes les données vers des serveurs centralisés), l'Edge AI distribue le calcul parmi le matériel sur site. Le schéma ci-dessous illustre un modèle simple d'informatique en périphérie : les appareils finaux (couche inférieure) alimentent un serveur ou une passerelle en périphérie (couche intermédiaire) au lieu d'envoyer uniquement vers le cloud distant (couche supérieure).

Dans cette configuration, l'inférence IA peut se faire sur l'appareil ou le nœud local en périphérie, réduisant considérablement les délais de communication.

Approche traditionnelle

- Données envoyées vers des serveurs distants

- Latence élevée due aux délais réseau

- Nécessite une connectivité continue

- Ressources de calcul illimitées

- Problèmes de confidentialité lors de la transmission des données

Approche moderne

- Traitement local sur les appareils

- Temps de réponse en millisecondes

- Fonctionne hors ligne si nécessaire

- Ressources limitées mais efficaces

- Protection renforcée de la vie privée

Latence

L'Edge AI minimise les délais. Comme le traitement est local, les décisions peuvent se prendre en millisecondes.

- Critique pour les tâches sensibles au temps

- Éviter les accidents de voiture

- Contrôle des robots en temps réel

Bande passante

L'Edge AI réduit la charge réseau en analysant ou filtrant les données sur place.

- Beaucoup moins d'informations envoyées en amont

- Plus efficace et économique

- Réduit la congestion réseau

Confidentialité/Sécurité

Les données sensibles peuvent être traitées et stockées sur l'appareil, jamais transmises au cloud.

- Voix, images, données de santé restent locales

- Réduit l'exposition aux violations tierces

- Reconnaissance faciale sans upload de photos

Ressources de calcul

Les appareils en périphérie ont une puissance limitée mais utilisent des modèles optimisés.

- Modèles compacts et quantifiés

- La formation se fait toujours dans le cloud

- Contraint en taille mais efficace

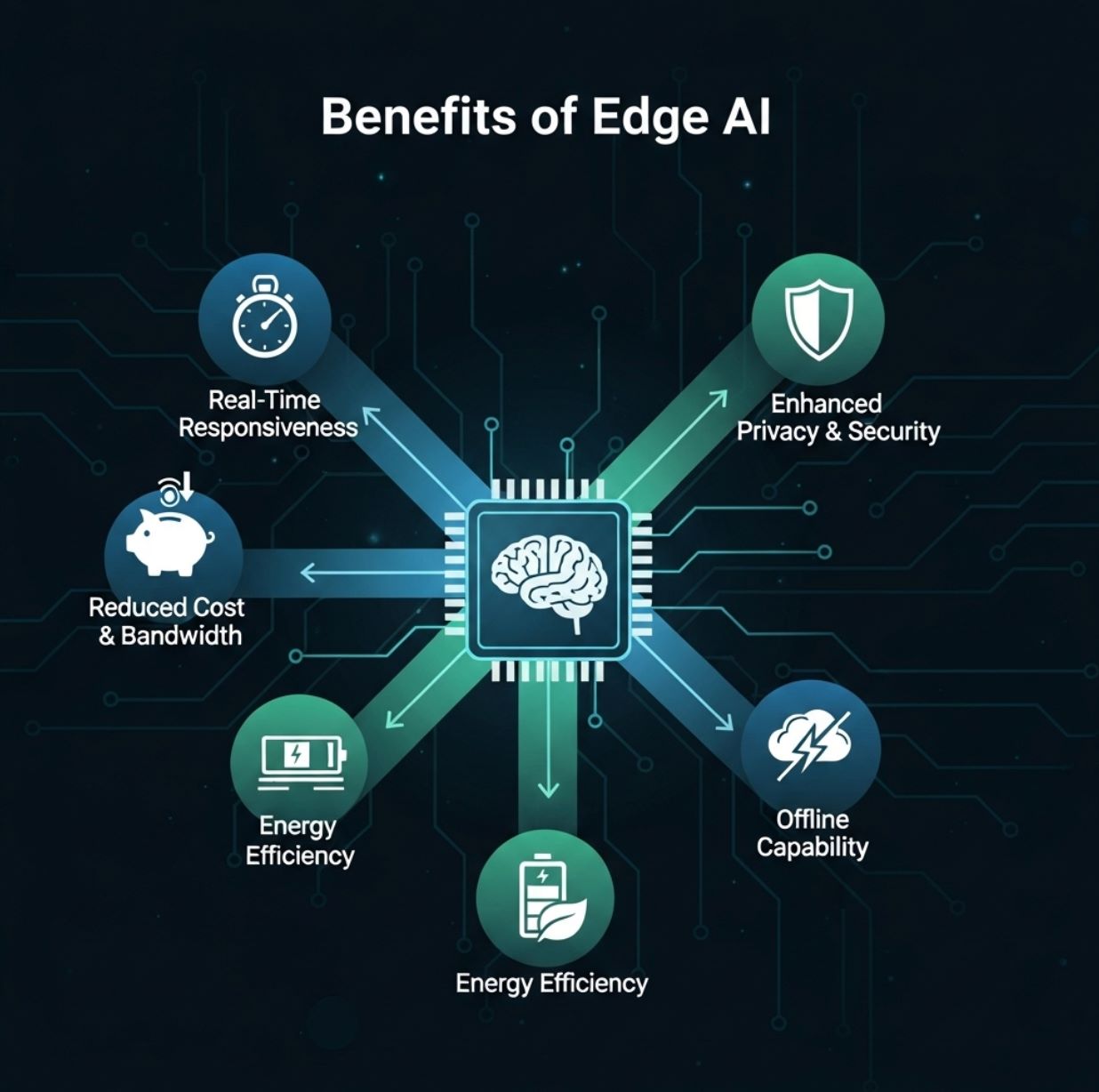

Avantages de l'Edge AI

L'Edge AI offre plusieurs avantages pratiques pour les utilisateurs et les organisations :

Réactivité en temps réel

- Détection d'objets en direct

- Systèmes de réponse vocale

- Alertes d'anomalies

- Applications de réalité augmentée

Réduction de la bande passante et des coûts

- Les caméras de sécurité ne téléchargent que les clips de menace

- Réduction du streaming continu

- Moins de frais d'hébergement cloud

Confidentialité renforcée

- Essentiel pour la santé et la finance

- Les données restent dans le pays ou l'établissement

- Conformité aux réglementations sur la vie privée

Efficacité énergétique et économique

- Consommation électrique réduite

- Coûts serveur diminués

- Optimisé pour les appareils mobiles

L'Edge AI apporte des capacités de calcul haute performance en périphérie, permettant une analyse en temps réel et une efficacité améliorée.

— Rapport conjoint Red Hat & IBM

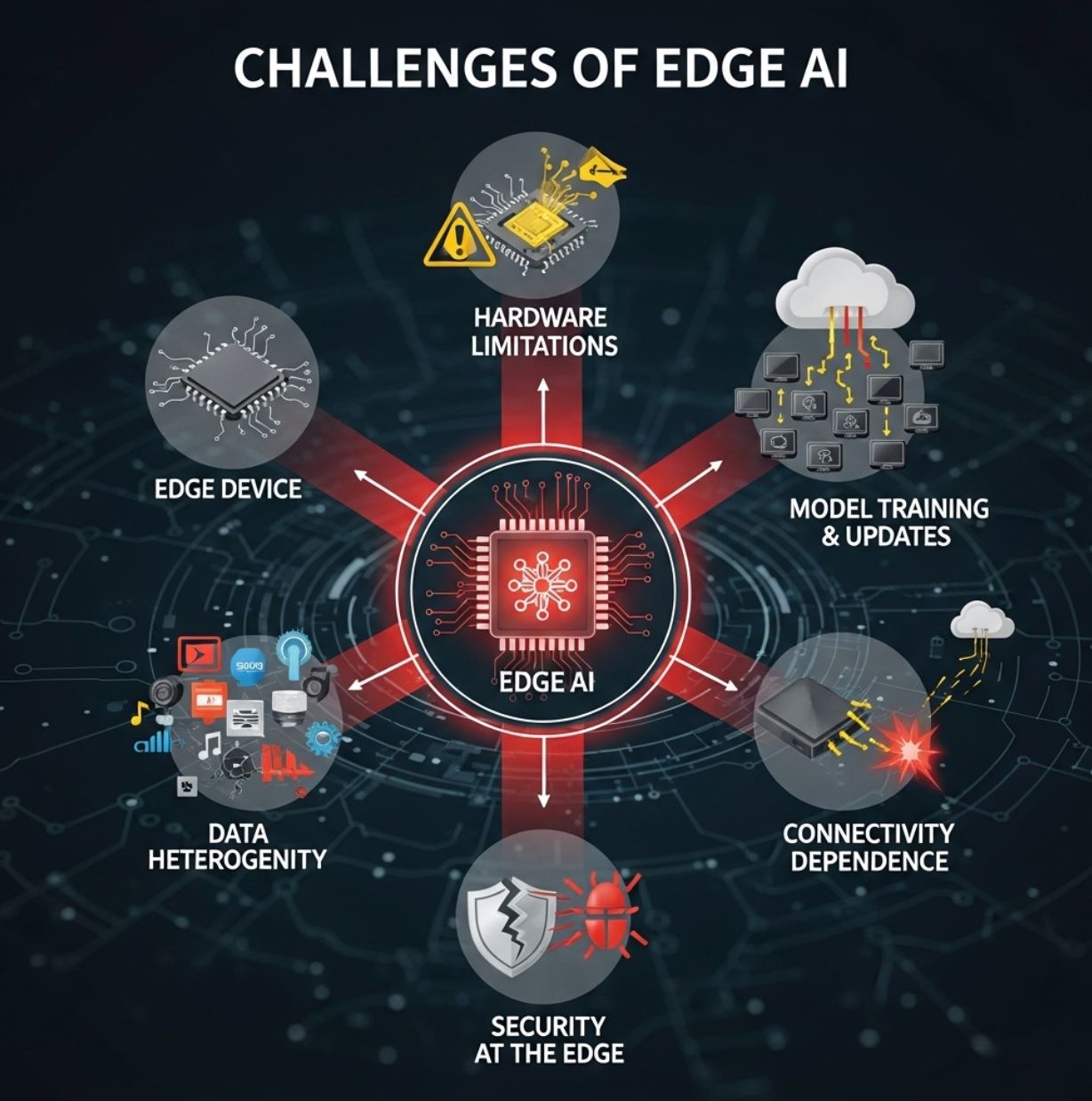

Défis de l'Edge AI

Malgré ses avantages, l'Edge AI fait face à des obstacles importants :

Limitations matérielles

Les appareils en périphérie sont généralement petits et limités en ressources. Ils disposent souvent de CPU modestes ou de NPU basse consommation spécialisés, et d'une mémoire restreinte.

- Oblige à utiliser compression et élagage des modèles

- Techniques TinyML nécessaires pour microcontrôleurs

- Les modèles complexes ne peuvent pas fonctionner à grande échelle

- Une certaine précision peut être sacrifiée

Formation et mises à jour des modèles

La formation de modèles IA sophistiqués se fait généralement encore dans le cloud, où les données massives et la puissance de calcul sont disponibles.

- Les modèles doivent être optimisés et déployés sur chaque appareil

- Maintenir des milliers d'appareils à jour est complexe

- La synchronisation du firmware ajoute une charge

- Gestion des versions dans des systèmes distribués

Gravité des données et hétérogénéité

Les environnements en périphérie sont divers. Différents lieux peuvent collecter différents types de données, et les politiques peuvent varier selon les régions.

- Les données tendent à rester locales

- Difficile d'obtenir une vue globale

- Les appareils ont toutes formes et tailles

- Défis d'intégration et de standardisation

Sécurité en périphérie

Bien que l'Edge AI améliore la confidentialité, il introduit aussi de nouvelles préoccupations de sécurité. Chaque appareil ou nœud est une cible potentielle pour les hackers.

- Les modèles doivent être inviolables

- Exigences de sécurité du firmware

- Surface d'attaque distribuée

- Des protections solides sont nécessaires

Dépendances de connectivité

Bien que l'inférence puisse être locale, les systèmes en périphérie dépendent souvent encore de la connectivité cloud pour les tâches lourdes.

- La reformation des modèles nécessite un accès cloud

- L'analyse de données à grande échelle demande une connectivité

- Agrégation des résultats distribués

- Une connectivité limitée peut freiner les fonctions

Cas d'usage de l'Edge AI

L'Edge AI est appliquée dans de nombreux secteurs avec un impact concret :

Véhicules autonomes

Les voitures autonomes utilisent l'Edge AI embarquée pour traiter instantanément les données des caméras et radars pour la navigation et l'évitement d'obstacles.

- Impossible de tolérer le délai d'envoi vidéo au serveur

- La détection d'objets se fait localement

- Reconnaissance des piétons en temps réel

- Suivi de voie sans connectivité

Industrie et Industrie 4.0

Les usines déploient des caméras intelligentes et des capteurs sur les lignes de production pour détecter en temps réel défauts ou anomalies.

Contrôle qualité

Les caméras Edge AI repèrent les produits défectueux sur les tapis roulants et déclenchent une action immédiate.

Maintenance prédictive

Les machines industrielles utilisent l'IA sur site pour prédire les pannes avant qu'elles ne surviennent.

Santé et intervention d'urgence

Les dispositifs médicaux portables et les ambulances utilisent désormais l'Edge AI pour analyser les données patients sur place.

- Échographie embarquée avec analyse IA

- Moniteurs de signes vitaux détectant les anomalies

- Alerte des ambulanciers sur blessures internes

- Surveillance des patients en soins intensifs avec alarmes instantanées

Villes intelligentes

Les systèmes urbains utilisent l'Edge AI pour la gestion du trafic, la surveillance et la détection environnementale.

Gestion du trafic

Surveillance

Surveillance environnementale

Commerce et IoT grand public

L'Edge AI améliore l'expérience client et la commodité dans le commerce et les applications grand public.

Analyse en magasin

Les caméras intelligentes et capteurs d'étagères suivent instantanément le comportement des acheteurs et les niveaux de stock.

Appareils mobiles

Les smartphones exécutent la reconnaissance vocale et faciale localement sans accès au cloud pour le déverrouillage et l'identification gestuelle.

Suivi fitness

Les objets connectés analysent localement les données de santé (rythme cardiaque, pas) pour fournir un retour en temps réel.

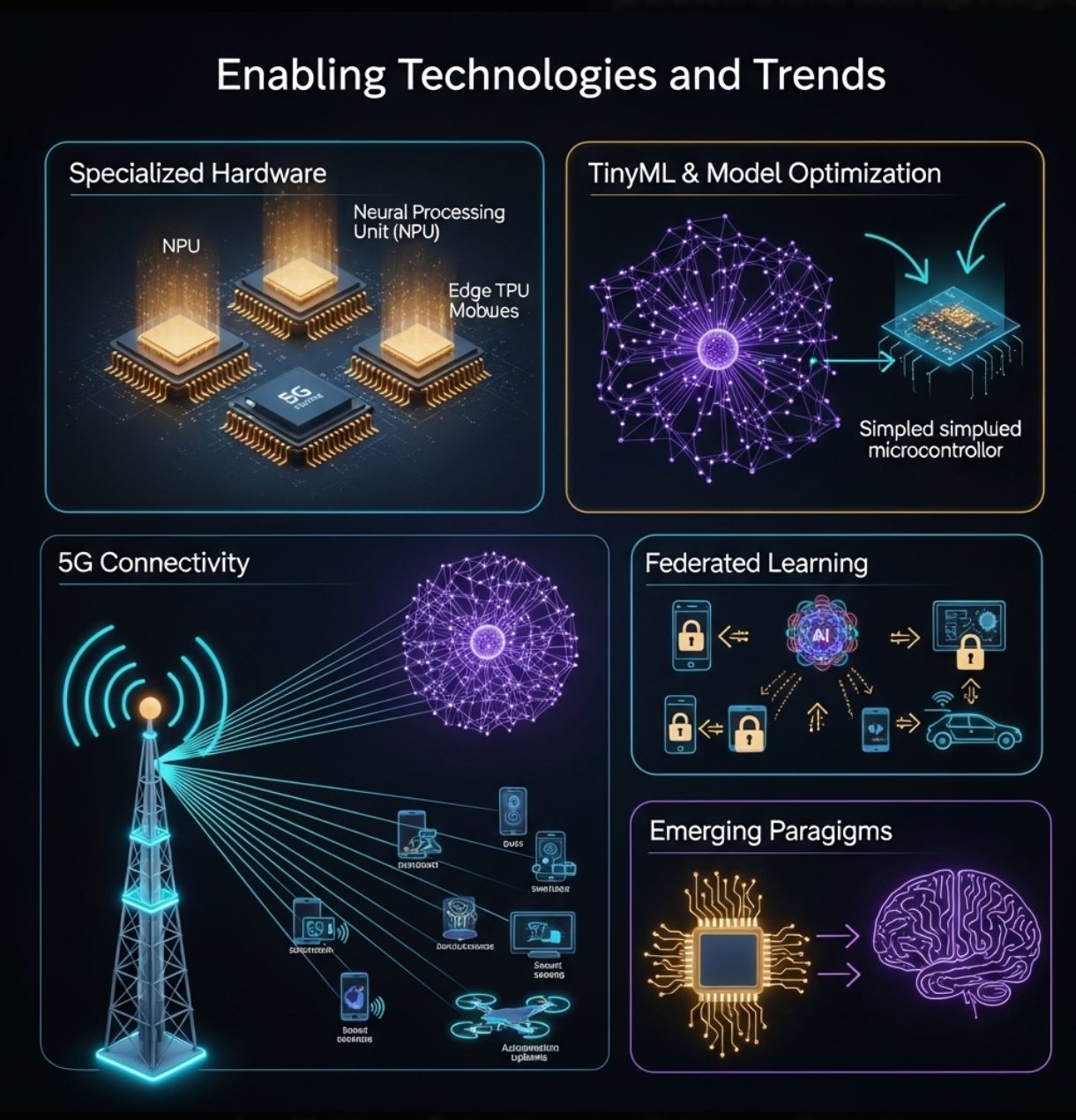

Technologies et tendances facilitantes

La croissance de l'Edge AI est alimentée par des avancées matérielles et logicielles :

Matériel spécialisé

Les fabricants conçoivent des puces spécifiquement dédiées à l'inférence en périphérie.

- Accélérateurs neuronaux basse consommation (NPU)

- Google Coral Edge TPU

- NVIDIA Jetson Nano

- Arduino et Raspberry Pi avec extensions IA

TinyML et optimisation des modèles

Des outils et techniques permettent de réduire la taille des réseaux neuronaux pour les petits appareils.

- Optimisation TensorFlow Lite

- Élagage et quantification des modèles

- Distillation des connaissances

- TinyML pour microcontrôleurs

5G et connectivité

La génération suivante de réseaux sans fil offre une bande passante élevée et une faible latence qui complètent l'Edge AI.

- Réseaux locaux rapides pour coordination des appareils

- Déchargement des tâches lourdes si nécessaire

- Usines intelligentes et communication V2X

- Clusters d'appareils en périphérie améliorés

Apprentissage fédéré

Les méthodes préservant la confidentialité permettent à plusieurs appareils en périphérie de former conjointement des modèles sans partager les données brutes.

- Amélioration locale des modèles

- Partage uniquement des mises à jour de modèles

- Utilisation distribuée des données

- Protection renforcée de la vie privée

Ces technologies continuent de repousser les limites de ce que l'Edge AI peut accomplir. Ensemble, elles contribuent à l'ère de l'inférence IA – rapprochant l'intelligence des utilisateurs et des capteurs.

Conclusion

L'Edge AI transforme notre utilisation de l'intelligence artificielle en déplaçant le calcul vers la source des données. Elle complète l'IA cloud, offrant des analyses plus rapides, plus efficaces et plus privées sur des appareils locaux.

Cette approche répond aux défis de temps réel et de bande passante inhérents aux architectures centrées sur le cloud. En pratique, l'Edge AI alimente une large gamme de technologies modernes – des capteurs intelligents et usines aux drones et voitures autonomes – en permettant une intelligence instantanée sur place.

Avec la prolifération des appareils IoT et l'amélioration des réseaux, l'Edge AI est destinée à croître. Les progrès matériels (microprocesseurs puissants, TinyML) et techniques (apprentissage fédéré, optimisation des modèles) facilitent la généralisation de l'IA partout.

No comments yet. Be the first to comment!