Sinusuri ng AI ang datos ng eksperimento

Sa pananaliksik na siyentipiko, mahalaga ang bilis at katumpakan sa pagsusuri ng datos ng eksperimento. Noon, maaaring tumagal ng araw o linggo ang pagproseso ng mga dataset, ngunit binago ito ng Artificial Intelligence (AI). Kayang i-scan, iproseso, at kunin ng AI ang mga mahahalagang impormasyon mula sa napakalaking dami ng datos sa loob lamang ng ilang minuto, na tumutulong sa mga mananaliksik na makatipid ng oras, mabawasan ang mga pagkakamali, at mapabilis ang mga tuklas.

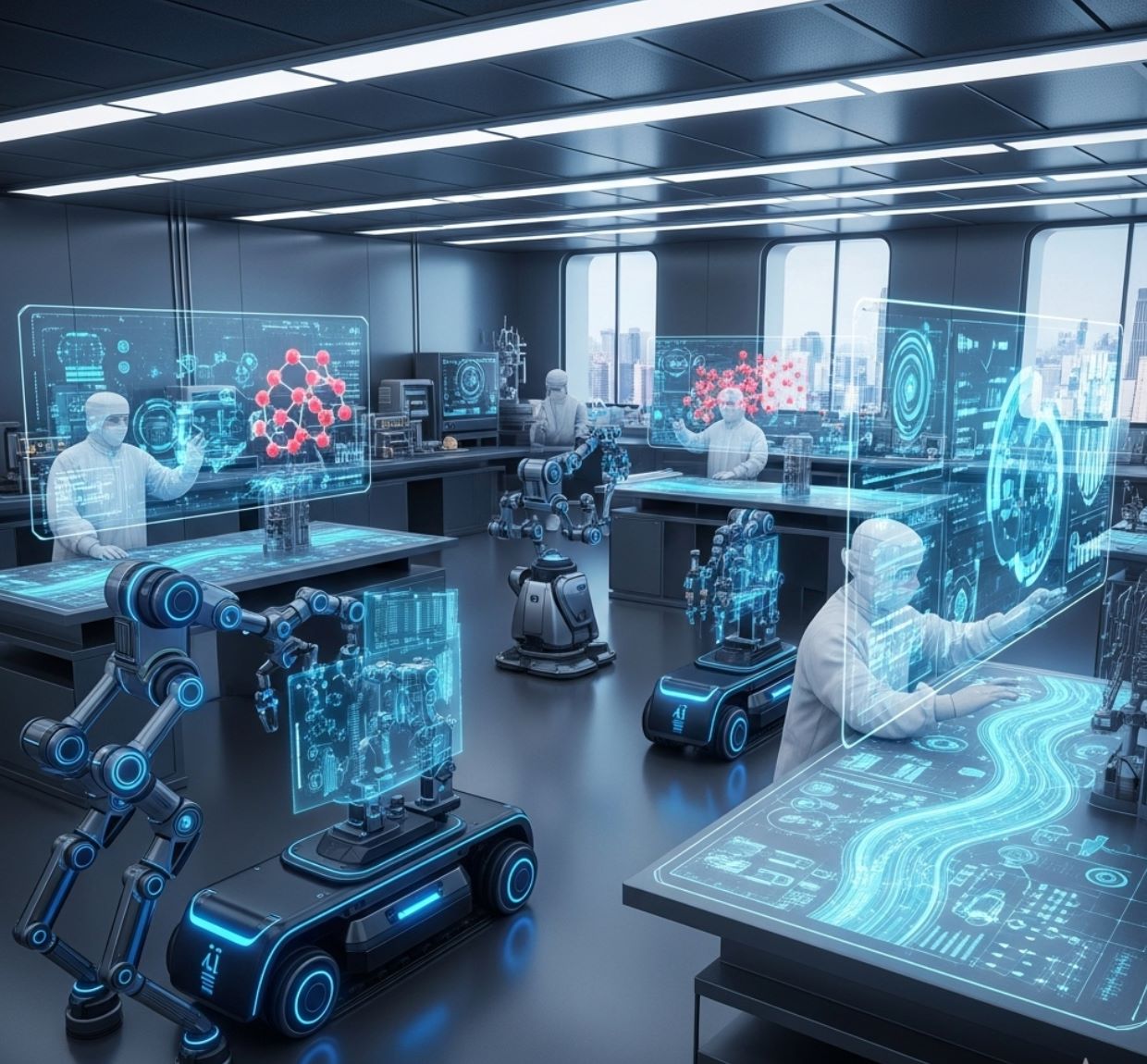

Ang mga modernong laboratoryo ng pananaliksik ay gumagamit ng artificial intelligence (AI) upang iproseso ang mga resulta ng eksperimento nang hindi pa nagagawa sa ganitong bilis. Sa pamamagitan ng pagsasama ng AI sa mga automated na instrumento at supercomputer, maaaring suriin ng mga siyentipiko ang malalaking dataset sa real time, agad na matukoy ang mga pattern, at mahulaan ang mga resulta nang hindi na kailangang isagawa ang mabagal na tradisyunal na eksperimento. Ang kakayahang ito ay nagrerebolusyon sa mga larangan mula sa agham ng materyales hanggang sa biyolohiya.

Sa ibaba ay tatalakayin natin ang mga pangunahing paraan kung paano pinapabilis ng AI ang pagsusuri ng datos sa laboratoryo:

Apat na Rebolusyonaryong Aplikasyon ng AI sa Pagsusuri sa Laboratoryo

Automated na "Self-Driving" na mga Laboratoryo

Ang mga robot na pinapatnubayan ng AI ay patuloy na nagsasagawa ng mga eksperimento at pumipili kung aling mga sample ang susuriin, na nagpapabawas ng oras na walang ginagawa at mga dobleng pagsukat.

Real-Time na Pagproseso ng Datos

Ang mga datos na dumadaloy mula sa mga instrumento ay ipinapasok sa mga AI-driven na sistema ng kompyuter para sa agarang pagsusuri. Maaaring baguhin ng mga mananaliksik ang mga eksperimento habang isinasagawa dahil ang mga resulta ay bumabalik sa loob ng ilang minuto sa halip na araw.

Mga Predictive Machine Learning Models

Kapag na-train na, maaaring i-simulate ng mga AI model ang mga eksperimento sa kompyuter. Halimbawa, kaya nilang gumawa ng libu-libong istruktura ng molekula o mga profile ng gene-expression sa loob ng ilang minuto, na katumbas ng linggo o buwan na pag-aaral sa laboratoryo.

End-to-End na Awtomasyon ng Pananaliksik

Ang malawak na AI platform (tulad ng FutureHouse ng MIT) ay binubuo upang hawakan ang buong daloy ng trabaho—mula sa pagsusuri ng literatura at pangangalap ng datos hanggang sa disenyo at pagsusuri ng eksperimento—na ina-automate ang maraming mahahalagang hakbang sa pananaliksik.

AI-Driven na Awtomasyon sa mga Laboratoryo

Gumagawa ang mga mananaliksik ng autonomous labs na nagsasagawa ng mga eksperimento na may kaunting interbensyon ng tao. Halimbawa, pinagsasama ng A-Lab ng Lawrence Berkeley Lab ang mga AI algorithm sa mga robotic arm: ang AI ang nagmumungkahi ng mga bagong materyales na susubukan, at ang mga robot ang naghahalo at sumusubok ng mga ito nang mabilis. Ang ganitong mahigpit na ugnayan ng "robot scientists" ay nangangahulugan na mas mabilis na na-validate ang mga promising na compound kaysa sa manu-manong pag-aaral.

Gayundin, ang proyekto ng FutureHouse ng MIT ay nagde-develop ng mga AI agent upang hawakan ang mga gawain tulad ng paghahanap ng literatura, pagpaplano ng eksperimento, at pagsusuri ng datos, upang makapagtuon ang mga siyentipiko sa pagtuklas sa halip na sa mga rutinang gawain.

Self-Driving Microscope

Intelligent Scanning

Isang kapansin-pansing halimbawa ay ang self-driving microscope ng Argonne National Laboratory. Sa sistemang ito, nagsisimula ang AI algorithm sa pag-scan ng ilang random na punto sa sample, pagkatapos ay hinuhulaan kung saan maaaring makita ang susunod na kawili-wiling tampok.

Ang on-the-fly na kontrol ng AI ay nag-aalis ng pangangailangan para sa interbensyon ng tao at lubos na nagpapabilis ng eksperimento.

— Mga Siyentipiko ng Argonne National Laboratory

Sa pamamagitan ng pagtutok lamang sa mga rehiyong mayaman sa datos at pag-iwas sa mga uniform na lugar, nakakolekta ang mikroskopyo ng mga kapaki-pakinabang na larawan nang mas mabilis kaysa sa tradisyunal na point-by-point scan. Sa praktika, nangangahulugan ito ng mas epektibong paggamit ng oras sa mga instrumento na mataas ang demand: maaaring magsagawa ang mga mananaliksik ng maraming high-resolution scan sa parehong oras na gagamitin ng manu-manong pamamaraan para sa isa lamang.

Real-Time na Pagproseso ng Datos sa mga Pasilidad ng Pananaliksik

Gumagamit ang malalaking pasilidad ng pananaliksik ng AI upang suriin ang datos habang ito ay nililikha. Sa Berkeley Lab, ang raw data mula sa mga mikroskopyo at teleskopyo ay direktang ipinapadala sa isang supercomputer.

Distiller Platform

Pinoproseso ng mga machine-learning workflow ang datos sa loob ng ilang minuto. Ang bagong platform na tinatawag na Distiller ay nagpapadala ng mga electron-microscope na larawan sa NERSC supercomputer habang nag-iimaging; ang mga resulta ay bumabalik agad, na nagpapahintulot sa mga siyentipiko na i-refine ang eksperimento sa mismong lugar.

Nakikinabang din ang mga kumplikadong instrumento: sa BELLA laser accelerator, patuloy na tina-tune ng mga deep-learning model ang laser at electron beams para sa pinakamainam na katatagan, na nagpapabawas ng oras na ginugugol ng mga siyentipiko sa manu-manong kalibrasyon.

24/7 Monitoring

Gumagamit ang ibang pambansang laboratoryo ng AI para sa live quality control. Ginagamit ngayon ng NSLS-II synchrotron ng Brookhaven ang mga AI agent upang bantayan ang mga beamline experiment 24/7.

Kung may paggalaw ang sample o mukhang "hindi tama" ang datos, agad itong tinutukoy ng sistema. Ang ganitong uri ng anomaly detection ay nakakatipid ng napakalaking oras—maaaring ayusin ng mga siyentipiko ang mga problema sa real time sa halip na matuklasan ito pagkatapos ng maraming oras na nawalang beamtime.

Particle Physics

Gumagamit ang Large Hadron Collider ng CERN ng "fast ML" algorithm na naka-embed sa trigger hardware nito: ang custom AI sa FPGAs ay agad na nagsusuri ng mga signal ng banggaan, kinukwenta ang enerhiya ng mga particle sa real time, at mas mahusay kaysa sa mga lumang signal filter.

Kolektahin Lahat Bago Suriin

- Oras o araw ng pagkolekta ng datos

- Manu-manong pagsusuri pagkatapos ng eksperimento

- Mga problema na natuklasan nang huli na

- Limitadong real-time na pagbabago

Suriin Agad

- Instant na pagproseso ng datos

- Real-time na pag-aayos ng eksperimento

- Agad na pagtukoy ng problema

- Patuloy na pag-optimize

Mga Predictive Model para sa Mabilis na Insight

Hindi lang pinapabilis ng AI ang mga umiiral na eksperimento – pinapalitan din nito ang mabagal na trabaho sa laboratoryo ng virtual experiments. Sa genomics, halimbawa, nakabuo ang mga kemiko ng MIT ng ChromoGen, isang generative AI na natututo ng gramatika ng pag-fold ng DNA.

ChromoGen AI

Prediksyon ng Gene Expression

Kapag binigyan ng DNA sequence, maaaring "mabilis na suriin" ng ChromoGen ang sequence at makabuo ng libu-libong posibleng 3D chromatin structure sa loob ng ilang minuto. Ito ay mas mabilis nang malaki kaysa sa tradisyunal na mga pamamaraan sa laboratoryo: habang maaaring tumagal ng araw o linggo ang Hi-C experiment upang i-map ang genome para sa isang uri ng cell, nakagawa ang ChromoGen ng 1,000 predicted structures sa loob lamang ng 20 minuto gamit ang isang GPU.

Sa biyolohiya, nag-train ang mga grupo sa Columbia University ng isang "foundation model" gamit ang datos mula sa mahigit isang milyong cells upang mahulaan ang gene activity. Kayang hulaan ng kanilang AI kung aling mga gene ang naka-on sa anumang uri ng cell, na parang nagsasagawa ng malawakang gene-expression experiment. Ayon sa mga mananaliksik, pinapayagan ng mga predictive model na ito ang "mabilis at tumpak" na malawakang computational experiments na gumagabay at sumusuporta sa wet-lab na trabaho.

Sa mga pagsubok, ang mga prediksyon ng AI para sa gene expression ng mga bagong uri ng cell ay malapit na tumugma sa aktwal na mga sukat ng eksperimento.

Epekto at Hinaharap na Pananaw

Binabago ng pagsasama ng AI sa daloy ng eksperimento ang agham. Sa pamamagitan ng pag-automate ng pagsusuri ng datos at maging ng paggawa ng desisyon habang isinasagawa ang mga eksperimento, nagiging turbocharged na proseso ang dating bottleneck.

Magpokus sa pagtuklas habang ang mga makina ang humahawak sa paulit-ulit na gawain at real-time na pagsusuri ng napakalaking datos.

— Mga Siyentipiko sa Pananaliksik

Sa madaling salita, mas maraming eksperimento ang maaaring isagawa ng mga siyentipiko at mas mabilis silang makakagawa ng mga konklusyon kaysa dati.

Ang pag-automate ng mga eksperimento gamit ang AI ay magpapabilis nang malaki sa pag-unlad ng agham.

— Mga Pisiko ng Argonne National Laboratory

Kasalukuyang Kalagayan

Mga AI-driven na kagamitan sa piling mga laboratoryo

Malapit na Hinaharap

Mas maraming self-driving na instrumento

Pangmatagalang Panahon

Malawakang paggamit ng AI sa pagsusuri

Sa hinaharap, inaasahan nating lalaki ang papel ng AI: mas maraming laboratoryo ang gagamit ng self-driving na mga instrumento, at mas maraming larangan ang aasa sa mabilis na pagsusuri at prediksyon gamit ang AI.

Ibig sabihin, ang siklo ng hypothesis, eksperimento, at resulta ay babawasan—mula taon patungo sa buwan o kahit araw.

No comments yet. Be the first to comment!