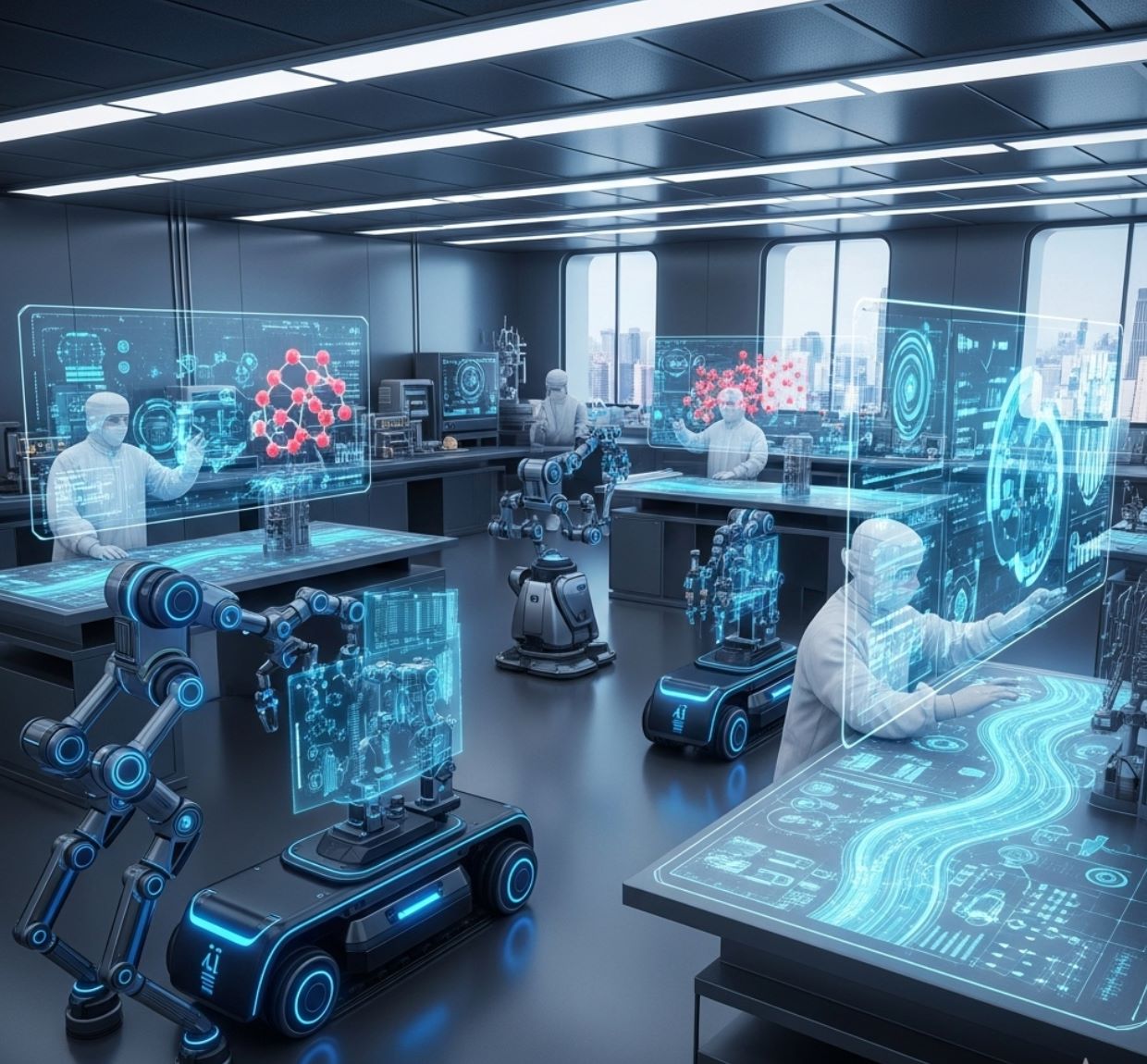

Les laboratoires de recherche modernes utilisent l’intelligence artificielle (IA) pour traiter les résultats expérimentaux à une vitesse sans précédent. En intégrant l’IA aux instruments automatisés et aux supercalculateurs, les scientifiques peuvent analyser d’immenses ensembles de données en temps réel, identifier instantanément des motifs et même prédire les résultats sans recourir aux expériences traditionnelles longues. Cette capacité révolutionne déjà des domaines allant de la science des matériaux à la biologie.

Voici les principales façons dont l’IA accélère considérablement l’analyse des données de laboratoire :

- Laboratoires automatisés « autonomes » : Des robots guidés par l’IA réalisent des expériences en continu et choisissent les échantillons à tester, réduisant ainsi les temps d’inactivité et les mesures redondantes.

- Traitement des données en temps réel : Les données diffusées par les instruments sont envoyées à des systèmes informatiques pilotés par l’IA pour une analyse instantanée. Les chercheurs peuvent ajuster les expériences immédiatement, car les résultats sont disponibles en quelques minutes au lieu de plusieurs jours.

- Modèles prédictifs d’apprentissage automatique : Une fois entraînés, les modèles d’IA peuvent simuler des expériences par calcul. Par exemple, ils peuvent générer en quelques minutes des milliers de structures moléculaires ou de profils d’expression génique, ce qui prendrait des semaines ou des mois avec les techniques de laboratoire classiques.

- Automatisation complète des recherches : Des plateformes d’IA étendues (comme FutureHouse du MIT) sont développées pour gérer l’ensemble des flux de travail — de la revue bibliographique et la collecte de données à la conception et l’analyse expérimentales — automatisant ainsi de nombreuses étapes clés de la recherche.

Ces avancées permettent aux scientifiques de se concentrer sur l’interprétation plutôt que sur le traitement routinier des données, accélérant ainsi considérablement le rythme des découvertes.

Automatisation pilotée par l’IA dans les laboratoires

Les chercheurs développent des laboratoires autonomes qui réalisent des expériences avec une intervention humaine minimale.

Par exemple, l’installation A-Lab du Lawrence Berkeley Lab associe des algorithmes d’IA à des bras robotiques : l’IA suggère de nouveaux matériaux à tester, et les robots les mélangent et les analysent en succession rapide. Cette boucle étroite de « scientifiques robots » permet de valider les composés prometteurs bien plus rapidement que dans les études manuelles.

De même, le projet FutureHouse du MIT développe des agents d’IA pour gérer des tâches telles que la recherche bibliographique, la planification des expériences et l’analyse des données, afin que les scientifiques puissent se consacrer aux découvertes plutôt qu’aux tâches répétitives.

Un exemple particulièrement marquant est le microscope autonome du Laboratoire national d’Argonne. Dans ce système, un algorithme d’IA commence par scanner quelques points aléatoires sur un échantillon, puis prédit où se trouvent les prochaines caractéristiques intéressantes.

En se concentrant uniquement sur les zones riches en données et en évitant les zones uniformes, le microscope collecte des images utiles bien plus rapidement qu’un balayage traditionnel point par point. Comme l’expliquent les scientifiques d’Argonne, le contrôle IA « en temps réel » « élimine le besoin d’intervention humaine et accélère considérablement l’expérience ».

En pratique, cela signifie une utilisation beaucoup plus efficace du temps sur des instruments très sollicités : les chercheurs peuvent réaliser plusieurs scans haute résolution dans le même laps de temps qu’une seule méthode manuelle.

Traitement des données en temps réel dans les centres de recherche

Les grands centres de recherche utilisent l’IA pour analyser les données au fur et à mesure de leur production. Au Berkeley Lab, les données brutes provenant des microscopes et télescopes sont transmises directement à un superordinateur.

Les flux de travail d’apprentissage automatique traitent ensuite ces données en quelques minutes. Par exemple, une nouvelle plateforme appelée Distiller envoie les images du microscope électronique au superordinateur NERSC pendant l’imagerie ; les résultats reviennent instantanément, permettant aux scientifiques d’affiner l’expérience sur place.

Même les instruments complexes en bénéficient : à l’accélérateur laser BELLA, des modèles d’apprentissage profond ajustent en continu les faisceaux laser et électroniques pour une stabilité optimale, réduisant considérablement le temps consacré aux calibrations manuelles.

D’autres laboratoires nationaux utilisent l’IA pour le contrôle qualité en temps réel. Le synchrotron NSLS-II de Brookhaven emploie désormais des agents d’IA pour surveiller les expériences sur les lignes de faisceau 24h/24 et 7j/7.

Si un échantillon bouge ou si les données semblent « anormales », le système le signale immédiatement. Ce type de détection d’anomalies fait gagner énormément de temps — les scientifiques peuvent corriger les problèmes en temps réel au lieu de les découvrir après des heures de perte de faisceau.

De même, le Grand collisionneur de hadrons du CERN utilise des algorithmes « fast ML » intégrés dans son matériel de déclenchement : une IA personnalisée dans des FPGA analyse instantanément les signaux de collision, calculant les énergies des particules en temps réel et surpassant les filtres de signaux plus anciens.

Dans tous ces exemples, l’IA fait passer le flux de travail de « collecter tout puis analyser plus tard » à « analyser en temps réel », rendant le traitement des données quasiment instantané.

Modèles prédictifs pour des analyses rapides

L’IA ne se contente pas d’accélérer les expériences existantes – elle remplace aussi les travaux de laboratoire lents par des expériences virtuelles. En génomique, par exemple, des chimistes du MIT ont développé ChromoGen, une IA générative qui apprend la grammaire du repliement de l’ADN.

À partir d’une séquence d’ADN, ChromoGen peut « analyser rapidement » la séquence et générer en quelques minutes des milliers de structures 3D possibles de la chromatine. C’est bien plus rapide que les méthodes traditionnelles : alors qu’une expérience Hi-C peut prendre des jours ou des semaines pour cartographier le génome d’un type cellulaire, ChromoGen a produit 1 000 structures prédites en seulement 20 minutes sur un seul GPU.

Il est important de noter que les prédictions de l’IA correspondaient étroitement aux données expérimentales, validant ainsi l’approche.

En biologie, des équipes de l’Université Columbia ont entraîné un « modèle fondamental » sur des données de plus d’un million de cellules pour prévoir l’activité génique.

Leur IA peut prédire quels gènes sont activés dans chaque type cellulaire, simulant en quelque sorte ce qu’une vaste expérience d’expression génique montrerait. Comme le soulignent les chercheurs, ces modèles prédictifs permettent des expériences computationnelles à grande échelle « rapides et précises » qui guident et complètent le travail en laboratoire.

Lors des tests, les prédictions d’expression génique de l’IA pour de nouveaux types cellulaires concordaient très bien avec les mesures expérimentales réelles.

En résumé, l’apprentissage automatique permet désormais aux scientifiques de réaliser des essais virtuels à grande échelle : tester des milliers de scénarios génomiques ou moléculaires en un temps équivalent à celui d’une seule expérience en laboratoire.

Impact et perspectives d’avenir

L’intégration de l’IA dans le processus expérimental transforme la science. En automatisant l’analyse des données et même la prise de décision pendant les expériences, l’IA transforme un goulot d’étranglement en un processus accéléré.

Les chercheurs rapportent qu’avec les outils pilotés par l’IA, ils peuvent « se concentrer sur la découverte pendant que les machines gèrent les tâches répétitives et l’analyse en temps réel de vastes ensembles de données ».

Autrement dit, les scientifiques peuvent réaliser plus d’expériences et tirer des conclusions plus rapidement que jamais. Comme le concluent les physiciens d’Argonne, la capacité à « automatiser les expériences avec l’IA accélérera significativement le progrès scientifique ».

À l’avenir, on peut s’attendre à ce que le rôle de l’IA se développe : davantage de laboratoires utiliseront des instruments autonomes, et plus de domaines s’appuieront sur l’analyse et la prédiction rapides par IA.

Cela signifie que le cycle hypothèse, expérience et résultat se réduira — passant d’années à quelques mois, voire quelques jours.

Le résultat est une nouvelle ère de science pilotée par les données, où les avancées dans les matériaux, l’énergie, la santé et au-delà peuvent émerger à un rythme sans précédent, grâce à la capacité de l’IA à interpréter rapidement les données expérimentales.