Edge AI (a veces llamado “IA en el borde”) significa ejecutar modelos de inteligencia artificial y aprendizaje automático en dispositivos locales (sensores, cámaras, teléfonos inteligentes, gateways industriales, etc.) en lugar de en centros de datos remotos. En otras palabras, el “borde” de la red – donde se generan los datos – se encarga del procesamiento. Esto permite que los dispositivos analicen los datos inmediatamente al ser recogidos, en lugar de enviar constantemente datos sin procesar a la nube.

Como explica IBM, Edge AI permite el procesamiento en tiempo real y en el dispositivo sin depender de un servidor central. Por ejemplo, una cámara con Edge AI puede detectar y clasificar objetos al instante, proporcionando retroalimentación inmediata. Al procesar los datos localmente, Edge AI puede funcionar incluso con conexión a internet intermitente o sin ella.

Según informes de la industria, este cambio está ocurriendo rápidamente: el gasto global en computación en el borde alcanzó aproximadamente 232 mil millones de dólares en 2024 (un aumento del 15% respecto a 2023), impulsado en gran parte por el crecimiento del IoT potenciado por IA.

En resumen, Edge AI simplemente acerca el cómputo a la fuente de datos – desplegando inteligencia en dispositivos o nodos cercanos, lo que acelera las respuestas y reduce la necesidad de transmitir todo a la nube.

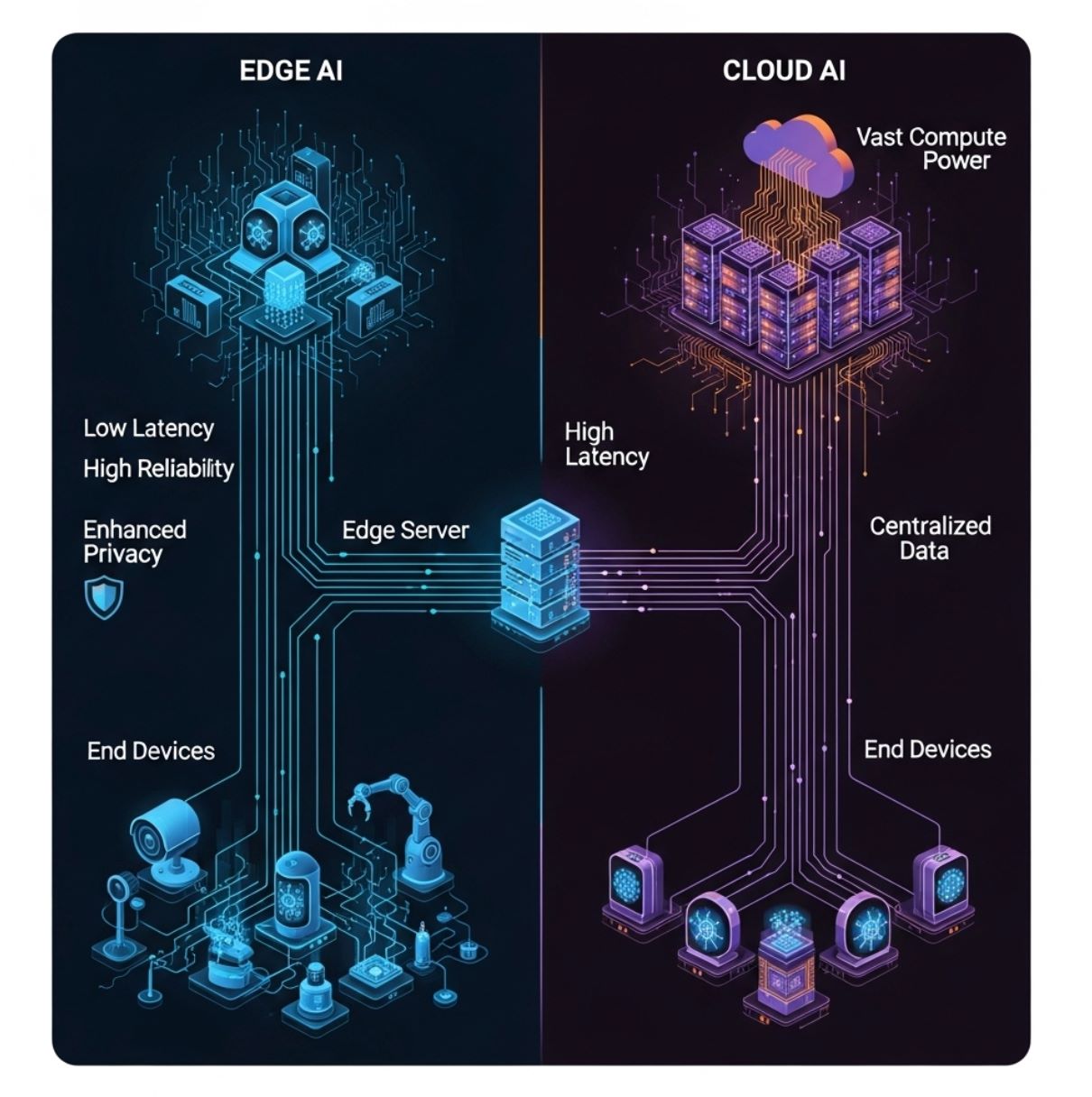

Edge AI vs IA en la Nube: Diferencias Clave

A diferencia de la IA tradicional basada en la nube (que envía todos los datos a servidores centralizados), Edge AI distribuye el procesamiento entre hardware local. El diagrama anterior ilustra un modelo simple de computación en el borde: los dispositivos finales (capa inferior) envían datos a un servidor o gateway en el borde (capa media) en lugar de solo a la nube distante (capa superior).

En esta configuración, la inferencia de IA puede ocurrir en el dispositivo o en el nodo local del borde, reduciendo significativamente los retrasos en la comunicación.

- Latencia: Edge AI minimiza el retardo. Debido a que el procesamiento es local, las decisiones pueden ocurrir en milisegundos. IBM señala que la inferencia basada en el borde “proporciona una latencia reducida al procesar los datos directamente en el dispositivo,” mientras que la IA en la nube incurre en retrasos adicionales al enviar datos hacia y desde servidores remotos.

Esto es crítico para tareas sensibles al tiempo (por ejemplo, evitar un accidente automovilístico o controlar un robot). - Ancho de banda: Edge AI reduce la carga de la red. Al analizar o filtrar datos en el sitio, se envía mucha menos información hacia arriba. IBM explica que los sistemas en el borde “requieren menor ancho de banda” ya que la mayoría de los datos permanecen locales.

En contraste, la IA en la nube necesita conexiones continuas de alta velocidad para mover datos sin procesar de ida y vuelta. Esto hace que Edge AI sea más eficiente y económico cuando las redes están saturadas o son costosas. - Privacidad/Seguridad: Edge AI puede mejorar la privacidad. Los datos sensibles (voz, imágenes, lecturas de salud) pueden procesarse y almacenarse en el dispositivo, sin transmitirse a la nube. Esto reduce la exposición a brechas de terceros.

Por ejemplo, un teléfono inteligente puede reconocer tu rostro localmente sin subir tu foto. En comparación, la IA en la nube a menudo implica enviar datos personales a servidores externos, lo que puede aumentar riesgos de seguridad. - Recursos de cómputo: Los centros de datos en la nube tienen potencia de CPU/GPU prácticamente ilimitada, permitiendo modelos de IA muy grandes. Los dispositivos en el borde tienen mucho menos procesamiento y almacenamiento. Como señala IBM, las unidades en el borde están “limitadas por las restricciones de tamaño del dispositivo”.

Por ello, Edge AI suele usar modelos optimizados o más pequeños. En la práctica, el entrenamiento de modelos pesados generalmente ocurre en la nube, y solo modelos compactos y cuantificados se despliegan en dispositivos del borde. - Confiabilidad: Al reducir la dependencia de la conectividad continua, Edge AI puede mantener funciones críticas incluso si la red falla. Por ejemplo, un dron puede navegar usando IA a bordo cuando pierde señal con la base.

En resumen, la IA en el borde y en la nube se complementan. Los servidores en la nube manejan entrenamiento pesado, archivado y análisis a gran escala, mientras que Edge AI se encarga de la inferencia en tiempo real y decisiones rápidas cerca de los datos.

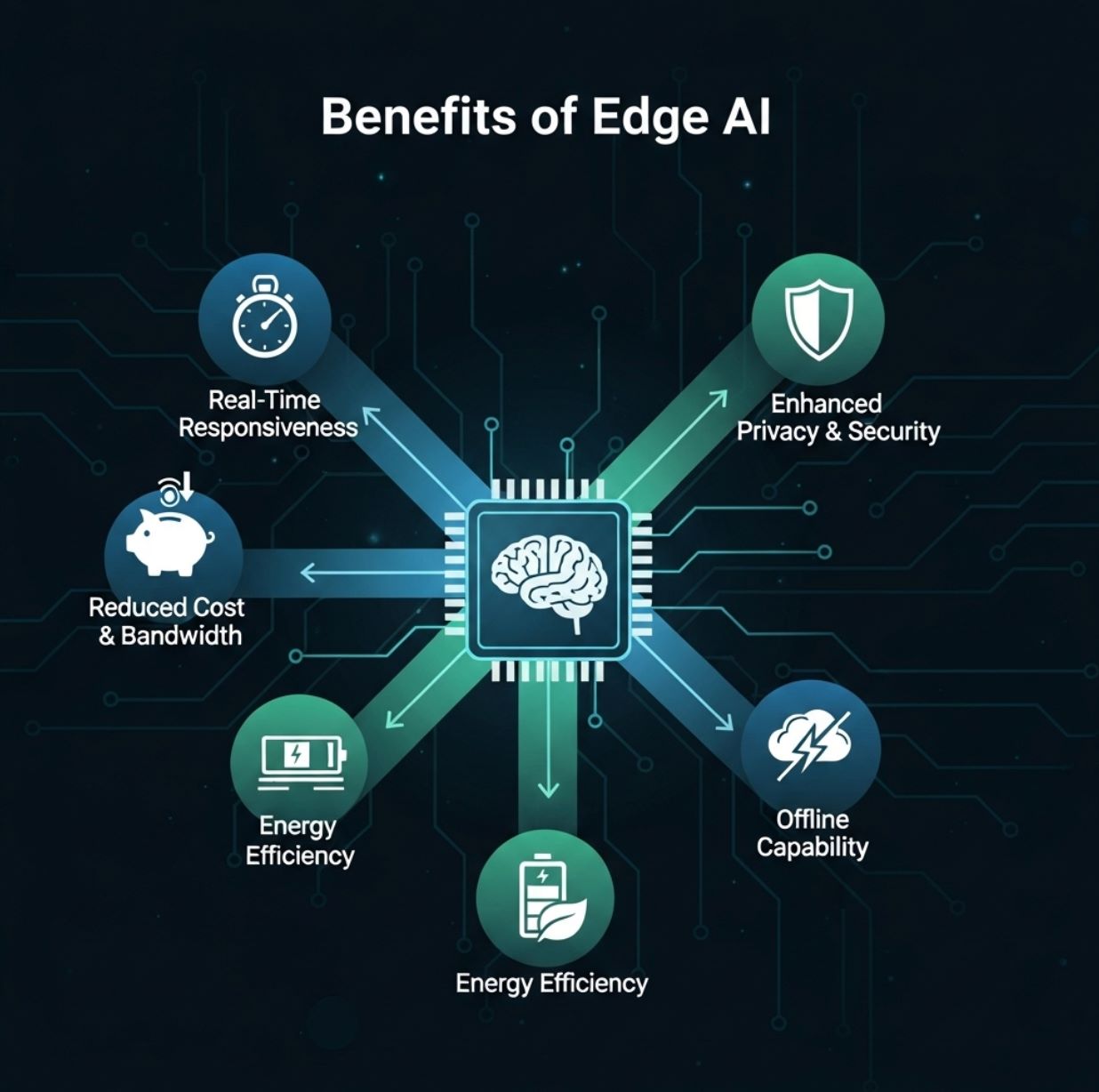

Beneficios de Edge AI

Edge AI ofrece varias ventajas prácticas para usuarios y organizaciones:

- Respuesta en tiempo real: Procesar datos localmente permite análisis inmediatos. Los usuarios reciben retroalimentación instantánea (por ejemplo, detección en vivo de objetos, respuesta por voz, alerta de anomalías) sin esperar un viaje de ida y vuelta a la nube.

Esta baja latencia es una gran ventaja para aplicaciones como realidad aumentada, vehículos autónomos y robótica. - Reducción de ancho de banda y costos: Con Edge AI, solo se envían resultados resumidos o eventos inusuales por internet. Esto reduce drásticamente los costos de transferencia de datos y almacenamiento en la nube.

Por ejemplo, una cámara de seguridad podría subir solo clips cuando detecta una amenaza potencial, en lugar de transmitir continuamente. - Privacidad mejorada: Mantener los datos en el dispositivo mejora la seguridad. La información personal o sensible nunca sale del hardware local si se procesa en el borde.

Esto es especialmente importante para aplicaciones bajo estrictas normas de privacidad (salud, finanzas, etc.), ya que Edge AI puede mantener los datos dentro de un país o instalación. - Eficiencia energética y de costos: La IA en el dispositivo puede ahorrar energía. Ejecutar un modelo pequeño en un chip de bajo consumo suele usar menos energía que enviar datos a un servidor en la nube y recibir respuesta.

También reduce costos de servidores, ya que las cargas pesadas de IA son caras de alojar en la nube. - Capacidad offline y resiliencia: Edge AI puede seguir funcionando si falla la conectividad. Los dispositivos pueden operar con inteligencia local y sincronizar después.

Esto hace que los sistemas sean más robustos, especialmente en zonas remotas o usos críticos (por ejemplo, monitoreo industrial).

Red Hat e IBM destacan estos beneficios. Edge AI “lleva capacidades de computación de alto rendimiento al borde,” permitiendo análisis en tiempo real y mayor eficiencia.

Como resume un informe, las implementaciones en el borde reducen latencia y necesidades de ancho de banda mientras aumentan privacidad y confiabilidad.

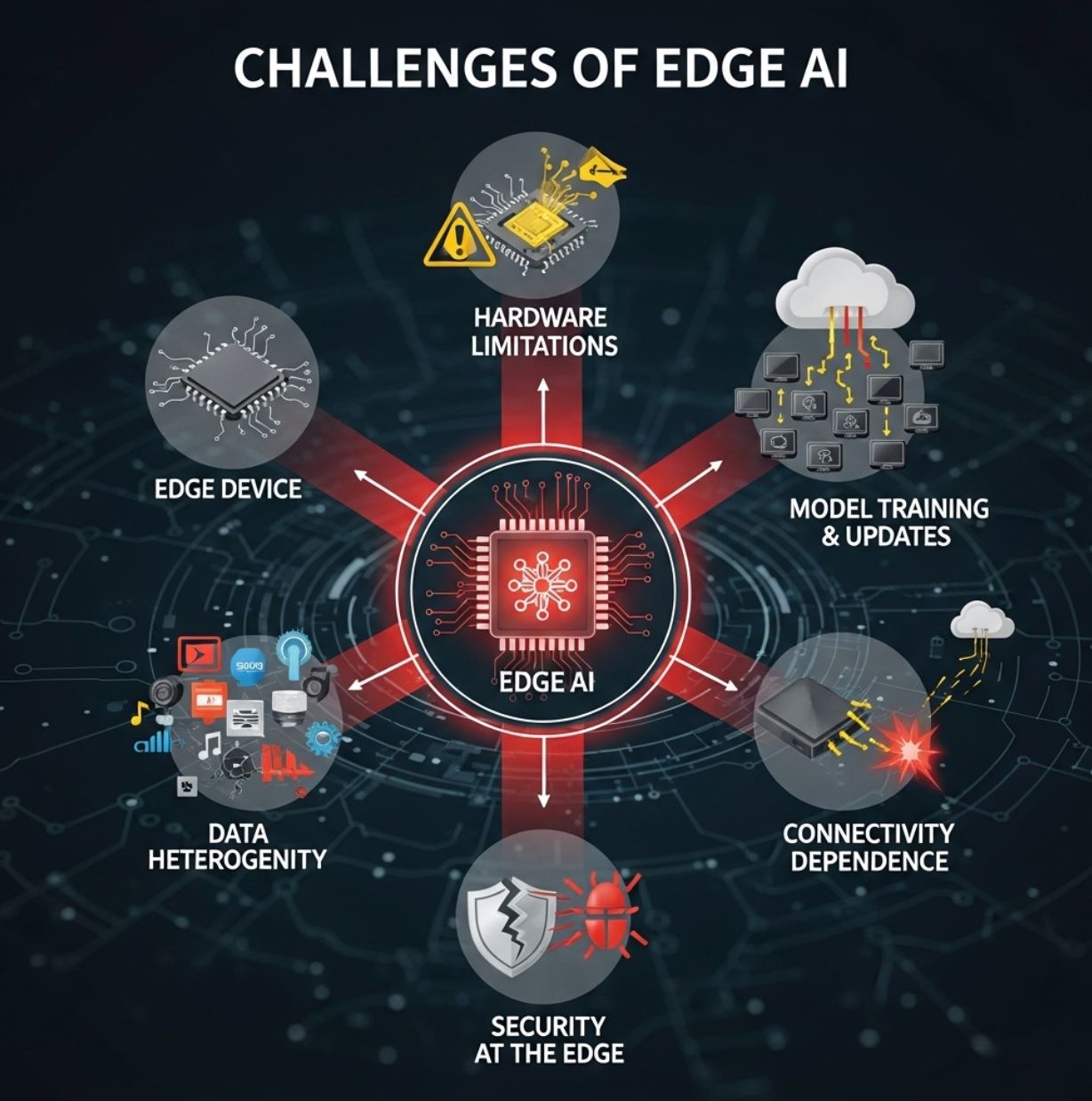

Desafíos de Edge AI

A pesar de sus ventajas, Edge AI también enfrenta obstáculos:

- Limitaciones de hardware: Los dispositivos en el borde suelen ser pequeños y con recursos limitados. Pueden tener CPUs modestos o NPUs especializadas de bajo consumo, y memoria limitada.

Esto obliga a los ingenieros de IA a usar técnicas de compresión, poda o TinyML para adaptar los modelos al dispositivo. Los modelos complejos de aprendizaje profundo a menudo no pueden ejecutarse a escala completa en un microcontrolador, por lo que se sacrifica algo de precisión. - Entrenamiento y actualizaciones de modelos: El entrenamiento de modelos sofisticados generalmente sigue ocurriendo en la nube, donde hay datos masivos y potencia de cómputo disponible. Tras el entrenamiento, esos modelos deben optimizarse (cuantificación, poda, etc.) y desplegarse en cada dispositivo del borde.

Mantener miles o millones de dispositivos actualizados puede ser complejo. La sincronización de firmware y datos añade carga de gestión. - Gravedad y heterogeneidad de datos: Los entornos de borde son diversos. Diferentes ubicaciones pueden recopilar distintos tipos de datos (los sensores varían según la aplicación), y las políticas pueden variar por región.

Integrar y estandarizar todos esos datos es un desafío. Como señala IBM, desplegar Edge AI ampliamente plantea problemas de “gravedad de datos, heterogeneidad, escala y limitaciones de recursos”. En otras palabras, los datos tienden a quedarse locales, dificultando una visión global, y los dispositivos son muy variados. - Seguridad en el borde: Aunque Edge AI puede mejorar la privacidad, también introduce nuevas preocupaciones de seguridad. Cada dispositivo o nodo es un posible objetivo para hackers.

Asegurar que los modelos locales sean a prueba de manipulaciones y que el firmware sea seguro requiere fuertes medidas de protección. - Dependencia de la conectividad para algunas tareas: Aunque la inferencia puede ser local, los sistemas en el borde a menudo dependen de la conexión a la nube para tareas pesadas como reentrenar modelos, análisis de datos a gran escala o agregación de resultados distribuidos.

La conectividad limitada puede ser un cuello de botella para estas funciones administrativas.

En la práctica, la mayoría de las soluciones usan un modelo híbrido: los dispositivos en el borde manejan la inferencia, mientras que la nube se encarga del entrenamiento, gestión de modelos y análisis de big data.

Este equilibrio ayuda a superar las limitaciones de recursos y permite escalar Edge AI.

Casos de Uso de Edge AI

Edge AI se está aplicando en muchas industrias. Ejemplos reales incluyen:

- Vehículos autónomos: Los coches autónomos usan Edge AI a bordo para procesar instantáneamente datos de cámaras y radares para navegación y evitación de obstáculos.

No pueden permitirse el retraso de enviar video a un servidor, por lo que todo (detección de objetos, reconocimiento de peatones, seguimiento de carriles) ocurre localmente. - Manufactura e Industria 4.0: Las fábricas despliegan cámaras inteligentes y sensores en líneas de producción para detectar defectos o anomalías en tiempo real.

Por ejemplo, una cámara con Edge AI puede identificar un producto defectuoso en la cinta transportadora y activar una acción inmediata. De igual forma, las máquinas industriales usan IA local para predecir fallos (mantenimiento predictivo) antes de que ocurran averías. - Salud y respuesta a emergencias: Dispositivos médicos portátiles y ambulancias ahora usan Edge AI para analizar datos del paciente en el momento.

Un ecógrafo o monitor de signos vitales a bordo de una ambulancia puede aplicar IA instantáneamente para detectar lesiones internas o alertar a paramédicos sobre signos anormales. En hospitales, Edge AI puede monitorear continuamente pacientes en UCI y activar alarmas sin esperar un servidor central. - Ciudades inteligentes: Los sistemas urbanos usan Edge AI para gestión del tráfico, vigilancia y monitoreo ambiental.

Los semáforos inteligentes ajustan sus tiempos usando IA local que analiza imágenes de cámaras, aliviando la congestión en tiempo real. Las cámaras callejeras pueden detectar incidentes (accidentes, incendios) y alertar a las autoridades de inmediato. Al mantener el procesamiento local, las ciudades pueden reaccionar rápido sin saturar las redes centrales. - Retail e IoT para consumidores: Edge AI mejora la experiencia y conveniencia del cliente.

En tiendas, cámaras inteligentes o sensores en estantes usan IA para rastrear el comportamiento de compradores y niveles de inventario al instante. En casa, teléfonos, tabletas y altavoces inteligentes ejecutan reconocimiento de voz o facial en el dispositivo. Por ejemplo, un smartphone puede desbloquearse o identificar gestos sin acceso a la nube. Los rastreadores de actividad analizan datos de salud (ritmo cardíaco, pasos) localmente para dar retroalimentación en tiempo real.

Otros usos emergentes incluyen agricultura de precisión (drones y sensores que usan Edge AI para monitorear suelo y cultivos) y sistemas de seguridad (reconocimiento facial en el dispositivo para cerraduras). Como señala un estudio de IEEE, Edge AI es crucial para aplicaciones como agricultura inteligente, control de tráfico y automatización industrial.

En resumen, cualquier escenario que se beneficie de análisis instantáneo y local es un candidato ideal para Edge AI.

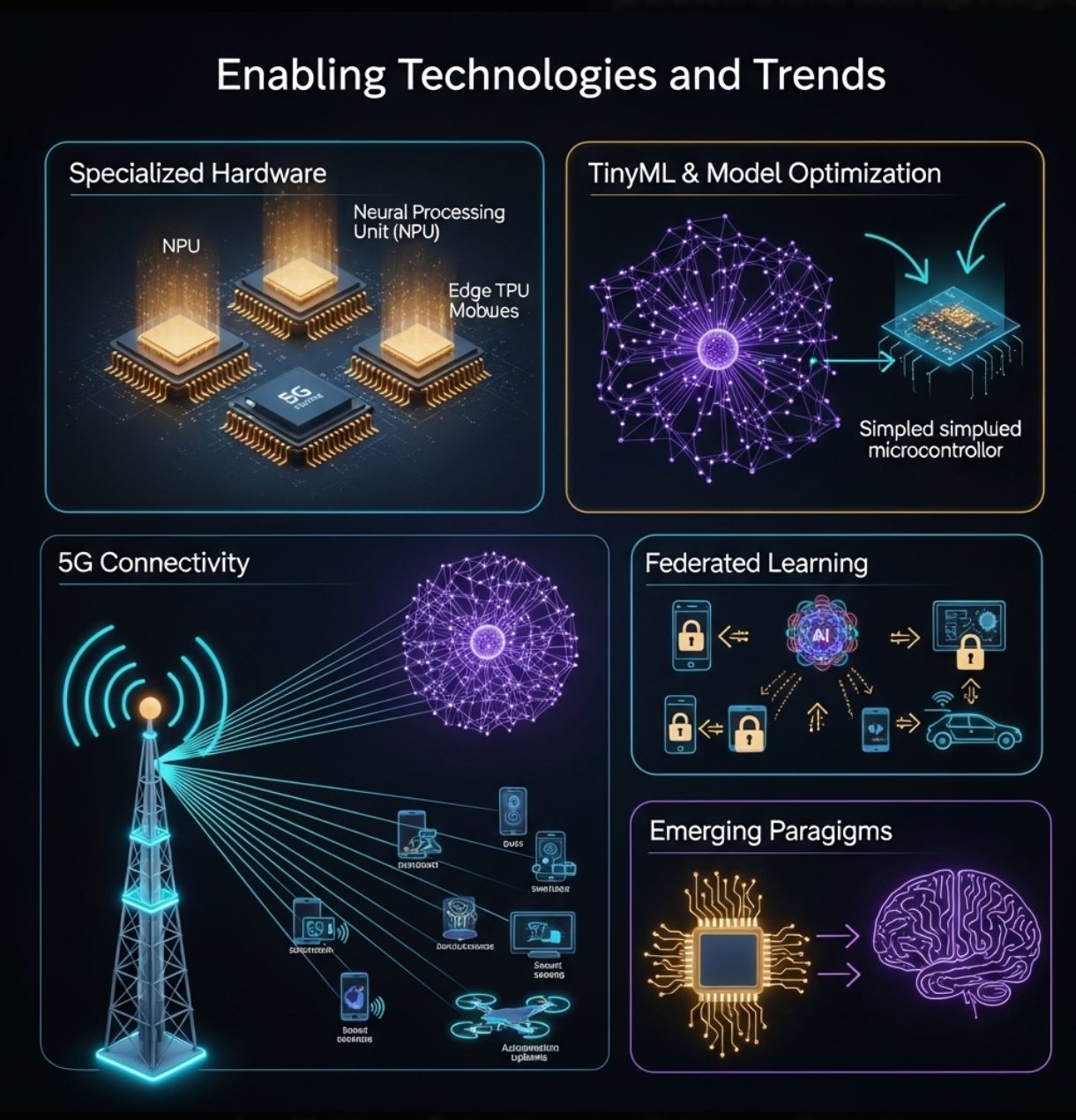

Tecnologías y Tendencias Facilitadoras

El crecimiento de Edge AI está impulsado por avances tanto en hardware como en software:

- Hardware especializado: Los fabricantes están desarrollando chips diseñados para inferencia en el borde. Estos incluyen aceleradores neuronales de bajo consumo en smartphones (NPUs) y módulos dedicados de Edge AI como Google Coral Edge TPU, NVIDIA Jetson Nano y placas microcontroladoras económicas (Arduino, Raspberry Pi con complementos de IA).

Un informe reciente de la industria destaca que los avances en procesadores ultra-bajo consumo y algoritmos “nativos del borde” están superando las limitaciones del hardware de los dispositivos. - TinyML y optimización de modelos: Herramientas como TensorFlow Lite y técnicas como poda, cuantización y destilación permiten reducir redes neuronales para que quepan en dispositivos diminutos.

“TinyML” es un campo emergente enfocado en ejecutar ML en microcontroladores. Estos enfoques extienden la IA a sensores y dispositivos portátiles que funcionan con baterías. - 5G y conectividad: La siguiente generación inalámbrica (5G y más allá) ofrece enlaces de alta velocidad y baja latencia que complementan Edge AI.

Las redes locales rápidas facilitan coordinar grupos de dispositivos en el borde y descargar tareas pesadas cuando es necesario. Esta sinergia entre 5G e IA habilita nuevas aplicaciones (por ejemplo, fábricas inteligentes, comunicación vehículo a todo). - Aprendizaje federado y colaborativo: Métodos que preservan la privacidad como el aprendizaje federado permiten que múltiples dispositivos en el borde entrenen un modelo conjuntamente sin compartir datos sin procesar.

Cada dispositivo mejora el modelo localmente y solo comparte actualizaciones. Esta tendencia (anticipada en hojas de ruta tecnológicas) potenciará Edge AI aprovechando datos distribuidos manteniendo la privacidad. - Paradigmas emergentes: De cara al futuro, la investigación explora la computación neuromórfica y la IA generativa en el dispositivo para aumentar aún más la inteligencia en el borde.

Como predice un informe, innovaciones como chips inspirados en el cerebro y modelos de lenguaje grandes locales podrían aparecer en el borde.

Estas tecnologías continúan ampliando las capacidades de Edge AI. En conjunto, ayudan a entregar la “era de la inferencia de IA” – acercando la inteligencia a usuarios y sensores.

>>> Puede interesarte:

¿Qué es el Aprendizaje por Refuerzo?

Edge AI está transformando la forma en que usamos la inteligencia artificial al mover el cómputo hacia la fuente de datos. Complementa la IA en la nube, ofreciendo análisis más rápidos, eficientes y privados en dispositivos locales.

Este enfoque aborda los desafíos de tiempo real y ancho de banda inherentes a las arquitecturas centradas en la nube. En la práctica, Edge AI impulsa una amplia gama de tecnologías modernas – desde sensores inteligentes y fábricas hasta drones y vehículos autónomos – al permitir inteligencia inmediata.

A medida que proliferan los dispositivos IoT y mejoran las redes, Edge AI solo crecerá. Los avances en hardware (microchips potentes, TinyML) y técnicas (aprendizaje federado, optimización de modelos) facilitan llevar IA a todas partes.

Según expertos, Edge AI aporta ganancias notables en eficiencia, privacidad y uso de ancho de banda. En resumen, Edge AI es el futuro de la inteligencia embebida – ofreciendo lo mejor de la IA en una forma distribuida y en el dispositivo.