Przez wiele lat (2023–2025) sztuczna inteligencja poczyniła ogromne postępy na wielu polach. Duże modele językowe (LLM) i chatboty, systemy multimodalne, narzędzia naukowe oparte na SI oraz robotyka – wszystkie te obszary odnotowały przełomy.

Giganci technologiczni wprowadzili nowe asystenty SI, społeczności open-source udostępniły potężne modele, a nawet regulatorzy zaczęli reagować na wpływ SI.

Poniżej przedstawiamy najważniejsze osiągnięcia, od rozszerzeń GPT-4 i Google Gemini po Nagrodę Nobla dla AlphaFold oraz odkrycia naukowe i artystyczne wspierane przez SI.

Generatywne modele językowe i chatboty

Nowoczesne LLM stały się znacznie bardziej zaawansowane i multimodalne. GPT-4 Turbo od OpenAI (ogłoszony w listopadzie 2023) potrafi teraz przetworzyć 128 000 tokenów w jednym zapytaniu (co odpowiada około 300 stronom tekstu) i jest znacznie tańszy w użytkowaniu niż GPT-4.

W maju 2024 OpenAI wprowadziło GPT-4o (Omni), ulepszony model obsługujący tekst, obrazy i dźwięk w czasie rzeczywistym – co w praktyce daje GPT-4 zdolność „widzenia i słyszenia” w rozmowie. ChatGPT zyskał wbudowane funkcje obrazów i głosu: użytkownicy mogą przesyłać zdjęcia lub mówić do bota, który odpowiada na podstawie tych danych wizualnych lub dźwiękowych.

- GPT-4 Turbo i GPT-4o (Omni): GPT-4 Turbo (listopad 2023) obniżył koszty i wydłużył długość kontekstu do 128 tys. tokenów. GPT-4o (maj 2024) uczynił SI naprawdę multimodalną, generując tekst, mowę i obrazy z prędkością zbliżoną do ludzkiej.

- Postępy ChatGPT: Pod koniec 2023 ChatGPT „potrafi już widzieć, słyszeć i mówić” – można przesyłać obrazy i dźwięki jako zapytania, a bot odpowiada adekwatnie.

Zintegrowano też DALL·E 3 (październik 2023), co pozwala generować obrazy na podstawie tekstu z pomocą konwersacyjnych wskazówek. - Seria Gemini Google’a: W grudniu 2024 Google DeepMind wprowadził pierwsze modele Gemini 2.0 („Flash” i prototypy) zaprojektowane na „erę agentów” – SI zdolną do autonomicznego wykonywania złożonych, wieloetapowych zadań.

Google rozpoczął już testy Gemini 2.0 w wyszukiwarce (AI Overviews) i innych produktach dla ponad miliarda użytkowników, co odzwierciedla ulepszone zdolności rozumowania i multimodalności. - Inne modele: Meta wypuściło LLaMA 3 w kwietniu 2024 (otwarte modele LLM do 400 mld parametrów), twierdząc, że przewyższa wiele wcześniejszych modeli.

Anthropic z modelem Claude 3 oraz narzędzia Microsoft Copilot również bazują na tych postępach (np. Copilot oparty na technologii OpenAI).

Te innowacje pozwalają asystentom SI prowadzić znacznie dłuższe, bogatsze rozmowy i obsługiwać różnorodne dane wejściowe.

Napędzają też nowe aplikacje „asystentów” dostępne przez API (Google „AI Overviews”, OpenAI Assistants API itd.), czyniąc SI bardziej dostępną dla programistów i użytkowników końcowych.

Postępy multimodalnej i kreatywnej SI

Kreatywność i zdolności wizualne SI eksplodowały. Modele tekst-na-obraz i tekst-na-wideo osiągnęły nowe poziomy:

OpenAI DALL·E 3 (październik 2023) generuje fotorealistyczne obrazy na podstawie zapytań i jest zintegrowany z ChatGPT, co ułatwia tworzenie precyzyjnych promptów.

Google wprowadził Imagen 3 (październik 2024) oraz Veo 2 (grudzień 2024) – nowoczesne silniki tekst-na-obraz i tekst-na-wideo – które znacznie poprawiają jakość, szczegółowość i spójność generowanej sztuki i filmów.

Nawet muzyka SI poszła do przodu dzięki narzędziom MusicFX Google’a i powiązanym badaniom (np. eksperymenty MusicLM).

- Modele generatywnej sztuki: DALL·E 3 i Imagen 3 potrafią wiernie odwzorować subtelne wskazówki (w tym tekst osadzony w obrazach).

Google Veo 2 generuje krótkie klipy wideo na podstawie pojedynczego opisu tekstowego, co jest znaczącym krokiem w syntezie wideo.

Stable Diffusion i Midjourney również wypuściły nowe wersje (v3, v6) z lepszym realizmem w tym roku. - SI w urządzeniach: Apple wprowadziło Apple Intelligence (w iOS 18 i macOS 15, pod koniec 2024) – wbudowaną generatywną SI na iPhone, iPad i Mac.

Dodaje asystentów pisania (przepisywanie, korekta, streszczanie w Mail/Pages), jeszcze mądrzejszą Siri oraz narzędzia do obrazów, takie jak Image Playground (tworzenie ilustracji za pomocą tekstu) i Genmoji (generowane przez SI spersonalizowane emoji).

Zdjęcia zyskały wyszukiwanie w języku naturalnym („znajdź Maję na deskorolce”), a funkcja „Clean Up” usuwa niechciane obiekty ze zdjęć.

Apple stawia na przetwarzanie lokalne i prywatność. - SI w sztuce: Przykład godny uwagi: w listopadzie 2024 Sotheby’s sprzedało pierwszy obraz namalowany przez humanoidalnego robota.

Portret Alana Turinga stworzony przez robota zasilanego SI Ai-Da osiągnął cenę 1,08 mln USD.

Ta rekordowa sprzedaż („A.I. God: Portret Alana Turinga”) podkreśla rosnącą rolę SI w kreatywności i jej wpływ kulturowy.

Ogólnie rzecz biorąc, modele generatywne demokratyzują kreatywność: każdy może teraz tworzyć sztukę, muzykę czy wideo za pomocą kilku słów.

Branża przesunęła się z poziomu ciekawostek (surrealistyczne obrazy) do praktycznego generowania obrazów (logotypy, diagramy, mapy) i realizmu zbliżonego do ludzkiego.

(W marcu 2025 OpenAI wypuściło nawet „4o Image Generation”, integrując swój najlepszy model obrazowy z GPT-4o dla precyzyjnych, fotorealistycznych efektów sterowanych rozmową.)

Narzędzia te szybko trafiają do aplikacji, przeglądarek i procesów twórczych.

SI w nauce, medycynie i matematyce

Osiągnięcia SI napędziły odkrycia naukowe i postępy badawcze:

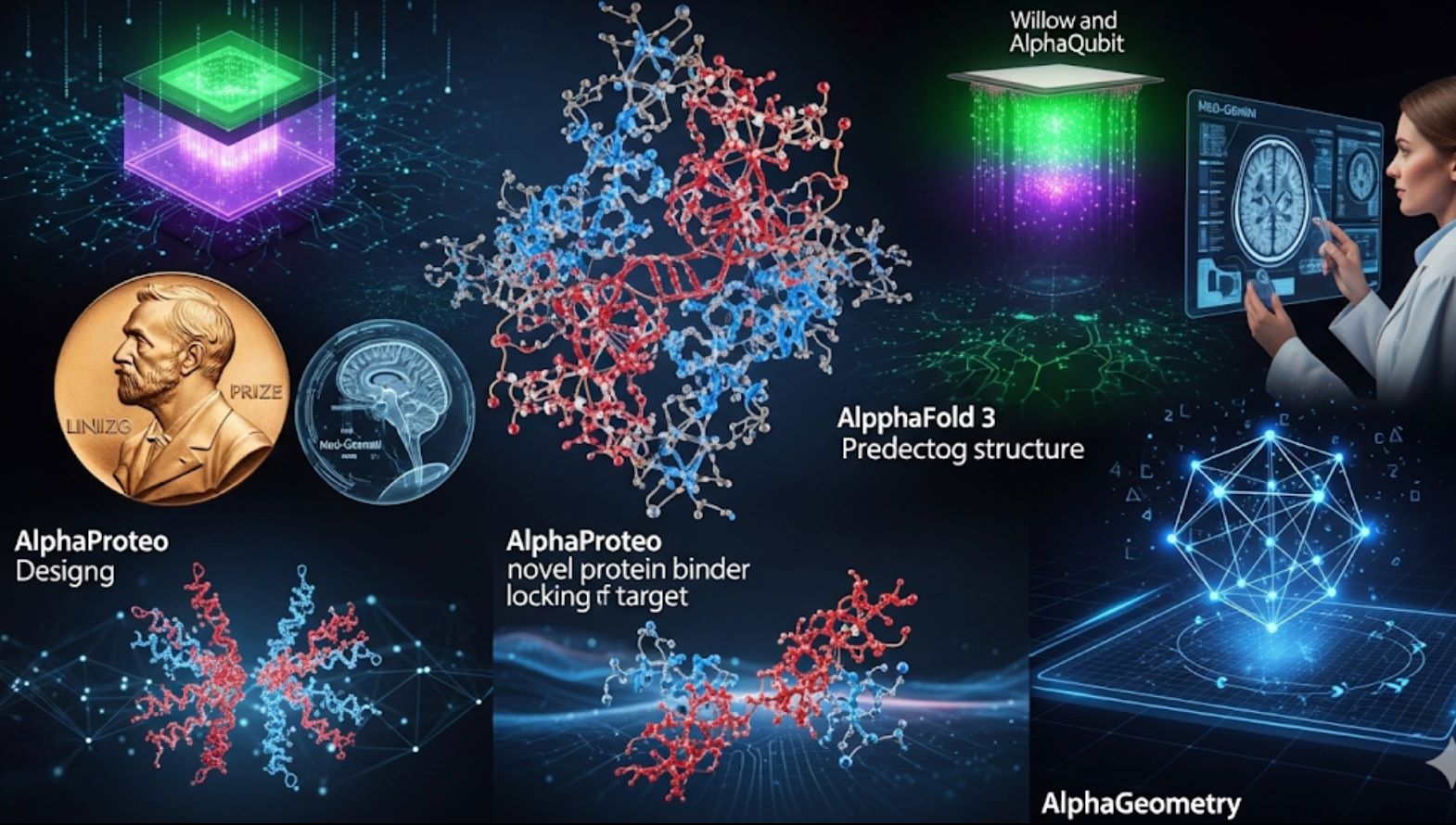

- AlphaFold 3 – biomolekuły: W listopadzie 2024 Google DeepMind (we współpracy z Isomorphic Labs) zaprezentował AlphaFold 3, nowy model przewidujący trójwymiarowe struktury wszystkich biomolekuł (białek, DNA, RNA, ligandów itd.) jednocześnie z bezprecedensową dokładnością.

W przypadku interakcji białek z lekami AlphaFold 3 jest około 50% dokładniejszy niż tradycyjne metody.

Twórcy natychmiast udostępnili bezpłatny AlphaFold Server, aby naukowcy na całym świecie mogli przewidywać struktury molekularne.

To rozszerzenie wcześniejszych przewidywań białek AlphaFold 2, które ma zrewolucjonizować odkrywanie leków i badania genomowe. - Nagroda Nobla – fałdowanie białek: Znaczenie tego przełomu podkreśliła Nagroda Nobla w dziedzinie chemii w 2024 roku.

Demis Hassabis i John Jumper (DeepMind) podzielili się nagrodą (wraz z Davidem Bakerem) za rozwój AlphaFold (SI do fałdowania białek).

Komitet Noblowski zauważył, że AlphaFold „otworzył zupełnie nowe możliwości” w projektowaniu białek.

(To jedno z najbardziej medialnych osiągnięć SI do tej pory.) - AlphaProteo – projektowanie leków: Również w 2024 DeepMind ogłosił AlphaProteo, SI, która projektuje nowe wiążące białka – cząsteczki silnie łączące się z docelowymi białkami.

AlphaProteo może przyspieszyć tworzenie nowych przeciwciał, biosensorów i kandydatów na leki, generując obiecujące struktury białek dla określonych celów. - Matematyka – AlphaGeometry: DeepMind zaprezentował kolejne przełomy dzięki AlphaGeometry i AlphaProof.

W lipcu 2024 AlphaGeometry 2 rozwiązał zadanie z Międzynarodowej Olimpiady Matematycznej w 19 sekund, osiągając poziom srebrnego medalisty.

To rzadki przypadek, gdy SI radzi sobie z zaawansowaną matematyką na poziomie szkoły średniej. - Komputery kwantowe – AlphaQubit i Willow: SI poprawiła też najnowocześniejszy sprzęt.

W 2024 Google ogłosił AlphaQubit, dekoder oparty na SI, który znacznie lepiej niż wcześniejsze metody wykrywa błędy w komputerach kwantowych (np. chipy Sycamore Google’a).

W grudniu 2024 Google zaprezentował Willow, nowy chip kwantowy, który dzięki zaawansowanej korekcji błędów rozwiązał zadanie benchmarkowe w mniej niż 5 minut, podczas gdy najlepszy superkomputer potrzebowałby około 10^24 lat.

Te osiągnięcia przyniosły Willow nagrodę „Przełom roku w fizyce 2024”, podkreślając rolę SI w postępach kwantowych.

W medycynie i zdrowiu modele SI również poczyniły znaczne postępy. Na przykład nowy model Google Med-Gemini (dostrojony na danych medycznych) uzyskał 91,1% na benchmarku egzaminu medycznego w USA (w stylu USMLE), znacznie przewyższając wcześniejsze modele.

Udostępniono narzędzia SI do radiologii i patologii (np. Derm i Path Foundations), które poprawiają analizę obrazów.

Ogólnie SI stała się niezbędnym partnerem badawczym – od nanoskalowego mapowania ludzkiego mózgu (z pomocą obrazowania EM wspieranego SI) po przyspieszenie przesiewowych badań gruźlicy w Afryce, jak raportują badacze Google’a.

SI w robotyce i automatyzacji

Roboty zasilane SI uczą się wykonywać skomplikowane zadania w rzeczywistym świecie.

Humanoidalne roboty Optimus Tesli zostały publicznie zaprezentowane w październiku 2024 podczas wydarzenia „We, Robot”. Kilkadziesiąt jednostek Optimus chodziło, stało, a nawet tańczyło na scenie – choć późniejsze raporty wskazywały, że początkowe pokazy były częściowo zdalnie sterowane przez ludzi.

Mimo to wydarzenie podkreśliło szybki postęp w kierunku robotów ogólnego przeznaczenia.

- Roboty ALOHA DeepMind: Laboratorium SI Google’a osiągnęło imponujące wyniki w robotach domowych.

W 2024 robot ALOHA (Autonomous Legged Household Assistant) nauczył się wiązać sznurowadła, wieszać koszulę, naprawiać innego robota, wkładać zębatki, a nawet sprzątać kuchnię wyłącznie dzięki planowaniu i wizji SI.

Otwarte projekty „ALOHA Unleashed” pokazały roboty koordynujące dwie ręce do zadań, co jest pierwszym takim przypadkiem w manipulacji ogólnego przeznaczenia. - Robotyczne Transformery: DeepMind wprowadził RT-2 (Robotic Transformer 2), model wizja-język-akcja, który potrafi uczyć się zarówno z obrazów internetowych, jak i danych z prawdziwych robotów.

RT-2 pozwala robotom interpretować polecenia jak człowiek, wykorzystując wiedzę z sieci.

Model został zaprezentowany podczas pomocy robotowi w sortowaniu obiektów na podstawie tekstowych instrukcji. - Roboty przemysłowe: Inne firmy również poczyniły postępy: Boston Dynamics kontynuowało udoskonalanie robotów Atlas i Spot (choć bez pojedynczego przełomu), a pojazdy autonomiczne zasilane SI poprawiły się (beta pełnej autonomii Tesli została szerzej udostępniona, choć pełna autonomia nadal pozostaje wyzwaniem).

W produkcji firmy skoncentrowane na SI, takie jak Figure AI, pozyskały fundusze na budowę robotów domowych do prac porządkowych.

Te działania pokazują, że roboty wykonują coraz trudniejsze zadania bez konieczności programowania krok po kroku. Jednak prawdziwe, w pełni autonomiczne humanoidy wciąż są w fazie rozwoju.

Pokazy (Optimus, ALOHA, RT-2) to kamienie milowe, ale badacze ostrzegają, że przed bezpiecznym i niezawodnym współdziałaniem robotów z ludźmi na dużą skalę jest jeszcze wiele pracy.

SI w produktach, przemyśle i społeczeństwie

Wpływ SI sięga codziennych produktów, a nawet polityki:

- Urządzenia konsumenckie: Najważniejsze produkty technologiczne wprowadziły agentów SI.

Copilot Microsoftu (wbudowany w Windows, Office, Bing) oraz Bard/Bard AI Google’a w wyszukiwarce (oparty na Gemini) udostępniły moc LLM użytkownikom.

Urządzenia Apple otrzymały Apple Intelligence (jak wyżej), a producenci sprzętu, tacy jak Nvidia, sprzedali rekordowe ilości procesorów graficznych do SI, napędzając zarówno chmurę, jak i konsumencką SI.

(Nvidia stała się najcenniejszą firmą świata w 2024 dzięki boomowi SI.) - Regulacje – unijna ustawa o SI: W odpowiedzi na zasięg SI, regulatorzy również podjęli działania.

1 sierpnia 2024 weszła w życie UE AI Act, pierwsze kompleksowe prawo dotyczące SI.

Ustanawia ono ramy oparte na ryzyku: SI niskiego ryzyka (filtry spamu, gry wideo) podlega minimalnym zasadom; zasady przejrzystości wymagają, by systemy SI, takie jak chatboty, ujawniały, że są SI; SI wysokiego ryzyka (narzędzia medyczne czy rekrutacyjne) podlega ścisłemu nadzorowi; a wyraźnie nieakceptowalna SI (np. „ocena społeczna” osób przez rządy) jest zakazana.

Ten zestaw reguł (wraz z nadchodzącymi wytycznymi dotyczącymi modeli ogólnego przeznaczenia) to ważne osiągnięcie w zarządzaniu SI i prawdopodobnie wpłynie na standardy na całym świecie. - Wzrost branży: Sektor SI odnotował historyczne finansowanie i wyceny: OpenAI osiągnęło wycenę 157 mld USD pod koniec 2023, a firmy takie jak Anthropic, Inflection i chińskie startupy SI pozyskały wielomiliardowe rundy finansowania.

Wzrost popytu na sprzęt SI Nvidia podniósł jej kapitalizację rynkową powyżej 3,5 biliona USD do połowy 2024.

Te liczby podkreślają, jak bardzo SI stała się centralnym elementem gospodarki technologicznej.

>>> Czy kiedykolwiek próbował Pan/Pani: Porównanie sztucznej inteligencji z inteligencją ludzką ?

Krótko mówiąc, SI nie jest już ograniczona do laboratoriów czy pokazów nowości – jest wbudowana w telefony, samochody, miejsca pracy i politykę publiczną.

Powyższe postępy – od ogromnej wiedzy GPT-4 po naukowe rewolucje AlphaFold – pokazują szybkie dojrzewanie SI.

Wchodząc w 2025 rok, te osiągnięcia zapowiadają jeszcze potężniejsze i praktyczniejsze zastosowania SI w naszym codziennym życiu.