Nowoczesne laboratoria badawcze wykorzystują sztuczną inteligencję (AI) do przetwarzania wyników eksperymentów z niespotykaną dotąd szybkością. Integrując AI z automatycznymi urządzeniami i superkomputerami, naukowcy mogą analizować ogromne zbiory danych w czasie rzeczywistym, natychmiast identyfikować wzorce, a nawet przewidywać wyniki bez konieczności przeprowadzania powolnych, tradycyjnych eksperymentów. Ta zdolność już rewolucjonizuje dziedziny od nauki o materiałach po biologię.

Poniżej przedstawiamy kluczowe sposoby, w jakie AI przyspiesza analizę danych laboratoryjnych:

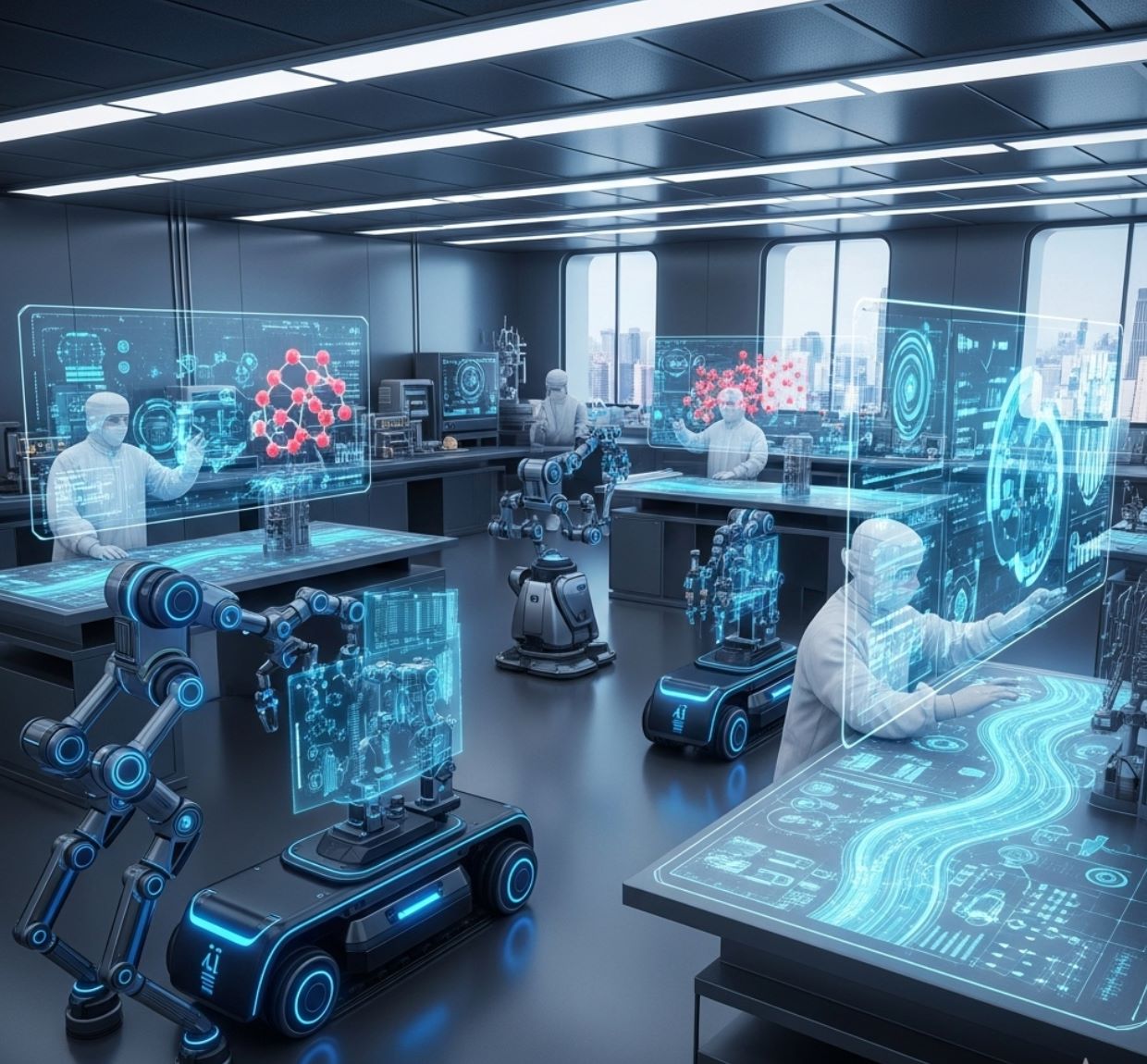

- Zautomatyzowane laboratoria „samobieżne”: Roboty sterowane przez AI prowadzą eksperymenty nieprzerwanie i wybierają próbki do testów, redukując czas przestoju i powtarzalne pomiary.

- Przetwarzanie danych w czasie rzeczywistym: Dane przesyłane strumieniowo z urządzeń trafiają do systemów obliczeniowych opartych na AI, które dokonują natychmiastowej analizy. Badacze mogą na bieżąco modyfikować eksperymenty, ponieważ wyniki otrzymują w minutach, a nie dniach.

- Predykcyjne modele uczenia maszynowego: Po odpowiednim wytrenowaniu modele AI mogą symulować eksperymenty komputerowo. Na przykład generują tysiące struktur molekularnych lub profili ekspresji genów w ciągu minut, co tradycyjne metody laboratoryjne zajmowałyby tygodnie lub miesiące.

- Automatyzacja całego procesu badawczego: Szerokie platformy AI (takie jak FutureHouse z MIT) są tworzone, aby obsługiwać pełne procesy — od przeglądu literatury i zbierania danych po projektowanie eksperymentów i analizę — automatyzując wiele kluczowych etapów badań.

Te postępy pozwalają naukowcom skupić się na wnioskach, zamiast na rutynowym przetwarzaniu danych, znacznie przyspieszając tempo odkryć.

Automatyzacja laboratoriów napędzana przez AI

Badacze tworzą autonomiczne laboratoria, które prowadzą eksperymenty przy minimalnym udziale człowieka.

Na przykład w Lawrence Berkeley Lab, w obiekcie A-Lab, algorytmy AI współpracują z ramionami robotycznymi: AI proponuje nowe materiały do testów, a roboty szybko je mieszają i badają. Ten ścisły cykl „robotycznych naukowców” pozwala na znacznie szybszą weryfikację obiecujących związków niż w badaniach manualnych.

Podobnie projekt FutureHouse z MIT rozwija agentów AI do zadań takich jak wyszukiwanie literatury, planowanie eksperymentów oraz analiza danych, umożliwiając naukowcom skupienie się na odkryciach zamiast na rutynowych zadaniach.

Szczególnie imponującym przykładem jest samobieżny mikroskop z Argonne National Laboratory. W tym systemie algorytm AI zaczyna od skanowania kilku losowych punktów na próbce, a następnie przewiduje, gdzie mogą znajdować się kolejne interesujące cechy.

Skupiając się tylko na obszarach bogatych w dane i pomijając jednolite fragmenty, mikroskop zbiera użyteczne obrazy znacznie szybciej niż tradycyjne skanowanie punkt po punkcie. Jak wyjaśniają naukowcy z Argonne, sterowanie AI „w locie” „eliminuję potrzebę ingerencji człowieka i znacznie przyspiesza eksperyment”.

W praktyce oznacza to znacznie efektywniejsze wykorzystanie czasu na urządzeniach o dużym zapotrzebowaniu: badacze mogą wykonać wiele skanów wysokiej rozdzielczości w czasie, który manualne metody zajmowałyby na jeden.

Przetwarzanie danych w czasie rzeczywistym w ośrodkach badawczych

Duże ośrodki badawcze wykorzystują AI do analizy danych w momencie ich powstawania. W Berkeley Lab surowe dane z mikroskopów i teleskopów są przesyłane bezpośrednio do superkomputera.

Następnie przepływy pracy oparte na uczeniu maszynowym przetwarzają te dane w ciągu kilku minut. Na przykład nowa platforma o nazwie Distiller przesyła obrazy z mikroskopu elektronowego do superkomputera NERSC podczas obrazowania; wyniki wracają natychmiast, co pozwala naukowcom na bieżąco udoskonalać eksperyment.

Nawet skomplikowane urządzenia korzystają z tego rozwiązania: w akceleratorze laserowym BELLA modele głębokiego uczenia stale dostrajają wiązki laserowe i elektronowe dla optymalnej stabilności, znacznie skracając czas poświęcany przez naukowców na ręczne kalibracje.

Inne laboratoria narodowe wykorzystują AI do kontroli jakości na żywo. Synchrotron NSLS-II w Brookhaven stosuje teraz agentów AI do całodobowego monitorowania eksperymentów na liniach wiązek.

Jeśli próbka się przesunie lub dane wydają się „nieprawidłowe”, system natychmiast to sygnalizuje. Tego rodzaju wykrywanie anomalii oszczędza ogromne ilości czasu — naukowcy mogą naprawić problemy na bieżąco, zamiast odkrywać je po wielu godzinach utraconego czasu pracy wiązki.

Podobnie Wielki Zderzacz Hadronów CERN wykorzystuje algorytmy „fast ML” wbudowane w sprzęt wyzwalający: niestandardowa AI w układach FPGA analizuje sygnały zderzeń natychmiastowo, obliczając energie cząstek w czasie rzeczywistym i przewyższając starsze filtry sygnału.

We wszystkich tych przykładach AI zmienia sposób pracy z „zbieraj wszystko, a potem analizuj” na „analizuj na bieżąco”, czyniąc przetwarzanie danych niemal natychmiastowym.

Modele predykcyjne dla szybkich wniosków

AI nie tylko przyspiesza istniejące eksperymenty – zastępuje też powolną pracę laboratoryjną wirtualnymi eksperymentami. W genomice, na przykład, chemicy z MIT opracowali ChromoGen, generatywną AI, która uczy się „gramatyki” składania DNA.

Dając sekwencję DNA, ChromoGen potrafi „szybko analizować” sekwencję i wygenerować tysiące możliwych trójwymiarowych struktur chromatyny w ciągu minut. To znacznie szybciej niż tradycyjne metody laboratoryjne: podczas gdy eksperyment Hi-C może trwać dni lub tygodnie, aby zmapować genom jednego typu komórek, ChromoGen wygenerował 1000 przewidywanych struktur w zaledwie 20 minut na pojedynczym procesorze GPU.

Co ważne, przewidywania AI bardzo dobrze pokrywały się z danymi eksperymentalnymi, potwierdzając skuteczność podejścia.

W biologii zespoły z Uniwersytetu Columbia wytrenowały „model bazowy” na danych z ponad miliona komórek, aby prognozować aktywność genów.

Ich AI potrafi przewidzieć, które geny są aktywne w danym typie komórek, symulując w praktyce, co pokazałby rozległy eksperyment ekspresji genów. Jak zauważają badacze, te modele predykcyjne umożliwiają „szybkie i precyzyjne” eksperymenty obliczeniowe na dużą skalę, które wspierają i uzupełniają prace laboratoryjne.

W testach przewidywania ekspresji genów dla nowych typów komórek bardzo dobrze zgadzały się z rzeczywistymi pomiarami eksperymentalnymi.

Podsumowując, uczenie maszynowe pozwala naukowcom przeprowadzać wirtualne próby na dużą skalę: sprawdzając tysiące scenariuszy genomowych lub molekularnych w czasie, który w laboratorium zajęłoby wykonanie tylko jednego.

Wpływ i perspektywy na przyszłość

Integracja AI w procesie eksperymentalnym zmienia naukę. Automatyzując analizę danych, a nawet podejmowanie decyzji podczas eksperymentów, AI przekształca dawny wąski gardło w proces turbo.

Badacze podkreślają, że dzięki narzędziom napędzanym przez AI mogą „skupić się na odkryciach, podczas gdy maszyny zajmują się powtarzalnymi zadaniami i analizą ogromnych zbiorów danych w czasie rzeczywistym”.

Innymi słowy, naukowcy mogą przeprowadzać więcej eksperymentów i szybciej wyciągać wnioski niż kiedykolwiek wcześniej. Jak podsumowują fizycy z Argonne, możliwość „automatyzacji eksperymentów za pomocą AI znacząco przyspieszy postęp naukowy”.

Patrząc w przyszłość, można oczekiwać, że rola AI będzie rosła: coraz więcej laboratoriów będzie korzystać z samobieżnych urządzeń, a coraz więcej dziedzin będzie polegać na szybkiej analizie i predykcji AI.

Oznacza to, że cykl hipoteza–eksperyment–wynik skróci się — z lat do miesięcy, a nawet dni.

Efektem jest nowa era nauki opartej na danych, w której przełomy w dziedzinach materiałów, energii, zdrowia i innych mogą pojawiać się w niespotykanym dotąd tempie, napędzane zdolnością AI do szybkiego interpretowania danych eksperymentalnych.