Wat is natuurlijke taalverwerking?

Natuurlijke taalverwerking (NLP) is een vakgebied binnen kunstmatige intelligentie (AI) dat zich richt op het mogelijk maken dat computers menselijke taal begrijpen en ermee communiceren.

Natuurlijke taalverwerking (NLP) – of natural language processing – is een vakgebied binnen kunstmatige intelligentie (AI) dat zich richt op het mogelijk maken dat computers menselijke taal begrijpen en ermee communiceren. Simpel gezegd gebruikt NLP machine learning-methoden om computers het vermogen te geven om de natuurlijke taal die wij dagelijks gebruiken te interpreteren, ermee te interacteren en te begrijpen.

Dit wordt beschouwd als een van de meest complexe uitdagingen binnen AI omdat taal een geavanceerd hulpmiddel is om gedachten uit te drukken en communicatie mogelijk te maken die uniek is voor mensen, waardoor machines de verborgen betekenissen achter zinnen moeten "begrijpen".

Natuurlijke taal verwijst hier naar menselijke talen zoals Vietnamees, Engels, Chinees, enzovoort, in tegenstelling tot computertalen. Het doel van NLP is om computers te programmeren om deze talen automatisch te verwerken en te begrijpen, en zelfs zinnen te genereren die lijken op menselijke taal.

Waarom is natuurlijke taalverwerking belangrijk?

In het digitale tijdperk is de hoeveelheid taaldata (tekst, audio, gesprekken) enorm gegroeid uit vele bronnen zoals e-mails, berichten, sociale netwerken, video’s, enzovoort. In tegenstelling tot gestructureerde data (cijfers, tabellen) is taaldata in tekst- of audioformaat ongestructureerde data – zeer moeilijk automatisch te verwerken zonder NLP.

Natuurlijke taalverwerkingstechnologie helpt computers deze ongestructureerde data effectief te analyseren en intentie, context en emoties in menselijke woorden te begrijpen. Dankzij dit wordt NLP de sleutel voor machines om te communiceren en mensen slimmer te bedienen.

Natuurlijke interactie

Maakt natuurlijke communicatie tussen mens en computer mogelijk zonder complexe commando’s te hoeven leren.

Tijd- en kostenbesparing

Automatiseert complexe taalgerelateerde taken, waardoor handmatige inspanning en operationele kosten worden verminderd.

Verbeterde ervaring

Personaliseert diensten en verbetert de gebruikerservaring in diverse toepassingen.

Natuurlijke taalverwerking is belangrijk omdat het natuurlijke interactie tussen mens en computer mogelijk maakt. In plaats van computertalen te leren, kunnen we commando’s geven of vragen stellen in onze moedertaal. NLP automatiseert veel complexe taalgerelateerde taken, waardoor tijd en kosten worden bespaard en de gebruikerservaring in vrijwel elk vakgebied wordt verbeterd.

Bedrijven kunnen NLP gebruiken om automatisch duizenden klantreacties op sociale media te analyseren en waardevolle inzichten te verkrijgen, terwijl chatbots aangedreven door NLP klanten 24/7 consistent kunnen beantwoorden.

— Voorbeeld uit de industrie

Een juiste toepassing van NLP helpt bedrijven processen te optimaliseren, productiviteit te verhogen en zelfs diensten te personaliseren voor elke gebruiker.

Het is duidelijk dat natuurlijke taalverwerking een kerntechnologie is geworden die veel slimme toepassingen om ons heen aandrijft en machines helpt taal beter te "begrijpen" dan ooit tevoren.

Veelvoorkomende toepassingen van NLP

Dankzij het vermogen om taal te "begrijpen" wordt NLP breed toegepast in diverse vakgebieden. Hieronder enkele belangrijke toepassingen van natuurlijke taalverwerking:

Virtuele assistenten & chatbots

NLP maakt het mogelijk virtuele assistenten zoals Siri, Alexa of chatbots op websites, Facebook Messenger, enzovoort te creëren die gebruikersvragen begrijpen en automatisch reageren.

- Beantwoorden veelgestelde vragen

- Helpen bij planning en winkelen

- 24/7 klantproblemen oplossen

Sentiment- & opinieanalyse

Bedrijven gebruiken NLP om klantfeedback te analyseren op sociale media, enquêtes of productrecensies.

- Sentiment detecteren (positief/negatief)

- Houdingen en sarcasme herkennen

- Klantmeningen en markttrends begrijpen

Machinevertaling

Machinevertaling is een klassieke NLP-toepassing. Vertaalsoftware (zoals Google Translate) gebruikt NLP om tekst of spraak van de ene taal naar de andere om te zetten met behoud van betekenis en context.

Spraakverwerking

- Spraakherkenning: Zet gesproken taal om in tekst

- Tekst-naar-spraak: Creëert natuurlijk klinkende stemmen

- Spraakgestuurde systemen in auto’s en slimme huizen

Classificatie & informatie-extractie

NLP kan automatisch teksten classificeren op onderwerp en belangrijke informatie extraheren:

- Spamfiltering vs. niet-spam e-mails

- Nieuws categorisatie

- Extractie van medische gegevens

- Filteren van juridische documenten

Geautomatiseerde contentgeneratie

Moderne taalmodellen (zoals GPT-3, GPT-4) kunnen natuurlijke taal genereren – teksten creëren die menselijk lijken:

- Artikelen schrijven en e-mails opstellen

- Poëzie maken en code schrijven

- Ondersteunen bij contentcreatie

- Automatische klantenservice-antwoorden

Over het algemeen kan elke taak die te maken heeft met natuurlijke taal (tekst, spraak) NLP toepassen om te automatiseren of efficiëntie te verbeteren. Van informatieopvraging, vraagbeantwoording, documentanalyse tot onderwijsondersteuning (bijv. automatische essaybeoordeling, virtuele tutoring) – natuurlijke taalverwerking speelt een cruciale rol.

Hoe werkt NLP?

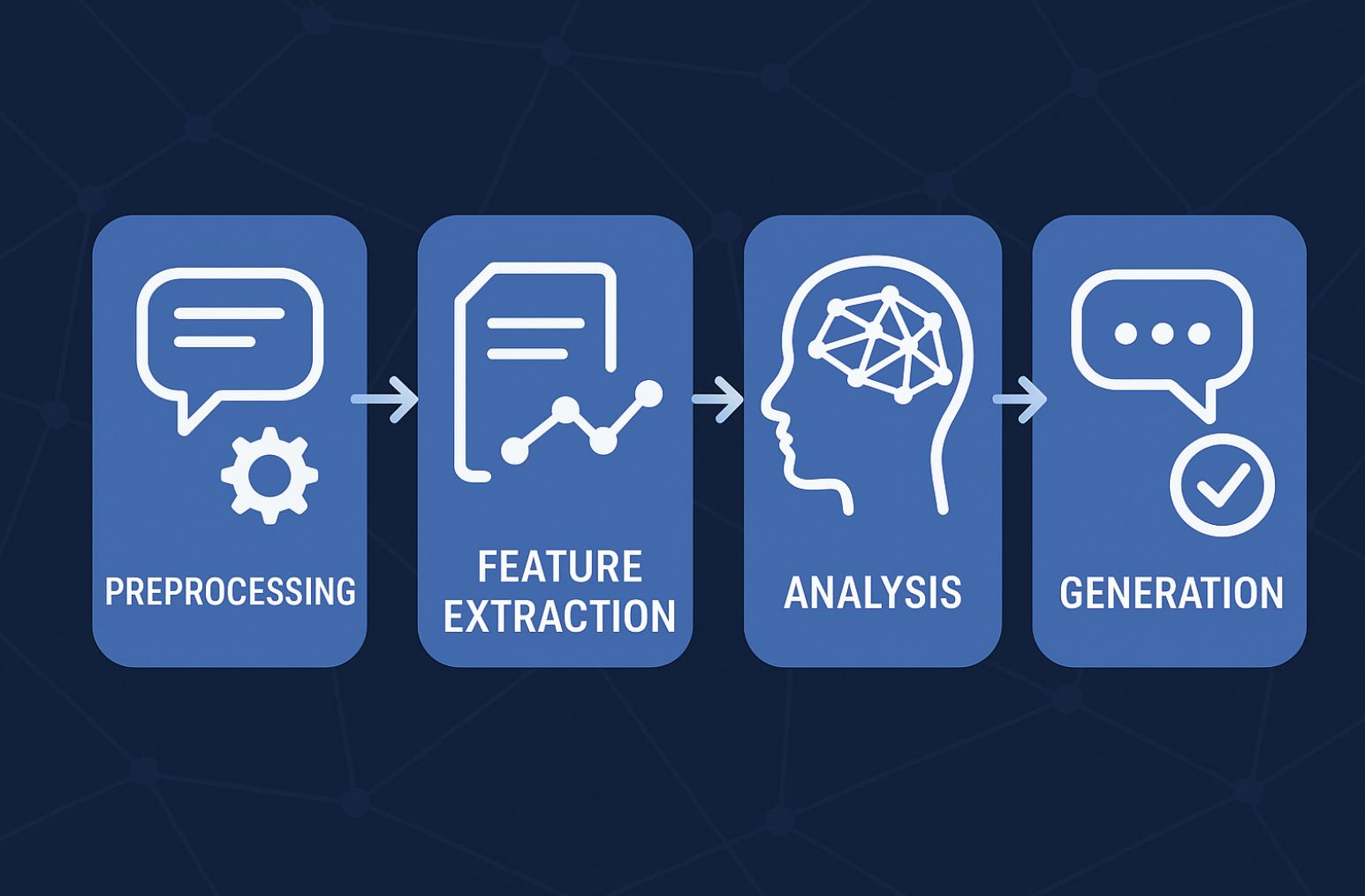

Om computers menselijke taal te laten begrijpen, combineert NLP verschillende technieken uit de informatica en taalkunde. In essentie doorloopt een NLP-systeem de volgende hoofdfasen bij het verwerken van taal:

Voorbewerking

Eerst wordt tekst of spraak omgezet in ruwe data voor de computer. Voor tekst voert NLP zinnen splitsen, tokenisatie uit, zet alles om naar kleine letters, verwijdert leestekens en stopwoorden (woorden zoals "de", "is" die weinig betekenis dragen).

Vervolgens kan stemming/lemmatisering worden toegepast – woorden terugbrengen tot hun stamvorm (bijv. "rennen" naar "ren"). Voor spraak is de eerste stap spraakherkenning om tekst te verkrijgen. Het resultaat van voorbewerking is schone en genormaliseerde taaldata klaar voor machine learning.

Kenmerkextractie

Computers begrijpen woorden niet direct, dus NLP moet taal representeren als getallen. Deze stap zet tekst om in numerieke kenmerken of vectoren.

Veelgebruikte technieken zijn Bag of Words, TF-IDF (term frequency-inverse document frequency), of geavanceerdere woord-embedding-methoden (zoals Word2Vec, GloVe) – waarbij elk woord een vector krijgt die zijn betekenis representeert. Deze vectoren helpen algoritmes de semantische relaties tussen woorden te begrijpen (bijv. "koning" ligt dichter bij "koningin" dan bij "auto" in vectorruimte).

Contextanalyse & begrip

Wanneer numerieke data beschikbaar is, gebruikt het systeem machine learning-modellen en algoritmes om syntaxis en semantiek te analyseren.

Bijvoorbeeld, syntactische analyse identificeert de rol van woorden in een zin (wat is het onderwerp, werkwoord, voorwerp, enzovoort), terwijl semantische analyse helpt de betekenis van de zin in context te begrijpen. Moderne NLP gebruikt deep learning-modellen om deze taken uit te voeren, waardoor computers geleidelijk de betekenis van zinnen bijna als mensen kunnen doorgronden.

Taalgeneratie of actie

Afhankelijk van het doel kan de laatste stap zijn om resultaten te produceren voor de gebruiker. Bijvoorbeeld, bij een vraag zal het NLP-systeem een passend antwoord vinden uit data en reageren (in tekst of spraak). Bij een commando zal NLP een actie op de machine activeren (bijv. muziek afspelen bij "Speel muziek").

Bij machinevertaling genereert deze stap de vertaalde zin in de doeltaal. Voor chatbots is dit het moment waarop natuurlijke reacties worden gegenereerd op basis van het begrip uit eerdere stappen.

Deze opsplitsing helpt ons echter te visualiseren hoe NLP werkt om menselijke taal om te zetten in een vorm die computers begrijpen en passend kunnen beantwoorden.

Benaderingen in NLP

Gedurende de ontwikkelingsgeschiedenis heeft natuurlijke taalverwerking verschillende generaties van benaderingen doorgemaakt. Van de jaren 50 tot nu kunnen we drie hoofdbenaderingen in NLP onderscheiden:

Regelgebaseerde NLP (jaren 50-80)

Dit was de eerste benadering. Programmeurs schreven sets taalregels in if-dan-formaat zodat machines zinnen konden verwerken.

- Voorgeprogrammeerde zinspatronen

- Geen machine learning betrokken

- Starre regelgebaseerde reacties

- Zeer beperkt begrip

- Geen zelflerend vermogen

- Moeilijk schaalbaar

- Vereist taalkundige experts

Statistische NLP (jaren 90-2000)

Vanaf de jaren 90 verschoof NLP naar statistisch machine learning. In plaats van handmatig regels te schrijven, werden algoritmes gebruikt om machines taalmodellen te laten leren uit data.

Op waarschijnlijkheid gebaseerd

Berekenen van waarschijnlijkheden om passende woordbetekenissen te selecteren op basis van context

Praktische toepassingen

Maakte spellingscontrole en woordvoorspellingssystemen zoals T9 op oude telefoons mogelijk

Deze benadering maakt natuurlijke taalverwerking flexibeler en nauwkeuriger, omdat machines waarschijnlijkheden kunnen berekenen om de juiste betekenis van een woord/zin te kiezen op basis van context.

Deep Learning NLP (2010-heden)

Sinds eind jaren 2010 is deep learning met neurale netwerk-modellen de dominante methode in NLP geworden. Dankzij de enorme hoeveelheid tekstdata op het internet en toegenomen rekenkracht kunnen deep learning-modellen automatisch zeer abstracte taalrepresentaties leren.

Transformer-model

Belangrijke doorbraak met self-attention mechanisme voor beter contextbegrip

BERT

Google’s model verbeterde de zoekkwaliteit aanzienlijk

GPT-serie

GPT-2, GPT-3, GPT-4 maakten vloeiende tekstgeneratie mogelijk

Moderne trends: Foundation Models

Een moderne trend is het gebruik van foundation models – grote vooraf getrainde AI-modellen op miljarden woorden. Deze modellen (bijv. OpenAI’s GPT-4 of IBM’s Granite) kunnen snel worden aangepast voor diverse NLP-taken, van betekenisvolle tekstsamenvatting tot gespecialiseerde informatie-extractie.

Tijdbesparend

Bespaart trainingstijd met vooraf getrainde modellen

Hoge prestaties

Behaalt superieure resultaten over verschillende taken

Verbeterde nauwkeurigheid

Retrieval-augmented generatie verbetert de precisie van antwoorden

Dit toont aan dat NLP zich dynamisch ontwikkelt en technisch continu innoveert.

Uitdagingen en nieuwe trends in NLP

Huidige uitdagingen

Ondanks vele prestaties staat natuurlijke taalverwerking nog steeds voor aanzienlijke uitdagingen. Menselijke taal is extreem rijk en divers: dezelfde zin kan meerdere betekenissen hebben afhankelijk van de context, om nog maar te zwijgen over straattaal, uitdrukkingen, woordspelingen, sarcasme. Machines helpen om menselijke intentie in alle gevallen correct te begrijpen is niet eenvoudig.

Context & redeneren

Om gebruikersvragen nauwkeurig te beantwoorden, moeten NLP-systemen over vrij brede achtergrondkennis en enige redeneervermogen beschikken, niet alleen geïsoleerde woorden begrijpen.

Meertalige complexiteit

Elke taal heeft unieke kenmerken:

- Vietnamees verschilt van Engels in schrift en structuur

- Japans en Chinees scheiden woorden niet duidelijk

- Regionale dialecten en culturele nuances

Opkomende trends

Wat betreft trends streeft moderne NLP ernaar systemen te creëren die slimmer en meer "kennisrijk" zijn. Grotere taalmodellen (met meer parameters en trainingsdata) zoals GPT-4, GPT-5, enzovoort, zullen naar verwachting het begrip en de generatie van natuurlijke taal blijven verbeteren.

Uitlegbare NLP

Onderzoekers zijn geïnteresseerd in het maken van NLP die uitlegbaar is – wat betekent dat we kunnen begrijpen waarom een machine een beslissing neemt op basis van welke taalkenmerken, in plaats van een mysterieuze "black box".

Integratie van reële kennis

Nieuwe modellen kunnen taalverwerking combineren met kennisdatabases of externe data om context beter te begrijpen.

Realtime informatie

Vraag-antwoord systemen kunnen informatie opzoeken van Wikipedia of internet in realtime

Verbeterde nauwkeurigheid

Levert nauwkeurige antwoorden in plaats van alleen te vertrouwen op geleerde data

Multimodale NLP

De trend naar multimodale NLP verwerkt tekst, afbeeldingen en audio tegelijkertijd zodat machines taal in een bredere context kunnen begrijpen.

NLP komt ook dichter bij algemene AI met interdisciplinair onderzoek dat cognitiewetenschap en neurowetenschap omvat, met als doel te simuleren hoe mensen taal echt begrijpen.

Conclusie

Samenvattend is natuurlijke taalverwerking geweest, is en zal blijven een kerngebied binnen AI met enorme potentie. Van het helpen van computers om menselijke taal te begrijpen tot het automatiseren van talloze taalgerelateerde taken, NLP heeft een diepgaande impact op alle aspecten van leven en technologie.

Met de ontwikkeling van deep learning en big data kunnen we in de nabije toekomst slimmere machines verwachten met natuurlijkere communicatie. Natuurlijke taalverwerking is de sleutel om de kloof tussen mens en computer te overbruggen en technologie op een natuurlijke en efficiënte manier dichter bij het menselijk leven te brengen.

No comments yet. Be the first to comment!