Edge AI (czasami nazywane „AI na brzegu”) oznacza uruchamianie modeli sztucznej inteligencji i uczenia maszynowego na lokalnych urządzeniach (czujniki, kamery, smartfony, bramy przemysłowe itp.) zamiast w odległych centrach danych. Innymi słowy, „brzeg” sieci – miejsce, gdzie generowane są dane – odpowiada za przetwarzanie. Pozwala to urządzeniom na natychmiastową analizę danych w momencie ich zbierania, zamiast ciągłego przesyłania surowych danych do chmury.

Jak wyjaśnia IBM, Edge AI umożliwia przetwarzanie w czasie rzeczywistym bezpośrednio na urządzeniu, bez konieczności polegania na centralnym serwerze. Na przykład kamera z Edge AI może na bieżąco wykrywać i klasyfikować obiekty, zapewniając natychmiastową informację zwrotną. Przetwarzając dane lokalnie, Edge AI działa nawet przy przerywanym lub braku połączenia z internetem.

Według raportów branżowych, zmiana ta postępuje szybko: globalne wydatki na przetwarzanie brzegowe osiągnęły około 232 miliardów dolarów w 2024 roku (wzrost o 15% w porównaniu z 2023), głównie dzięki rozwojowi IoT zasilanego AI.

Podsumowując, Edge AI po prostu przybliża obliczenia do źródła danych – wdrażając inteligencję na urządzeniach lub pobliskich węzłach, co przyspiesza reakcje i zmniejsza potrzebę przesyłania wszystkiego do chmury.

Edge AI a Cloud AI: Kluczowe różnice

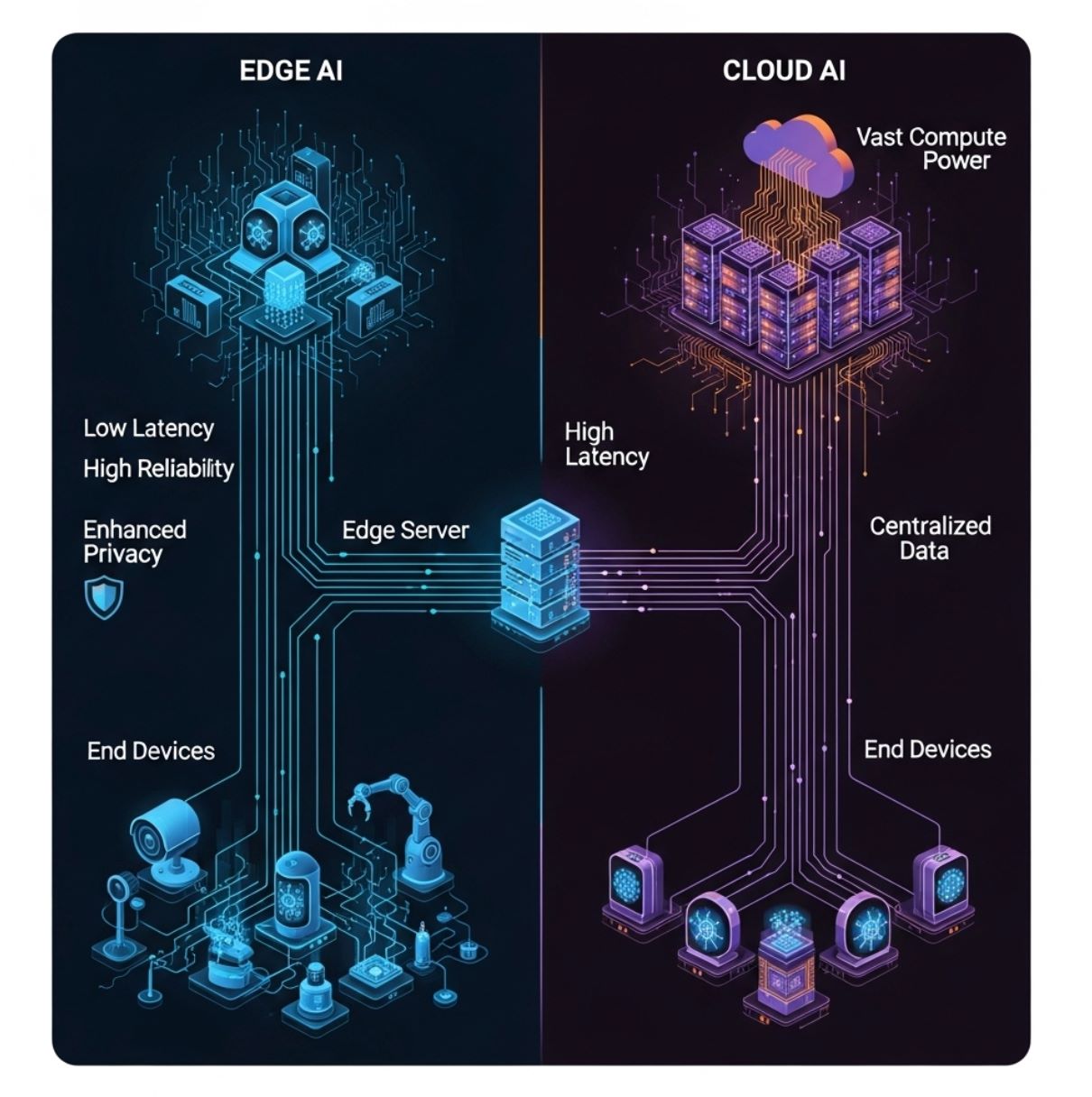

W przeciwieństwie do tradycyjnej AI opartej na chmurze (która przesyła wszystkie dane do scentralizowanych serwerów), Edge AI rozdziela obliczenia pomiędzy lokalny sprzęt. Powyższy diagram ilustruje prosty model przetwarzania brzegowego: urządzenia końcowe (dolna warstwa) przekazują dane do serwera brzegowego lub bramy (warstwa środkowa) zamiast wyłącznie do odległej chmury (warstwa górna).

W tym układzie wnioskowanie AI może odbywać się na urządzeniu lub lokalnym węźle brzegowym, co znacznie redukuje opóźnienia komunikacyjne.

- Opóźnienia: Edge AI minimalizuje lag. Ponieważ przetwarzanie odbywa się lokalnie, decyzje zapadają w ciągu milisekund. IBM zauważa, że wnioskowanie na brzegu „zapewnia zmniejszone opóźnienia dzięki przetwarzaniu danych bezpośrednio na urządzeniu”, podczas gdy AI w chmurze generuje dodatkowe opóźnienia związane z przesyłaniem danych do i z odległych serwerów.

Jest to kluczowe dla zadań wrażliwych na czas (np. unikanie wypadków samochodowych czy sterowanie robotem). - Przepustowość: Edge AI zmniejsza obciążenie sieci. Analizując lub filtrując dane na miejscu, znacznie mniej informacji musi być przesyłane dalej. IBM wyjaśnia, że systemy brzegowe „wymagają mniejszej przepustowości”, ponieważ większość danych pozostaje lokalnie.

W przeciwieństwie do tego, AI w chmurze wymaga ciągłych szybkich połączeń do przesyłania surowych danych tam i z powrotem. To sprawia, że Edge AI jest bardziej efektywne i tańsze w eksploatacji, gdy sieci są obciążone lub kosztowne. - Prywatność/Bezpieczeństwo: Edge AI może zwiększać prywatność. Wrażliwe dane (głos, obrazy, odczyty zdrowotne) mogą być przetwarzane i przechowywane na urządzeniu, nigdy nie przesyłane do chmury. To zmniejsza ryzyko naruszeń przez osoby trzecie.

Na przykład smartfon może rozpoznać Twarz lokalnie, bez przesyłania zdjęcia. W porównaniu, AI w chmurze często wymaga przesyłania danych osobowych na zewnętrzne serwery, co może zwiększać ryzyko bezpieczeństwa. - Zasoby obliczeniowe: Centra danych w chmurze dysponują praktycznie nieograniczoną mocą CPU/GPU, pozwalając na bardzo duże modele AI. Urządzenia brzegowe mają znacznie mniej mocy obliczeniowej i pamięci. Jak zauważa IBM, jednostki brzegowe są „ograniczone przez rozmiar urządzenia”.

Dlatego Edge AI często korzysta z zoptymalizowanych lub mniejszych modeli. W praktyce trenowanie dużych modeli zwykle odbywa się w chmurze, a na urządzenia brzegowe wdraża się tylko kompaktowe, skwantowane modele. - Niezawodność: Dzięki zmniejszeniu zależności od ciągłego połączenia, Edge AI może utrzymać krytyczne funkcje nawet przy braku sieci. Na przykład dron może nawigować za pomocą AI na pokładzie, gdy traci sygnał z bazy.

Krótko mówiąc, AI brzegowa i chmurowa się uzupełniają. Serwery w chmurze obsługują ciężkie treningi, archiwizację i analizy dużych zbiorów danych, podczas gdy Edge AI odpowiada za wnioskowanie w czasie rzeczywistym i szybkie decyzje blisko źródła danych.

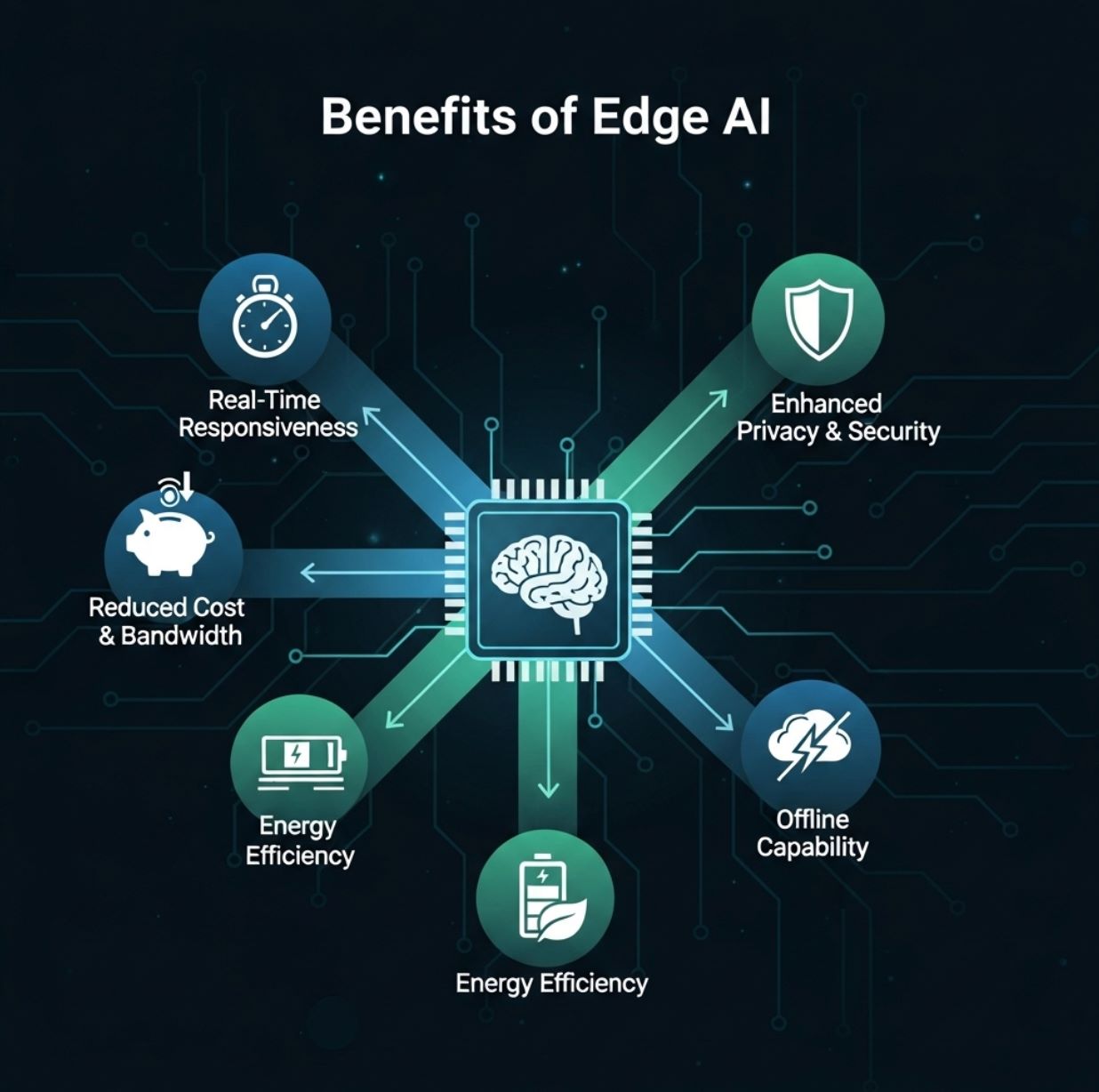

Zalety Edge AI

Edge AI oferuje użytkownikom i organizacjom kilka praktycznych korzyści:

- Reakcja w czasie rzeczywistym: Przetwarzanie danych lokalnie umożliwia natychmiastową analizę. Użytkownicy otrzymują błyskawiczną informację zwrotną (np. wykrywanie obiektów na żywo, odpowiedź głosowa, alert o anomalii) bez oczekiwania na przesłanie do chmury.

To niskie opóźnienie jest kluczowe dla zastosowań takich jak rzeczywistość rozszerzona, pojazdy autonomiczne i robotyka. - Zmniejszenie przepustowości i kosztów: Dzięki Edge AI tylko podsumowane wyniki lub nietypowe zdarzenia muszą być przesyłane przez internet. To znacznie obniża koszty transferu danych i przechowywania w chmurze.

Na przykład kamera bezpieczeństwa może przesyłać nagrania tylko wtedy, gdy wykryje potencjalne zagrożenie, zamiast ciągłego streamingu. - Zwiększona prywatność: Przechowywanie danych na urządzeniu poprawia bezpieczeństwo. Dane osobowe lub wrażliwe nigdy nie opuszczają lokalnego sprzętu, jeśli są przetwarzane na brzegu.

Jest to szczególnie ważne w zastosowaniach objętych surowymi przepisami o ochronie prywatności (np. opieka zdrowotna, finanse), ponieważ Edge AI może utrzymać dane w kraju lub w obrębie placówki. - Efektywność energetyczna i kosztowa: AI na urządzeniu może oszczędzać energię. Uruchamianie niewielkiego modelu na niskomocowym chipie często zużywa mniej energii niż przesyłanie danych do serwera w chmurze i z powrotem.

Zmniejsza to również koszty serwerów – duże obciążenia AI są kosztowne w chmurze. - Praca offline i odporność: Edge AI może działać nawet przy braku łączności. Urządzenia mogą funkcjonować dzięki lokalnej inteligencji, a następnie synchronizować się później.

To zwiększa odporność systemów, zwłaszcza w odległych lokalizacjach lub w zastosowaniach krytycznych (np. monitorowanie przemysłowe).

Red Hat i IBM podkreślają te zalety. Edge AI „przynosi możliwości wysokowydajnego przetwarzania na brzeg”, umożliwiając analizę w czasie rzeczywistym i zwiększoną efektywność.

Jak podsumowuje jeden z raportów, wdrożenia brzegowe obniżają opóźnienia i zapotrzebowanie na przepustowość, jednocześnie zwiększając prywatność i niezawodność.

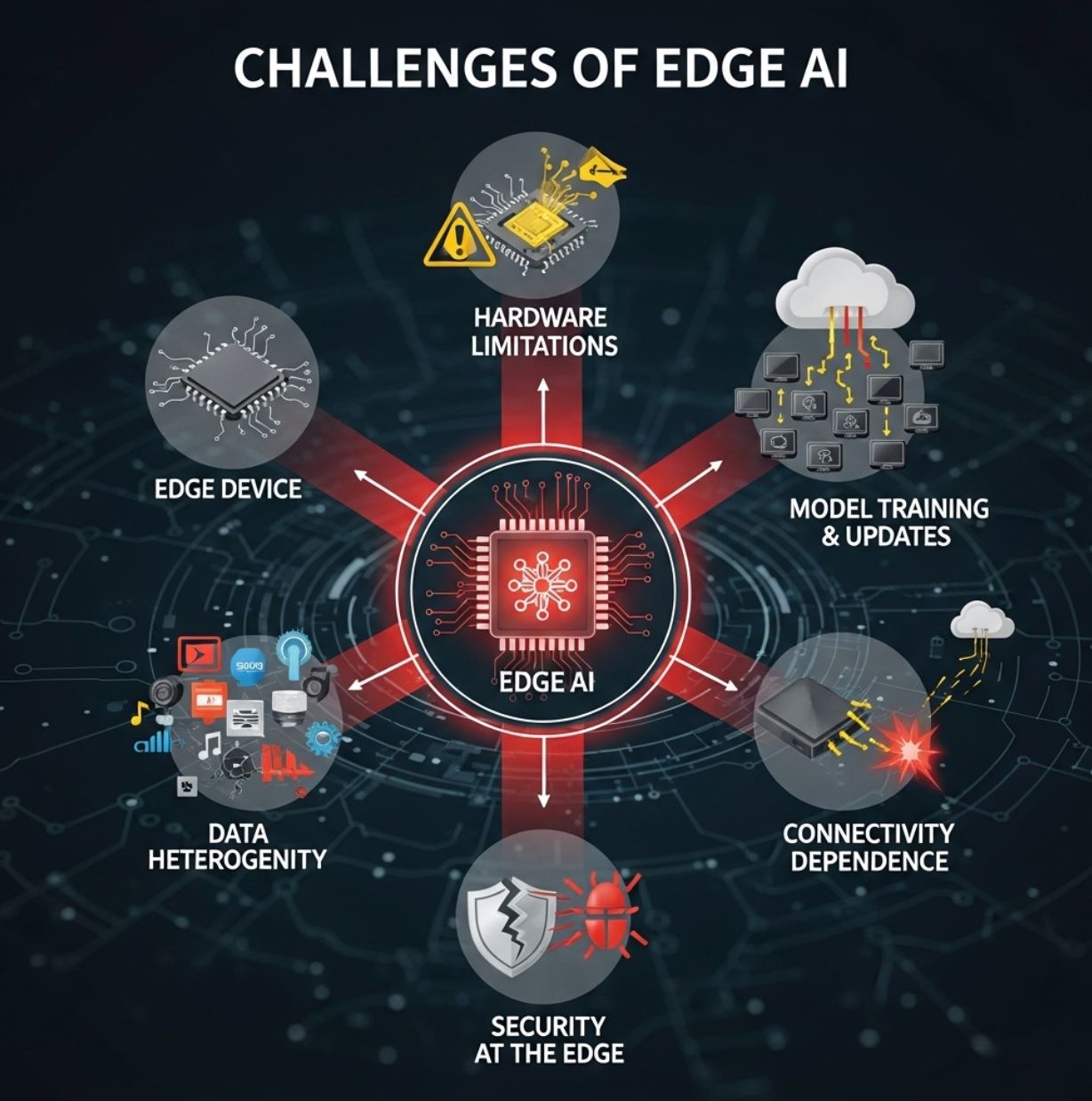

Wyzwania Edge AI

Pomimo zalet, Edge AI napotyka również na trudności:

- Ograniczenia sprzętowe: Urządzenia brzegowe są zazwyczaj małe i mają ograniczone zasoby. Mogą dysponować jedynie skromnymi procesorami CPU lub specjalistycznymi, niskomocowymi NPU oraz ograniczoną pamięcią.

To zmusza inżynierów AI do stosowania kompresji modeli, przycinania lub technik TinyML, aby dopasować modele do urządzenia. Złożone modele głębokiego uczenia często nie mogą działać w pełnej skali na mikrokontrolerze, więc pewna dokładność może zostać poświęcona. - Trening i aktualizacje modeli: Trening zaawansowanych modeli AI zwykle odbywa się w chmurze, gdzie dostępne są ogromne zasoby danych i mocy obliczeniowej. Po treningu modele muszą być zoptymalizowane (kwantyzacja, przycinanie itp.) i wdrożone na każde urządzenie brzegowe.

Utrzymanie aktualności tysięcy lub milionów urządzeń może być skomplikowane. Synchronizacja oprogramowania i danych zwiększa nakład zarządzania. - Grawitacja danych i heterogeniczność: Środowiska brzegowe są zróżnicowane. Różne lokalizacje mogą zbierać różne typy danych (czujniki różnią się w zależności od zastosowania), a polityki mogą się różnić regionalnie.

Integracja i standaryzacja tych danych jest wyzwaniem. Jak zauważa IBM, szerokie wdrożenie Edge AI wiąże się z problemami „grawitacji danych, heterogeniczności, skali i ograniczeń zasobów”. Innymi słowy, dane zwykle pozostają lokalnie, co utrudnia uzyskanie globalnego obrazu, a urządzenia występują w różnych formach i rozmiarach. - Bezpieczeństwo na brzegu: Chociaż Edge AI może poprawić prywatność, wprowadza też nowe zagrożenia bezpieczeństwa. Każde urządzenie lub węzeł jest potencjalnym celem dla hakerów.

Zabezpieczenie lokalnych modeli przed manipulacją oraz zapewnienie bezpieczeństwa oprogramowania wymaga silnych środków ochronnych. - Zależność od łączności w niektórych zadaniach: Chociaż wnioskowanie może odbywać się lokalnie, systemy brzegowe często nadal polegają na łączności z chmurą w przypadku ciężkich zadań, takich jak retrening modeli, analiza dużych zbiorów danych czy agregacja rozproszonych wyników.

Ograniczona łączność może spowalniać te funkcje zaplecza.

W praktyce większość rozwiązań stosuje model hybrydowy: urządzenia brzegowe obsługują wnioskowanie, a chmura zajmuje się treningiem, zarządzaniem modelami i analizą big data.

To równoważy ograniczenia zasobów i pozwala skalować Edge AI.

Zastosowania Edge AI

Edge AI znajduje zastosowanie w wielu branżach. Przykłady z życia codziennego to:

- Pojazdy autonomiczne: Samochody autonomiczne wykorzystują Edge AI na pokładzie do natychmiastowego przetwarzania danych z kamer i radarów w celu nawigacji i unikania przeszkód.

Nie mogą sobie pozwolić na opóźnienia związane z przesyłaniem wideo do serwera, więc wszystko (wykrywanie obiektów, rozpoznawanie pieszych, śledzenie pasa ruchu) odbywa się lokalnie. - Produkcja i Przemysł 4.0: Fabryki stosują inteligentne kamery i czujniki na liniach produkcyjnych do wykrywania wad lub anomalii w czasie rzeczywistym.

Na przykład kamera Edge AI może zauważyć wadliwy produkt na taśmie i natychmiast wywołać reakcję. Podobnie maszyny przemysłowe wykorzystują AI na miejscu do przewidywania awarii (predykcyjne utrzymanie ruchu) zanim do nich dojdzie. - Opieka zdrowotna i ratownictwo: Przenośne urządzenia medyczne i karetki korzystają z Edge AI do analizy danych pacjenta na miejscu.

Ultrasonograf lub monitor parametrów życiowych w ambulansie może natychmiast zastosować AI do wykrywania urazów wewnętrznych lub ostrzegania ratowników o nieprawidłowościach. W szpitalach Edge AI może ciągle monitorować pacjentów na OIOM i wywoływać alarmy bez oczekiwania na serwer centralny. - Inteligentne miasta: Systemy miejskie wykorzystują Edge AI do zarządzania ruchem, nadzoru i monitoringu środowiska.

Inteligentne sygnalizacje świetlne dostosowują czas działania dzięki lokalnej AI analizującej obraz z kamer, co zmniejsza korki w czasie rzeczywistym. Kamery uliczne wykrywają incydenty (wypadki, pożary) i natychmiast powiadamiają służby. Przetwarzanie lokalne pozwala miastom szybko reagować bez przeciążania sieci centralnych. - Handel detaliczny i IoT konsumencki: Edge AI poprawia doświadczenia klientów i wygodę.

W sklepach inteligentne kamery lub czujniki na półkach wykorzystują AI do śledzenia zachowań klientów i poziomu zapasów na bieżąco. W domu smartfony, tablety i inteligentne głośniki realizują rozpoznawanie głosu lub twarzy lokalnie. Na przykład smartfon może odblokować się lub rozpoznać gesty bez dostępu do chmury. Opaski fitness analizują dane zdrowotne (tętno, kroki) lokalnie, dostarczając natychmiastową informację zwrotną.

Inne rozwijające się zastosowania to precyzyjne rolnictwo (drony i czujniki wykorzystujące Edge AI do monitorowania gleby i zdrowia upraw) oraz systemy bezpieczeństwa (lokalne rozpoznawanie twarzy do zamków). Jak zauważa jedno z badań IEEE, Edge AI jest kluczowe dla takich zastosowań jak inteligentne rolnictwo, kontrola ruchu i automatyzacja przemysłowa.

Krótko mówiąc, każde zastosowanie, które korzysta z natychmiastowej, lokalnej analizy, jest doskonałym kandydatem dla Edge AI.

Technologie i trendy wspierające

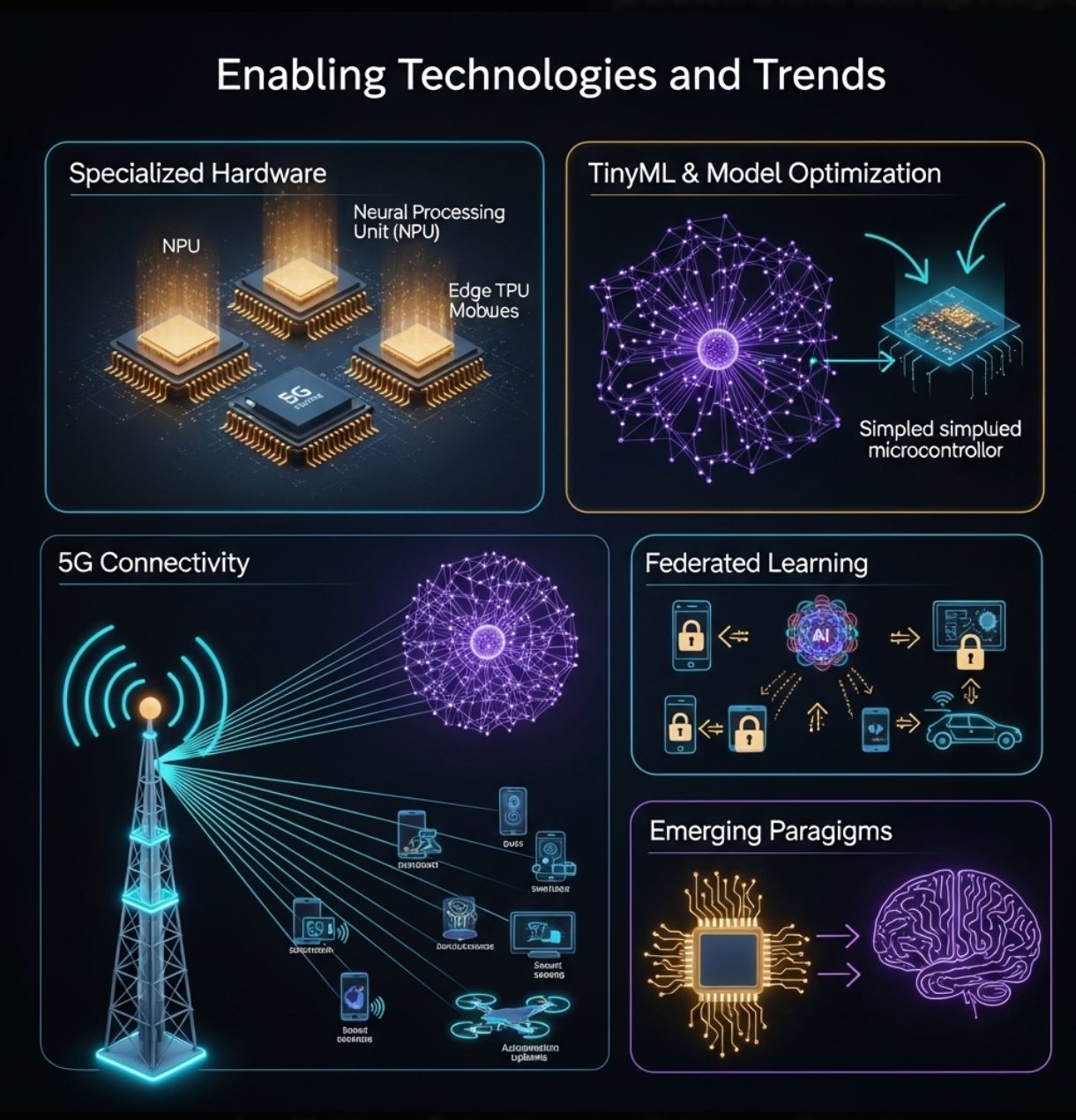

Rozwój Edge AI napędzają postępy zarówno w sprzęcie, jak i oprogramowaniu:

- Specjalistyczny sprzęt: Producenci tworzą układy zaprojektowane do wnioskowania na brzegu. Należą do nich niskomocowe akceleratory neuronowe w smartfonach (NPU) oraz dedykowane moduły Edge AI, takie jak Google Coral Edge TPU, NVIDIA Jetson Nano i tanie płytki mikrokontrolerów (Arduino, Raspberry Pi z dodatkami AI).

Ostatni raport branżowy wskazuje, że postęp w ultraniskomocowych procesorach i algorytmach „native edge” przełamuje ograniczenia sprzętowe urządzeń. - TinyML i optymalizacja modeli: Narzędzia takie jak TensorFlow Lite oraz techniki przycinania modeli, kwantyzacji i destylacji umożliwiają zmniejszenie sieci neuronowych tak, by zmieściły się na malutkich urządzeniach.

„TinyML” to rozwijająca się dziedzina skupiona na uruchamianiu ML na mikrokontrolerach. Podejścia te rozszerzają AI na czujniki i urządzenia noszone zasilane bateriami. - 5G i łączność: Sieci nowej generacji (5G i kolejne) oferują wysoką przepustowość i niskie opóźnienia, które uzupełniają Edge AI.

Szybkie sieci lokalne ułatwiają koordynację klastrów urządzeń brzegowych i odciążanie cięższych zadań, gdy jest to potrzebne. Ta synergia 5G i AI umożliwia nowe zastosowania (np. inteligentne fabryki, komunikację pojazdów z otoczeniem). - Uczenie federacyjne i współpraca: Metody chroniące prywatność, takie jak uczenie federacyjne, pozwalają wielu urządzeniom brzegowym wspólnie trenować model bez udostępniania surowych danych.

Każde urządzenie poprawia model lokalnie i dzieli się tylko aktualizacjami. Ten trend (wskazywany w przyszłych planach technologicznych) wzmocni Edge AI, wykorzystując rozproszone dane przy zachowaniu prywatności. - Nowe paradygmaty: Patrząc w przyszłość, badania eksplorują neuromorficzne przetwarzanie i generatywną AI na urządzeniach, by jeszcze bardziej zwiększyć inteligencję na brzegu.

Jak przewiduje jeden z raportów, innowacje takie jak chipy inspirowane mózgiem i lokalne modele językowe mogą pojawić się na brzegu.

Te technologie nieustannie przesuwają granice możliwości Edge AI. Razem pomagają dostarczyć „erę wnioskowania AI” – przesuwając inteligencję bliżej użytkowników i czujników.

>>> Może Cię zainteresować:

Czym jest Generatywna Sztuczna Inteligencja?

Czym jest uczenie ze wzmocnieniem?

Edge AI zmienia sposób wykorzystania sztucznej inteligencji, przenosząc obliczenia bliżej źródła danych. Uzupełnia AI w chmurze, dostarczając szybszą, bardziej efektywną i bardziej prywatną analizę na lokalnych urządzeniach.

Takie podejście rozwiązuje wyzwania związane z czasem rzeczywistym i przepustowością, charakterystyczne dla architektur opartych na chmurze. W praktyce Edge AI napędza szeroką gamę nowoczesnych technologii – od inteligentnych czujników i fabryk po drony i samochody autonomiczne – umożliwiając inteligencję na miejscu.

Wraz z rosnącą liczbą urządzeń IoT i rozwojem sieci, Edge AI będzie się tylko rozwijać. Postępy w sprzęcie (wydajne mikroprocesory, TinyML) i technikach (uczenie federacyjne, optymalizacja modeli) ułatwiają wdrażanie AI wszędzie.

Eksperci podkreślają, że Edge AI przynosi znaczące korzyści w zakresie efektywności, prywatności i wykorzystania przepustowości. Krótko mówiąc, Edge AI to przyszłość wbudowanej inteligencji – oferująca najlepsze cechy AI w rozproszonej, lokalnej formie.