Edge AI (a volte chiamata “AI ai margini”) significa eseguire modelli di intelligenza artificiale e machine learning su dispositivi locali (sensori, telecamere, smartphone, gateway industriali, ecc.) anziché in data center remoti. In altre parole, il “margine” della rete – dove i dati vengono generati – gestisce l’elaborazione. Questo permette ai dispositivi di analizzare i dati immediatamente mentre vengono raccolti, invece di inviare continuamente dati grezzi al cloud.

Come spiega IBM, Edge AI consente l’elaborazione in tempo reale direttamente sul dispositivo senza dipendere da un server centrale. Per esempio, una telecamera con Edge AI può rilevare e classificare oggetti al volo, fornendo un feedback istantaneo. Elaborando i dati localmente, Edge AI può funzionare anche con connessioni internet intermittenti o assenti.

Secondo i rapporti di settore, questo cambiamento sta avvenendo rapidamente: la spesa globale per l’edge computing ha raggiunto circa 232 miliardi di dollari nel 2024 (in crescita del 15% rispetto al 2023), trainata principalmente dalla crescita dell’IoT potenziato dall’AI.

In sintesi, Edge AI avvicina semplicemente il calcolo alla fonte dei dati – distribuendo l’intelligenza su dispositivi o nodi vicini, accelerando le risposte e riducendo la necessità di trasmettere tutto al cloud.

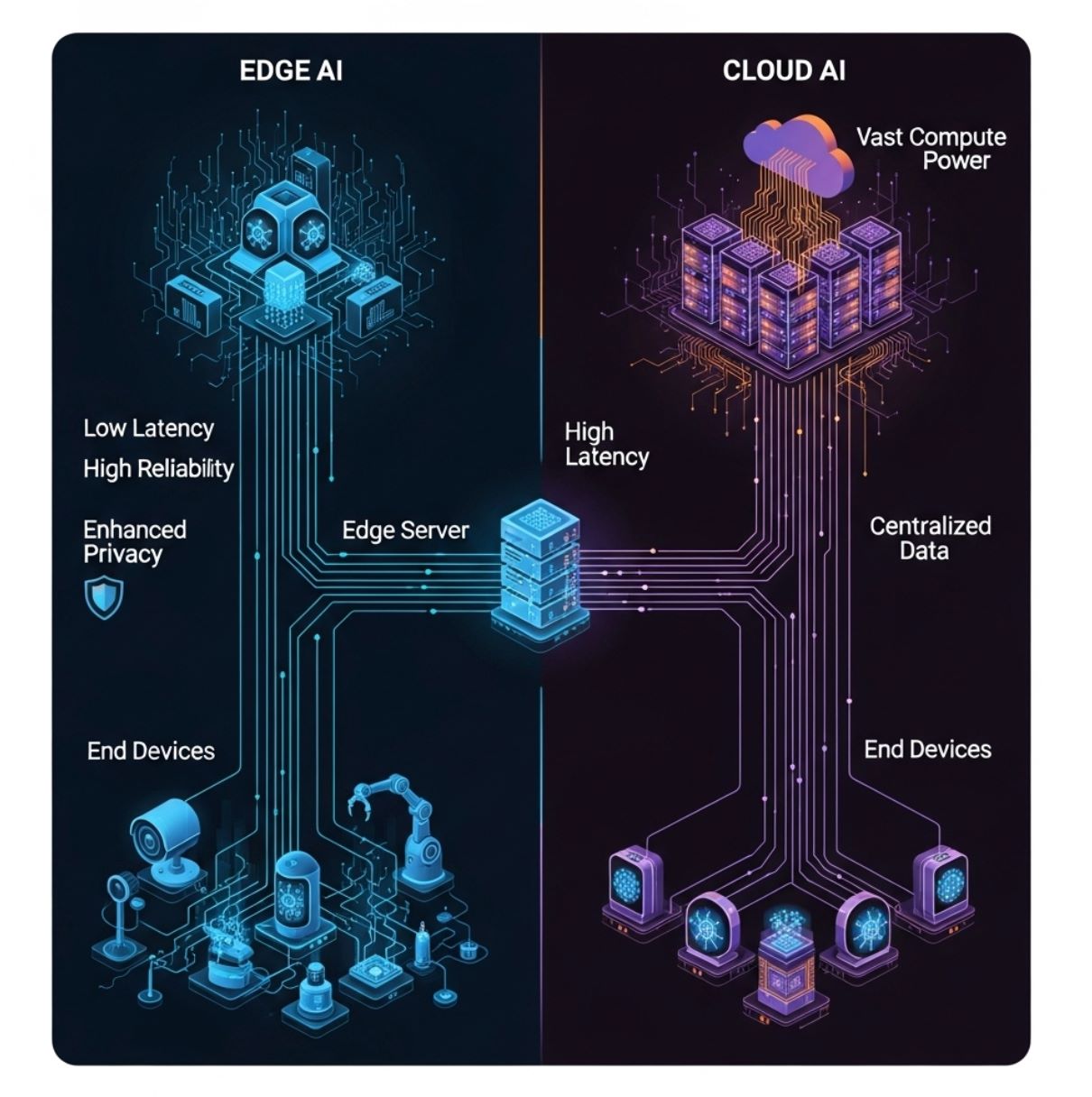

Edge AI vs Cloud AI: Differenze Chiave

A differenza dell’AI tradizionale basata sul cloud (che invia tutti i dati a server centralizzati), Edge AI distribuisce l’elaborazione tra hardware locale. Il diagramma sopra illustra un modello semplice di edge computing: i dispositivi finali (livello inferiore) inviano dati a un server o gateway edge (livello intermedio) invece che solo al cloud distante (livello superiore).

In questa configurazione, l’inferenza AI può avvenire sul dispositivo o sul nodo edge locale, riducendo notevolmente i ritardi di comunicazione.

- Latenza: Edge AI minimizza i ritardi. Poiché l’elaborazione è locale, le decisioni possono avvenire in millisecondi. IBM sottolinea che l’inferenza basata su edge “fornisce una latenza ridotta elaborando i dati direttamente sul dispositivo,” mentre l’AI cloud comporta ritardi aggiuntivi per l’invio dei dati da e verso server remoti.

Questo è fondamentale per compiti sensibili al tempo (es. evitare incidenti stradali o controllare un robot). - Banda: Edge AI riduce il carico di rete. Analizzando o filtrando i dati in loco, si invia molto meno traffico a monte. IBM spiega che i sistemi edge “richiedono una banda inferiore” poiché la maggior parte dei dati rimane locale.

Al contrario, l’AI cloud necessita di connessioni ad alta velocità continue per trasferire dati grezzi avanti e indietro. Questo rende Edge AI più efficiente e meno costosa da gestire quando le reti sono congestionate o costose. - Privacy/Sicurezza: Edge AI può migliorare la privacy. Dati sensibili (voce, immagini, parametri sanitari) possono essere elaborati e archiviati sul dispositivo, senza mai essere trasmessi al cloud. Questo riduce l’esposizione a violazioni da terze parti.

Per esempio, uno smartphone può riconoscere il volto localmente senza caricare la foto. Al contrario, l’AI cloud spesso implica l’invio di dati personali a server esterni, aumentando i rischi di sicurezza. - Risorse di calcolo: I data center cloud dispongono di potenza CPU/GPU praticamente illimitata, permettendo modelli AI molto grandi. I dispositivi edge hanno capacità di elaborazione e memoria molto più limitate. Come nota IBM, le unità edge sono “vincolate dalle dimensioni del dispositivo”.

Perciò, Edge AI utilizza spesso modelli ottimizzati o più piccoli. In pratica, l’addestramento di modelli pesanti avviene ancora nel cloud, mentre solo modelli compatti e quantizzati vengono distribuiti ai dispositivi edge. - Affidabilità: Riducendo la dipendenza dalla connettività continua, Edge AI può mantenere funzioni critiche anche in caso di interruzione della rete. Un drone, per esempio, può navigare usando AI a bordo quando perde il segnale con la base.

In breve, edge e cloud AI si completano a vicenda. I server cloud gestiscono l’addestramento pesante, l’archiviazione e l’analisi di grandi volumi, mentre Edge AI si occupa dell’inferenza in tempo reale e delle decisioni rapide vicino ai dati.

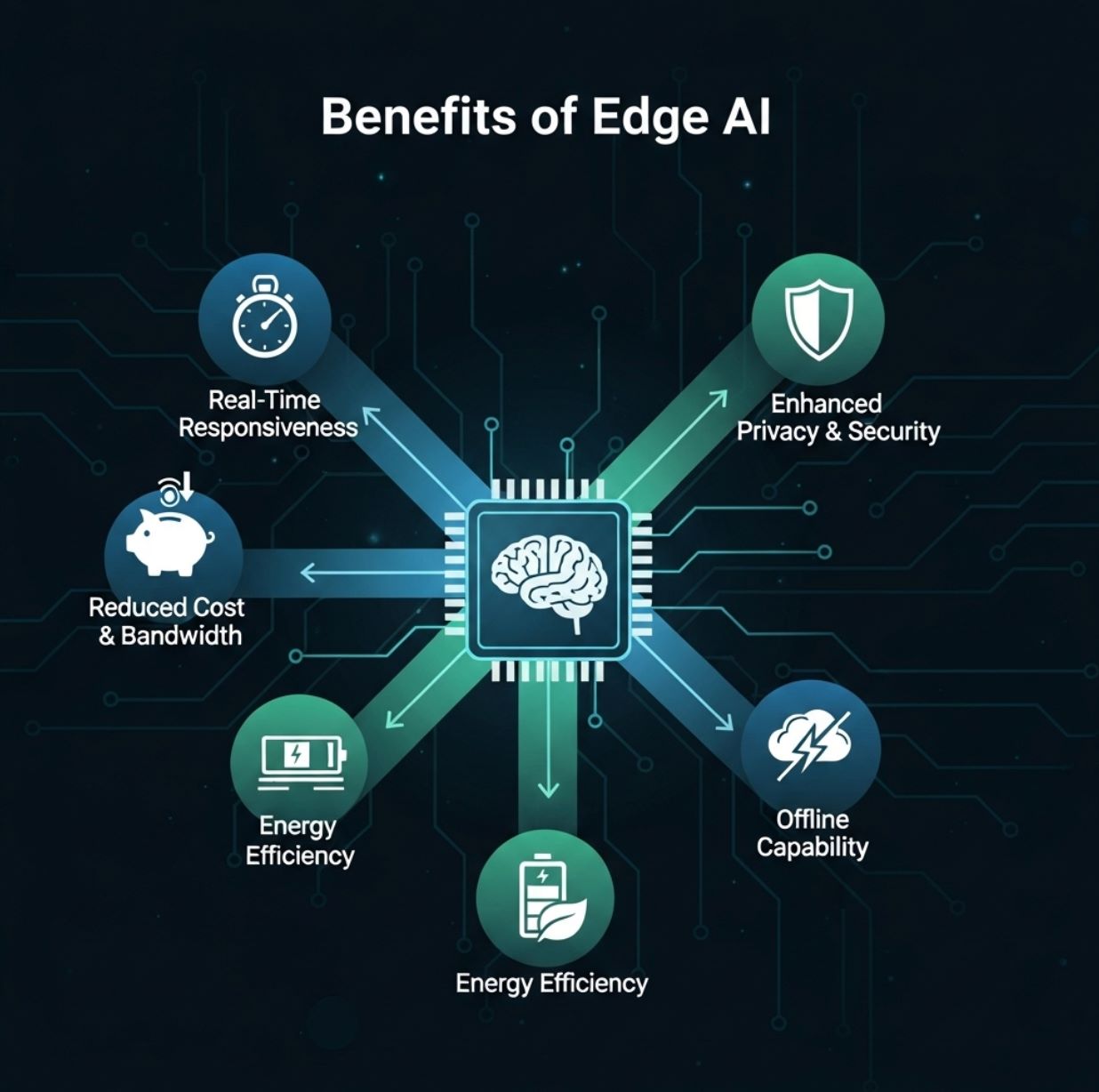

Vantaggi di Edge AI

Edge AI offre diversi vantaggi pratici per utenti e organizzazioni:

- Reattività in tempo reale: Elaborare i dati localmente consente un’analisi immediata. Gli utenti ricevono feedback istantanei (es. rilevamento oggetti live, risposta vocale, allerta anomalie) senza attendere il viaggio di andata e ritorno verso il cloud.

Questa bassa latenza è un grande vantaggio per applicazioni come realtà aumentata, veicoli autonomi e robotica. - Riduzione di banda e costi: Con Edge AI, solo risultati sintetici o eventi insoliti devono essere inviati via internet. Questo riduce drasticamente i costi di trasferimento dati e archiviazione cloud.

Per esempio, una telecamera di sicurezza potrebbe caricare solo clip quando rileva una minaccia potenziale, invece di trasmettere continuamente. - Privacy migliorata: Mantenere i dati sul dispositivo aumenta la sicurezza. Informazioni personali o sensibili non lasciano mai l’hardware locale se elaborate al margine.

Questo è particolarmente importante per applicazioni soggette a rigide normative sulla privacy (sanità, finanza, ecc.), poiché Edge AI può mantenere i dati all’interno di un paese o struttura. - Efficienza energetica e di costo: L’AI su dispositivo può risparmiare energia. Eseguire un modello leggero su un chip a basso consumo spesso consuma meno energia che inviare dati a un server cloud e ricevere risposte.

Riduce anche i costi dei server – i carichi AI pesanti sono costosi da ospitare nel cloud. - Funzionamento offline e resilienza: Edge AI può continuare a funzionare anche in assenza di connettività. I dispositivi possono operare con intelligenza locale e sincronizzarsi successivamente.

Questo rende i sistemi più robusti, specialmente in aree remote o in usi critici (es. monitoraggio industriale).

Red Hat e IBM evidenziano entrambi questi vantaggi. Edge AI “porta capacità di calcolo ad alte prestazioni al margine,” abilitando analisi in tempo reale e maggiore efficienza.

Come riassume un rapporto, le implementazioni edge riducono latenza e necessità di banda aumentando privacy e affidabilità.

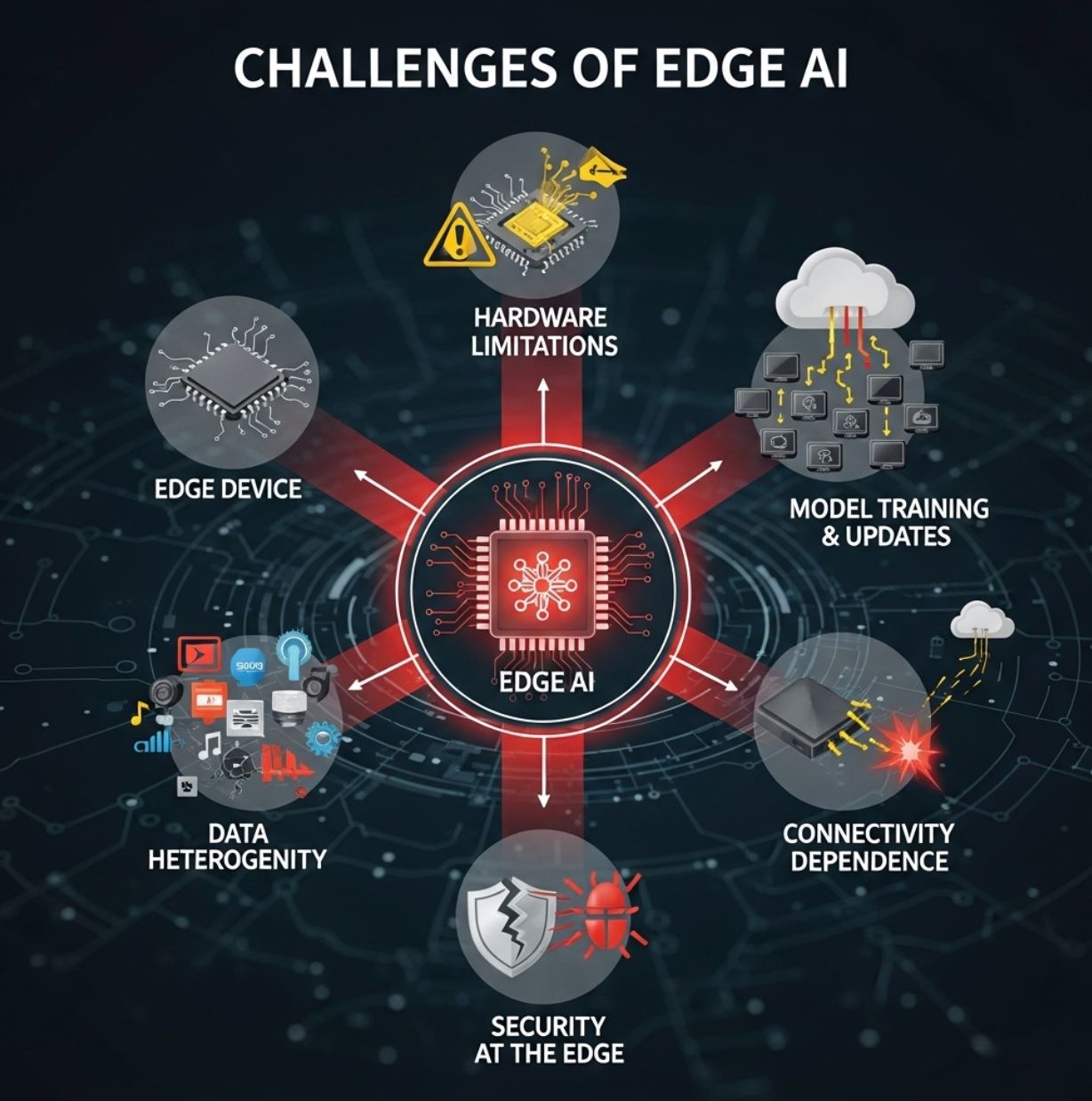

Sfide di Edge AI

Nonostante i vantaggi, Edge AI presenta anche delle sfide:

- Limitazioni hardware: I dispositivi edge sono tipicamente piccoli e con risorse limitate. Possono avere solo CPU modeste o NPU a basso consumo specializzate, e memoria limitata.

Questo costringe gli ingegneri AI a usare tecniche di compressione, potatura o TinyML per adattare i modelli al dispositivo. Modelli di deep learning complessi spesso non possono girare a pieno regime su microcontrollori, quindi si può sacrificare un po’ di accuratezza. - Addestramento e aggiornamenti dei modelli: L’addestramento di modelli AI sofisticati avviene solitamente nel cloud, dove sono disponibili grandi quantità di dati e potenza di calcolo. Dopo l’addestramento, i modelli devono essere ottimizzati (quantizzati, potati, ecc.) e distribuiti a ogni dispositivo edge.

Mantenere aggiornati migliaia o milioni di dispositivi può essere complesso. Firmware e sincronizzazione dati aggiungono complessità gestionale. - Gravità e eterogeneità dei dati: Gli ambienti edge sono molto diversi. Diverse località possono raccogliere tipi di dati differenti (i sensori variano per applicazione), e le politiche possono differire per regione.

Integrare e standardizzare tutti questi dati è una sfida. Come nota IBM, la diffusione di Edge AI solleva problemi di “gravità dei dati, eterogeneità, scala e vincoli di risorse”. In altre parole, i dati tendono a rimanere locali, rendendo difficile avere una visione globale, e i dispositivi sono molto vari. - Sicurezza al margine: Sebbene Edge AI possa migliorare la privacy, introduce anche nuove preoccupazioni di sicurezza. Ogni dispositivo o nodo è un potenziale bersaglio per hacker.

Garantire che i modelli locali siano a prova di manomissione e che il firmware sia sicuro richiede protezioni robuste. - Dipendenza dalla connettività per alcune attività: Anche se l’inferenza può essere locale, i sistemi edge spesso dipendono ancora dalla connettività cloud per compiti pesanti come il riaddestramento dei modelli, l’analisi dati su larga scala o l’aggregazione dei risultati distribuiti.

La connettività limitata può creare colli di bottiglia in queste funzioni di back-office.

In pratica, la maggior parte delle soluzioni utilizza un modello ibrido: i dispositivi edge gestiscono l’inferenza, mentre il cloud si occupa di addestramento, gestione dei modelli e analisi big data.

Questo equilibrio aiuta a superare i limiti di risorse e permette a Edge AI di scalare.

Casi d’uso di Edge AI

Edge AI viene applicata in molti settori. Esempi concreti includono:

- Veicoli autonomi: Le auto a guida autonoma usano Edge AI a bordo per elaborare istantaneamente dati da telecamere e radar per la navigazione e l’evitamento ostacoli.

Non possono permettersi il ritardo di inviare video a un server, quindi tutto (rilevamento oggetti, riconoscimento pedoni, tracciamento corsie) avviene localmente. - Manifattura e Industria 4.0: Le fabbriche impiegano telecamere intelligenti e sensori sulle linee di produzione per rilevare difetti o anomalie in tempo reale.

Per esempio, una telecamera Edge AI può individuare un prodotto difettoso sul nastro trasportatore e attivare un’azione immediata. Allo stesso modo, le macchine industriali usano AI locale per prevedere guasti (manutenzione predittiva) prima che si verifichino rotture. - Sanità e Pronto Soccorso: Dispositivi medici portatili e ambulanze ora usano Edge AI per analizzare i dati del paziente sul posto.

L’ecografo o il monitor dei segni vitali a bordo di un’ambulanza possono applicare AI istantaneamente per rilevare lesioni interne o avvisare i paramedici di anomalie. Negli ospedali, Edge AI può monitorare continuamente i pazienti in terapia intensiva e attivare allarmi senza attendere un server centrale. - Città intelligenti: I sistemi urbani usano Edge AI per la gestione del traffico, la sorveglianza e il monitoraggio ambientale.

I semafori intelligenti regolano i tempi usando AI locale che analizza i flussi video, alleviando la congestione in tempo reale. Le telecamere stradali possono rilevare incidenti (incidenti, incendi) e avvisare immediatamente le autorità. Mantenendo l’elaborazione locale, le città possono reagire rapidamente senza sovraccaricare le reti centrali. - Retail e IoT per consumatori: Edge AI migliora l’esperienza cliente e la comodità.

Nei negozi, telecamere intelligenti o sensori sugli scaffali usano AI per tracciare il comportamento degli acquirenti e i livelli di inventario istantaneamente. A casa, smartphone, tablet e speaker intelligenti eseguono riconoscimento vocale o facciale sul dispositivo. Per esempio, uno smartphone può sbloccare o riconoscere gesti senza accesso al cloud. I fitness tracker analizzano dati sanitari (battito cardiaco, passi) localmente per fornire feedback in tempo reale.

Altri usi emergenti includono agricoltura di precisione (droni e sensori che usano Edge AI per monitorare il suolo e la salute delle colture) e sistemi di sicurezza (riconoscimento facciale su dispositivo per serrature). Come evidenzia uno studio IEEE, Edge AI è cruciale per applicazioni come agricoltura intelligente, controllo del traffico e automazione industriale.

In sintesi, qualsiasi scenario che beneficia di analisi istantanea e locale è un candidato ideale per Edge AI.

Tecnologie abilitanti e tendenze

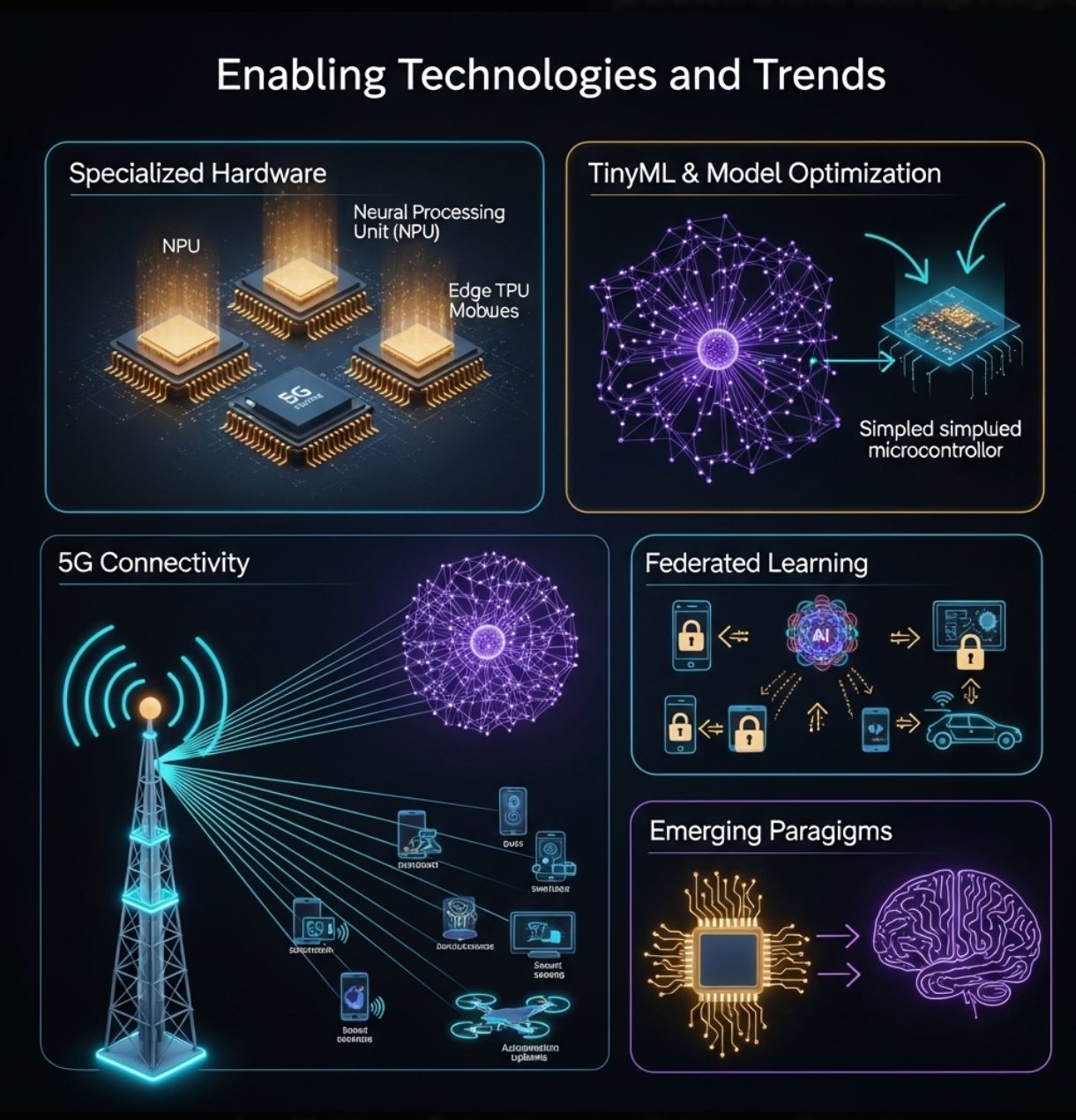

La crescita di Edge AI è alimentata dai progressi sia hardware che software:

- Hardware specializzato: I produttori stanno realizzando chip progettati per l’inferenza edge. Questi includono acceleratori neurali a basso consumo negli smartphone (NPU) e moduli AI edge dedicati come Google Coral Edge TPU, NVIDIA Jetson Nano e schede microcontrollore a basso costo (Arduino, Raspberry Pi con componenti AI).

Un recente rapporto di settore evidenzia che i progressi nei processori ultra a basso consumo e negli algoritmi “nativi edge” stanno superando i limiti dell’hardware dei dispositivi. - TinyML e ottimizzazione dei modelli: Strumenti come TensorFlow Lite e tecniche quali potatura, quantizzazione e distillazione permettono di ridurre le reti neurali per adattarle a dispositivi minuscoli.

“TinyML” è un campo emergente focalizzato sull’esecuzione di ML su microcontrollori. Questi approcci estendono l’AI a sensori e dispositivi indossabili alimentati a batteria. - 5G e connettività: Le reti wireless di nuova generazione (5G e oltre) offrono alta banda e bassa latenza che completano Edge AI.

Reti locali veloci facilitano il coordinamento di cluster di dispositivi edge e lo scarico di compiti più pesanti quando necessario. Questa sinergia tra 5G e AI abilita nuove applicazioni (es. fabbriche intelligenti, comunicazione veicolo-tutto). - Apprendimento federato e collaborativo: Metodi che preservano la privacy come il federated learning permettono a più dispositivi edge di addestrare congiuntamente un modello senza condividere dati grezzi.

Ogni dispositivo migliora il modello localmente e condivide solo aggiornamenti. Questa tendenza (anticipata nelle roadmap tecnologiche future) potenzierà Edge AI sfruttando dati distribuiti mantenendoli privati. - Paradigmi emergenti: Guardando avanti, la ricerca esplora il calcolo neuromorfico e l’AI generativa su dispositivo per aumentare ulteriormente l’intelligenza al margine.

Come prevede un rapporto, innovazioni come chip ispirati al cervello e modelli linguistici di grandi dimensioni locali potrebbero comparire all’edge.

Queste tecnologie continuano a spingere i confini di ciò che Edge AI può fare. Insieme, aiutano a realizzare l’“era dell’inferenza AI” – spostando l’intelligenza più vicino agli utenti e ai sensori.

>>> Potrebbe interessarLe:

Cos’è l’Intelligenza Artificiale Generativa?

Cos’è l’Apprendimento per Rinforzo?

Edge AI sta trasformando il modo in cui utilizziamo l’intelligenza artificiale spostando il calcolo alla fonte dei dati. Complementa l’AI cloud, offrendo analisi più rapide, efficienti e riservate su dispositivi locali.

Questo approccio affronta le sfide in tempo reale e di banda insite nelle architetture cloud-centriche. In pratica, Edge AI alimenta un’ampia gamma di tecnologie moderne – da sensori intelligenti e fabbriche a droni e auto a guida autonoma – abilitando intelligenza immediata.

Con la proliferazione dei dispositivi IoT e il miglioramento delle reti, Edge AI è destinata a crescere ulteriormente. I progressi hardware (microchip potenti, TinyML) e le tecniche (apprendimento federato, ottimizzazione modelli) rendono più semplice portare l’AI ovunque.

Secondo gli esperti, Edge AI apporta notevoli vantaggi in efficienza, privacy e uso della banda. In sintesi, Edge AI è il futuro dell’intelligenza integrata – offrendo il meglio dell’AI in forma distribuita e su dispositivo.