Edge AI (parfois appelée « IA en périphérie ») désigne l’exécution de modèles d’intelligence artificielle et d’apprentissage automatique sur des appareils locaux (capteurs, caméras, smartphones, passerelles industrielles, etc.) plutôt que dans des centres de données distants. En d’autres termes, le « bord » du réseau – là où les données sont générées – prend en charge le calcul. Cela permet aux appareils d’analyser les données immédiatement dès leur collecte, au lieu d’envoyer constamment des données brutes vers le cloud.

Comme l’explique IBM, l’Edge AI permet un traitement en temps réel directement sur l’appareil sans dépendre d’un serveur central. Par exemple, une caméra équipée d’Edge AI peut détecter et classifier des objets instantanément, fournissant un retour immédiat. En traitant les données localement, l’Edge AI peut fonctionner même avec une connexion internet intermittente ou absente.

Selon les rapports industriels, cette évolution s’accélère : les dépenses mondiales en informatique en périphérie ont atteint environ 232 milliards de dollars en 2024 (en hausse de 15 % par rapport à 2023), principalement grâce à la croissance de l’IoT alimenté par l’IA.

En résumé, l’Edge AI rapproche simplement le calcul de la source des données – en déployant l’intelligence sur les appareils ou les nœuds proches, ce qui accélère les réponses et réduit la nécessité de tout transmettre au cloud.

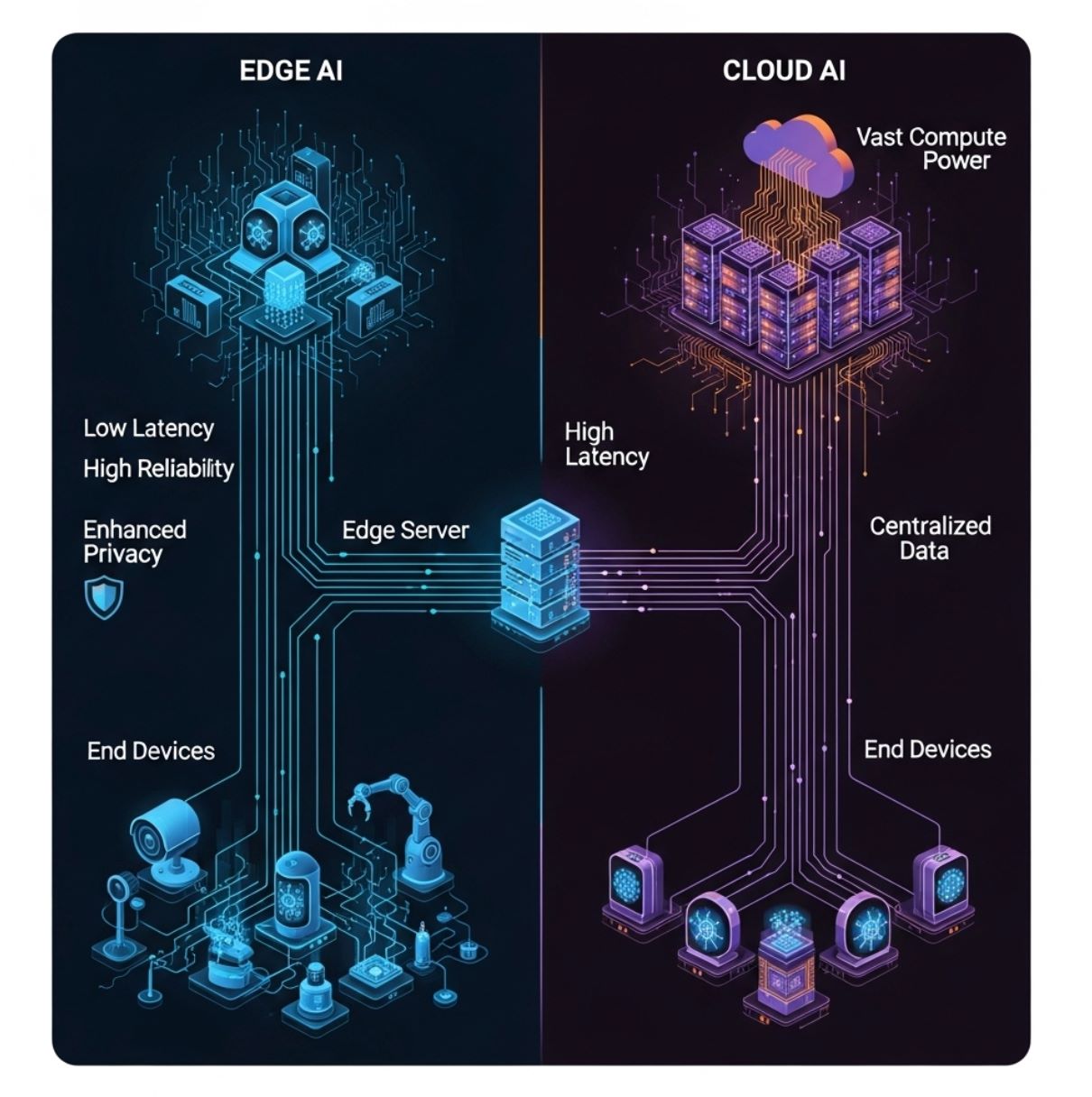

Edge AI vs IA Cloud : différences clés

Contrairement à l’IA traditionnelle basée sur le cloud (qui envoie toutes les données vers des serveurs centralisés), l’Edge AI répartit le calcul entre le matériel sur site. Le schéma ci-dessus illustre un modèle simple d’informatique en périphérie : les appareils finaux (couche inférieure) alimentent un serveur ou une passerelle en périphérie (couche intermédiaire) au lieu d’envoyer uniquement vers le cloud distant (couche supérieure).

Dans cette configuration, l’inférence IA peut se faire sur l’appareil ou le nœud local, réduisant considérablement les délais de communication.

- Latence : L’Edge AI minimise les délais. Comme le traitement est local, les décisions peuvent être prises en millisecondes. IBM souligne que l’inférence en périphérie « réduit la latence en traitant les données directement sur l’appareil », alors que l’IA cloud engendre un délai supplémentaire lié à l’envoi des données vers des serveurs distants.

Cela est crucial pour les tâches sensibles au temps (par exemple éviter un accident de voiture ou contrôler un robot). - Bande passante : L’Edge AI réduit la charge réseau. En analysant ou filtrant les données sur place, beaucoup moins d’informations doivent être envoyées en amont. IBM explique que les systèmes en périphérie « nécessitent une bande passante plus faible » puisque la plupart des données restent locales.

En revanche, l’IA cloud exige des connexions haut débit continues pour transférer les données brutes. Cela rend l’Edge AI plus efficace et moins coûteuse à exploiter lorsque les réseaux sont saturés ou onéreux. - Confidentialité/Sécurité : L’Edge AI peut renforcer la confidentialité. Les données sensibles (voix, images, relevés de santé) peuvent être traitées et stockées sur l’appareil, sans jamais être transmises au cloud. Cela réduit les risques d’exposition à des violations par des tiers.

Par exemple, un smartphone peut reconnaître votre visage localement sans télécharger votre photo. En comparaison, l’IA cloud implique souvent l’envoi de données personnelles vers des serveurs externes, ce qui peut poser des risques de sécurité. - Ressources de calcul : Les centres de données cloud disposent d’une puissance CPU/GPU quasi illimitée, permettant des modèles IA très volumineux. Les appareils en périphérie ont beaucoup moins de capacité de traitement et de stockage. Comme le note IBM, les unités en périphérie sont « limitées par les contraintes de taille de l’appareil ».

Par conséquent, l’Edge AI utilise souvent des modèles optimisés ou plus petits. En pratique, l’entraînement de modèles lourds se fait généralement dans le cloud, et seuls des modèles compacts et quantifiés sont déployés sur les appareils en périphérie. - Fiabilité : En réduisant la dépendance à une connectivité continue, l’Edge AI peut maintenir les fonctions critiques même en cas de panne réseau. Un drone, par exemple, peut naviguer grâce à l’IA embarquée lorsqu’il perd le signal avec la base.

En bref, l’Edge AI et l’IA cloud se complètent. Les serveurs cloud gèrent l’entraînement intensif, l’archivage et l’analyse de gros volumes, tandis que l’Edge AI prend en charge l’inférence en temps réel et les décisions rapides proches des données.

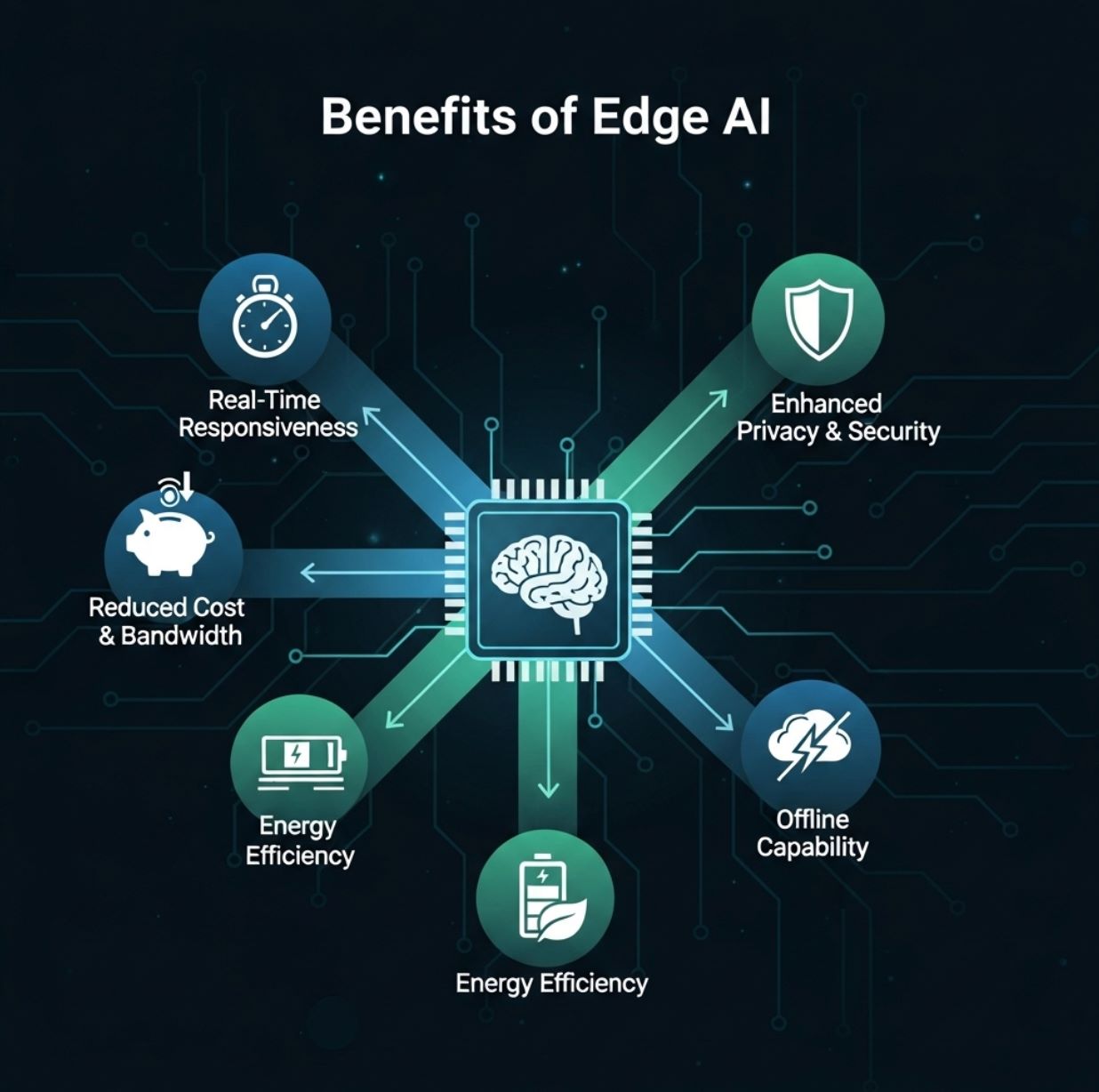

Avantages de l’Edge AI

L’Edge AI offre plusieurs avantages concrets pour les utilisateurs et les organisations :

- Réactivité en temps réel : Le traitement local des données permet une analyse immédiate. Les utilisateurs reçoivent un retour instantané (par exemple détection d’objets en direct, réponse vocale, alerte d’anomalie) sans attendre un aller-retour vers le cloud.

Cette faible latence est un atout majeur pour des applications comme la réalité augmentée, les véhicules autonomes et la robotique. - Réduction de la bande passante et des coûts : Avec l’Edge AI, seuls les résultats résumés ou événements inhabituels doivent être envoyés via internet. Cela réduit considérablement les coûts de transfert de données et de stockage cloud.

Par exemple, une caméra de sécurité peut ne télécharger que des extraits lorsqu’elle détecte une menace potentielle, au lieu de diffuser en continu. - Confidentialité renforcée : Conserver les données sur l’appareil améliore la sécurité. Les informations personnelles ou sensibles ne quittent jamais le matériel local si elles sont traitées en périphérie.

Cela est particulièrement important pour les applications soumises à des règles strictes de confidentialité (santé, finance, etc.), car l’Edge AI peut maintenir les données dans un pays ou un établissement. - Efficacité énergétique et économique : L’IA embarquée peut économiser de l’énergie. Exécuter un modèle léger sur une puce basse consommation utilise souvent moins d’énergie que d’envoyer les données vers un serveur cloud et en retour.

Elle réduit aussi les coûts serveurs – les charges lourdes d’IA sont coûteuses à héberger dans le cloud. - Fonctionnement hors ligne et résilience : L’Edge AI peut continuer à fonctionner en cas de coupure de connexion. Les appareils restent opérationnels grâce à l’intelligence locale, puis se synchronisent ultérieurement.

Cela rend les systèmes plus robustes, notamment dans les zones isolées ou pour des usages critiques (par exemple surveillance industrielle).

Red Hat et IBM soulignent ces bénéfices. L’Edge AI « apporte des capacités de calcul haute performance en périphérie », permettant une analyse en temps réel et une meilleure efficacité.

Comme le résume un rapport, les déploiements en périphérie réduisent la latence et les besoins en bande passante tout en renforçant la confidentialité et la fiabilité.

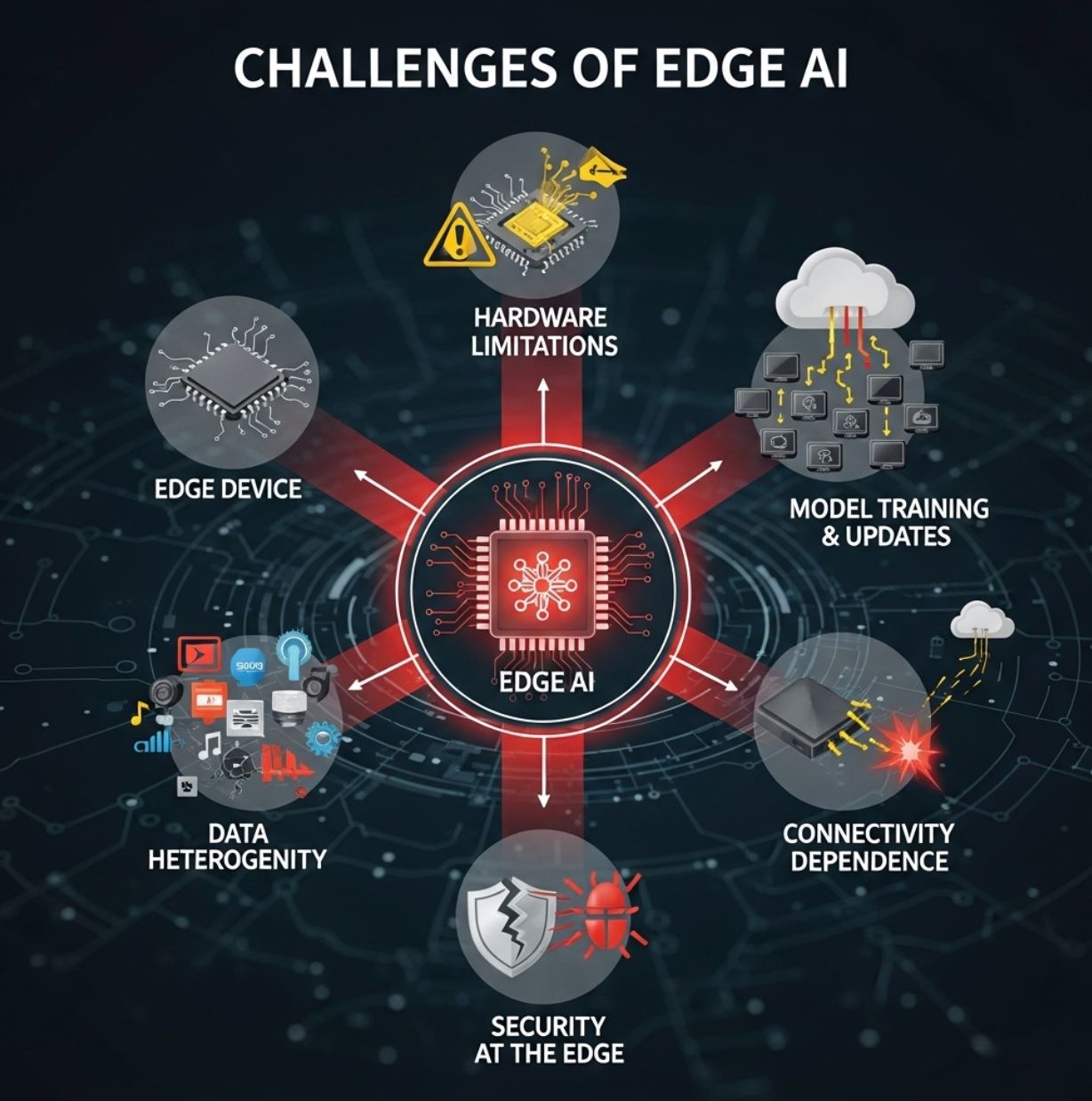

Défis de l’Edge AI

Malgré ses avantages, l’Edge AI rencontre aussi des obstacles :

- Limitations matérielles : Les appareils en périphérie sont généralement petits et aux ressources limitées. Ils disposent souvent de CPU modestes ou de NPU basse consommation spécialisés, ainsi que d’une mémoire restreinte.

Cela oblige les ingénieurs IA à utiliser la compression, l’élagage ou les techniques TinyML pour adapter les modèles à l’appareil. Les modèles d’apprentissage profond complexes ne peuvent souvent pas fonctionner à pleine échelle sur un microcontrôleur, ce qui peut entraîner une perte de précision. - Entraînement et mises à jour des modèles : L’entraînement des modèles IA sophistiqués se fait généralement dans le cloud, où les données massives et la puissance de calcul sont disponibles. Après entraînement, ces modèles doivent être optimisés (quantifiés, élagués, etc.) et déployés sur chaque appareil en périphérie.

Maintenir à jour des milliers ou millions d’appareils peut être complexe. La synchronisation des firmwares et des données ajoute une charge de gestion. - Gravité et hétérogénéité des données : Les environnements en périphérie sont diversifiés. Différents sites peuvent collecter différents types de données (les capteurs varient selon les applications), et les politiques peuvent différer selon les régions.

Intégrer et standardiser toutes ces données est un défi. Comme le note IBM, le déploiement large de l’Edge AI soulève des questions de « gravité des données, hétérogénéité, échelle et contraintes de ressources ». En d’autres termes, les données ont tendance à rester locales, ce qui complique une vision globale, et les appareils sont très variés. - Sécurité en périphérie : Bien que l’Edge AI puisse améliorer la confidentialité, elle introduit aussi de nouvelles préoccupations de sécurité. Chaque appareil ou nœud est une cible potentielle pour les hackers.

Garantir que les modèles locaux sont inviolables et que le firmware est sécurisé nécessite des protections robustes. - Dépendance à la connectivité pour certaines tâches : Même si l’inférence peut être locale, les systèmes en périphérie dépendent souvent encore du cloud pour des tâches lourdes comme la réentraînement des modèles, l’analyse de données à grande échelle ou l’agrégation des résultats distribués.

Une connectivité limitée peut freiner ces fonctions en back-office.

En pratique, la plupart des solutions adoptent un modèle hybride : les appareils en périphérie gèrent l’inférence, tandis que le cloud prend en charge l’entraînement, la gestion des modèles et l’analyse big data.

Ce compromis permet de surmonter les contraintes de ressources et de faire évoluer l’Edge AI.

Cas d’usage de l’Edge AI

L’Edge AI est appliquée dans de nombreux secteurs. Exemples concrets :

- Véhicules autonomes : Les voitures autonomes utilisent l’Edge AI embarquée pour traiter instantanément les données des caméras et radars pour la navigation et l’évitement d’obstacles.

Elles ne peuvent pas se permettre le délai d’envoi des vidéos vers un serveur, donc tout (détection d’objets, reconnaissance des piétons, suivi des voies) se fait localement. - Industrie et Industrie 4.0 : Les usines déploient des caméras intelligentes et des capteurs sur les lignes de production pour détecter en temps réel défauts ou anomalies.

Par exemple, une caméra Edge AI peut repérer un produit défectueux sur le convoyeur et déclencher une action immédiate. De même, les machines industrielles utilisent l’IA sur site pour prédire les pannes (maintenance prédictive) avant qu’elles ne surviennent. - Santé et intervention d’urgence : Les dispositifs médicaux portables et les ambulances utilisent désormais l’Edge AI pour analyser les données des patients sur place.

Un échographe ou un moniteur de signes vitaux embarqué dans une ambulance peut appliquer l’IA instantanément pour détecter des blessures internes ou alerter les secouristes en cas de signes vitaux anormaux. Dans les hôpitaux, l’Edge AI peut surveiller en continu les patients en soins intensifs et déclencher des alarmes sans attendre un serveur central. - Villes intelligentes : Les systèmes urbains utilisent l’Edge AI pour la gestion du trafic, la surveillance et la détection environnementale.

Les feux de circulation intelligents ajustent leur timing grâce à l’IA locale qui analyse les flux des caméras, réduisant les embouteillages en temps réel. Les caméras de rue peuvent détecter des incidents (accidents, incendies) et alerter immédiatement les autorités. En gardant le traitement local, les villes réagissent rapidement sans surcharger les réseaux centraux. - Commerce de détail et IoT grand public : L’Edge AI améliore l’expérience client et la commodité.

Dans les magasins, les caméras intelligentes ou capteurs d’étagères utilisent l’IA pour suivre instantanément le comportement des acheteurs et les niveaux de stock. À domicile, smartphones, tablettes et enceintes connectées exécutent la reconnaissance vocale ou faciale sur l’appareil. Par exemple, un smartphone peut se déverrouiller ou reconnaître des gestes sans accès au cloud. Les trackers d’activité analysent localement les données de santé (rythme cardiaque, pas) pour fournir un retour en temps réel.

D’autres usages émergents incluent l’agriculture de précision (drones et capteurs utilisant l’Edge AI pour surveiller la santé des sols et des cultures) et les systèmes de sécurité (reconnaissance faciale embarquée pour les serrures). Comme le souligne une étude IEEE, l’Edge AI est essentielle pour des applications telles que l’agriculture intelligente, le contrôle du trafic et l’automatisation industrielle.

En résumé, tout scénario bénéficiant d’une analyse locale instantanée est un candidat idéal pour l’Edge AI.

Technologies et tendances facilitatrices

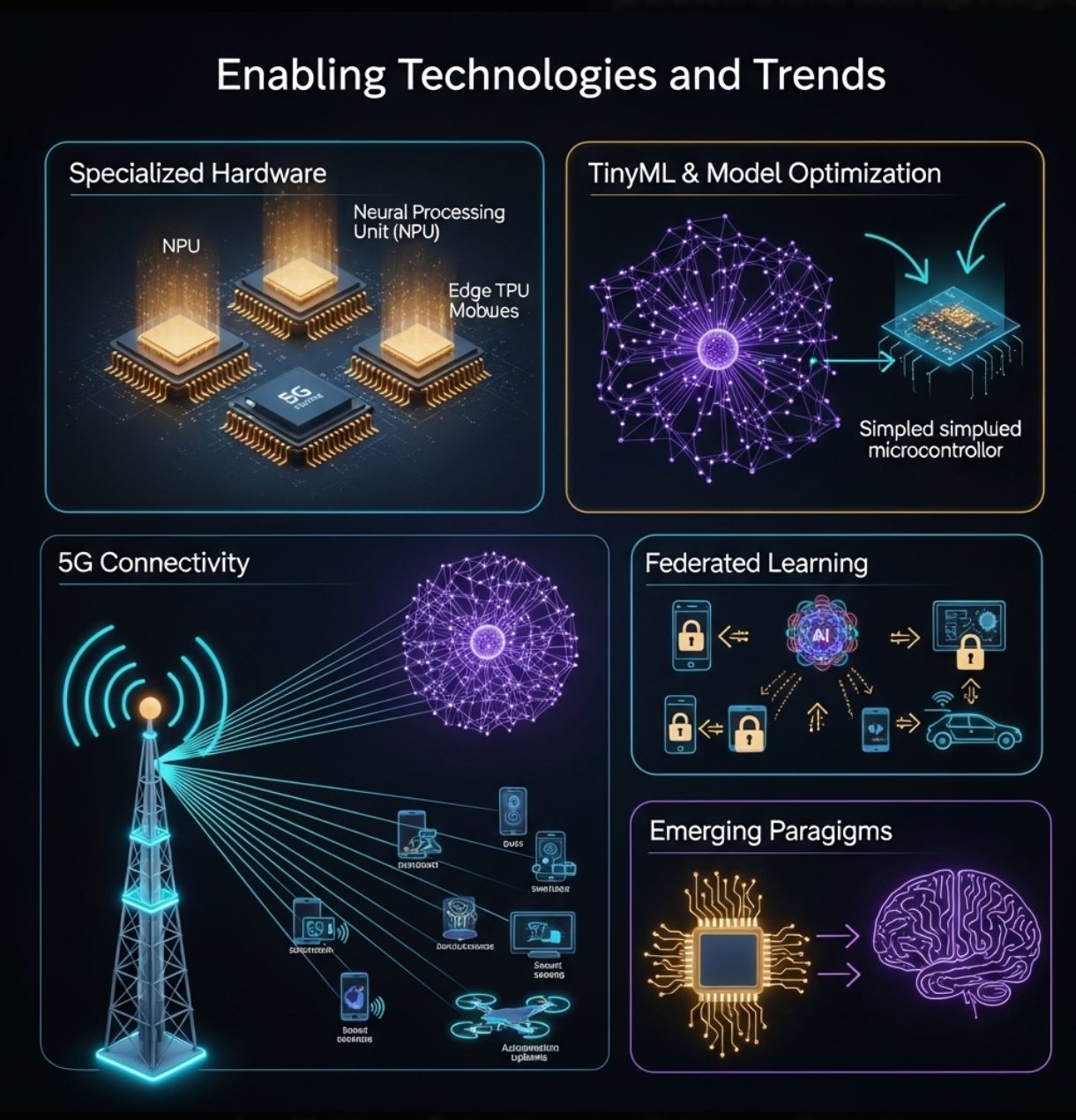

La croissance de l’Edge AI est portée par les progrès matériels et logiciels :

- Matériel spécialisé : Les fabricants conçoivent des puces dédiées à l’inférence en périphérie. Cela inclut des accélérateurs neuronaux basse consommation dans les smartphones (NPU) et des modules Edge AI dédiés comme Google Coral Edge TPU, NVIDIA Jetson Nano, ainsi que des cartes microcontrôleurs à faible coût (Arduino, Raspberry Pi avec extensions IA).

Un rapport récent souligne que les avancées dans les processeurs ultra basse consommation et les algorithmes « natifs en périphérie » dépassent les limites du matériel embarqué. - TinyML et optimisation des modèles : Des outils comme TensorFlow Lite et des techniques telles que l’élagage, la quantification et la distillation permettent de réduire la taille des réseaux neuronaux pour les faire tenir sur de petits appareils.

Le « TinyML » est un domaine émergent dédié à l’exécution du ML sur microcontrôleurs. Ces approches étendent l’IA aux capteurs et objets connectés fonctionnant sur batterie. - 5G et connectivité : Les réseaux sans fil de nouvelle génération (5G et au-delà) offrent une bande passante élevée et une faible latence qui complètent l’Edge AI.

Les réseaux locaux rapides facilitent la coordination de grappes d’appareils en périphérie et le déchargement des tâches lourdes si nécessaire. Cette synergie entre 5G et IA ouvre la voie à de nouvelles applications (usines intelligentes, communication véhicule-à-tout). - Apprentissage fédéré et collaboratif : Les méthodes préservant la confidentialité comme l’apprentissage fédéré permettent à plusieurs appareils en périphérie d’entraîner conjointement un modèle sans partager les données brutes.

Chaque appareil améliore localement le modèle et ne partage que les mises à jour. Cette tendance (annoncée dans les feuilles de route technologiques) renforcera l’Edge AI en exploitant des données distribuées tout en les gardant privées. - Paradigmes émergents : À l’avenir, la recherche explore l’informatique neuromorphique et l’IA générative embarquée pour renforcer encore l’intelligence en périphérie.

Comme le prédit un rapport, des innovations telles que les puces inspirées du cerveau et les grands modèles de langage locaux pourraient apparaître en périphérie.

Ces technologies repoussent sans cesse les limites de l’Edge AI. Ensemble, elles contribuent à l’ère de « l’inférence IA » – rapprochant l’intelligence des utilisateurs et des capteurs.

>>> Vous pourriez être intéressé :

Qu’est-ce que l’IA générative ?

Qu’est-ce que l’apprentissage par renforcement ?

L’Edge AI transforme notre utilisation de l’intelligence artificielle en déplaçant le calcul vers la source des données. Elle complète l’IA cloud, offrant des analyses plus rapides, plus efficaces et plus confidentielles sur des appareils locaux.

Cette approche répond aux défis du temps réel et de la bande passante inhérents aux architectures centrées sur le cloud. En pratique, l’Edge AI alimente un large éventail de technologies modernes – des capteurs intelligents et usines aux drones et voitures autonomes – en permettant une intelligence instantanée sur place.

Avec la prolifération des objets connectés et l’amélioration des réseaux, l’Edge AI est appelée à se développer. Les progrès matériels (microprocesseurs puissants, TinyML) et les techniques (apprentissage fédéré, optimisation des modèles) facilitent la généralisation de l’IA partout.

Selon les experts, l’Edge AI apporte des gains notables en efficacité, confidentialité et usage de la bande passante. En résumé, l’Edge AI est l’avenir de l’intelligence embarquée – offrant le meilleur de l’IA sous une forme distribuée et locale.