Edge AI (manchmal auch „KI am Rand“ genannt) bedeutet, künstliche Intelligenz- und Machine-Learning-Modelle auf lokalen Geräten (Sensoren, Kameras, Smartphones, industrielle Gateways usw.) statt in entfernten Rechenzentren auszuführen. Anders gesagt übernimmt der „Rand“ des Netzwerks – dort, wo die Daten entstehen – die Verarbeitung. So können Geräte Daten sofort analysieren, sobald sie erfasst werden, anstatt ständig Rohdaten in die Cloud zu senden.

Wie IBM erklärt, ermöglicht Edge AI eine Echtzeitverarbeitung direkt auf dem Gerät, ohne auf einen zentralen Server angewiesen zu sein. Beispielsweise kann eine Kamera mit Edge AI Objekte in Echtzeit erkennen und klassifizieren und sofortiges Feedback geben. Durch die lokale Datenverarbeitung funktioniert Edge AI auch bei intermittierender oder fehlender Internetverbindung.

Laut Branchenberichten vollzieht sich dieser Wandel schnell: Die weltweiten Ausgaben für Edge Computing erreichten im Jahr 2024 etwa 232 Milliarden US-Dollar (ein Plus von 15 % gegenüber 2023), maßgeblich getrieben durch das Wachstum von KI-gestütztem IoT.

Zusammengefasst bringt Edge AI die Rechenleistung näher an die Datenquelle – Intelligenz wird auf Geräten oder nahegelegenen Knotenpunkten bereitgestellt, was Reaktionszeiten verkürzt und die Notwendigkeit reduziert, alle Daten in die Cloud zu übertragen.

Edge AI vs Cloud AI: Wesentliche Unterschiede

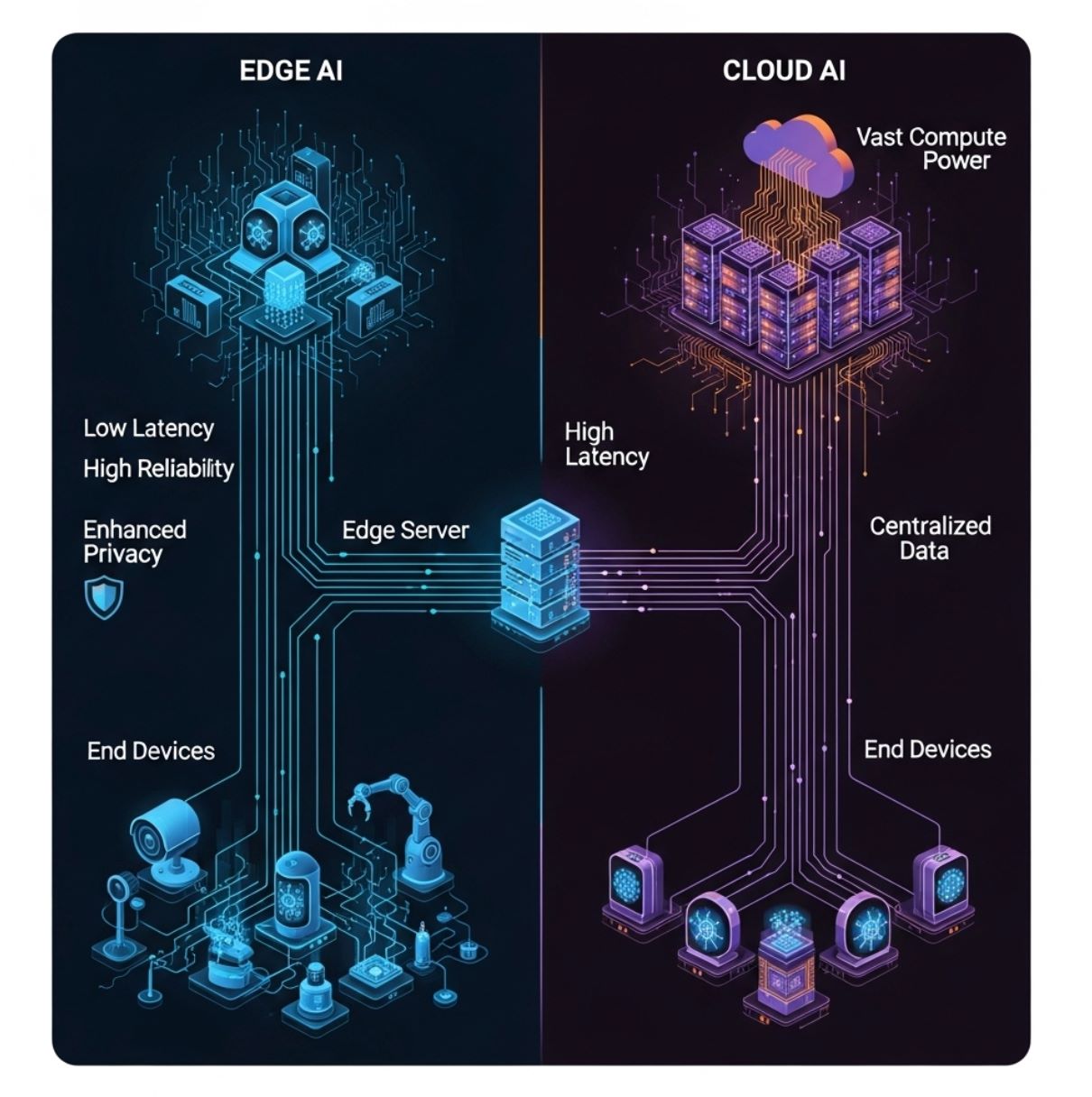

Im Gegensatz zur herkömmlichen Cloud-basierten KI (bei der alle Daten an zentrale Server gesendet werden), verteilt Edge AI die Rechenleistung auf lokale Hardware vor Ort. Das obige Diagramm zeigt ein einfaches Edge-Computing-Modell: Endgeräte (unterste Ebene) liefern Daten an einen Edge-Server oder Gateway (mittlere Ebene) statt nur an die entfernte Cloud (obere Ebene).

In diesem Setup kann die KI-Auswertung direkt auf dem Gerät oder dem lokalen Edge-Knoten erfolgen, was Kommunikationsverzögerungen erheblich reduziert.

- Latenz: Edge AI minimiert Verzögerungen. Da die Verarbeitung lokal erfolgt, können Entscheidungen in Millisekunden getroffen werden. IBM weist darauf hin, dass Edge-basierte Auswertung „die Latenz durch direkte Datenverarbeitung auf dem Gerät reduziert“, während Cloud-KI zusätzliche Verzögerungen durch den Datentransfer zu und von entfernten Servern verursacht.

Dies ist entscheidend für zeitkritische Aufgaben (z. B. Unfallvermeidung oder Robotersteuerung). - Bandbreite: Edge AI reduziert die Netzwerklast. Durch lokale Analyse oder Filterung müssen deutlich weniger Daten weitergeleitet werden. IBM erklärt, dass Edge-Systeme „geringere Bandbreite erfordern“, da die meisten Daten lokal bleiben.

Im Gegensatz dazu benötigt Cloud-KI durchgehende Hochgeschwindigkeitsverbindungen, um Rohdaten hin- und her zu senden. Das macht Edge AI effizienter und kostengünstiger, besonders bei ausgelasteten oder teuren Netzwerken. - Datenschutz/Sicherheit: Edge AI kann die Privatsphäre verbessern. Sensible Daten (Sprache, Bilder, Gesundheitswerte) können lokal verarbeitet und gespeichert werden, ohne in die Cloud übertragen zu werden. Dadurch wird das Risiko von Datenlecks durch Dritte verringert.

Beispielsweise kann ein Smartphone Ihr Gesicht lokal erkennen, ohne das Foto hochzuladen. Im Vergleich dazu erfordert Cloud-KI oft das Senden persönlicher Daten an externe Server, was Sicherheitsrisiken birgt. - Rechenressourcen: Cloud-Rechenzentren verfügen über nahezu unbegrenzte CPU-/GPU-Leistung und können sehr große KI-Modelle ausführen. Edge-Geräte haben deutlich weniger Rechen- und Speicherressourcen. IBM weist darauf hin, dass Edge-Einheiten „durch die Größe des Geräts begrenzt sind“.

Daher verwendet Edge AI oft optimierte oder kleinere Modelle. In der Praxis erfolgt das Training großer Modelle meist in der Cloud, während nur kompakte, quantisierte Modelle auf Edge-Geräte übertragen werden. - Zuverlässigkeit: Durch die geringere Abhängigkeit von ständiger Konnektivität kann Edge AI kritische Funktionen auch bei Netzwerkausfällen aufrechterhalten. Ein Drohne kann beispielsweise mit an Bord befindlicher KI navigieren, wenn die Verbindung zur Basis verloren geht.

Kurz gesagt ergänzen sich Edge und Cloud AI. Cloud-Server übernehmen das aufwändige Training, Archivierung und großvolumige Analysen, während Edge AI Echtzeit-Auswertung und schnelle Entscheidungen nahe an der Datenquelle ermöglicht.

Vorteile von Edge AI

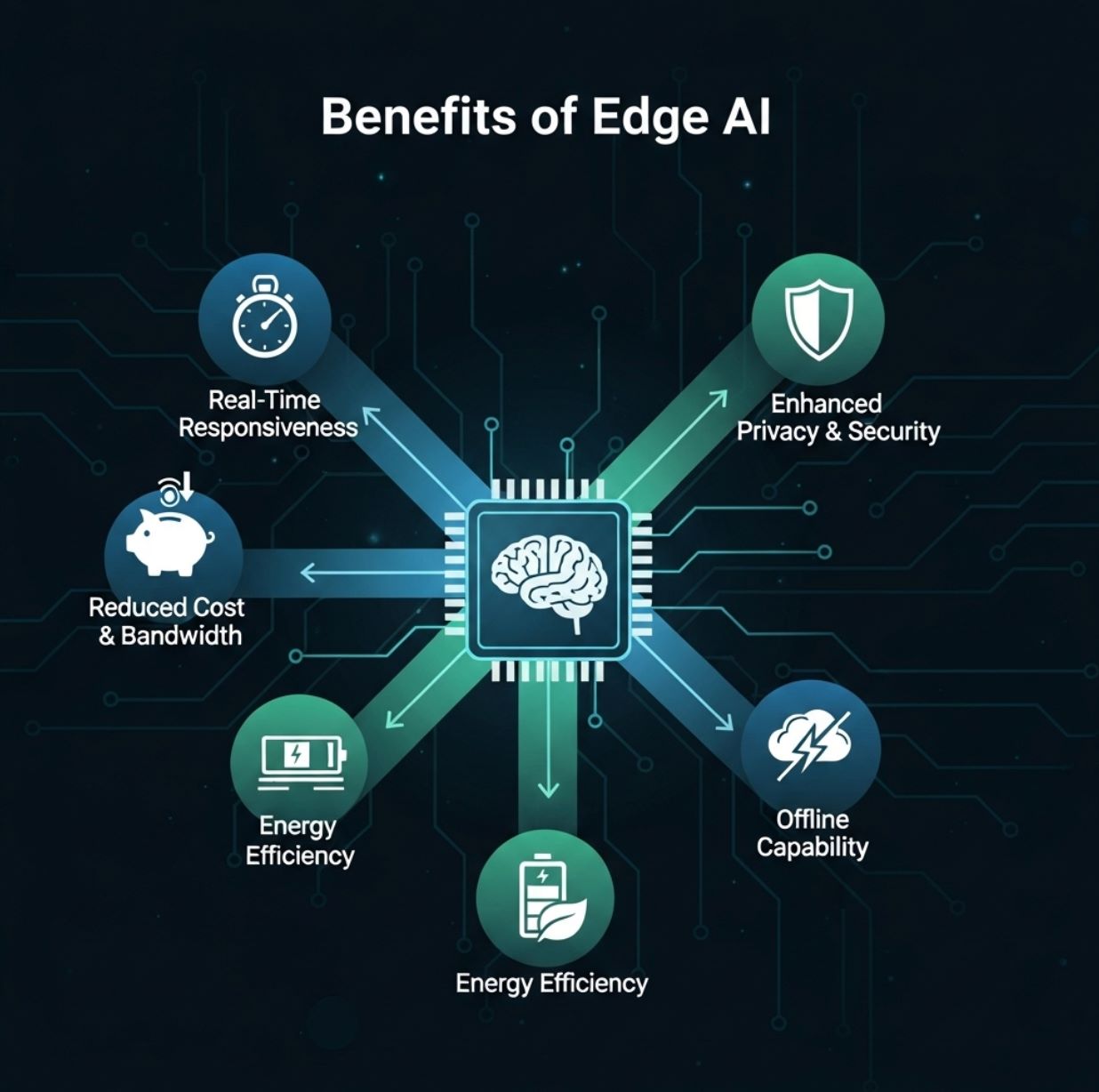

Edge AI bietet Anwendern und Organisationen mehrere praktische Vorteile:

- Echtzeitreaktionen: Die lokale Datenverarbeitung ermöglicht sofortige Analysen. Nutzer erhalten sofortiges Feedback (z. B. Live-Objekterkennung, Sprachantwort, Anomaliealarm), ohne auf eine Rückmeldung aus der Cloud warten zu müssen.

Diese geringe Latenz ist ein großer Vorteil für Anwendungen wie Augmented Reality, autonome Fahrzeuge und Robotik. - Reduzierte Bandbreite und Kosten: Mit Edge AI müssen nur zusammengefasste Ergebnisse oder ungewöhnliche Ereignisse über das Internet gesendet werden. Das senkt Datenübertragungs- und Cloud-Speicherkosten erheblich.

Beispielsweise lädt eine Sicherheitskamera nur Clips hoch, wenn eine potenzielle Bedrohung erkannt wird, statt kontinuierlich zu streamen. - Verbesserter Datenschutz: Die Daten bleiben auf dem Gerät und erhöhen so die Sicherheit. Persönliche oder sensible Informationen verlassen die lokale Hardware nicht, wenn sie am Rand verarbeitet werden.

Das ist besonders wichtig für Anwendungen mit strengen Datenschutzvorgaben (Gesundheitswesen, Finanzen usw.), da Edge AI Daten innerhalb eines Landes oder einer Einrichtung halten kann. - Energie- und Kosteneffizienz: KI auf dem Gerät kann Energie sparen. Ein kleines Modell auf einem stromsparenden Chip verbraucht oft weniger Energie als das Senden von Daten zu einem Cloud-Server und zurück.

Außerdem reduziert es Serverkosten – große KI-Workloads sind in der Cloud teuer zu betreiben. - Offline-Fähigkeit und Robustheit: Edge AI kann auch bei Verbindungsproblemen weiterarbeiten. Geräte funktionieren mit lokaler Intelligenz und synchronisieren später.

Das macht Systeme robuster, besonders in abgelegenen Gebieten oder bei kritischen Anwendungen (z. B. industrielle Überwachung).

Red Hat und IBM heben diese Vorteile hervor. Edge AI „bringt Hochleistungsrechenkapazitäten an den Rand“ und ermöglicht Echtzeitanalyse sowie verbesserte Effizienz.

Wie ein Bericht zusammenfasst, senken Edge-Implementierungen Latenz und Bandbreitenbedarf und steigern gleichzeitig Datenschutz und Zuverlässigkeit.

Herausforderungen von Edge AI

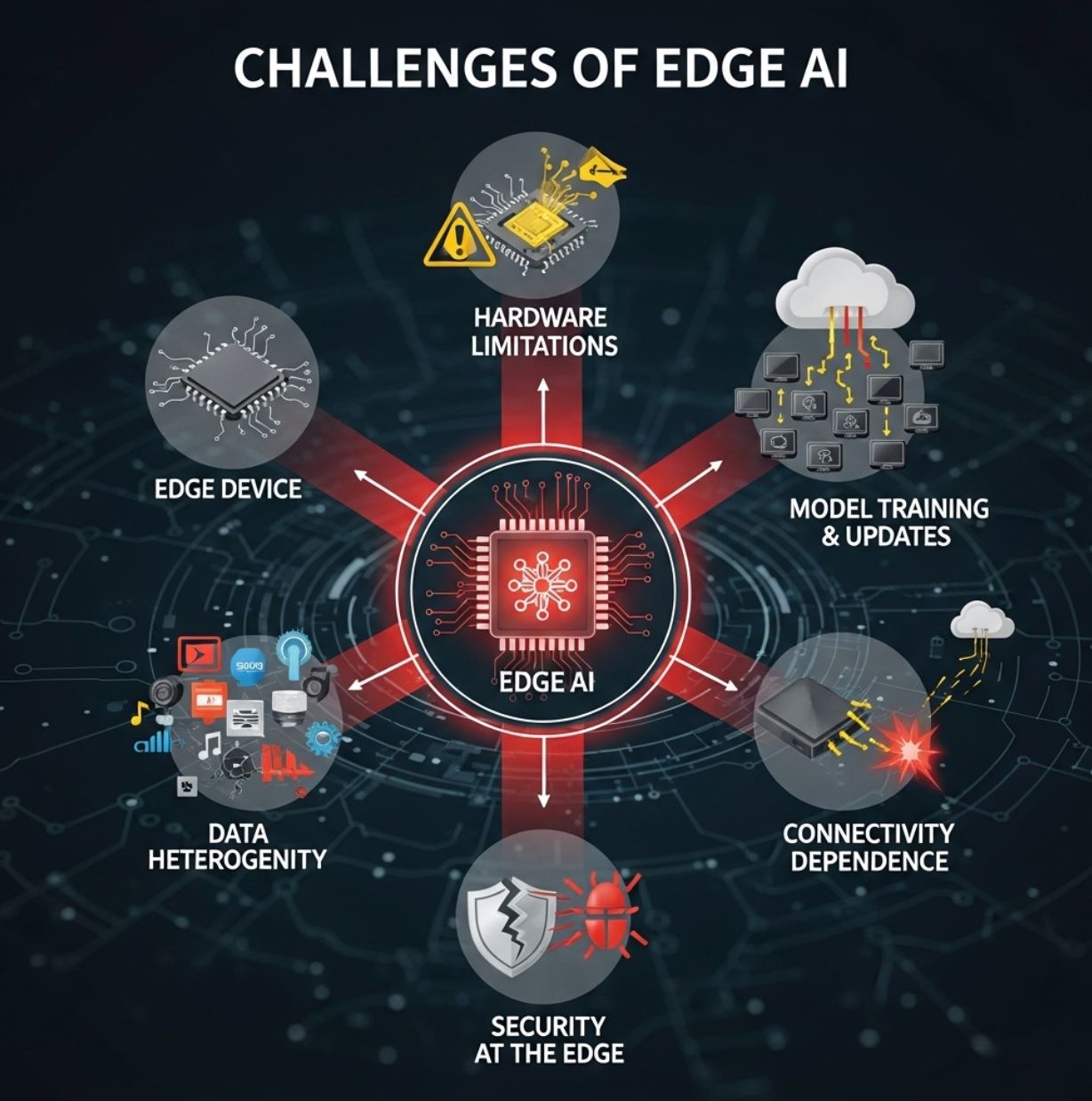

Trotz der Vorteile steht Edge AI auch vor Herausforderungen:

- Hardwarebeschränkungen: Edge-Geräte sind meist klein und ressourcenbeschränkt. Sie verfügen oft nur über einfache CPUs oder spezialisierte stromsparende NPUs sowie begrenzten Speicher.

Das zwingt KI-Ingenieure, Modellkompression, Pruning oder TinyML-Techniken einzusetzen, um Modelle auf das Gerät zu bringen. Komplexe Deep-Learning-Modelle können oft nicht vollständig auf Mikrocontrollern laufen, wodurch Genauigkeit verloren gehen kann. - Modelltraining und Updates: Das Training anspruchsvoller KI-Modelle erfolgt meist weiterhin in der Cloud, wo große Datenmengen und Rechenleistung verfügbar sind. Nach dem Training müssen Modelle optimiert (quantisiert, beschnitten usw.) und auf jedes Edge-Gerät verteilt werden.

Die Aktualisierung von Tausenden oder Millionen Geräten kann komplex sein. Firmware- und Datensynchronisation erhöhen den Verwaltungsaufwand. - Datenlokalität und Heterogenität: Edge-Umgebungen sind vielfältig. Unterschiedliche Standorte erfassen verschiedene Datentypen (Sensoren variieren je nach Anwendung), und Richtlinien können regional unterschiedlich sein.

Die Integration und Standardisierung all dieser Daten ist herausfordernd. IBM weist darauf hin, dass die breite Einführung von Edge AI Probleme mit „Datenlokalität, Heterogenität, Skalierung und Ressourcenbeschränkungen“ mit sich bringt. Daten bleiben meist lokal, was eine globale Übersicht erschwert, und Geräte sind sehr unterschiedlich. - Sicherheit am Rand: Obwohl Edge AI den Datenschutz verbessern kann, entstehen neue Sicherheitsrisiken. Jedes Gerät oder jeder Knotenpunkt ist ein potenzielles Ziel für Hacker.

Es erfordert starke Schutzmaßnahmen, um lokale Modelle manipulationssicher und Firmware sicher zu halten. - Abhängigkeit von Konnektivität bei bestimmten Aufgaben: Obwohl die Auswertung lokal erfolgen kann, sind Edge-Systeme oft auf Cloud-Verbindungen für aufwändige Aufgaben wie Modelltraining, groß angelegte Datenanalysen oder das Zusammenführen verteilter Ergebnisse angewiesen.

Begrenzte Konnektivität kann diese Backoffice-Funktionen ausbremsen.

In der Praxis verwenden die meisten Lösungen ein hybrides Modell: Edge-Geräte übernehmen die Auswertung, während die Cloud Training, Modellverwaltung und Big-Data-Analysen übernimmt.

Dieses Gleichgewicht hilft, Ressourcenbeschränkungen zu überwinden und Edge AI skalierbar zu machen.

Anwendungsfälle von Edge AI

Edge AI wird in vielen Branchen eingesetzt. Beispiele aus der Praxis sind:

- Autonome Fahrzeuge: Selbstfahrende Autos nutzen an Bord Edge AI, um Kamera- und Radardaten sofort für Navigation und Hindernisvermeidung zu verarbeiten.

Sie können sich keine Verzögerung leisten, die durch das Senden von Videos an einen Server entsteht, daher erfolgt alles lokal (Objekterkennung, Fußgängererkennung, Spurverfolgung). - Fertigung und Industrie 4.0: Fabriken setzen intelligente Kameras und Sensoren an Produktionslinien ein, um Fehler oder Anomalien in Echtzeit zu erkennen.

Beispielsweise kann eine Edge AI-Kamera ein fehlerhaftes Produkt auf dem Förderband erkennen und sofort Maßnahmen auslösen. Ebenso nutzen Industrieanlagen vor Ort KI, um Ausfälle vorherzusagen (vorausschauende Wartung), bevor es zu Störungen kommt. - Gesundheitswesen und Notfallversorgung: Tragbare medizinische Geräte und Rettungswagen verwenden Edge AI, um Patientendaten direkt vor Ort zu analysieren.

Ein Ultraschallgerät oder Vitalzeichenmonitor im Rettungswagen kann KI sofort einsetzen, um innere Verletzungen zu erkennen oder Sanitäter bei abnormalen Werten zu alarmieren. In Krankenhäusern überwacht Edge AI intensivmedizinische Patienten kontinuierlich und löst Alarme aus, ohne auf einen zentralen Server zu warten. - Smart Cities: Städtische Systeme nutzen Edge AI für Verkehrsmanagement, Überwachung und Umweltmessungen.

Intelligente Ampeln passen ihre Steuerung mit lokaler KI an Kamerabilder an und reduzieren so Staus in Echtzeit. Straßenkameras erkennen Vorfälle (Unfälle, Brände) und alarmieren sofort die Behörden. Durch lokale Verarbeitung können Städte schnell reagieren, ohne zentrale Netzwerke zu überlasten. - Einzelhandel und Consumer IoT: Edge AI verbessert Kundenerlebnis und Komfort.

In Geschäften verfolgen intelligente Kameras oder Regalsensoren mit KI das Verhalten der Kunden und den Lagerbestand in Echtzeit. Zu Hause führen Smartphones, Tablets und smarte Lautsprecher Sprach- oder Gesichtserkennung direkt auf dem Gerät aus. Beispielsweise kann ein Smartphone entsperrt oder Gesten erkannt werden, ohne Cloud-Zugriff. Fitness-Tracker analysieren Gesundheitsdaten (Herzfrequenz, Schritte) lokal und geben sofortiges Feedback.

Weitere aufkommende Anwendungen sind präzise Landwirtschaft (Drohnen und Sensoren mit Edge AI zur Überwachung von Boden- und Pflanzenzustand) und Sicherheitssysteme (lokale Gesichtserkennung für Schlösser). Wie eine IEEE-Studie feststellt, ist Edge AI entscheidend für Anwendungen wie Smart Farming, Verkehrssteuerung und industrielle Automatisierung.

Kurz gesagt: Jede Situation, die von sofortiger, lokaler Analyse profitiert, ist ein idealer Anwendungsfall für Edge AI.

Technologien und Trends

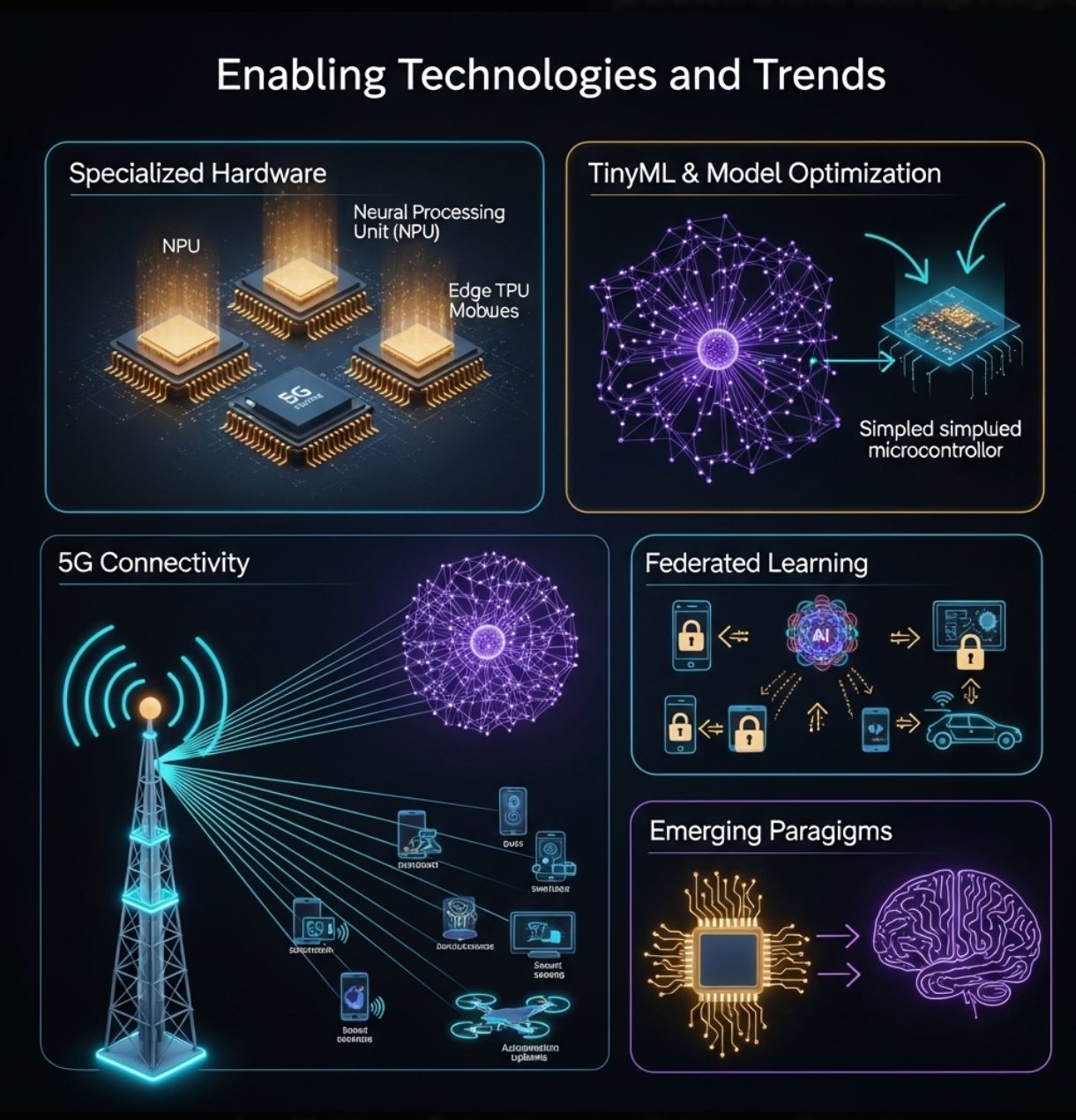

Das Wachstum von Edge AI wird durch Fortschritte in Hardware und Software vorangetrieben:

- Spezialisierte Hardware: Hersteller entwickeln Chips, die speziell für Edge-Inferenz ausgelegt sind. Dazu gehören stromsparende neuronale Beschleuniger in Smartphones (NPUs) und dedizierte Edge-AI-Module wie Google Coral Edge TPU, NVIDIA Jetson Nano sowie kostengünstige Mikrocontroller-Boards (Arduino, Raspberry Pi mit KI-Erweiterungen).

Ein aktueller Branchenbericht stellt fest, dass Fortschritte bei ultra-stromsparenden Prozessoren und „edge-nativen“ Algorithmen die Grenzen der Gerätehardware überwinden. - TinyML und Modelloptimierung: Werkzeuge wie TensorFlow Lite und Techniken wie Modell-Pruning, Quantisierung und Distillation ermöglichen es, neuronale Netze so zu verkleinern, dass sie auf winzigen Geräten laufen.

„TinyML“ ist ein aufstrebendes Feld, das sich auf Machine Learning auf Mikrocontrollern konzentriert. Diese Ansätze erweitern KI auf Sensoren und Wearables mit Batteriebetrieb. - 5G und Konnektivität: Die nächste Generation drahtloser Netzwerke (5G und darüber hinaus) bietet hohe Bandbreite und geringe Latenz, die Edge AI ergänzen.

Schnelle lokale Netzwerke erleichtern die Koordination von Edge-Geräte-Clustern und das Auslagern schwererer Aufgaben bei Bedarf. Diese Synergie zwischen 5G und KI ermöglicht neue Anwendungen (z. B. smarte Fabriken, Fahrzeug-zu-Alles-Kommunikation). - Föderiertes und kollaboratives Lernen: Datenschutzfreundliche Methoden wie föderiertes Lernen erlauben es mehreren Edge-Geräten, gemeinsam ein Modell zu trainieren, ohne Rohdaten auszutauschen.

Jedes Gerät verbessert das Modell lokal und teilt nur Updates. Dieser Trend (in zukünftigen Technologieroadmaps angedeutet) wird Edge AI durch verteilte Daten bei gleichzeitiger Wahrung der Privatsphäre stärken. - Neue Paradigmen: Zukünftig erforscht die Forschung neuromorphe Rechnerarchitekturen und generative KI auf dem Gerät, um die Intelligenz am Rand weiter zu steigern.

Wie ein Bericht prognostiziert, könnten Innovationen wie gehirninspirierte Chips und lokale große Sprachmodelle am Rand Einzug halten.

Diese Technologien verschieben kontinuierlich die Grenzen dessen, was Edge AI leisten kann. Gemeinsam ermöglichen sie die „Ära der KI-Auswertung“ – Intelligenz rückt näher an Nutzer und Sensoren.

>>> Für Sie interessant:

Was ist Reinforcement Learning?

Edge AI verändert die Nutzung künstlicher Intelligenz, indem die Verarbeitung näher an die Datenquelle verlagert wird. Es ergänzt Cloud-KI und liefert schnellere, effizientere und datenschutzfreundlichere Analysen auf lokalen Geräten.

Dieser Ansatz löst Herausforderungen in Echtzeit und Bandbreite, die bei cloudzentrierten Architekturen bestehen. In der Praxis treibt Edge AI eine Vielzahl moderner Technologien an – von intelligenten Sensoren und Fabriken bis hin zu Drohnen und selbstfahrenden Autos – indem es Intelligenz direkt vor Ort ermöglicht.

Mit der Verbreitung von IoT-Geräten und der Verbesserung der Netzwerke wird Edge AI weiter wachsen. Fortschritte in Hardware (leistungsstarke Mikroprozessoren, TinyML) und Methoden (föderiertes Lernen, Modelloptimierung) erleichtern es, KI überall einzusetzen.

Experten zufolge bringt Edge AI deutliche Vorteile bei Effizienz, Datenschutz und Bandbreitennutzung. Kurz gesagt, ist Edge AI die Zukunft eingebetteter Intelligenz – die beste KI in verteilter, gerätebasierter Form.