Qu'est-ce que le traitement du langage naturel ?

Le traitement du langage naturel (NLP) – ou traitement automatique du langage naturel – est un domaine de l’intelligence artificielle (IA) qui se concentre sur la capacité des ordinateurs à comprendre et à interagir avec le langage humain.

Le traitement du langage naturel (NLP) – ou traitement automatique du langage naturel – est un domaine de l’intelligence artificielle (IA) qui se concentre sur la capacité des ordinateurs à comprendre et à interagir avec le langage humain. Pour faire simple, le NLP utilise des méthodes de machine learning (apprentissage automatique) pour permettre aux ordinateurs d’interpréter, d’interagir et de comprendre le langage naturel que nous utilisons au quotidien.

C’est considéré comme l’un des problèmes les plus complexes de l’IA, car le langage est un outil d’expression des pensées et de communication très sophistiqué chez l’être humain, ce qui exige que les machines « comprennent » le sens caché derrière les phrases.

Le langage naturel ici désigne les langues humaines comme le vietnamien, l’anglais, le chinois... par opposition au langage informatique. L’objectif du NLP est de programmer les ordinateurs pour qu’ils traitent automatiquement et comprennent ces langues, et qu’ils puissent même générer des phrases comme un humain.

Par exemple, lorsque vous parlez à un assistant virtuel ou à un chatbot, posez une question à Siri, Alexa, ou traduisez un texte avec Google Traduction – toutes ces applications utilisent la technologie de traitement du langage naturel en arrière-plan.

Pourquoi le traitement du langage naturel est-il important ?

À l’ère du numérique, le volume de données linguistiques (textes, sons, conversations) augmente de façon exponentielle à partir de nombreuses sources telles que les emails, messages, réseaux sociaux, vidéos, etc. Contrairement aux données structurées (chiffres, tableaux), les données linguistiques sous forme de texte ou audio sont non structurées – très difficiles à traiter automatiquement sans NLP.

La technologie de traitement du langage naturel aide les ordinateurs à analyser efficacement ces données non structurées, à comprendre les intentions, le contexte et les émotions dans les mots humains. Grâce à cela, le NLP devient la clé pour que les machines communiquent et servissent les humains de manière plus intelligente.

Le traitement du langage naturel est important car il ouvre la possibilité d’une interaction naturelle entre l’homme et la machine. Au lieu d’apprendre un langage informatique, nous pouvons donner des ordres ou poser des questions à l’ordinateur dans notre langue maternelle. Le NLP automatise de nombreuses tâches complexes liées au langage, ce qui permet de gagner du temps et réduire les coûts, tout en améliorant l’expérience utilisateur dans presque tous les domaines.

Par exemple, les entreprises peuvent utiliser le NLP pour analyser automatiquement des milliers de retours clients sur les réseaux sociaux afin d’en extraire des insights importants, ou un chatbot utilisant le NLP peut répondre aux clients 24h/24 et 7j/7 de manière cohérente. Une bonne application du NLP aide les entreprises à optimiser leurs processus, augmenter leur productivité et même personnaliser les services pour chaque utilisateur.

En réalité, le NLP est déjà présent dans notre vie quotidienne. Les moteurs de recherche comme Google comprennent ce que vous cherchez même si la requête est imprécise. Les systèmes de assistants virtuels tels qu’Amazon Alexa, Apple Siri ou Microsoft Cortana peuvent écouter et répondre aux utilisateurs, aidant à effectuer diverses tâches, de passer un appel à lancer de la musique ou chercher des informations.

Même la fonction de prédiction de mots lorsque vous tapez un message ou la correction automatique sont rendues possibles grâce au NLP. Clairement, le traitement du langage naturel est devenu une technologie clé qui alimente de nombreuses applications intelligentes autour de nous, permettant aux machines de mieux « comprendre » le langage que jamais auparavant.

Applications courantes du NLP

Grâce à sa capacité à « comprendre » le langage, le NLP est largement utilisé dans de nombreux domaines différents. Voici quelques-unes des applications majeures du traitement du langage naturel :

-

Assistants virtuels et chatbots :

Le NLP permet de créer des assistants virtuels comme Siri, Alexa ou des chatbots sur des sites web, Facebook Messenger... capables de comprendre les questions des utilisateurs et de répondre automatiquement. Ils aident à répondre aux questions fréquentes, à gérer les rendez-vous, les achats ou à résoudre rapidement les problèmes clients, à tout moment et en tout lieu.

-

Analyse des opinions et des sentiments :

Les entreprises utilisent le NLP pour analyser les retours clients sur les réseaux sociaux, enquêtes ou évaluations de produits. Les algorithmes NLP peuvent détecter les sentiments (positifs/négatifs), les attitudes ou même l’ironie dans les textes. Cela aide les entreprises à mieux comprendre les opinions des clients et les tendances du marché pour améliorer leurs produits et services en temps réel.

-

Traduction automatique :

La traduction automatique est une application classique du NLP. Les logiciels de traduction (comme Google Traduction) utilisent le NLP pour convertir des textes ou paroles d’une langue à une autre tout en essayant de préserver le sens et le contexte. Grâce au NLP, la qualité des traductions automatiques s’améliore constamment, facilitant la communication au-delà des barrières linguistiques.

-

Traitement de la voix :

La reconnaissance vocale (speech recognition) convertit la voix en texte, vous permettant de donner des commandes vocales à votre téléphone ou ordinateur (par exemple : fonction Voice-to-text, appels vocaux).

Inversement, le NLP aide aussi à générer la voix à partir de texte (text-to-speech), créant une voix naturelle pour les livres audio, assistants virtuels, etc. Les systèmes de commande vocale dans les voitures ou maisons intelligentes reposent sur ces technologies.

-

Classification et extraction d’informations :

Le NLP peut automatiquement classer des textes par sujet (par exemple : filtrer les emails spam/non spam, classer les actualités par domaine) et extraire des informations importantes. En entreprise, le NLP est utilisé pour organiser des dossiers, documents ; en santé, pour extraire des données médicales ; ou en droit, pour filtrer des documents parmi des millions de pages.

-

Génération automatique de contenu :

Une avancée récente du NLP est la capacité à générer du langage naturel – c’est-à-dire créer des textes semblables à ceux écrits par des humains. Les modèles linguistiques modernes (comme GPT-3, GPT-4) peuvent rédiger des articles, composer des emails, écrire de la poésie, coder... selon les demandes des utilisateurs.

Cela ouvre de nombreuses applications intéressantes comme l’aide à la création de contenu, les réponses automatiques dans le service client, voire la rédaction de brouillons pour les étudiants. Bien sûr, le contenu généré par machine nécessite une supervision humaine pour garantir précision et éthique.

En résumé, toute tâche liée au langage naturel (texte, parole) peut bénéficier du NLP pour automatiser ou améliorer son efficacité. De la recherche d’information, réponse aux questions, analyse de documents à soutien éducatif (ex : correction automatique, tuteur virtuel) – le traitement du langage naturel joue un rôle clé.

Comment fonctionne le NLP ?

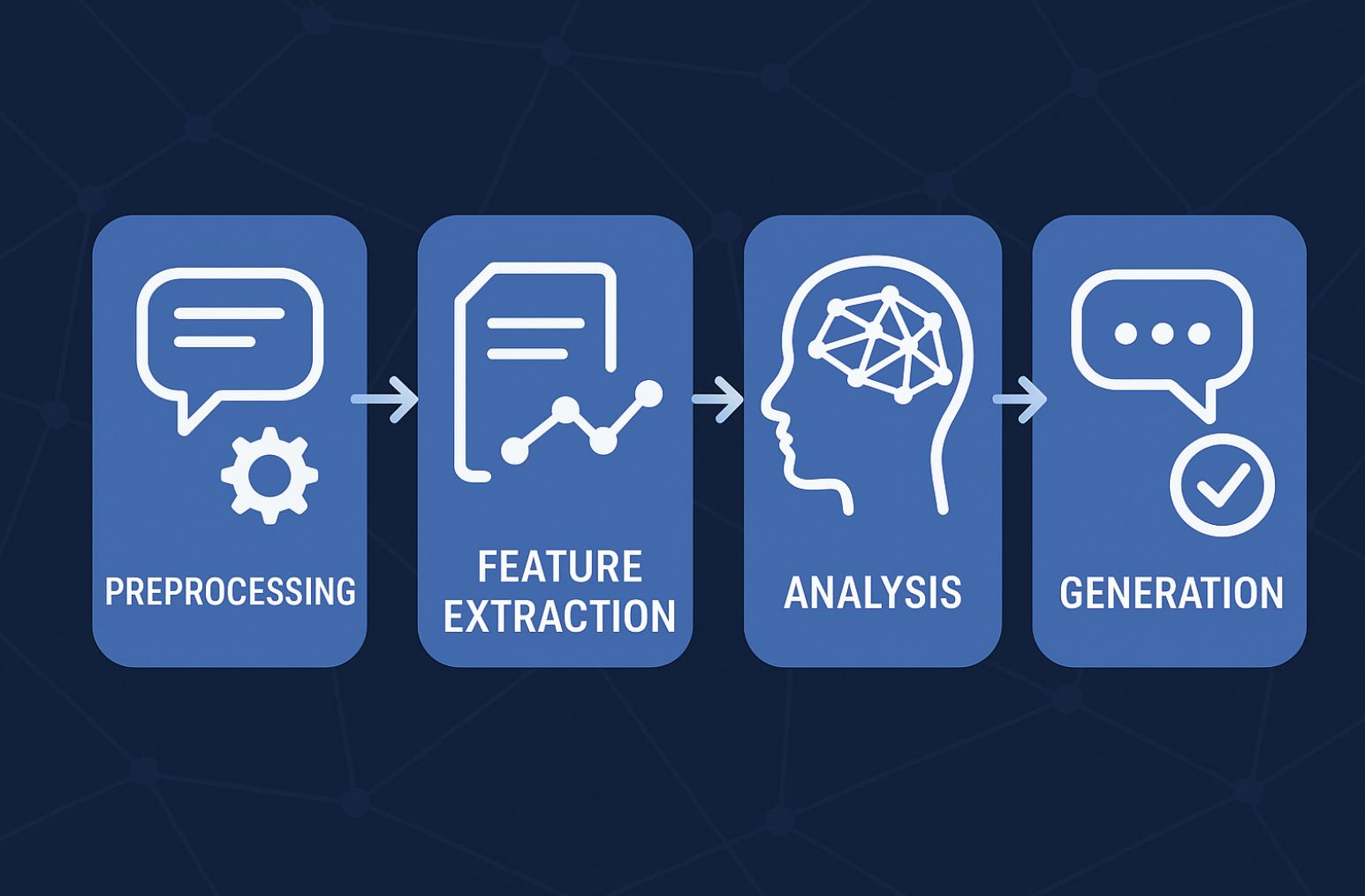

Pour que les ordinateurs comprennent le langage humain, le NLP combine plusieurs techniques de informatique et de linguistique. Fondamentalement, un système NLP suit les étapes principales suivantes lors du traitement du langage :

Prétraitement du langage :

Tout d’abord, le texte ou la voix est converti en données brutes pour l’ordinateur. Par exemple, pour le texte, le NLP effectue la tokenisation (découpage en phrases, mots), convertit tout en minuscules (lowercasing), supprime la ponctuation et les mots vides (mots comme « the », « is » qui n’apportent pas beaucoup de sens).

Ensuite, on peut appliquer le stemming/lemmatisation – ramener les mots à leur forme de base (ex : « running » devient « run »). Pour l’audio, la première étape est la reconnaissance vocale pour obtenir le texte. Le résultat du prétraitement est un jeu de données linguistiques nettoyé et normalisé, prêt pour l’apprentissage machine.

Extraction de caractéristiques (feature extraction) :

Les ordinateurs ne comprennent pas directement les mots, donc le NLP doit représenter le langage sous forme numérique. Cette étape convertit le texte en caractéristiques numériques ou vecteurs.

Les techniques courantes incluent le modèle Bag of Words, TF-IDF (fréquence pondérée des mots) ou plus modernes comme le word embedding (ex : Word2Vec, GloVe) – qui attribuent à chaque mot un vecteur représentant son sens. Ces vecteurs aident les algorithmes à comprendre les relations sémantiques entre les mots (par exemple, « roi » est plus proche de « reine » que de « voiture » dans l’espace vectoriel).

Analyse et compréhension du contexte :

Une fois les données numériques obtenues, le système utilise des modèles et algorithmes d’apprentissage automatique pour analyser la syntaxe et la sémantique.

Par exemple, l’analyse syntaxique identifie le rôle des mots dans la phrase (sujet, verbe, complément...), tandis que l’analyse sémantique aide à comprendre le sens dans un contexte donné. Le NLP moderne utilise des modèles de deep learning (apprentissage profond) pour ces tâches, permettant aux machines de progressivement comprendre le sens des phrases presque comme un humain.

Génération de langage ou action :

Selon l’objectif, la dernière étape peut être de fournir un résultat à l’utilisateur. Par exemple, pour une question, le système NLP va chercher une réponse appropriée dans les données et la restituer (texte ou voix). Pour une commande, le NLP déclenche une action sur la machine (ex : lancer la musique quand on dit « Play music »).

Dans le cas de la traduction automatique, cette étape génère la phrase traduite dans la langue cible. Pour un chatbot, c’est le moment où il produit une réponse naturelle basée sur la compréhension des étapes précédentes.

En pratique, ce processus peut être beaucoup plus complexe et les étapes ne sont pas toujours clairement séparées. De nombreux systèmes NLP actuels utilisent des modèles end-to-end, c’est-à-dire des réseaux de neurones qui apprennent tout du début à la fin, au lieu de traiter chaque étape séparément. Cependant, cette division aide à mieux comprendre comment fonctionne le NLP pour transformer le langage humain en une forme compréhensible par la machine et fournir une réponse adaptée.

Approches du NLP

Au cours de son développement, le traitement du langage naturel a connu plusieurs générations de méthodes différentes. Depuis les années 1950, on peut distinguer trois approches principales en NLP :

NLP basé sur des règles (Rule-based)

C’est la première méthode utilisée. Les programmeurs écrivent un ensemble de règles linguistiques sous forme de conditions if-then pour que la machine traite les phrases.

Par exemple, les premiers systèmes de réponse automatique ne pouvaient répondre qu’à des modèles de phrases prédéfinis. Cette approche n’utilise pas l’apprentissage automatique, donc elle est très limitée – le système ne comprend que ce que l’humain lui enseigne de manière rigide, sans apprendre par lui-même. Le NLP basé sur des règles nécessite que les experts en linguistique écrivent les règles, ce qui rend difficile l’extension à grande échelle à cause de la diversité du langage.

NLP statistique (Statistical)

À partir des années 1990, le NLP s’est orienté vers l’apprentissage automatique statistique. Au lieu d’écrire des règles manuellement, on utilise des algorithmes d’apprentissage machine pour que la machine apprenne des modèles linguistiques à partir des données. Cette méthode permet un traitement du langage naturel plus souple et précis, car la machine peut calculer la probabilité d’un sens adapté pour un mot ou une phrase selon le contexte.

Par exemple, un algorithme d’étiquetage grammatical (POS tagging) apprend à partir de données annotées pour déterminer la probabilité qu’un mot soit un nom ou un verbe dans un contexte donné. Le NLP statistique a permis de créer des applications efficaces comme la correction orthographique et la suggestion de mots (comme le T9 sur les anciens téléphones).

NLP par apprentissage profond (Deep learning)

Depuis la fin des années 2010, le deep learning avec des modèles de réseaux neuronaux est devenu la méthode dominante en NLP. Grâce à la quantité massive de données textuelles sur Internet et à la puissance de calcul accrue, les modèles deep learning peuvent apprendre automatiquement des représentations du langage à un niveau d’abstraction très élevé.

Le modèle Transformer (introduit en 2017) a marqué une avancée majeure : ce modèle apprend les relations sémantiques entre les mots dans une phrase via un mécanisme de self-attention, permettant une meilleure compréhension du contexte. Google a lancé le modèle BERT basé sur Transformer pour améliorer significativement la qualité de ses recherches.

Ensuite, des modèles autoregressifs comme GPT-2, GPT-3 sont entraînés à prédire le mot suivant, ouvrant la voie à la génération fluide de texte sans précédent. Aujourd’hui, grâce au deep learning, nous disposons de modèles linguistiques de très grande taille (LLM) tels que GPT-4, LLaMA, PaLM… capables de comprendre et de générer un langage très naturel, atteignant parfois un niveau proche de l’humain dans de nombreuses tâches linguistiques.

Par ailleurs, une tendance moderne est l’utilisation de modèles fondamentaux (foundation models) – de grands modèles d’IA pré-entraînés sur des milliards de mots. Ces modèles (comme GPT-4 d’OpenAI ou Granite d’IBM) peuvent être rapidement adaptés à diverses tâches NLP, allant de la génération de texte significative à l’extraction d’informations spécialisées.

L’exploitation de modèles préexistants permet de gagner du temps d’entraînement et d’obtenir de meilleurs résultats, tout en ouvrant la voie à de nouvelles méthodes comme la génération augmentée par récupération d’informations externes (retrieval-augmented generation) pour améliorer la précision des réponses. Cela montre que le NLP évolue très rapidement et innove constamment sur le plan technique.

Défis et nouvelles tendances en NLP

Malgré les nombreux progrès, le traitement du langage naturel fait encore face à des défis importants. Le langage humain est extrêmement riche et varié : une même phrase peut avoir plusieurs sens selon le contexte, sans parler des argots, expressions idiomatiques, jeux de mots, ironie. Aider les machines à comprendre correctement toutes les nuances du langage humain dans tous les cas reste un défi majeur.

Par exemple, la phrase « La pomme ne tombe pas loin de l’arbre » – la machine doit comprendre qu’il s’agit d’une expression idiomatique au sens figuré, et non d’une description littérale. Pour répondre correctement aux questions des utilisateurs, un système NLP doit posséder une connaissance de fond assez large et une capacité de raisonnement, au-delà de la simple compréhension mot à mot.

Un autre défi concerne les langues régionales et le multilinguisme. Chaque langue a ses particularités (le vietnamien diffère de l’anglais par son alphabet, sa structure de phrase ; le japonais et le chinois n’ont pas d’espaces entre les mots, etc.).

Le NLP doit s’adapter à chaque langue. Aujourd’hui, la tendance est de développer des modèles multilingues, voire multimodaux (NLP multimodal – traitant simultanément texte, images, sons) pour que les machines comprennent le langage dans un contexte plus large.

En termes de tendances, le NLP moderne vise à créer des systèmes plus intelligents et plus « compréhensifs ». Les modèles linguistiques de plus en plus grands (avec plus de paramètres et plus de données d’entraînement) comme GPT-4, GPT-5… devraient continuer à améliorer la compréhension et la génération de langage naturel.

Par ailleurs, les chercheurs s’intéressent aussi à rendre le NLP explicable (explainable NLP) – c’est-à-dire comprendre sur quelles caractéristiques linguistiques la machine base ses décisions, au lieu d’avoir une « boîte noire » opaque. Cela est crucial lorsque le NLP est utilisé dans des domaines sensibles comme la santé ou le droit, où il faut connaître les fondements des décisions prises par la machine.

Une autre tendance importante est l’intégration des connaissances du monde réel dans le NLP. Les nouveaux modèles peuvent combiner le traitement du langage avec des bases de connaissances ou des données externes pour mieux comprendre le contexte.

Par exemple, un système de questions-réponses peut consulter Wikipedia ou Internet en temps réel pour fournir des réponses précises, au lieu de se baser uniquement sur ce qu’il a appris. Le NLP se rapproche également de l’IA générale grâce à des recherches interdisciplinaires avec la cognition et les neurosciences, visant à simuler la manière dont les humains comprennent réellement le langage.

>>> Saviez-vous que :

Qu'est-ce que l'apprentissage automatique ?

Qu'est-ce que le Deep Learning ?

En résumé, le traitement du langage naturel a été, est et sera un domaine central de l’IA avec un potentiel immense. De l’aide à la compréhension du langage humain par les machines à l’automatisation de nombreuses tâches linguistiques, le NLP a un impact profond sur tous les aspects de la vie et de la technologie.

Avec le développement du deep learning et des données massives, nous pouvons espérer des générations futures de machines encore plus intelligentes, capables de communiquer de façon plus naturelle dans un avenir proche. Le traitement du langage naturel est la clé pour réduire la distance entre l’homme et la machine, rapprochant la technologie de la vie humaine de manière naturelle et efficace.