AI által generált karakterbeszélgetések a játékokban

Az AI átalakítja, hogyan lépnek kapcsolatba a játékbeli karakterek a játékosokkal. Ez a cikk bemutatja, hogyan működik az AI dinamikus NPC párbeszédek mögött, kiemeli a legjobb eszközöket, mint az Inworld AI, GPT-4 és Convai, valamint valós játékpéldákat vizsgál generatív beszélgetések használatával.

A videojátékok hagyományosan előre megírt párbeszédfákra támaszkodtak, ahol az NPC-k (nem játékos karakterek) rögzített mondatokat mondanak a játékos cselekedeteire válaszul. Ma a AI által vezérelt párbeszéd gépi tanulási modelleket – különösen nagy nyelvi modelleket (LLM-eket) – használ a karakterválaszok dinamikus generálására. Ahogy az Associated Press beszámol róla, a stúdiók most „kísérleteznek generatív AI-val az NPC párbeszédek megalkotásában”, hogy a világok „jobban reagáljanak” a játékos kreativitására.

Gyakorlatban ez azt jelenti, hogy az NPC-k emlékeznek a korábbi interakciókra, új mondatokkal válaszolnak, és szabad formájú beszélgetésekbe bocsátkoznak a sablonos válaszok ismétlése helyett. A játékstúdiók és kutatók megjegyzik, hogy az LLM-ek erős kontextusértése „természetes hangzású válaszokat” eredményez, amelyek kiválthatják a hagyományos párbeszéd-forgatókönyveket.

Miért fontos az AI párbeszéd

Bevonódás és újrajátszhatóság

Az NPC-k élethű személyiséget kapnak mélységgel és dinamikával, gazdagabb beszélgetéseket és erősebb játékosi elköteleződést teremtve.

Kontextuális tudatosság

A karakterek emlékeznek a korábbi találkozásokra és alkalmazkodnak a játékos döntéseihez, így a világok élőbbnek és reagálóbbnak tűnnek.

Emergens játékmenet

A játékosok szabad formában léphetnek interakcióba, előre nem meghatározott történeteket alakítva ahelyett, hogy előre megírt küldetésutakat követnének.

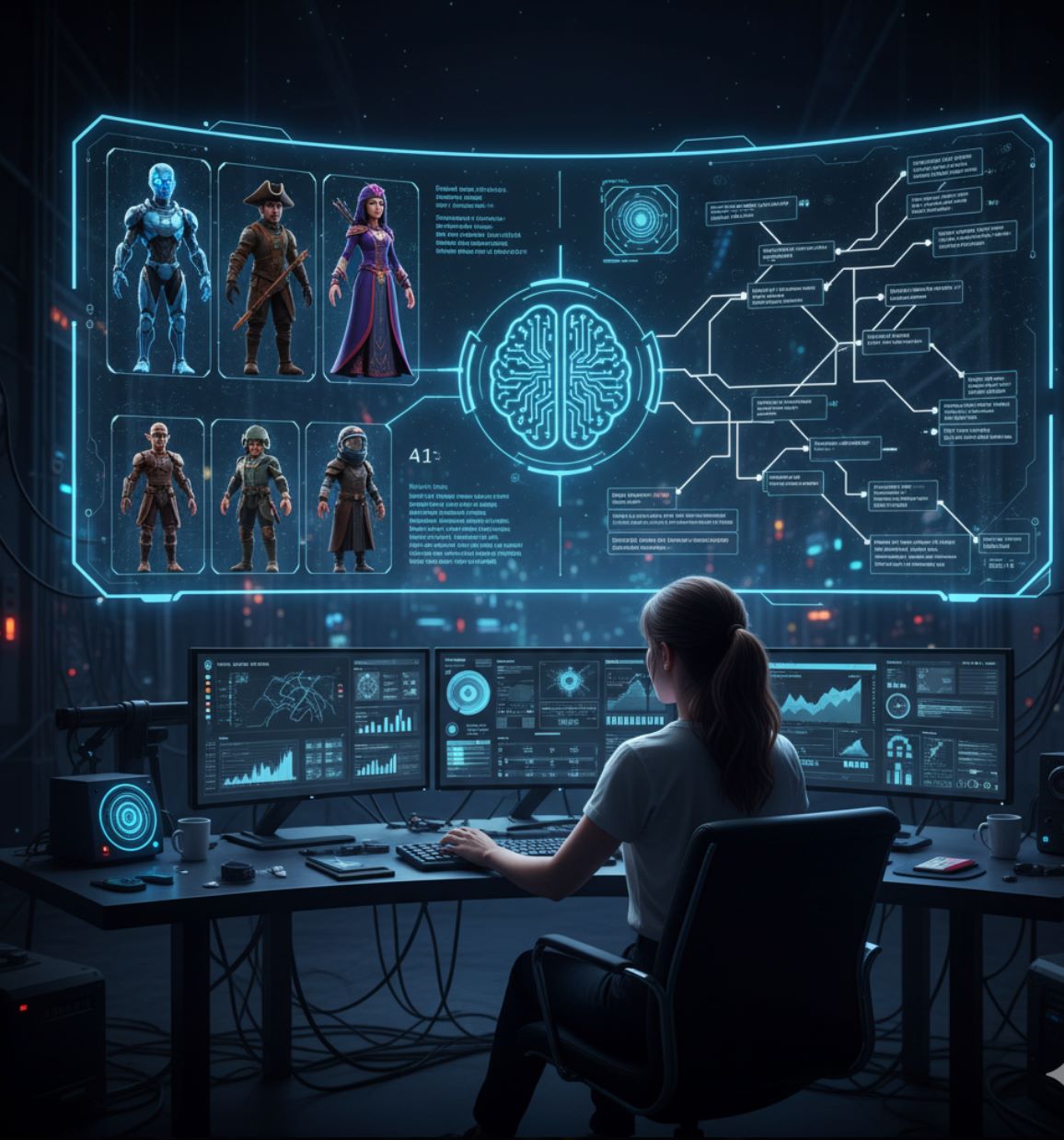

Az AI mint kreatív eszköz, nem helyettesítő

Az AI-alapú párbeszéd célja, hogy segítse a fejlesztőket, ne helyettesítse az emberi kreativitást. Az Ubisoft hangsúlyozza, hogy az írók és művészek továbbra is meghatározzák minden karakter alapvető identitását.

A fejlesztők „alakítják az NPC karakterét, háttértörténetét és beszédstílusát”, majd az AI-t „csak akkor használják, ha az értéket jelent számukra” – az AI „nem helyettesítheti” az emberi kreativitást.

— Ubisoft, NEO NPC projekt

Az Ubisoft „NEO NPC” prototípus projektjében a tervezők először megalkotják az NPC háttértörténetét és hangját, majd irányítják az AI-t, hogy kövesse ezt a karaktert. A generatív eszközök narratív „másodpilótaként” működnek, segítve az írókat az ötletek gyors és hatékony felfedezésében.

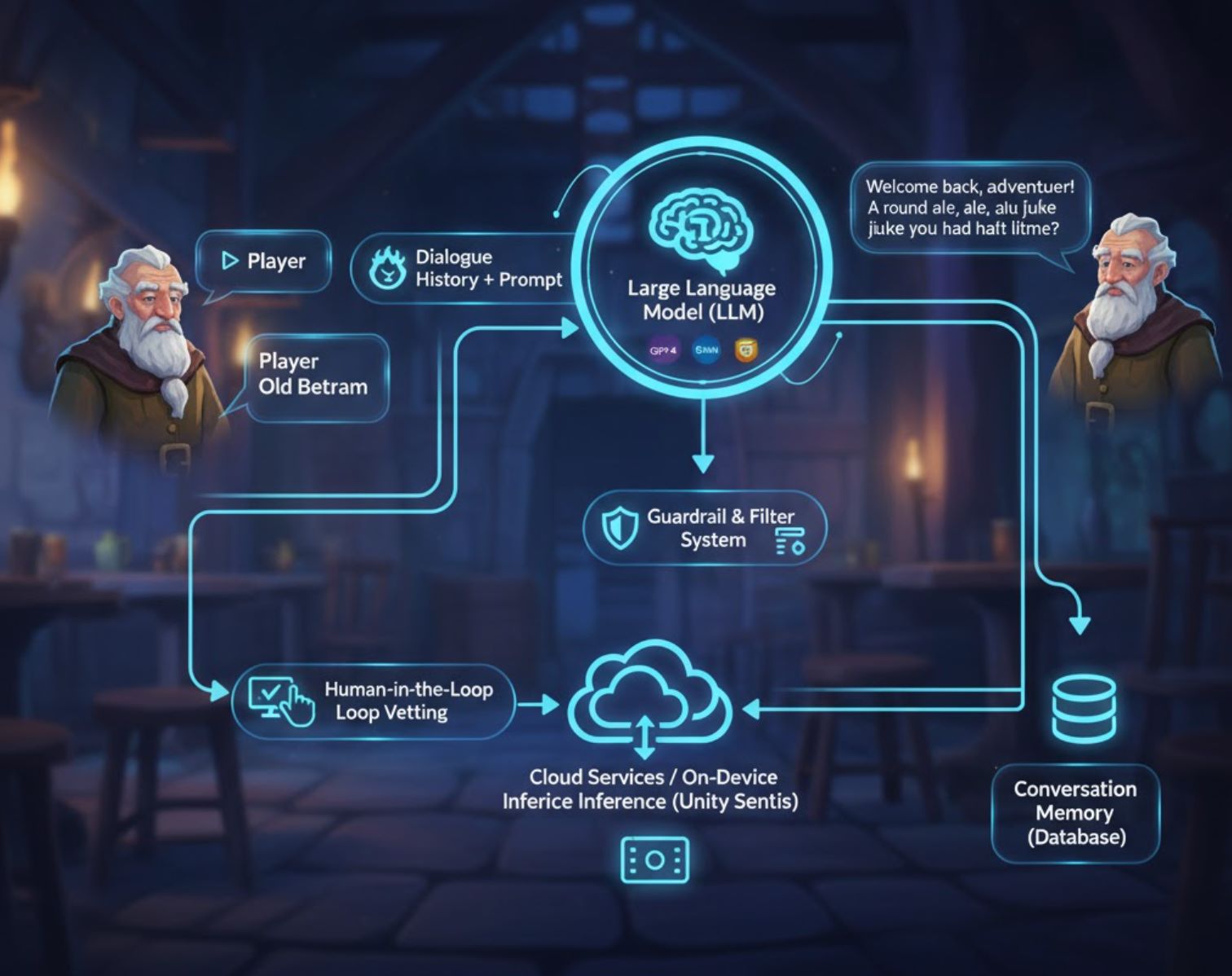

Hogyan működnek az AI párbeszéd rendszerek

A legtöbb AI párbeszéd rendszer nagy nyelvi modelleket (LLM-eket) használ, mint a GPT-4, Google Gemini vagy Claude – ideghálózatokat, amelyeket hatalmas szöveges adatokon tanítottak koherens válaszok generálására.

Karakter meghatározása

A fejlesztők megadnak egy promptot, amely leírja az NPC személyiségét és kontextusát (pl. „Ön egy idős kocsma-tulajdonos, Bertram bácsi, aki kedvesen beszél és emlékszik a játékos korábbi rendeléseire”)

Valós idejű generálás

Amikor a játékos beszél egy AI-NPC-vel, a játék elküldi a promptot és a párbeszéd előzményeit a nyelvi modellnek API-n keresztül

Válasz kézbesítése

Az AI visszaküld egy párbeszédsort, amelyet a játék valós időben vagy közel valós időben megjelenít vagy felolvas

Emlékezet megtartása

A beszélgetési naplókat tárolják, hogy az AI tudja, mi hangzott el korábban, és fenntartsa a koherenciát a munkamenetek között

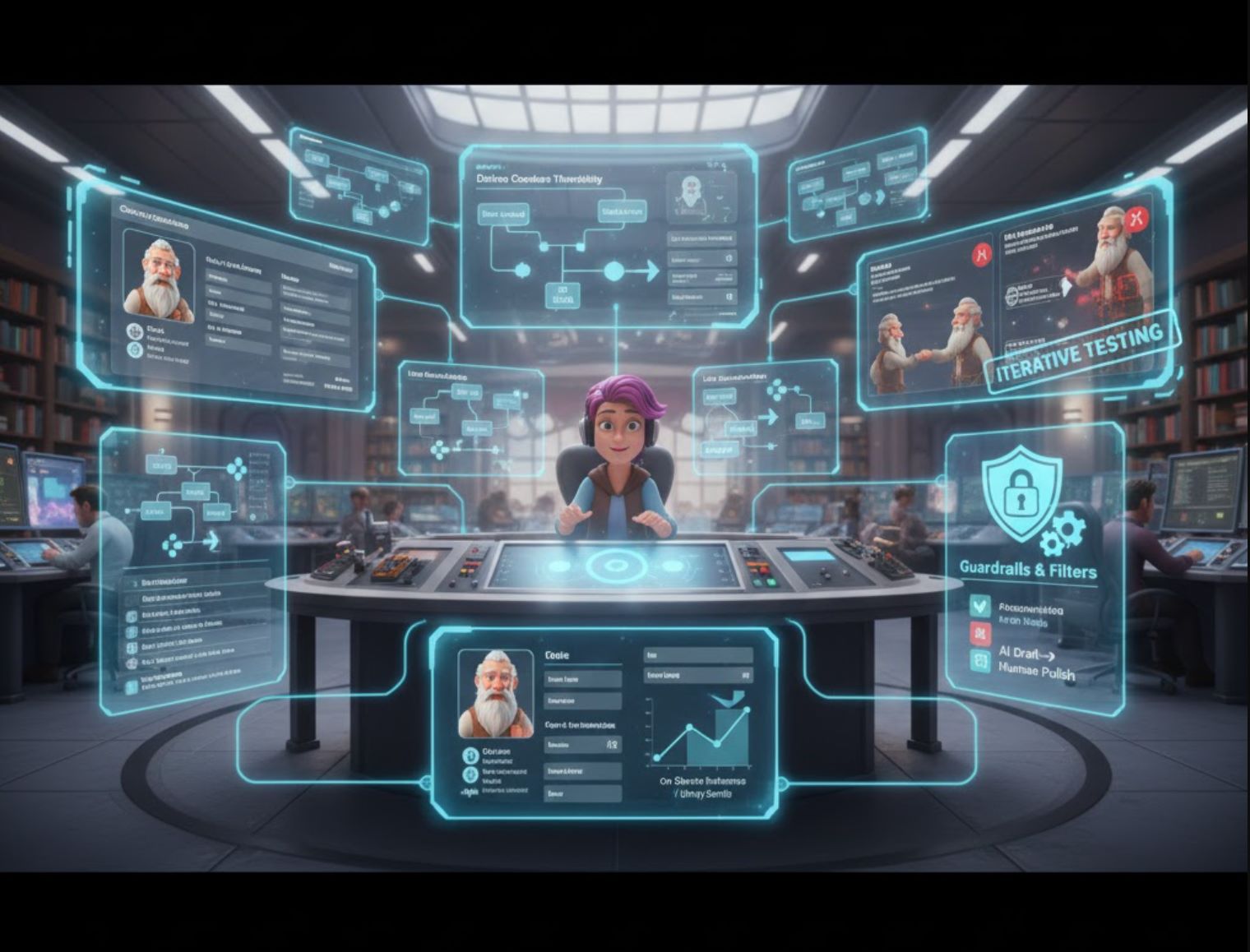

Biztonsági intézkedések és minőségellenőrzés

A csapatok többféle biztonsági intézkedést építenek be a karakterkonzisztencia fenntartására és a nem megfelelő válaszok megakadályozására:

- Védőkorlát rendszerek és toxicitás szűrők tartják az NPC-ket karakterükben

- Emberi felügyeletű iteráció: ha az NPC „úgy válaszolt, ahogy elképzeltük”, a fejlesztők megtartják; különben módosítják a modell promptokat

- Magas minőségű promptok biztosítják a magas minőségű párbeszédet („szemét be, szemét ki”)

- Felhőszolgáltatások vagy eszközön futó inferencia (pl. Unity Sentis) optimalizálják a teljesítményt és csökkentik a késleltetést

Előnyök és kihívások

Előnyök fejlesztőknek és játékosoknak

- Időmegtakarítás: Gyorsan vázolhatók a beszélgetések ahelyett, hogy minden sort kézzel írnának

- Kreatív ötletelés: Az AI-t kiindulópontként használva új párbeszédirányokat fedezhetnek fel

- Méretezhetőség: Hosszú csevegéseket és személyre szabott történetszálakat generálhatnak

- Játékosi elköteleződés: Az NPC-k, amelyek emlékeznek a korábbi találkozásokra, élőbbnek és alkalmazkodóbbnak tűnnek

- Emergens történetmesélés: A játékosok szabad formában alakíthatják az interakciókat sandbox vagy többjátékos játékokban

Kezelendő buktatók

- Értelmetlen beszélgetés: A korlátlan, véletlenszerű párbeszéd „csak végtelen zaj”, ami megtöri a beleélést

- Hallucináció: Az AI témán kívüli mondatokat generálhat, ha nem korlátozzák megfelelően a kontextussal

- Számítási költség: Az LLM API hívások nagy mennyiségben összeadódnak; a használati díjak megterhelhetik a költségvetést

- Etikai aggályok: Hangszínészek és írók aggódnak a munkahelyi eltolódás miatt

- Átláthatóság: Egyesek fontolgatják, hogy közöljék a játékosokkal az AI által írt sorokat

Eszközök és platformok AI párbeszédhez a játékokban

Game creators have many options for AI dialogue. Here are some notable tools and technologies:

Inworld AI

Application Information

| Developer | Inworld AI, Inc. |

| Supported Platforms |

|

| Language Support | Primarily English; multilingual voice generation and localization features in development. |

| Pricing Model | Freemium: free credits with pay-as-you-go usage for LLM dialogue and text-to-speech. |

Overview

Inworld AI is a generative AI platform designed to create highly realistic, emotionally intelligent non-player characters (NPCs) for games. By combining memory, goals, personality, and voice synthesis, it enables dynamic, context-aware conversations that evolve based on player behavior and world state. Game developers can build AI-driven characters using visual tools, then integrate them with game engines like Unreal or via API.

Key Features

Characters with memory, goals, and emotional dynamics that respond naturally to player interactions.

No-code, graph-based Studio interface to define personality, knowledge, relationships, and dialogue style.

Low-latency TTS with built-in voice archetypes tailored for gaming and emotional nuance.

NPCs recall past interactions and evolve relationships with players over time.

Filter character knowledge and moderate responses to ensure realistic and safe NPC behavior.

SDKs and plugins for Unreal Engine, Unity (early access), and Node.js agent templates.

Download or Access

Getting Started

Sign up for an Inworld Studio account on the Inworld website to access the character builder.

Use Studio to define persona, memory, emotional graphs, and knowledge base for your NPC.

Download the Unreal Runtime SDK or Unity plugin, then import character template components into your project.

Set up player input (speech or text), connect to the dialogue graph, and map output to text-to-speech and lip-sync.

Define what your NPC knows and how its knowledge evolves in response to player actions over time.

Prototype interactions in Studio, review generated dialogue, tune character goals and emotional weights, then re-deploy.

Use the API or integrated SDK to launch your AI-driven NPCs in your game or interactive experience.

Important Considerations

Configuration & Optimization

- Memory tuning and safety filtering require careful configuration to prevent unrealistic or unsafe NPC responses

- Voice localization is expanding but not all languages are currently available

- Test character behavior thoroughly before production deployment to ensure quality interactions

Frequently Asked Questions

Yes, Inworld Studio provides a no-code, graph-based interface to design character personality, dialogue, and behavior without programming knowledge.

Yes, Inworld includes an expressive text-to-speech API with gaming-optimized voices and built-in character archetypes. TTS is integrated into the Inworld Engine.

Inworld uses usage-based pricing: you pay per million characters for text-to-speech and compute costs for LLM dialogue generation. Free credits are available to get started.

Yes, Inworld supports long-term memory, allowing NPCs to recall past interactions and maintain evolving relationships with players across multiple sessions.

Yes, the Inworld AI NPC Engine plugin is available on the Epic Games Marketplace for Unreal Engine integration.

HammerAI

Application Information

| Developer | HammerAI (solo-developer / small team) |

| Supported Platforms |

|

| Language Support | Primarily English; character creation supports various styles without geographic limitations |

| Pricing Model | Free tier with unlimited conversations and characters; paid plans (Starter, Advanced, Ultimate) offer expanded context size and advanced features |

Overview

HammerAI is a powerful AI platform designed for creating realistic, expressive character dialogue. It empowers writers, game developers, and role-players to interact with AI-driven personas through intuitive chat, enabling them to build rich lore, backstories, and immersive conversations. The platform supports both local language models and cloud-hosted options, providing flexibility between privacy and scalability.

Key Features

Free tier supports unlimited chats and character creation without restrictions.

Run powerful LLMs locally via desktop for privacy or use cloud-hosted models for convenience.

Build detailed lore, backstories, and character settings to enrich dialogue and maintain consistency.

Specialized mode for writing dialogues for game cutscenes and interactive narrative sequences.

Desktop app supports image generation during chats using built-in models like Flux.

Invite up to 10 characters in a single group chat for complex multi-character interactions.

Detailed Introduction

HammerAI provides a unique environment for creating and conversing with AI characters. Through the desktop application, users can run language models locally on their own hardware using ollama or llama.cpp, ensuring privacy and offline functionality. For those preferring cloud-based solutions, HammerAI offers secure remote hosting for unlimited AI chat without requiring an account.

The character system supports lorebooks, personal backstories, and dialogue style tuning, making it ideal for narrative development in games, scripts, and interactive fiction. The platform includes specialized tools for cutscene dialogue generation, enabling rapid creation of cinematic and game-story sequences with proper formatting for spoken dialogue, thoughts, and narration.

Download or Access

Getting Started Guide

Get HammerAI from its itch.io page for Windows, macOS, or Linux.

Use the "Models" tab in the desktop app to download language models like Mistral-Nemo or Smart Lemon Cookie.

Pick from existing AI character cards or create your own custom character via Author Mode.

Enter dialogue or actions using normal text for speech or italics for narration and thoughts.

Click "Regenerate" if unsatisfied with the AI's reply, or edit your input to guide better responses.

Create and store character backstories and world lore to maintain consistent context throughout conversations.

Switch to cutscene dialogue mode to write cinematic or interactive narrative exchanges for games and stories.

Limitations & Important Notes

- Offline use requires downloading character and model files in advance

- Cloud models limited to 4,096 token context on free plan; higher-tier plans offer expanded context

- Chats and characters stored locally; cross-device sync unavailable due to lack of login system

- Cloud-hosted models use content filters; local models are less restricted

- Local model performance depends on available RAM and GPU resources

Frequently Asked Questions

Yes — HammerAI offers a free tier that supports unlimited conversations and character creation. Paid plans (Starter, Advanced, Ultimate) provide expanded context size and additional features for advanced users.

Yes, via the desktop app running local language models. You must download character and model files in advance to enable offline functionality.

Yes — the desktop app supports image generation during chat using built-in models like Flux, allowing you to create visual content alongside your conversations.

Use the lorebook feature to build and manage character backstories, personality traits, and world knowledge. This ensures consistent context throughout your conversations.

You can regenerate the response, edit your inputs to provide better guidance, or adjust your roleplay prompts to guide the AI toward better output quality.

Large Language Models (LLMs)

Application Information

| Developer | Multiple providers: OpenAI (GPT series), Meta (LLaMA), Anthropic (Claude), and others |

| Supported Platforms |

|

| Language Support | Primarily English; multilingual support varies by model (Spanish, French, Chinese, and more available) |

| Pricing Model | Freemium or paid; free tiers available for some APIs, while larger models or high-volume usage require subscription or pay-as-you-go plans |

Overview

Large Language Models (LLMs) are advanced AI systems that generate coherent, context-aware text for dynamic gaming experiences. In game development, LLMs power intelligent NPCs with real-time dialogue, adaptive storytelling, and interactive roleplay. Unlike static scripts, LLM-powered characters respond to player input, maintain conversation memory, and create unique narrative experiences that evolve with player choices.

How LLMs Work in Games

LLMs analyze vast amounts of text data to predict and generate natural language outputs tailored to game contexts. Developers use prompt engineering and fine-tuning to shape NPC responses while maintaining story coherence. Advanced techniques like retrieval-augmented generation (RAG) enable characters to remember previous interactions and lore, creating believable, immersive NPCs for role-playing, adventure, and narrative-driven games.

Creates context-sensitive NPC conversations in real time, responding naturally to player input.

Generates quests, events, and narrative branches that adapt to game state and player decisions.

Maintains character consistency using defined backstories, goals, and personality traits.

Recalls prior interactions and game world facts for coherent multi-turn dialogue and persistent character knowledge.

Download or Access

Getting Started

Choose a model (OpenAI GPT, Meta LLaMA, Anthropic Claude) that matches your game's requirements and performance needs.

Use cloud APIs for convenience or set up local instances on compatible hardware for greater control and privacy.

Create detailed NPC backstories, personality traits, and knowledge databases to guide LLM responses.

Craft prompts that guide LLM responses according to game context, player input, and narrative goals.

Connect LLM outputs to your game's dialogue systems using SDKs, APIs, or custom middleware solutions.

Evaluate NPC dialogue quality, refine prompts, and adjust memory handling to ensure consistency and immersion.

Important Considerations

- Hallucinations: LLMs can produce incoherent or factually incorrect dialogue if prompts are ambiguous; use clear, specific instructions

- Hardware & Latency: Real-time integration requires powerful hardware or cloud infrastructure for responsive gameplay

- Ethical & Bias Risks: LLM outputs may include unintended biases; implement moderation and careful prompt design

- Subscription Costs: High-volume or fine-tuned models typically require paid API access

Frequently Asked Questions

Yes. With proper persona design, memory integration, and prompt engineering, LLMs can maintain character consistency across multiple interactions and conversations.

Yes, though performance depends on hardware or cloud latency. Smaller local models may be preferred for real-time responsiveness, while cloud APIs work well for turn-based or asynchronous gameplay.

Many models support multilingual dialogue, but quality varies depending on the language and specific model. Test thoroughly for your target languages.

Implement moderation filters, constrain prompts with clear guidelines, and use safety layers provided by the model platform. Regular testing and community feedback help identify and address issues.

Some free tiers exist for basic usage, but larger context models or high-volume scenarios generally require subscription or pay-as-you-go plans. Evaluate costs based on your game's scale and player base.

Convai

Application Information

| Developer | Convai Technologies Inc. |

| Supported Platforms |

|

| Language Support | 65+ languages supported globally via web-based and engine integrations. |

| Pricing Model | Free access to Convai Playground; enterprise and large-scale deployments require paid plans or licensing contact. |

What is Convai?

Convai is a conversational AI platform that empowers developers to create highly interactive, embodied AI characters (NPCs) for games, XR worlds, and virtual experiences. These intelligent agents perceive their environment, listen and speak naturally, and respond in real time. With seamless integrations into Unity, Unreal Engine, and web environments, Convai brings lifelike virtual humans to life, adding immersive narrative depth and realistic dialogue to interactive worlds.

Key Features

NPCs respond intelligently to voice, text, and environmental stimuli for dynamic interactions.

Low-latency voice-based chat with AI characters for natural, immersive dialogue.

Upload documents and lore to shape character knowledge and maintain consistent, context-aware conversations.

Graph-based tools to define triggers, objectives, and dialogue flows while maintaining flexible, open-ended interactions.

Native Unity SDK and Unreal Engine plugin for seamless AI NPC embedding into your projects.

Enable AI characters to converse autonomously with each other in shared scenes for dynamic storytelling.

Download or Access

Getting Started Guide

Create your Convai account via their website to access the Playground and start building AI characters.

In the Playground, define your character's personality, backstory, knowledge base, and voice settings to bring them to life.

Use Convai's Narrative Design graph to establish triggers, decision points, and objectives that guide character behavior.

Unity: Download the Convai Unity SDK from the Asset Store, import it, and configure your API key.

Unreal Engine: Install the Convai Unreal Engine plugin (Beta) to enable voice, perception, and real-time conversations.

Activate Convai's NPC2NPC system to allow AI characters to converse autonomously with each other.

Playtest your scenes thoroughly, refine machine-learning parameters, dialogue triggers, and character behaviors based on feedback.

Important Limitations & Considerations

- Character avatars created in Convai's web tools may require external models for game engine export.

- Managing narrative flow across multiple AI agents requires careful design and planning.

- Real-time voice conversations may experience latency depending on backend performance and network conditions.

- Complex or high-scale deployments typically require enterprise-level licensing; free-tier access is primarily through the Playground.

Frequently Asked Questions

Yes — Convai supports NPC-to-NPC conversations through its NPC2NPC feature in both Unity and Unreal Engine, enabling autonomous character interactions.

Basic character creation is no-code via the Playground, but integrating with game engines (Unity, Unreal) requires development skills and technical knowledge.

Yes — you can define a knowledge base and memory system for each character, ensuring consistent, context-aware dialogue throughout interactions.

Yes — real-time voice-based conversations are fully supported, including speech-to-text and text-to-speech capabilities for natural interactions.

Yes — Convai offers enterprise options including on-premises deployment and security compliance certifications such as ISO 27001 for commercial and large-scale projects.

Nvidia ACE

Application Information

| Developer | NVIDIA Corporation |

| Supported Platforms |

|

| Language Support | Multiple languages for text and speech; globally available to developers |

| Pricing Model | Enterprise/developer access through NVIDIA program; commercial licensing required |

What is NVIDIA ACE?

NVIDIA ACE (Avatar Cloud Engine) is a generative AI platform that empowers developers to create intelligent, lifelike NPCs for games and virtual worlds. It combines advanced language models, speech recognition, voice synthesis, and real-time facial animation to deliver natural, interactive dialogues and autonomous character behavior. By integrating ACE, developers can build NPCs that respond contextually, converse naturally, and exhibit personality-driven behaviors, significantly enhancing immersion in gaming experiences.

How It Works

NVIDIA ACE leverages a suite of specialized AI components working in concert:

- NeMo — Advanced language understanding and dialogue modeling

- Riva — Real-time speech-to-text and text-to-speech conversion

- Audio2Face — Real-time facial animation, lip-sync, and emotional expressions

NPCs powered by ACE perceive audio and visual cues, plan actions autonomously, and interact with players through realistic dialogue and expressions. Developers can fine-tune NPC personalities, memories, and conversational context to create consistent, immersive interactions. The platform supports integration into popular game engines and cloud deployment, enabling scalable AI character implementations for complex gaming scenarios.

Key Features

Fine-tune NPC dialogue with character backstories, personalities, and conversational context.

Speech-to-text and text-to-speech powered by NVIDIA Riva for natural voice interactions.

Real-time facial expressions and lip-sync using Audio2Face in NVIDIA Omniverse.

NPCs perceive audio and visual inputs, act autonomously, and make intelligent decisions.

Cloud or on-device deployment via flexible SDK for scalable, efficient integration.

Get Started

Installation & Setup Guide

Sign up for NVIDIA Developer program to obtain ACE SDK, API credentials, and documentation.

Ensure you have an NVIDIA GPU (RTX series recommended) or cloud instance provisioned for real-time AI inference and processing.

Set up and configure the three core components:

- NeMo — Deploy for dialogue modeling and language understanding

- Riva — Configure for speech-to-text and text-to-speech services

- Audio2Face — Enable for real-time facial animation and expressions

Configure personality traits, memory systems, behavior parameters, and conversational guardrails for each NPC character.

Connect ACE components to Unity, Unreal Engine, or your custom game engine to enable NPC interactions within your game world.

Evaluate dialogue quality, animation smoothness, and response latency. Fine-tune AI parameters and hardware allocation for optimal gameplay experience.

Important Considerations

Frequently Asked Questions

Yes. NVIDIA Riva provides real-time speech-to-text and text-to-speech capabilities, enabling NPCs to carry on natural, voice-based conversations with players.

Yes. Audio2Face provides real-time facial animation, lip-sync, and emotional expressions, making NPCs visually expressive and emotionally engaging.

Yes. With RTX GPUs or optimized cloud deployment, ACE supports low-latency interactions suitable for real-time gaming scenarios.

Yes. Engine integration and multi-component setup require solid programming knowledge and experience with game development frameworks.

No. Access is available through NVIDIA's developer program. Enterprise licensing or subscription is required for commercial use.

Legjobb gyakorlatok fejlesztőknek

Karakterek alapos meghatározása

Írjon világos háttértörténetet és stílust minden NPC-nek. Ezt használja az AI „rendszer promptjaként”, hogy tudja, hogyan beszéljen. Az Ubisoft kísérletében az írók részletes karakterjegyzeteket készítettek, mielőtt bevonták az AI-t.

Kontextus fenntartása

Minden promptba foglalja bele a releváns játék kontextust. Adja át a játékos legutóbbi csevegését és minden fontos játékelemzést (elvégzett küldetések, kapcsolatok), hogy az AI válasza témán belül maradjon. Sok rendszer tárolja a beszélgetési előzményeket, hogy memóriát szimuláljon.

Védőkorlátok használata

Adjon hozzá szűrőket és korlátozásokat. Állítson be szavak listáját, amelyeket az AI-nak kerülni kell, vagy programozzon trigger pontokat speciális párbeszédfákhoz. Az Ubisoft védőkorlátokat használt, hogy az NPC soha ne térjen el személyiségétől.

Iteratív tesztelés

Játéktesztelje a beszélgetéseket és finomítsa a promptokat. Ha egy NPC válasz nem illik a karakterhez, módosítsa a bemenetet vagy adjon példapárbeszédeket. Ha a válasz nem igazán az ön karaktere, térjen vissza és derítse ki, mi történt a modellben.

Költség és teljesítmény kezelése

Használja az AI-t stratégiailag. Nem szükséges AI minden eldobható sorhoz. Fontolja meg a gyakori válaszok előre generálását vagy az AI és a hagyományos párbeszédfák kombinálását. A Unity Sentis motor optimalizált modelleket futtathat eszközön, csökkentve a szerverhívásokat.

AI és kézi írás ötvözése

Emlékezzen, hogy az emberi íróknak kell kurálniuk az AI kimenetet. Használja az AI-t inspirációként, ne végső hangként. A narratív ívet az embereknek kell megalkotniuk. Sok csapat AI-t használ vázlatkészítéshez vagy párbeszédek bővítéséhez, majd átnézi és csiszolja az eredményeket.

A játékbeli párbeszédek jövője

Az AI új korszakot nyit a videojáték párbeszédekben. Az indie modoktól a AAA K+F laborokig a fejlesztők generatív modelleket alkalmaznak, hogy az NPC-k beszéljenek, reagáljanak és emlékezzenek, mint még soha. Hivatalos kezdeményezések, mint a Microsoft Project Explora és az Ubisoft NEO NPC, mutatják, hogy az ipar elfogadja ezt a technológiát – mindig szem előtt tartva az etikát és az írói felügyeletet.

A mai eszközök (GPT-4, Inworld AI, Convai, Unity eszközök és mások) lehetővé teszik a készítők számára, hogy gyorsan prototípust készítsenek gazdag párbeszédekből. A jövőben teljesen procedurális narratívákat és személyre szabott történeteket láthatunk majd pillanatnyi generálással. Egyelőre az AI párbeszéd több kreatív rugalmasságot és beleélést jelent, amennyiben felelősségteljesen, az emberi művészettel együtt használjuk.

Comments 0

Leave a Comment

No comments yet. Be the first to comment!