¿Qué es Edge AI?

Edge AI (Inteligencia Artificial en el Borde) es la combinación de inteligencia artificial (IA) y computación en el borde. En lugar de enviar datos a la nube para su procesamiento, Edge AI permite que dispositivos inteligentes como teléfonos, cámaras, robots o máquinas IoT analicen y tomen decisiones directamente en el dispositivo. Este enfoque ayuda a reducir la latencia, ahorrar ancho de banda, mejorar la seguridad y proporcionar una respuesta en tiempo real.

Edge AI (a veces llamado "IA en el borde") significa ejecutar modelos de inteligencia artificial y aprendizaje automático en dispositivos locales (sensores, cámaras, teléfonos inteligentes, gateways industriales, etc.) en lugar de en centros de datos remotos. En otras palabras, el "borde" de la red – donde se generan los datos – maneja el procesamiento. Esto permite que los dispositivos analicen los datos inmediatamente al ser recolectados, en lugar de enviar constantemente datos sin procesar a la nube.

Edge AI permite el procesamiento en tiempo real y en el dispositivo sin depender de un servidor central. Por ejemplo, una cámara con Edge AI puede detectar y clasificar objetos al instante, proporcionando retroalimentación inmediata. Al procesar datos localmente, Edge AI puede funcionar incluso con conexión a internet intermitente o sin ella.

— IBM Research

En resumen, Edge AI simplemente acerca el cómputo a la fuente de datos – desplegando inteligencia en dispositivos o nodos cercanos, lo que acelera las respuestas y reduce la necesidad de transmitir todo a la nube.

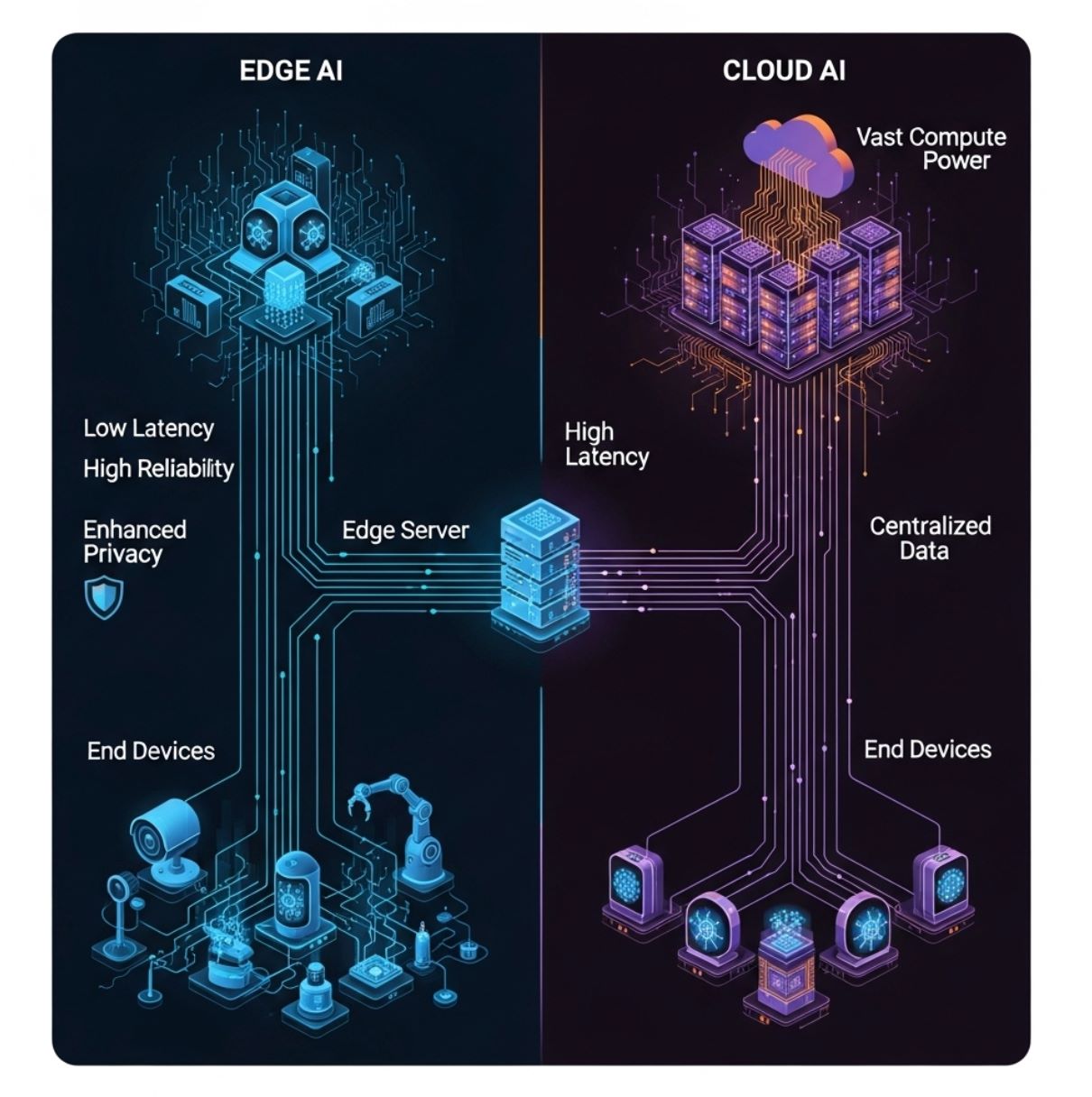

Edge AI vs Cloud AI: Diferencias clave

A diferencia de la IA tradicional basada en la nube (que envía todos los datos a servidores centralizados), Edge AI distribuye el procesamiento entre hardware local. El diagrama a continuación ilustra un modelo simple de computación en el borde: los dispositivos finales (capa inferior) envían datos a un servidor o gateway en el borde (capa media) en lugar de solo a la nube distante (capa superior).

En esta configuración, la inferencia de IA puede ocurrir en el dispositivo o en el nodo local del borde, reduciendo significativamente los retrasos en la comunicación.

Enfoque tradicional

- Datos enviados a servidores remotos

- Mayor latencia debido a retrasos en la red

- Requiere conectividad continua

- Recursos de cómputo ilimitados

- Preocupaciones de privacidad con la transmisión de datos

Enfoque moderno

- Procesamiento local en dispositivos

- Tiempos de respuesta en milisegundos

- Funciona sin conexión cuando es necesario

- Recursos limitados pero eficientes

- Protección mejorada de la privacidad

Latencia

Edge AI minimiza el retraso. Debido a que el procesamiento es local, las decisiones pueden ocurrir en milisegundos.

- Crítico para tareas sensibles al tiempo

- Evitar accidentes de tráfico

- Controlar robots en tiempo real

Ancho de banda

Edge AI reduce la carga de la red al analizar o filtrar datos en el sitio.

- Mucho menos información enviada hacia arriba

- Más eficiente y rentable

- Reduce la congestión de la red

Privacidad/Seguridad

Los datos sensibles pueden procesarse y almacenarse en el dispositivo, sin transmitirse nunca a la nube.

- Voz, imágenes, lecturas de salud permanecen locales

- Reduce la exposición a brechas de terceros

- Reconocimiento facial sin subir fotos

Recursos de cómputo

Los dispositivos en el borde tienen potencia limitada pero usan modelos optimizados.

- Modelos compactos y cuantificados

- El entrenamiento aún ocurre en la nube

- Tamaño limitado pero eficiente

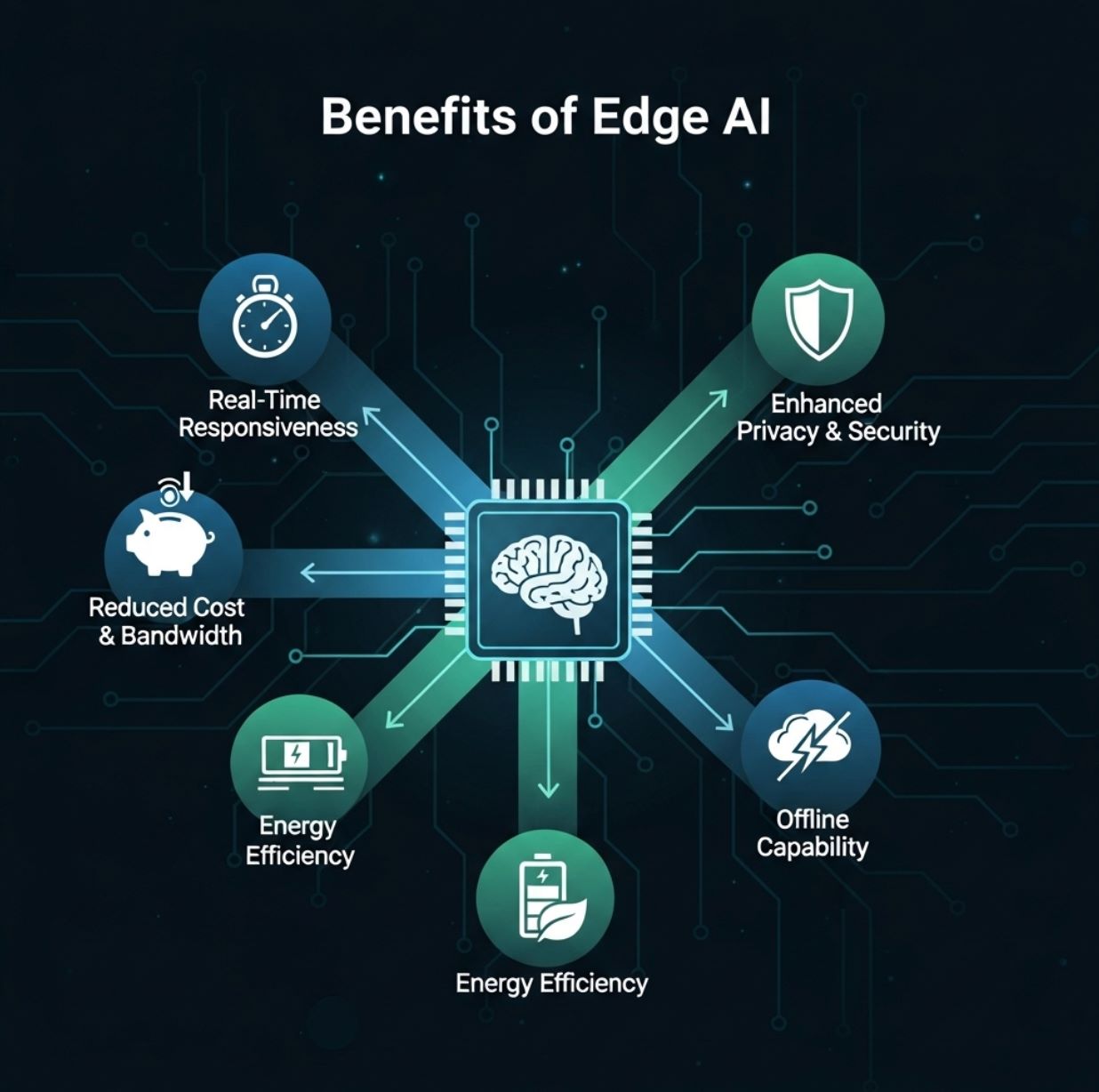

Beneficios de Edge AI

Edge AI ofrece varias ventajas prácticas para usuarios y organizaciones:

Respuesta en tiempo real

- Detección de objetos en vivo

- Sistemas de respuesta por voz

- Alertas de anomalías

- Aplicaciones de realidad aumentada

Reducción de ancho de banda y costos

- Cámaras de seguridad suben solo clips de amenazas

- Menor transmisión continua

- Gastos reducidos en hosting en la nube

Privacidad mejorada

- Crítico para salud y finanzas

- Los datos permanecen dentro del país o instalación

- Cumplimiento con regulaciones de privacidad

Eficiencia energética y de costos

- Menor consumo energético

- Costos reducidos de servidores

- Optimizado para dispositivos móviles

Edge AI lleva capacidades de cómputo de alto rendimiento al borde, permitiendo análisis en tiempo real y mayor eficiencia.

— Informe conjunto Red Hat & IBM

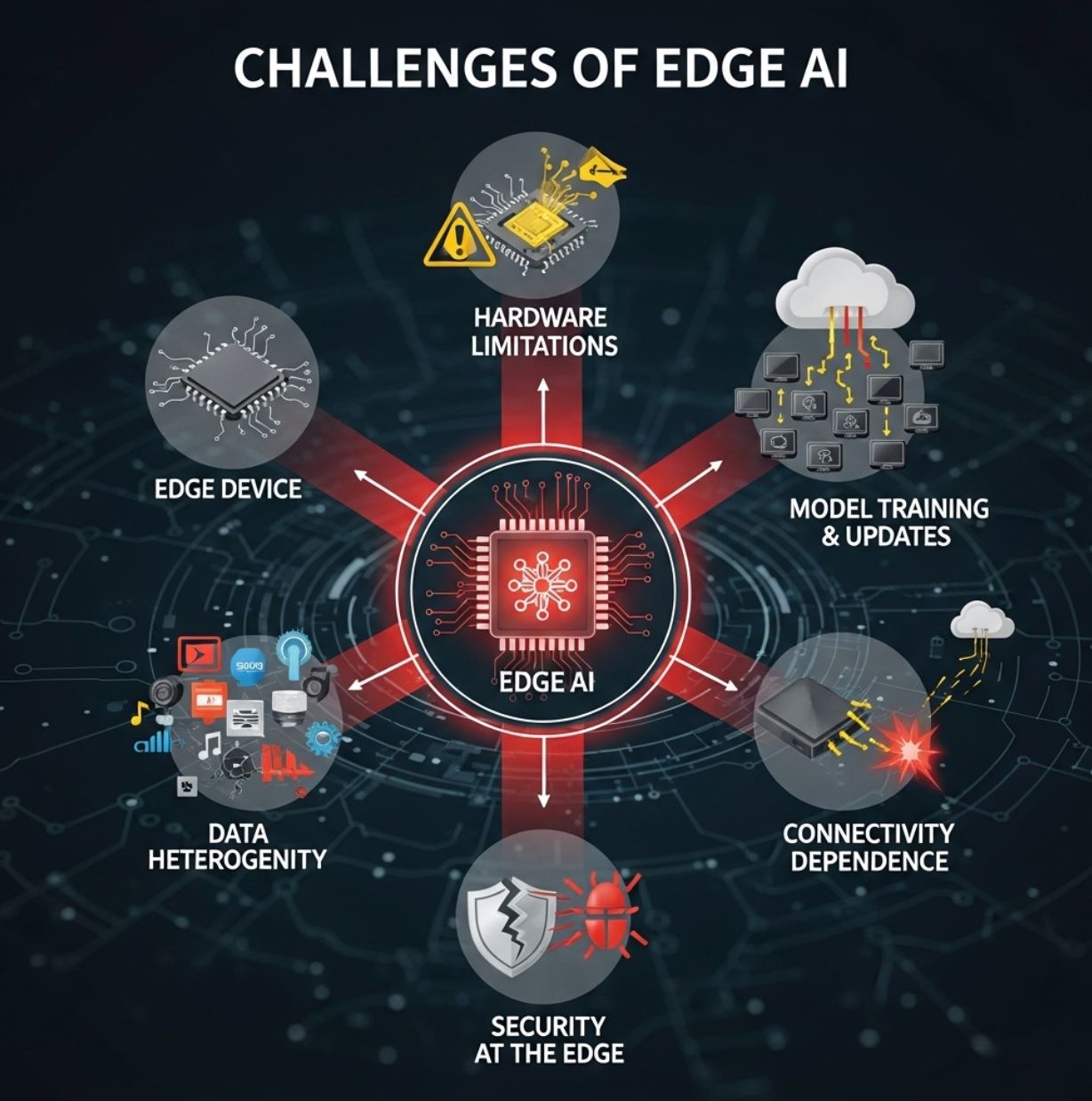

Desafíos de Edge AI

A pesar de sus ventajas, Edge AI también enfrenta obstáculos importantes:

Limitaciones de hardware

Los dispositivos en el borde suelen ser pequeños y con recursos limitados. Pueden tener CPUs modestos o NPUs especializadas de bajo consumo, y memoria limitada.

- Obliga a usar compresión y poda de modelos

- Técnicas TinyML necesarias para microcontroladores

- Modelos complejos no pueden ejecutarse a gran escala

- Se puede sacrificar algo de precisión

Entrenamiento y actualizaciones de modelos

El entrenamiento de modelos sofisticados generalmente sigue ocurriendo en la nube, donde hay gran cantidad de datos y potencia de cómputo.

- Los modelos deben optimizarse y desplegarse en cada dispositivo

- Mantener miles de dispositivos actualizados es complejo

- La sincronización de firmware añade carga

- Control de versiones en sistemas distribuidos

Gravedad y heterogeneidad de datos

Los entornos de borde son diversos. Diferentes ubicaciones pueden recolectar distintos tipos de datos, y las políticas pueden variar según la región.

- Los datos tienden a permanecer locales

- Difícil obtener una visión global

- Los dispositivos vienen en todas formas y tamaños

- Desafíos de integración y estandarización

Seguridad en el borde

Aunque Edge AI puede mejorar la privacidad, también introduce nuevas preocupaciones de seguridad. Cada dispositivo o nodo es un posible objetivo para hackers.

- Los modelos deben ser a prueba de manipulaciones

- Requisitos de seguridad del firmware

- Superficie de ataque distribuida

- Se necesitan salvaguardas fuertes

Dependencias de conectividad

Aunque la inferencia puede ser local, los sistemas de borde a menudo dependen de la conectividad en la nube para tareas pesadas.

- Reentrenar modelos requiere acceso a la nube

- El análisis de datos a gran escala necesita conectividad

- Agregación de resultados distribuidos

- Conectividad limitada puede limitar funciones

Casos de uso de Edge AI

Edge AI se aplica en muchas industrias con impacto real:

Vehículos autónomos

Los autos autónomos usan Edge AI a bordo para procesar instantáneamente datos de cámaras y radares para navegación y evitar obstáculos.

- No pueden permitirse el retraso de enviar video a un servidor

- La detección de objetos ocurre localmente

- Reconocimiento de peatones en tiempo real

- Seguimiento de carril sin conectividad

Manufactura e Industria 4.0

Las fábricas despliegan cámaras inteligentes y sensores en líneas de producción para detectar defectos o anomalías en tiempo real.

Control de calidad

Las cámaras Edge AI detectan productos defectuosos en cintas transportadoras y activan acciones inmediatas.

Mantenimiento predictivo

Las máquinas industriales usan IA local para predecir fallos antes de que ocurran averías.

Salud y respuesta a emergencias

Dispositivos médicos portátiles y ambulancias ahora usan Edge AI para analizar datos del paciente en el lugar.

- Ultrasonido a bordo con análisis IA

- Monitores de signos vitales detectan lecturas anormales

- Alertan a paramédicos sobre lesiones internas

- Monitoreo en UCI con alarmas instantáneas

Ciudades inteligentes

Los sistemas urbanos usan Edge AI para gestión de tráfico, vigilancia y monitoreo ambiental.

Gestión de tráfico

Vigilancia

Monitoreo ambiental

Retail y IoT para consumidores

Edge AI mejora la experiencia y conveniencia del cliente en aplicaciones de retail y consumo.

Análisis en tienda

Cámaras inteligentes y sensores en estantes rastrean comportamiento de compradores y niveles de inventario al instante.

Dispositivos móviles

Los smartphones ejecutan reconocimiento de voz y facial en el dispositivo sin acceso a la nube para desbloqueo e identificación por gestos.

Seguimiento de fitness

Los wearables analizan datos de salud (ritmo cardíaco, pasos) localmente para ofrecer retroalimentación en tiempo real.

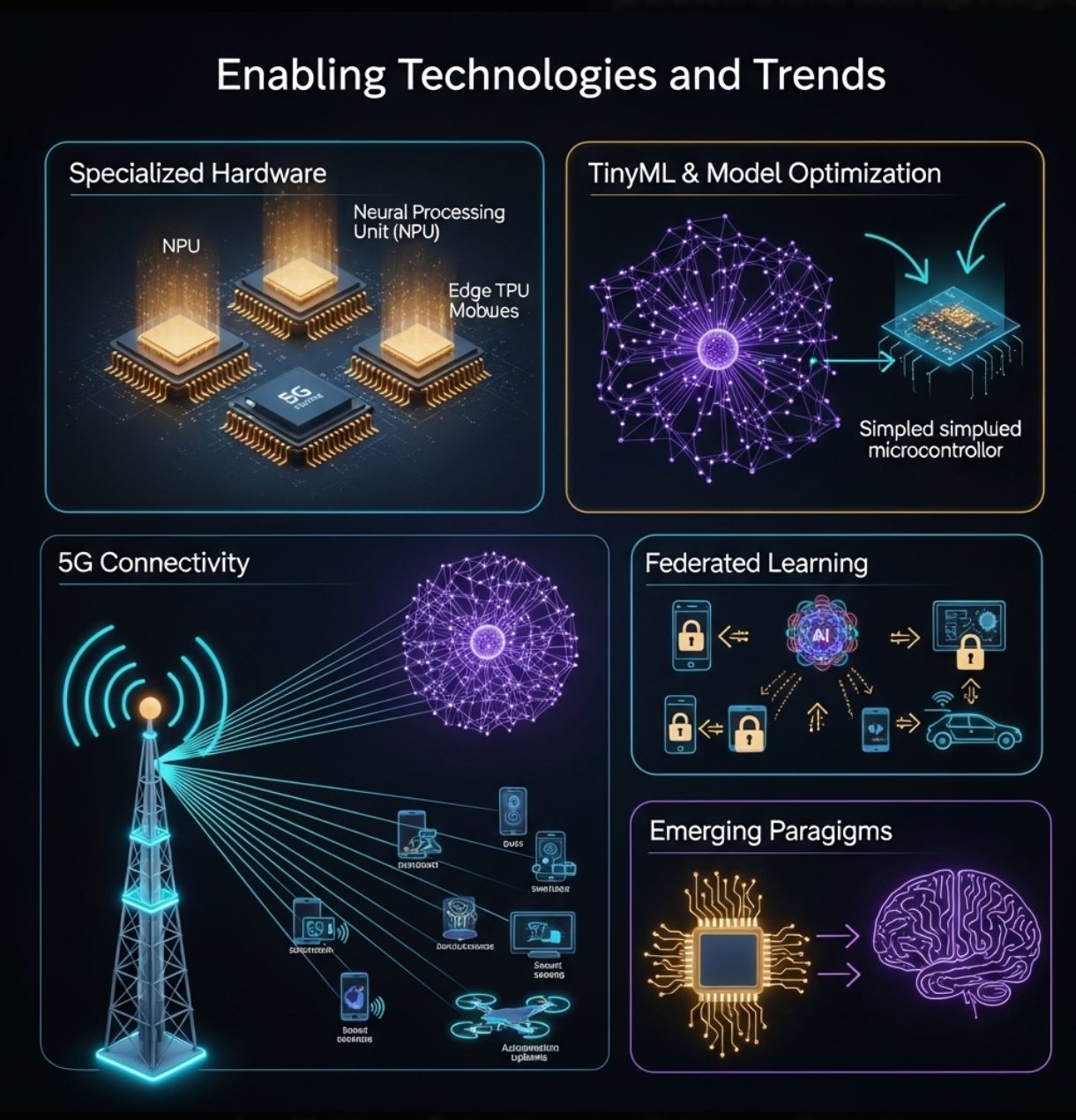

Tecnologías y tendencias habilitadoras

El crecimiento de Edge AI se impulsa por avances en hardware y software:

Hardware especializado

Los fabricantes están creando chips diseñados específicamente para inferencia en el borde.

- Aceleradores neuronales de bajo consumo (NPUs)

- Google Coral Edge TPU

- NVIDIA Jetson Nano

- Arduino y Raspberry Pi con complementos de IA

TinyML y optimización de modelos

Herramientas y técnicas permiten reducir redes neuronales para dispositivos diminutos.

- Optimización TensorFlow Lite

- Poda y cuantización de modelos

- Destilación de conocimiento

- TinyML para microcontroladores

5G y conectividad

La próxima generación inalámbrica ofrece alta velocidad y baja latencia que complementan Edge AI.

- Redes locales rápidas para coordinación de dispositivos

- Descarga de tareas pesadas cuando es necesario

- Fábricas inteligentes y comunicación V2X

- Clusters mejorados de dispositivos en el borde

Aprendizaje federado

Métodos que preservan la privacidad permiten que múltiples dispositivos en el borde entrenen modelos conjuntamente sin compartir datos sin procesar.

- Mejora local del modelo

- Solo se comparten actualizaciones del modelo

- Utilización distribuida de datos

- Protección mejorada de la privacidad

Estas tecnologías continúan ampliando el alcance de Edge AI. Juntas, ayudan a entregar la "era de la inferencia IA" – acercando la inteligencia a usuarios y sensores.

Conclusión

Edge AI está transformando el uso de la inteligencia artificial al mover el cómputo a la fuente de datos. Complementa la IA en la nube, ofreciendo análisis más rápidos, eficientes y privados en dispositivos locales.

Este enfoque aborda los desafíos de tiempo real y ancho de banda inherentes a arquitecturas centradas en la nube. En la práctica, Edge AI impulsa una amplia gama de tecnologías modernas – desde sensores inteligentes y fábricas hasta drones y autos autónomos – al permitir inteligencia inmediata.

A medida que proliferan los dispositivos IoT y mejoran las redes, Edge AI solo crecerá. Los avances en hardware (microchips potentes, TinyML) y técnicas (aprendizaje federado, optimización de modelos) facilitan poner IA en todas partes.

Comentarios 0

Dejar un comentario

Aún no hay comentarios. ¡Sé el primero en comentar!