Was ist Edge AI?

Edge AI (Edge Künstliche Intelligenz) ist die Kombination aus künstlicher Intelligenz (KI) und Edge Computing. Anstatt Daten zur Verarbeitung in die Cloud zu senden, ermöglicht Edge AI intelligenten Geräten wie Smartphones, Kameras, Robotern oder IoT-Maschinen, Daten direkt auf dem Gerät zu analysieren und Entscheidungen zu treffen. Dieser Ansatz hilft, Latenzzeiten zu reduzieren, Bandbreite zu sparen, die Sicherheit zu erhöhen und Echtzeitreaktionen zu ermöglichen.

Edge AI (manchmal auch „KI am Rand“ genannt) bedeutet, künstliche Intelligenz- und Machine-Learning-Modelle auf lokalen Geräten (Sensoren, Kameras, Smartphones, industrielle Gateways usw.) auszuführen, statt in entfernten Rechenzentren. Anders gesagt übernimmt der „Rand“ des Netzwerks – dort, wo Daten erzeugt werden – die Verarbeitung. So können Geräte Daten sofort analysieren, sobald sie erfasst werden, anstatt ständig Rohdaten in die Cloud zu senden.

Edge AI ermöglicht Echtzeitverarbeitung direkt auf dem Gerät, ohne auf einen zentralen Server angewiesen zu sein. Zum Beispiel kann eine Kamera mit Edge AI Objekte sofort erkennen und klassifizieren und so sofortiges Feedback geben. Durch lokale Datenverarbeitung funktioniert Edge AI auch bei unterbrochener oder fehlender Internetverbindung.

— IBM Research

Zusammengefasst bringt Edge AI die Rechenleistung näher an die Datenquelle – Intelligenz wird auf Geräten oder nahegelegenen Knotenpunkten eingesetzt, was Reaktionszeiten beschleunigt und die Notwendigkeit reduziert, alles in die Cloud zu übertragen.

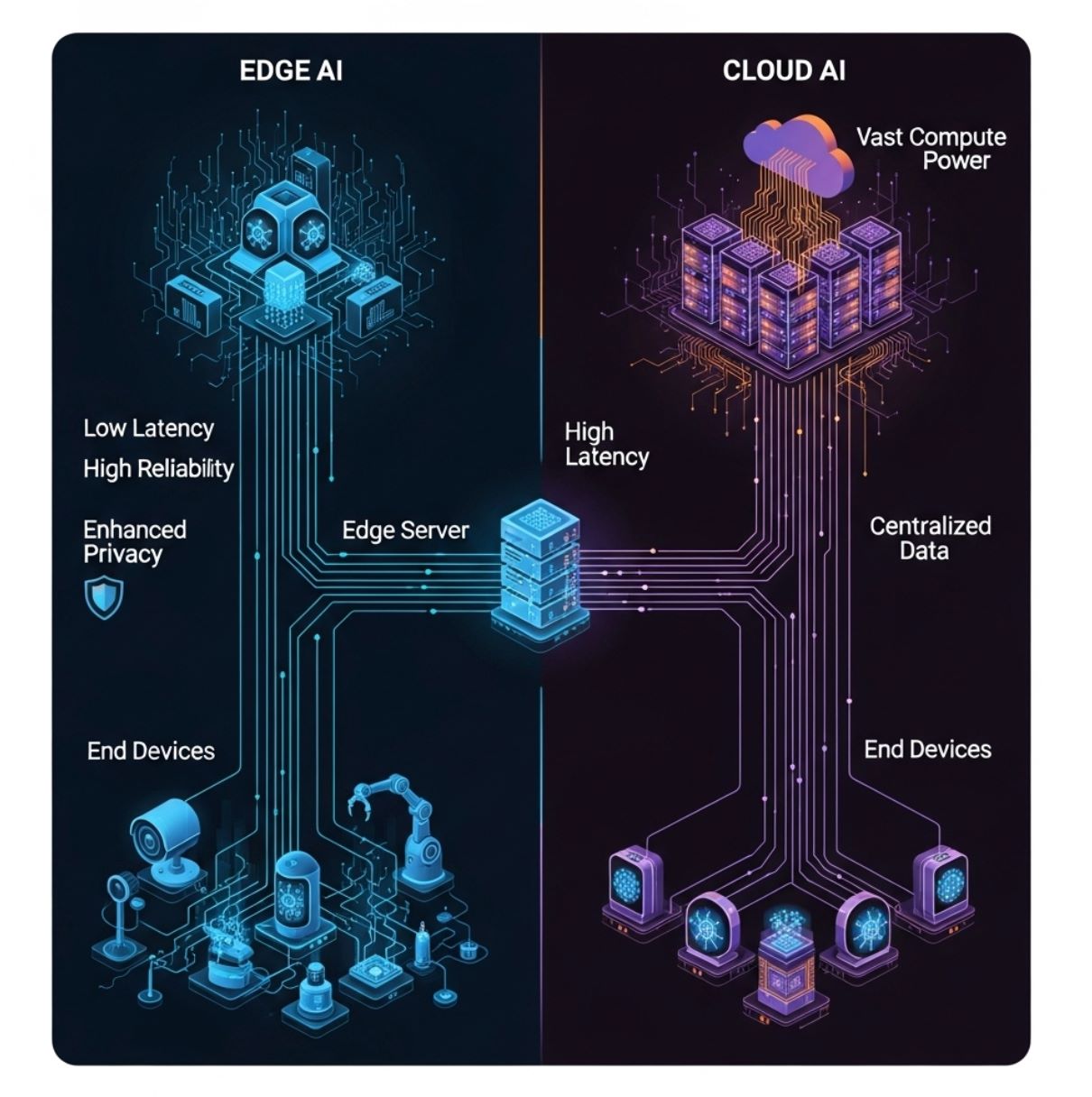

Edge AI vs Cloud AI: Wesentliche Unterschiede

Im Gegensatz zu traditioneller Cloud-basierter KI (bei der alle Daten an zentrale Server gesendet werden) verteilt Edge AI die Rechenleistung auf lokale Hardware vor Ort. Das folgende Diagramm zeigt ein einfaches Edge-Computing-Modell: Endgeräte (unterste Ebene) liefern Daten an einen Edge-Server oder Gateway (mittlere Ebene) statt nur an die entfernte Cloud (obere Ebene).

In diesem Setup kann die KI-Auswertung auf dem Gerät oder dem lokalen Edge-Knoten erfolgen, was Kommunikationsverzögerungen stark reduziert.

Traditioneller Ansatz

- Daten werden an entfernte Server gesendet

- Höhere Latenz durch Netzverzögerungen

- Erfordert durchgehende Konnektivität

- Unbegrenzte Rechenressourcen

- Datenschutzbedenken bei Datenübertragung

Moderner Ansatz

- Lokale Verarbeitung auf Geräten

- Antwortzeiten im Millisekundenbereich

- Funktioniert offline bei Bedarf

- Ressourcenbeschränkt, aber effizient

- Verbesserter Datenschutz

Latenz

Edge AI minimiert Verzögerungen. Da die Verarbeitung lokal erfolgt, können Entscheidungen in Millisekunden getroffen werden.

- Kritisch für zeitkritische Aufgaben

- Vermeidung von Verkehrsunfällen

- Echtzeitsteuerung von Robotern

Bandbreite

Edge AI reduziert die Netzwerklast, indem Daten vor Ort analysiert oder gefiltert werden.

- Weit weniger Daten werden nach oben gesendet

- Effizienter und kostengünstiger

- Verringert Netzüberlastung

Datenschutz/Sicherheit

Sensible Daten können auf dem Gerät verarbeitet und gespeichert werden, ohne in die Cloud übertragen zu werden.

- Sprache, Bilder, Gesundheitsdaten bleiben lokal

- Reduziert Risiko von Drittanbieterangriffen

- Gesichtserkennung ohne Foto-Uploads

Rechenressourcen

Edge-Geräte haben begrenzte Rechenleistung, nutzen aber optimierte Modelle.

- Kompakte, quantisierte Modelle

- Training erfolgt weiterhin in der Cloud

- Größenbeschränkt, aber effizient

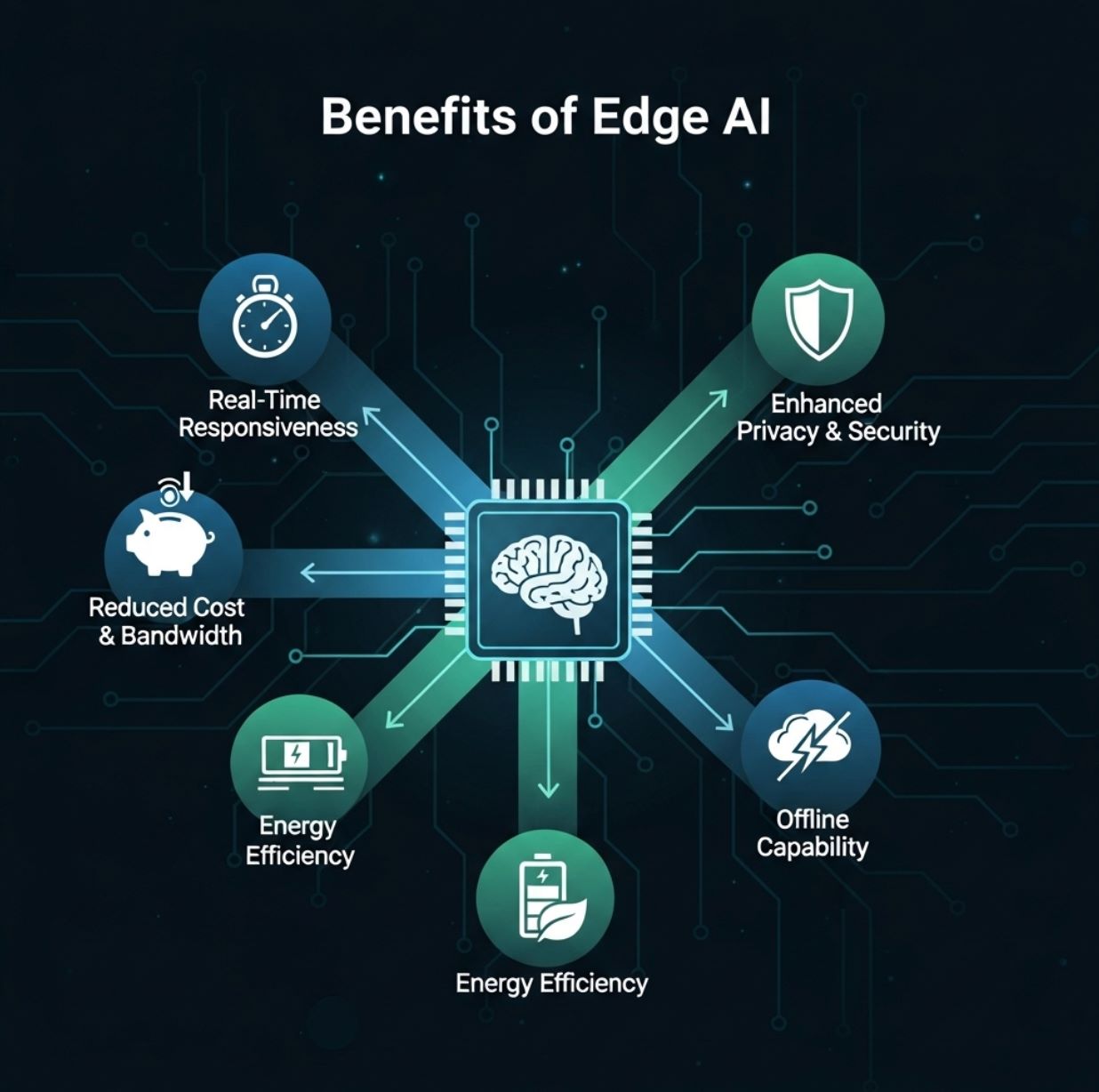

Vorteile von Edge AI

Edge AI bietet Anwendern und Organisationen mehrere praktische Vorteile:

Echtzeitreaktion

- Echtzeit-Objekterkennung

- Sprachantwortsysteme

- Anomalie-Warnungen

- Augmented-Reality-Anwendungen

Reduzierte Bandbreite und Kosten

- Sicherheitskameras laden nur Bedrohungsvideos hoch

- Weniger kontinuierliches Streaming

- Niedrigere Cloud-Hosting-Kosten

Verbesserter Datenschutz

- Kritisch für Gesundheitswesen und Finanzen

- Daten bleiben im Land oder in der Einrichtung

- Einhaltung von Datenschutzvorschriften

Energie- und Kosteneffizienz

- Geringerer Stromverbrauch

- Reduzierte Serverkosten

- Optimiert für mobile Geräte

Edge AI bringt Hochleistungsrechenleistung an den Rand, ermöglicht Echtzeitanalyse und verbesserte Effizienz.

— Gemeinsamer Bericht von Red Hat & IBM

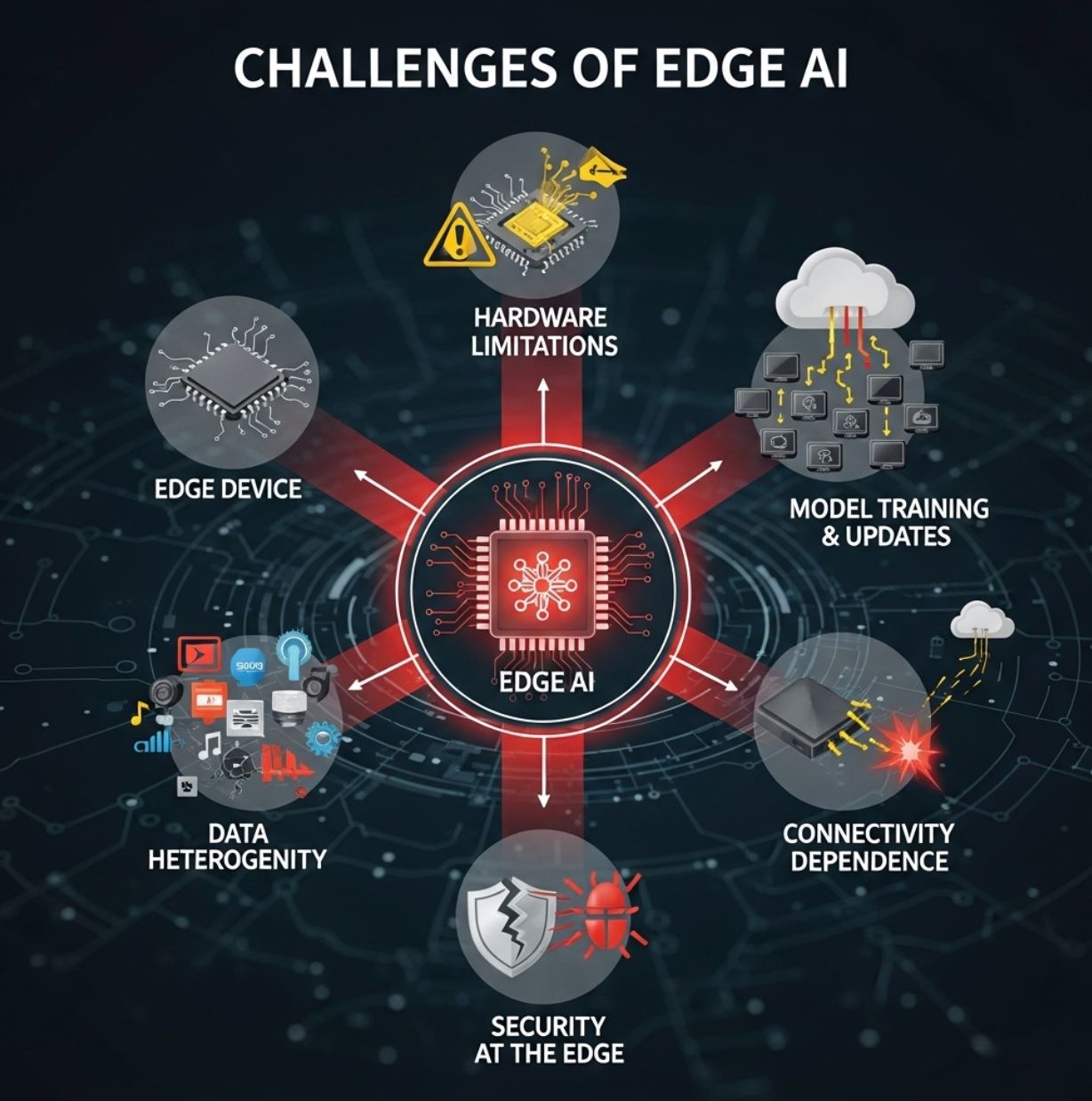

Herausforderungen von Edge AI

Trotz der Vorteile steht Edge AI auch vor bedeutenden Herausforderungen:

Hardware-Beschränkungen

Edge-Geräte sind meist klein und ressourcenbeschränkt. Sie verfügen oft nur über einfache CPUs oder spezialisierte stromsparende NPUs sowie begrenzten Speicher.

- Erfordert Modellkompression und -beschneidung

- TinyML-Techniken für Mikrocontroller notwendig

- Komplexe Modelle können nicht in voller Größe laufen

- Einige Genauigkeit muss eventuell geopfert werden

Modelltraining und Updates

Das Training komplexer KI-Modelle findet meist weiterhin in der Cloud statt, wo große Datenmengen und Rechenleistung verfügbar sind.

- Modelle müssen optimiert und auf jedes Gerät verteilt werden

- Die Aktualisierung von Tausenden Geräten ist komplex

- Firmware-Synchronisation verursacht Mehraufwand

- Versionskontrolle über verteilte Systeme

Daten-Gravitation und Heterogenität

Edge-Umgebungen sind vielfältig. Unterschiedliche Standorte erfassen verschiedene Datentypen, und Richtlinien können regional variieren.

- Daten bleiben meist lokal

- Schwer, einen globalen Überblick zu erhalten

- Geräte in allen Formen und Größen

- Herausforderungen bei Integration und Standardisierung

Sicherheit am Rand

Obwohl Edge AI den Datenschutz verbessert, entstehen neue Sicherheitsrisiken. Jedes Gerät oder jeder Knotenpunkt ist ein potenzielles Ziel für Hacker.

- Modelle müssen manipulationssicher sein

- Firmware-Sicherheitsanforderungen

- Verteilte Angriffsflächen

- Starke Schutzmaßnahmen erforderlich

Abhängigkeiten von Konnektivität

Obwohl die Auswertung lokal erfolgen kann, sind Edge-Systeme oft noch auf Cloud-Konnektivität für aufwändige Aufgaben angewiesen.

- Modell-Neutrainierung erfordert Cloud-Zugang

- Großvolumige Datenanalyse benötigt Verbindung

- Aggregation verteilter Ergebnisse

- Begrenzte Konnektivität kann Funktionen einschränken

Anwendungsfälle von Edge AI

Edge AI wird in vielen Branchen mit realen Auswirkungen eingesetzt:

Autonome Fahrzeuge

Selbstfahrende Autos nutzen an Bord Edge AI, um Kamera- und Radardaten sofort für Navigation und Hindernisvermeidung zu verarbeiten.

- Keine Verzögerung durch Videoübertragung an Server erlaubt

- Objekterkennung erfolgt lokal

- Fußgängererkennung in Echtzeit

- Spurverfolgung ohne Verbindung

Fertigung und Industrie 4.0

Fabriken setzen intelligente Kameras und Sensoren an Produktionslinien ein, um Fehler oder Anomalien in Echtzeit zu erkennen.

Qualitätskontrolle

Edge AI Kameras erkennen fehlerhafte Produkte auf Förderbändern und lösen sofortige Maßnahmen aus.

Vorausschauende Wartung

Industriemaschinen nutzen KI vor Ort, um Ausfälle vorherzusagen, bevor sie auftreten.

Gesundheitswesen und Notfallversorgung

Tragbare medizinische Geräte und Rettungswagen verwenden Edge AI, um Patientendaten direkt vor Ort zu analysieren.

- Ultraschall im Rettungswagen mit KI-Auswertung

- Vitalzeichenmonitore erkennen abnormale Werte

- Alarmierung von Sanitätern bei inneren Verletzungen

- Überwachung von Intensivpatienten mit Sofortalarmen

Smart Cities

Städtische Systeme nutzen Edge AI für Verkehrsmanagement, Überwachung und Umweltmessungen.

Verkehrsmanagement

Überwachung

Umweltüberwachung

Einzelhandel und Consumer IoT

Edge AI verbessert Kundenerlebnis und Komfort in Einzelhandel und Verbraucheranwendungen.

In-Store-Analysen

Intelligente Kameras und Regalsensoren verfolgen sofort das Verhalten der Kunden und den Lagerbestand.

Mobile Geräte

Smartphones führen Sprach- und Gesichtserkennung lokal ohne Cloud-Zugang aus, z. B. zum Entsperren und Gestenerkennung.

Fitness-Tracking

Wearables analysieren Gesundheitsdaten (Herzfrequenz, Schritte) lokal und liefern Echtzeit-Feedback.

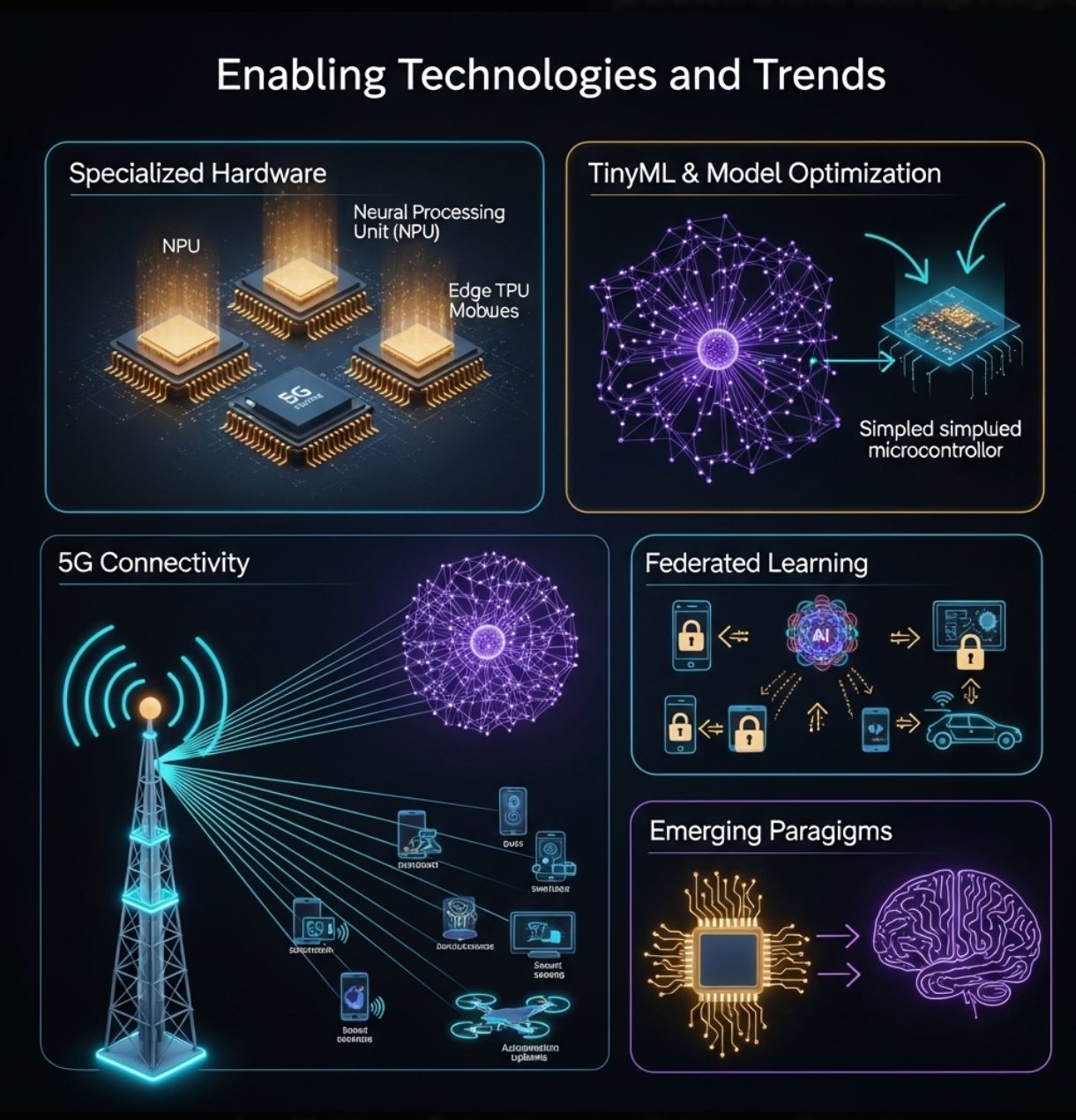

Ermöglichende Technologien und Trends

Das Wachstum von Edge AI wird durch Fortschritte in Hardware und Software angetrieben:

Spezialisierte Hardware

Hersteller entwickeln Chips, die speziell für Edge-Inferenz ausgelegt sind.

- Stromsparende neuronale Beschleuniger (NPUs)

- Google Coral Edge TPU

- NVIDIA Jetson Nano

- Arduino und Raspberry Pi mit KI-Erweiterungen

TinyML und Modelloptimierung

Werkzeuge und Techniken ermöglichen es, neuronale Netze für winzige Geräte zu verkleinern.

- TensorFlow Lite Optimierung

- Modellbeschneidung und Quantisierung

- Wissensdistillation

- TinyML für Mikrocontroller

5G und Konnektivität

Die nächste Generation drahtloser Netzwerke bietet hohe Bandbreite und niedrige Latenz, die Edge AI ergänzen.

- Schnelle lokale Netzwerke zur Gerätekoordination

- Auslagerung schwererer Aufgaben bei Bedarf

- Intelligente Fabriken und V2X-Kommunikation

- Verbesserte Edge-Geräte-Cluster

Federated Learning

Datenschutzfreundliche Methoden erlauben mehreren Edge-Geräten, Modelle gemeinsam zu trainieren, ohne Rohdaten zu teilen.

- Lokale Modellverbesserung

- Nur Modellupdates werden geteilt

- Verteilte Datennutzung

- Verbesserter Datenschutz

Diese Technologien verschieben weiterhin die Grenzen dessen, was Edge AI leisten kann. Gemeinsam ermöglichen sie die „Ära der KI-Auswertung“ – Intelligenz rückt näher zu Nutzern und Sensoren.

Fazit

Edge AI verändert die Nutzung künstlicher Intelligenz, indem die Verarbeitung zur Datenquelle verlagert wird. Sie ergänzt Cloud-KI und liefert schnellere, effizientere und datenschutzfreundlichere Analysen auf lokalen Geräten.

Dieser Ansatz löst Herausforderungen von Echtzeitverarbeitung und Bandbreitenbeschränkungen, die bei cloudzentrierten Architekturen bestehen. In der Praxis treibt Edge AI eine Vielzahl moderner Technologien an – von intelligenten Sensoren und Fabriken bis zu Drohnen und selbstfahrenden Autos – durch unmittelbare Intelligenz vor Ort.

Mit der Verbreitung von IoT-Geräten und verbesserten Netzwerken wird Edge AI weiter wachsen. Fortschritte in Hardware (leistungsstarke Mikroprozessoren, TinyML) und Methoden (federiertes Lernen, Modelloptimierung) erleichtern es, KI überall einzusetzen.

Kommentare 0

Einen Kommentar hinterlassen

Noch keine Kommentare. Seien Sie der Erste!