Was ist Natural Language Processing?

Natural Language Processing (NLP) – oder Verarbeitung natürlicher Sprache – ist ein Bereich der Künstlichen Intelligenz (KI), der sich darauf konzentriert, Computern das Verstehen und Interagieren mit menschlicher Sprache zu ermöglichen.

Natural Language Processing (NLP) – oder Verarbeitung natürlicher Sprache – ist ein Bereich der Künstlichen Intelligenz (KI), der sich darauf konzentriert, Computern das Verstehen und Interagieren mit der menschlichen Sprache zu ermöglichen. Einfach ausgedrückt nutzt NLP maschinelles Lernen, um Computern die Fähigkeit zu geben, natürliche Sprache, die wir täglich verwenden, zu interpretieren, zu interagieren und zu verstehen.

Dies gilt als eine der komplexesten Herausforderungen der KI, da Sprache ein äußerst feines und komplexes Werkzeug zur Ausdrucksweise von Gedanken und Kommunikation des Menschen ist, das von Maschinen verlangt, die verborgene Bedeutung hinter den Sätzen zu „verstehen“.

Natürliche Sprache bezieht sich hier auf menschliche Sprachen wie Deutsch, Englisch, Chinesisch usw., im Gegensatz zu Programmiersprachen. Das Ziel von NLP ist es, Computer so zu programmieren, dass sie diese Sprachen automatisch verarbeiten und verstehen können und sogar ähnliche Sätze wie Menschen erzeugen können.

Beispielsweise wenn Sie mit einem virtuellen Assistenten oder Chatbot sprechen, Siri oder Alexa Fragen stellen oder Texte mit Google Übersetzer übersetzen – all diese Anwendungen nutzen die Technologie der Verarbeitung natürlicher Sprache im Hintergrund.

Warum ist die Verarbeitung natürlicher Sprache wichtig?

Im digitalen Zeitalter wächst das Volumen an sprachlichen Daten (Text, Audio, Gespräche) enorm aus vielen Quellen wie E-Mails, Nachrichten, sozialen Netzwerken, Videos usw. Im Gegensatz zu strukturierten Daten (Zahlen, Tabellen) sind sprachliche Daten in Form von Text oder Audio unstrukturiert – was ohne NLP sehr schwer automatisiert zu verarbeiten ist.

Die Technologie der Verarbeitung natürlicher Sprache hilft Computern, diese unstrukturierten Daten effizient zu analysieren, Absichten, Kontext und Emotionen in der menschlichen Sprache zu verstehen. Dadurch wird NLP zum Schlüssel, damit Maschinen intelligenter kommunizieren und den Menschen besser dienen können.

Natural Language Processing ist wichtig, weil es die natürliche Interaktion zwischen Mensch und Computer ermöglicht. Anstatt Programmiersprachen zu lernen, können wir Befehle oder Fragen in unserer Muttersprache an den Computer richten. NLP automatisiert viele komplexe sprachbezogene Aufgaben, was Zeit und Kosten spart und gleichzeitig die Nutzererfahrung in fast allen Bereichen verbessert.

Zum Beispiel können Unternehmen NLP nutzen, um Tausende von Kundenfeedbacks in sozialen Medien automatisch zu analysieren und wichtige Erkenntnisse zu gewinnen, oder Chatbots, die NLP verwenden, können Kunden rund um die Uhr konsistent antworten. Die richtige Anwendung von NLP hilft Unternehmen, Prozesse zu optimieren, Produktivität zu steigern und sogar den Service für jeden Nutzer individuell zu personalisieren.

In der Praxis ist NLP bereits Teil unseres Alltags. Suchmaschinen wie Google verstehen, was Sie suchen, auch wenn die Anfrage unklar ist. Virtuelle Assistenten wie Amazon Alexa, Apple Siri oder Microsoft Cortana können zuhören und antworten, helfen beim Telefonieren, Musik abspielen oder Informationen finden.

Sogar Funktionen wie Wortvorhersage beim Tippen oder automatische Rechtschreibprüfung basieren auf NLP. Offensichtlich ist die Verarbeitung natürlicher Sprache eine Schlüsseltechnologie, die viele intelligente Anwendungen antreibt und Maschinen ein besseres Sprachverständnis als je zuvor ermöglicht.

Beliebte Anwendungen von NLP

Dank der Fähigkeit, Sprache zu „verstehen“, wird NLP in vielen verschiedenen Bereichen breit eingesetzt. Hier sind einige herausragende Anwendungen der Verarbeitung natürlicher Sprache:

-

Virtuelle Assistenten und Chatbots:

NLP ermöglicht die Erstellung von virtuellen Assistenten wie Siri, Alexa oder Chatbots auf Websites, Facebook Messenger usw., die Benutzerfragen verstehen und automatisch antworten können. Sie helfen bei häufig gestellten Fragen, Terminvereinbarungen, Einkäufen oder der schnellen Lösung von Kundenproblemen – jederzeit und überall.

-

Meinungs- und Sentiment-Analyse:

Unternehmen nutzen NLP, um Kundenfeedback in sozialen Medien, Umfragen oder Produktbewertungen zu analysieren. NLP-Algorithmen können Emotionen (positiv/negativ), Einstellungen oder sogar Sarkasmus in Texten erkennen. Dies hilft Unternehmen, Kundenmeinungen und Markttrends besser zu verstehen und Produkte sowie Dienstleistungen rechtzeitig zu verbessern.

-

Maschinelle Übersetzung:

Maschinelle Übersetzung ist eine klassische Anwendung von NLP. Übersetzungssoftware (wie Google Übersetzer) nutzt NLP, um Texte oder gesprochene Sprache von einer Sprache in eine andere zu übertragen, dabei aber Bedeutung und Kontext möglichst genau zu bewahren. Dank NLP verbessert sich die Qualität automatischer Übersetzungen stetig und hilft, Sprachbarrieren zu überwinden.

-

Spracherkennung:

Spracherkennung wandelt gesprochene Sprache in Text um und ermöglicht es Ihnen, Sprachbefehle an Telefon oder Computer zu geben (z. B. Voice-to-Text-Funktion, Telefonieren per Spracheingabe).

Umgekehrt hilft NLP auch bei der Sprachsynthese (Text-to-Speech), um natürliche Stimmen für Hörbücher, virtuelle Assistenten usw. zu erzeugen. Sprachgesteuerte Systeme in Autos oder Smart Homes basieren ebenfalls auf diesen Technologien.

-

Klassifikation und Informationsgewinnung:

NLP kann Texte automatisch nach Themen klassifizieren (z. B. Spam-/Nicht-Spam-E-Mails, Nachrichten nach Bereichen) und wichtige Informationen extrahieren. In Unternehmen wird NLP zur Organisation von Akten und Dokumenten eingesetzt; im Gesundheitswesen hilft es bei der Extraktion von Patientendaten; im Rechtswesen unterstützt es die Filterung relevanter Texte aus Millionen von Seiten.

-

Automatische Inhaltserstellung:

Ein neuer Fortschritt in NLP ist die Fähigkeit zur generativen Sprachproduktion – also das Erzeugen von menschenähnlichen Texten. Moderne Sprachmodelle (wie GPT-3, GPT-4) können Artikel schreiben, E-Mails verfassen, Gedichte dichten oder Programmcode generieren – basierend auf Nutzeranfragen.

Dies eröffnet viele interessante Anwendungen wie Unterstützung bei der Content-Erstellung, automatische Antworten im Kundenservice oder sogar das Verfassen von Entwürfen für wissenschaftliche Arbeiten. Natürlich erfordert maschinell erzeugter Inhalt menschliche Überprüfung, um Genauigkeit und ethische Standards sicherzustellen.

Im Allgemeinen kann NLP bei jeder Aufgabe, die mit natürlicher Sprache (Text, Sprache) zu tun hat, zur Automatisierung oder Effizienzsteigerung eingesetzt werden. Von Informationssuche, Fragebeantwortung, Dokumentenanalyse bis hin zu Bildungsunterstützung (z. B. automatische Bewertung von Aufsätzen, virtuelle Tutoren) spielt NLP eine zentrale Rolle.

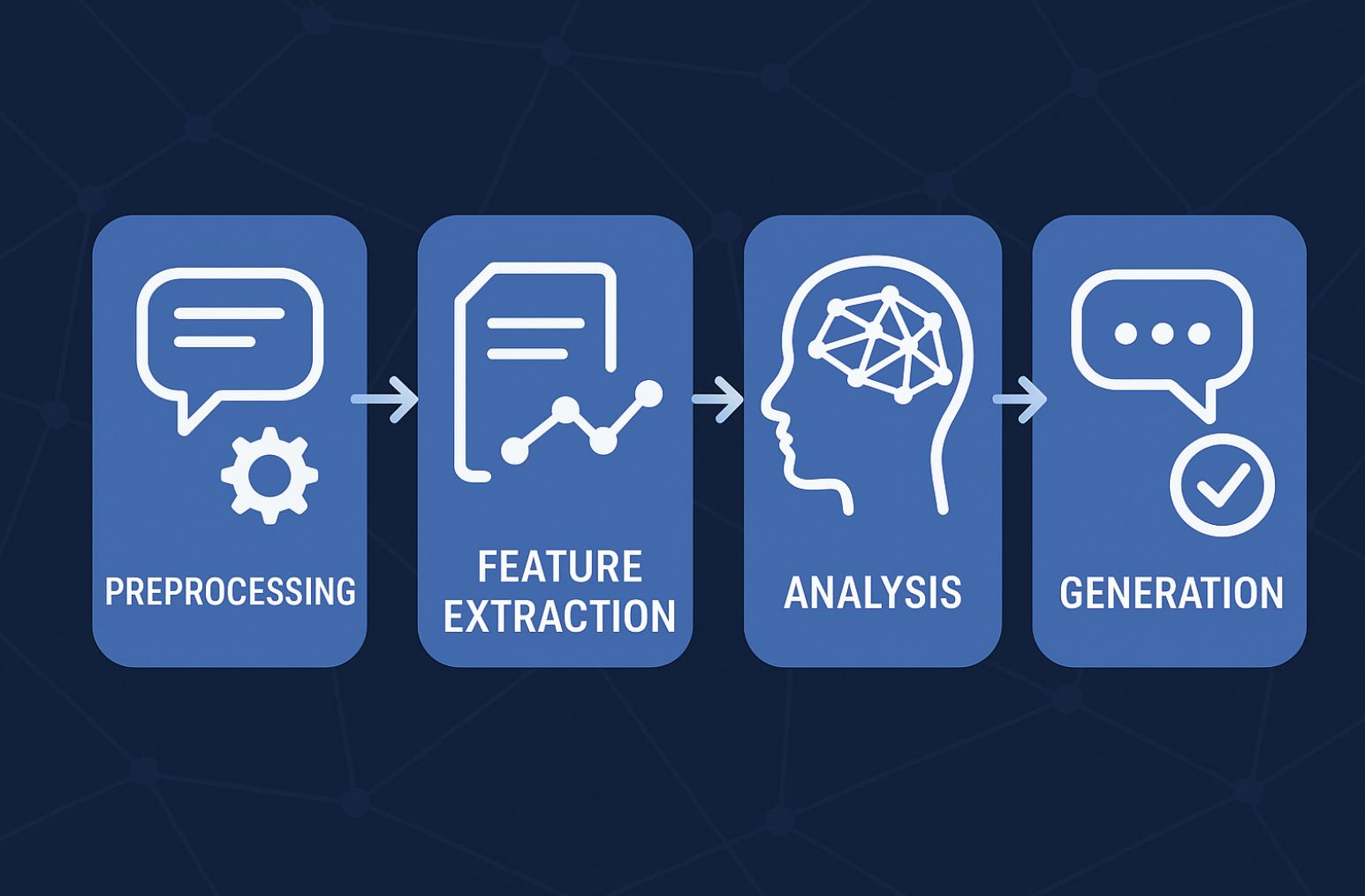

Wie funktioniert NLP?

Damit Computer menschliche Sprache verstehen können, kombiniert NLP verschiedene Techniken aus der Informatik und Sprachwissenschaft. Grundsätzlich durchläuft ein NLP-System folgende Hauptschritte bei der Sprachverarbeitung:

Vorverarbeitung der Sprache:

Zunächst werden Text oder Sprache in rohe Daten für den Computer umgewandelt. Bei Text erfolgt Tokenisierung (Satz- und Worttrennung), Umwandlung in Kleinbuchstaben, Entfernung von Satzzeichen und Stoppwörtern (Wörter wie „der“, „ist“, die wenig Bedeutung tragen).

Danach kann Stemming/Lemmatisierung angewandt werden – Wörter werden auf ihre Grundform zurückgeführt (z. B. „laufend“ zu „laufen“). Bei gesprochener Sprache erfolgt zunächst die Spracherkennung, um Text zu erhalten. Das Ergebnis der Vorverarbeitung sind bereinigte und normalisierte Sprachdaten, die für das maschinelle Lernen bereitstehen.

Merkmalextraktion (Feature Extraction):

Computer verstehen Wörter nicht direkt, daher muss NLP Sprache in Zahlenwerte umwandeln. Dieser Schritt wandelt Text in numerische Merkmale oder Vektoren um.

Gängige Techniken sind Modelle wie Bag of Words, TF-IDF (Häufigkeitszählung von Wörtern) oder moderner Word Embedding (z. B. Word2Vec, GloVe) – jedem Wort wird ein Vektor zugeordnet, der seine Bedeutung repräsentiert. Diese Vektoren helfen Algorithmen, semantische Beziehungen zwischen Wörtern zu verstehen (z. B. ist „König“ näher an „Königin“ als an „Auto“ im Vektorraum).

Analyse und Kontextverständnis:

Mit den numerischen Daten nutzt das System Modelle und maschinelle Lernalgorithmen, um Syntax (Satzbau) und Semantik (Bedeutung) zu analysieren.

Zum Beispiel bestimmt die syntaktische Analyse die Rolle eines Wortes im Satz (Subjekt, Verb, Objekt), während die semantische Analyse die Bedeutung im jeweiligen Kontext erfasst. Moderne NLP-Systeme verwenden Deep Learning-Modelle, die es Computern ermöglichen, die Bedeutung von Sätzen zunehmend menschenähnlich zu verstehen.

Sprachgenerierung oder Aktionen:

Je nach Ziel kann der letzte Schritt darin bestehen, Ergebnisse auszugeben. Bei einer Frage sucht das NLP-System eine passende Antwort aus den Daten und gibt diese als Text oder Sprache zurück. Bei einem Befehl aktiviert NLP eine Aktion auf der Maschine (z. B. Musik abspielen bei „Play music“).

Im Fall der Maschinenübersetzung erzeugt dieser Schritt die Übersetzung in der Zielsprache. Bei Chatbots wird hier die Antwort generiert, basierend auf dem Verständnis aus den vorherigen Schritten.

In der Praxis ist der Prozess oft komplexer und die Schritte sind nicht immer klar getrennt. Viele moderne NLP-Systeme verwenden End-to-End-Modelle, bei denen ein Neuronales Netzwerk den gesamten Prozess von Eingabe bis Ausgabe selbstständig lernt, anstatt jeden Schritt einzeln zu verarbeiten. Dennoch hilft diese Aufteilung, das Funktionsprinzip von NLP zu verstehen, wie menschliche Sprache in eine für Computer verständliche Form gebracht und passend beantwortet wird.

Ansätze in der NLP

Im Laufe der Entwicklung hat sich Natural Language Processing durch verschiedene Generationen von Methoden entwickelt. Seit den 1950er Jahren lassen sich drei Hauptansätze in NLP unterscheiden:

Regelbasierte NLP (Rule-based)

Dies ist der erste Ansatz. Programmierer schreiben Sprachregeln in Form von If-Then-Anweisungen, um Sätze zu verarbeiten.

Beispielsweise konnten frühe automatische Antwortsysteme nur vorprogrammierte Satzmuster erkennen und beantworten. Dieser Ansatz verwendet kein maschinelles Lernen und ist daher sehr eingeschränkt – das System versteht nur, was ihm starr beigebracht wurde, ohne selbst dazuzulernen. Regelbasierte NLP erfordert Expertenwissen in Linguistik zur Regelentwicklung und ist schwer skalierbar wegen der Vielfalt der Sprache.

Statistische NLP (Statistical)

Ab den 1990er Jahren setzte NLP verstärkt auf statistisches maschinelles Lernen. Statt Regeln manuell zu schreiben, lernt das System Sprachmodelle anhand von Daten. Dieser Ansatz ermöglicht eine flexiblere und genauere Verarbeitung natürlicher Sprache, da Wahrscheinlichkeiten berechnet werden, um die passende Bedeutung eines Wortes oder Satzes im Kontext zu bestimmen.

Zum Beispiel lernt ein Algorithmus zur Wortartenerkennung (POS-Tagging) aus markierten Daten, mit welcher Wahrscheinlichkeit ein Wort in einem bestimmten Kontext Substantiv oder Verb ist. Statistische NLP hat Anwendungen wie Rechtschreibprüfung und Wortvorschläge (z. B. T9 auf alten Handys) sehr effektiv gemacht.

Deep Learning NLP

Seit Ende der 2010er Jahre ist Deep Learning mit Neuronalen Netzwerken der dominierende Ansatz in NLP. Dank großer Textmengen im Internet und steigender Rechenleistung können Deep-Learning-Modelle Sprache auf sehr abstraktem Niveau selbstständig lernen.

Transformer-Modelle (seit 2017) sind ein großer Durchbruch: Sie lernen semantische Zusammenhänge zwischen Wörtern im Satz durch einen Mechanismus namens Self-Attention, der ein besseres Kontextverständnis ermöglicht. Google veröffentlichte das Modell BERT basierend auf Transformer, um die Suchqualität deutlich zu verbessern.

Darauf aufbauend wurden autoregressive Modelle wie GPT-2, GPT-3 trainiert, die nächste Wörter vorhersagen und so flüssige Texte generieren können. Heute gibt es dank Deep Learning sehr große Sprachmodelle (LLM) wie GPT-4, LLaMA, PaLM usw., die Sprache sehr natürlich verstehen und erzeugen können, oft auf menschlichem Niveau in vielen Aufgaben.

Ein moderner Trend sind Foundation Models – große vortrainierte KI-Modelle, die auf Milliarden von Wörtern basieren. Diese Modelle (z. B. OpenAI GPT-4 oder IBM Granite) können schnell für verschiedene NLP-Aufgaben angepasst werden, von Textgenerierung bis tiefgehender Informationsgewinnung.

Die Nutzung vortrainierter Modelle spart Trainingszeit und erhöht die Effizienz. Gleichzeitig eröffnen sich neue Methoden wie retrieval-augmented generation (Antwortgenerierung mit Zugriff auf externe Informationen), um die Genauigkeit von Antworten zu verbessern. Dies zeigt, dass NLP sich technisch sehr dynamisch und innovativ weiterentwickelt.

Herausforderungen und neue Trends in NLP

Trotz vieler Erfolge gibt es bei der Verarbeitung natürlicher Sprache weiterhin bedeutende Herausforderungen. Die menschliche Sprache ist extrem vielfältig und komplex: Ein und derselbe Satz kann je nach Kontext viele Bedeutungen haben, ganz zu schweigen von Slang, Redewendungen, Wortspielen und Sarkasmus. Maschinen in jeder Situation die richtige Bedeutung zu vermitteln, ist alles andere als einfach.

Beispielsweise muss ein System den Satz „Der Apfel fällt nicht weit vom Stamm“ als Redewendung erkennen und nicht wörtlich verstehen. Um korrekte Antworten zu geben, benötigt NLP zudem ein breites Hintergrundwissen und eine gewisse Schlussfolgerungsfähigkeit, nicht nur das Verständnis einzelner Wörter.

Eine weitere Herausforderung sind Dialekte und Mehrsprachigkeit. Jede Sprache hat ihre eigenen Besonderheiten (z. B. unterscheidet sich Deutsch stark vom Englischen in Schrift und Satzbau; Japanisch und Chinesisch haben keine Wortabstände usw.).

NLP muss sich an jede Sprache anpassen. Der Trend geht heute zu mehrsprachigen Modellen oder sogar multimodalen NLP-Systemen (die gleichzeitig Text, Bilder und Audio verarbeiten), damit Maschinen Sprache in einem breiteren Kontext verstehen können.

Moderne NLP-Systeme streben danach, intelligenter und „verständnisvoller“ zu werden. Größere Sprachmodelle mit mehr Parametern und Trainingsdaten wie GPT-4, GPT-5 usw. sollen die Sprachverständnis- und Generierungsfähigkeiten weiter verbessern.

Gleichzeitig wird an erklärbarer NLP gearbeitet – das heißt, dass wir nachvollziehen können, auf welchen sprachlichen Merkmalen eine maschinelle Entscheidung basiert, statt eine schwer durchschaubare „Black Box“ zu haben. Dies ist besonders wichtig in sensiblen Bereichen wie Medizin oder Recht, wo die Entscheidungsgrundlage klar sein muss.

Ein weiterer wichtiger Trend ist die Integration von Weltwissen in NLP. Neue Modelle kombinieren Sprachverarbeitung mit Wissensdatenbanken oder externen Datenquellen, um den Kontext besser zu erfassen.

Beispielsweise können Fragesysteme Informationen in Echtzeit aus Wikipedia oder dem Internet abrufen, um präzise Antworten zu geben, statt nur auf bereits Gelerntes zuzugreifen. NLP nähert sich damit immer mehr einer allgemeinen KI an, unterstützt durch interdisziplinäre Forschung in Kognitionswissenschaft und Neurowissenschaft, die das menschliche Sprachverständnis nachahmen möchte.

>>> Wussten Sie schon:

Zusammenfassend ist Natural Language Processing ein und bleibt ein Kernbereich der KI mit großem Potenzial. Von der Fähigkeit, Computer menschliche Sprache verstehen zu lassen, bis hin zur Automatisierung zahlreicher sprachbezogener Aufgaben, hat NLP tiefgreifende Auswirkungen auf alle Lebens- und Technologiebereiche.

Mit dem Fortschritt in Deep Learning und Big Data können wir in naher Zukunft noch intelligentere Maschinen erwarten, die natürlicher kommunizieren. Die Verarbeitung natürlicher Sprache ist der Schlüssel, um die Kluft zwischen Mensch und Computer zu überbrücken und Technologie natürlicher und effizienter in unser Leben zu integrieren.